План устранения проблемы при использовании SD-карт или USB-устройств в качестве загрузочного накопителя

Использование SD-карт или USB-устройств связано с некоторыми ограничениями:

Использование автономных SD-карт или USB-накопителей (без дополнительного устройства для раздела ESX-OSData) в качестве загрузочного накопителя для хранения раздела ESX-OSData устарело в vSphere 7 Update 3 и не будет поддерживаться в будущих основных выпусках.

В ближайшем будущем единственной поддерживаемой конфигурацией, предполагающей использование SD-карты или USB-накопителя в качестве загрузочного накопителя, будет, как минимум, 8 ГБ SD-карта или USB-накопитель + локально подключенное постоянное устройство хранения для раздела ESX-OSData. Рекомендуемый список локально подключаемых устройств хранения данных приведен ниже.

В любом случае, если в качестве загрузочного накопителя используется SD- или USB-устройство (только SD/USB или SD/USB + локальный HDD/SSD-диск), следуйте приведенным ниже инструкциям, чтобы уменьшить объем ввода-вывода, отправляемого на загрузочный SD- или USB-накопитель:

Включите параметр ToolsRamDisk, чтобы разгрузить запросы ввода-вывода при установке/обновлении VMTools на RAM-диск.

Убедитесь, что раздел /scratch настроен на постоянное хранилище, например локальный HDD/SSD, или загрузитесь с устройства SAN. Программа установки ESXi 7.0 не создает /scratch-раздел на SD-карте или USB-накопителе. Она пытается найти постоянное хранилище и пытается создать /scratch на постоянном устройстве хранения. Раздел /tmp размером 250 МБ создается на RAM-диске, если постоянное хранилище недоступно

Обратите внимание, что производительность хостов ESXi снижается, если в разделе /tmp заканчивается место.

VMware не поддерживает раздел /scratch на загрузочном накопителе SD или USB. Всегда настраивайте /scratch на локально подключенном диске (HDD или SSD)

Если локальный диск недоступен, настройте его на SAN. Следуйте шагам, указанным в статье KB 1033696. Примечание: Пожалуйста, имейте в виду, что RAMDisk нестабилен и подвержен потере данных, поэтому хранение части загрузочных разделов на RAM Disk приводит к ухудшению режима работы.

Хорошей практикой всегда является настройка ESXi Dump Collector на разгрузку дампов ядра.

Для решения проблемы отсутствия /bootbank убедитесь, что клиенты также обновились до vSphere 7 Update 2c или выше.

Двойная SD-карта: Это не то решение, на которое следует полагаться. Нарушения чтения/проблемы производительности могут быть вызваны и при использовании двух SD-карт

Также важно отметить, что даже ухудшение работы одной SD-карты в зеркальной установке может привести к ухудшению работы других SD-карт.

Если ваш хост ESXi уже обновлен до версии 7.x, вы можете добавить локально подключенное устройство хранения и установить autoPartition=True. При следующей перезагрузке будет создан раздел первого локально подключенного хранилища, который будет использоваться для раздела ESX-OSData

См. статью VMware KB Article 77009.

How to Mount VMFS file system on Linux (Ubuntu)

You can mount a partition with the VMFS file system on a computer with Ubuntu installed (Ubuntu Live CD won’t suit us in this case).

Firstly, you have to connect a physical disk with VMFS file system to the computer (server) with Ubuntu. To access the data on the VMFS volume, you have to install a special third-party vmfs-tools package. This package allows you to access VMFS from non-ESXi hosts. You can access data on this partition in read-only mode. The second important limitation: the developers of vmfs-tools officially announced support for versions of the VMFS file system up to VMFS 5.0. The possibility to connect a partition with VMFS 6 (vSphere 6.0 and 6.5.) is not guaranteed.

Install the package with the following command:

1 |

apt-get install vmfs-tools |

Note. In Ubuntu repository, only vmfs-tools 0.2.1 is available, and its main drawback is that it can work only with VMFS v3. If you need to mount a VMFS 5 datastore, you will have to download and install vmfs-tools 0.2.5 or higher, for instance, here:

- http://mirrors.kernel.org/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_amd64.deb – a package for a 32-bit system.

- http://mirrors.kernel.org/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_i386.deb – a package for a 64-bit system.

Download the corresponding package version as follows:

1 |

#wget http://mirrors.kernel.orgubuntupooluniversevvmfs-toolsvmfs-tools_0.2.5-1_amd64.deb |

And install it:

1 |

#dpkg -i vmfs-tools_0.2.5-1_amd64.deb |

To install package dependencies, use this command:

1 |

#apt-get install vmfs-tools |

After the package is installed, you need to create a mount point in which the VMFS partition will be mounted:

1 |

#mkdir mntvmfs |

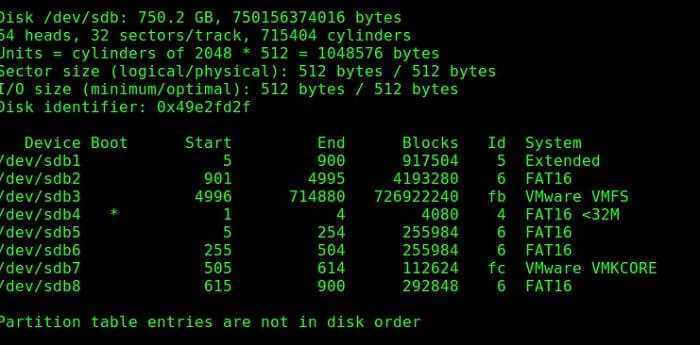

The next step is to look into the partitions on the disks. creates a number of service partitions when installed in addition to the partition for virtual machine files (VMFS partition).

If the ESXi version is 4 or earlier, or a VMFS storage has been updated from VMFS 3 to VMFS 5, and its size doesn’t exceed 2TB, display the list of disks and partitions like this:

1 |

#fdisk -l |

As you can see, the VMFS partition is /dev/sdb3 (label VMware VMFS).

Important. In ESXi 5 and later, VMFS v5 is used with the GPT partition table. GUID Partition Table allows to create larger storages (larger than 2TB), as well as connect RDM-drives in the physical compatibility mode. So to view the partition table you have to use the parted command instead of fdisk.

So, display the partition information as follows:

1 |

#parted -l |

Now you only have to mount a partition with the VMFS storage:

1 |

#vmfs-fuse devsdb3 mntvmfs |

List the contents of the mounted partition:

1 |

#ls -all mntvmfs |

Now you see all the virtual machine files on the VMFS storage that is available in read-only mode. That means that you can copy the directories and/or individual files of the necessary virtual machines to a separate drive and run them on another ESXi host.

VMFS хранилище на USB дисках размером более 2Тб

Большие диски, размером более 2Тб все также не работают в ESXi 6.5. Лог такой:

2017-12-27T16:22:13.213Z cpu4:66004)WARNING: ScsiPath: 7481: Adapter Invalid does not exist2017-12-27T16:22:13.246Z cpu7:65593)VMWARE SCSI Id: Could not get disk id for vmhba35:C0:T0:L02017-12-27T16:22:13.246Z cpu7:65593)ScsiDeviceIO: 9120: Get VPD 80 Inquiry for device «t10.WD______My_Book_1140____WMC1T2972871____» from Plugin «NMP» failed. Not supported2017-12-27T16:22:13.246Z cpu7:65593)ScsiDeviceIO: 9167: Get VPD 86 Inquiry for device «t10.WD______My_Book_1140____WMC1T2972871____» from Plugin «NMP» failed. Not supported2017-12-27T16:22:13.248Z cpu7:65593)ScsiDeviceIO: 7851: Could not detect setting of QErr for device t10.WD______My_Book_1140____WMC1T2972871____. Error Not supported.2017-12-27T16:22:13.251Z cpu2:65563)ScsiDeviceIO: 2948: Cmd(0x439500b1fe80) 0x1a, CmdSN 0x6ce from world 0 to dev «t10.WD______My_Book_1140____WMC1T2972871____» failed H:0x0 D:0x2 P:0x0 Valid sense data: 0x5 0x24 0x0.2017-12-27T16:22:13.253Z cpu7:65593)ScsiDeviceIO: 8365: Could not detect setting of sitpua for device t10.WD______My_Book_1140____WMC1T2972871____. Error Not supported.2017-12-27T16:22:13.253Z cpu7:65593)ScsiDevice: 3163: Failing registration of device ‘t10.WD______My_Book_1140____WMC1T2972871____’: Unsupported sector size:40962017-12-27T16:22:13.253Z cpu7:65593)ScsiEvents: 545: Event Subsystem: Device Events, Destroyed!2017-12-27T16:22:13.253Z cpu7:65593)WARNING: NMP: nmp_RegisterDevice:851: Registration of NMP device with primary uid ‘t10.WD______My_Book_1140____WMC1T2972871____’ failed. Not supported2017-12-27T16:22:13.253Z cpu7:65593)StorageApdHandler: 1062: Freeing APD handle 0x43029e213fd0 []2017-12-27T16:22:13.253Z cpu7:65593)StorageApdHandler: 1147: APD Handle freed!

Загрузка vApp в VMware Cloud Director

Переходим в vcd.cloud4y.ru и загружаем vApp из OVF.

Нажимаем Browse и выбираем все файлы, которые мы экспортировали из vCenter.

На последующих шагах принимаем EULA и не вносим изменений в параметры развёртывания. Нажимаем Next-> Next -> … -> Finish.

Дожидаемся окончания загрузки. Теперь мы можем сохранить готовый vApp в каталог.

Спасибо за внимание!

Что ещё интересного есть в блоге Cloud4Y

→ Пароль как крестраж: ещё один способ защитить свои учётные данные

→ Тим Бернерс-Ли предлагает хранить персональные данные в подах

→ Виртуальные машины и тест Гилева

→ Создание группы доступности AlwaysON на основе кластера Failover

→ Как настроить SSH-Jump Server

Подписывайтесь на наш Telegram-канал, чтобы не пропустить очередную статью. Пишем не чаще двух раз в неделю и только по делу.

Важные ссылки

- ESXi System Storage Changes

- ESXi System Storage While Upgrading

- ESXi System Storage FAQs

- VMFS-L locker partition corruption

- Bootbank cannot be found at path ‘/bootbank’ errors being seen after upgrading to ESXi 7.0 U2

- Creating a persistent scratch location for ESXi 7.x/6.x/5.x/4.x

- Configure ESXi Dump Collector with ESXCLI

- VMware KB Article 85615

P.S. Перевод выполнен комбинацией машинного обучения и человеческого интеллекта в пропорции 99/1. Если есть пожелание поправить чего, то пишите в комментарии.

P.P.S. Качество картинок везде исправлено до приемлемого (в отличии от оригинальной статьи). Таблица сделана текстом, опечатки оригинальной исправлены.

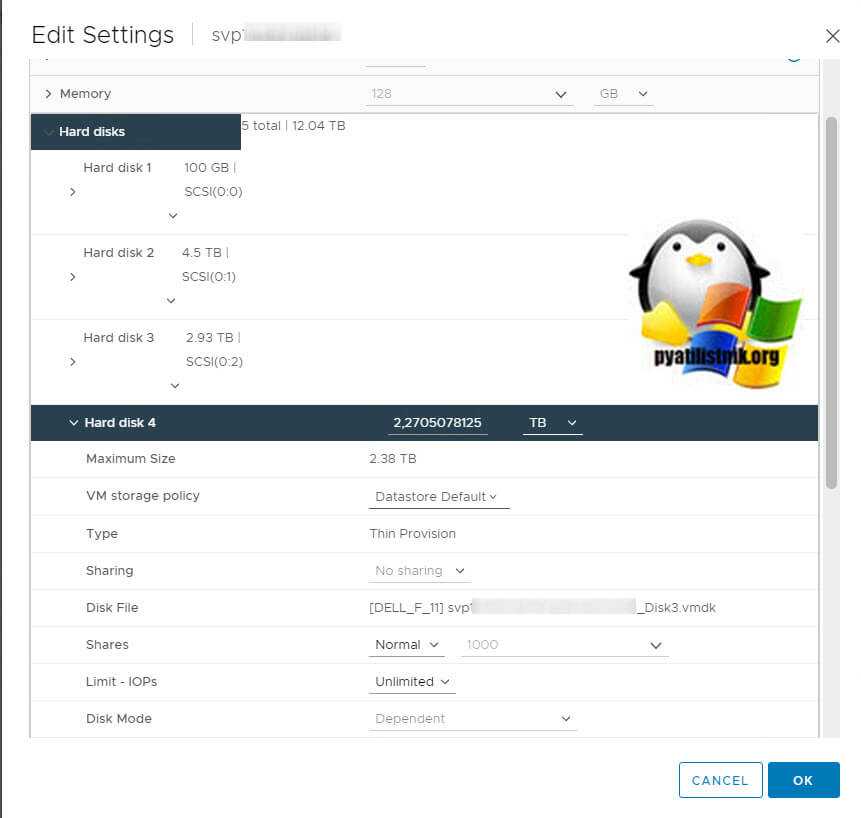

Постановка задачи

У меня в организации есть vCenter Server 7 на котором есть кластер из 24 ESXI хостов. Им презентованы общие датасторы. На одном из датасторов не правильно было спланировано дисковое пространство виртуальных дисков для одной из виртуальных машин, в итоге при заполнении дисков внутри гостевой операционной системы, мы поймали ошибку «There is no more space for virtual disk». Получилось, что суммарный выделенный объем виртуальных дисков превысил размер VMFS хранилища.

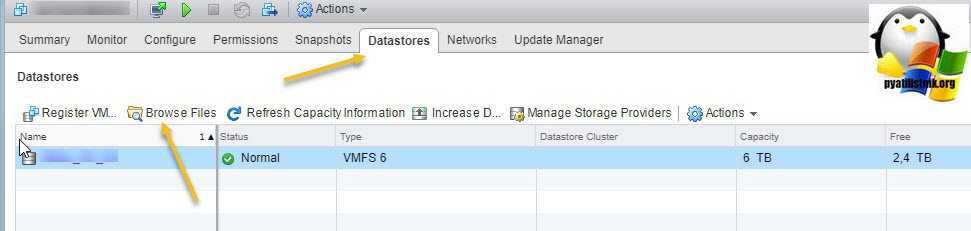

В моем примере 11-ое хранилище почти заполнено и там осталось всего 111 из 6 ТБ.

С данного датастора я хочу мигрировать один из виртуальных дисков, размером 2,2 ТБ на другой датастор.

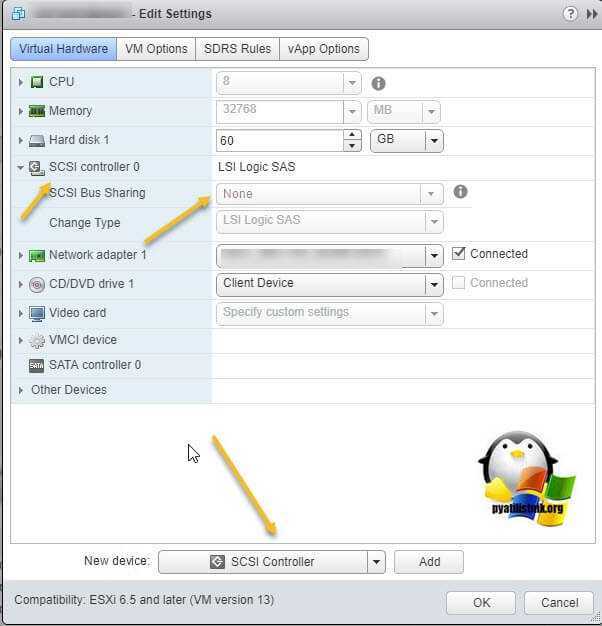

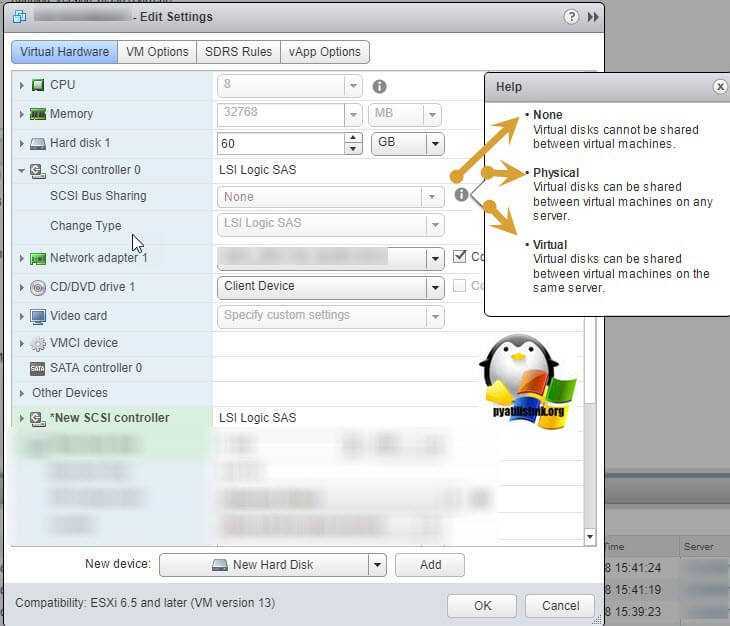

Как подключить общий диск в VMware ESXI 6.5 и выше

Предположим, что общее внешнее хранилище (подключенное к каждому хосту ESXi с использованием iSCSI или Fibre Channel SAN) уже представлено всем хостам VMWare ESXi, на которых запущены виртуальные машины, которым вы хотите добавить общий виртуальный диск. На обеих виртуальных машинах вам нужно добавить новый контроллер SCSI. Объясню для чего нужно добавлять новый SCSI Controller. Когда вы создаете новую виртуальную машину ESXI у вас по умолчанию уже будет один LSI Logic SAS контроллер (SCSI Controller), но он работает во первых в режиме SCSI Bus Sharing «None», то есть не работает с общими дисками VMDK, это можно поправить при выключенной машине, но VMWare не рекомендует совмещать при работе обычных дисков и Multi-Writer VMDK дисков на одном LSI Logic SAS контроллере.

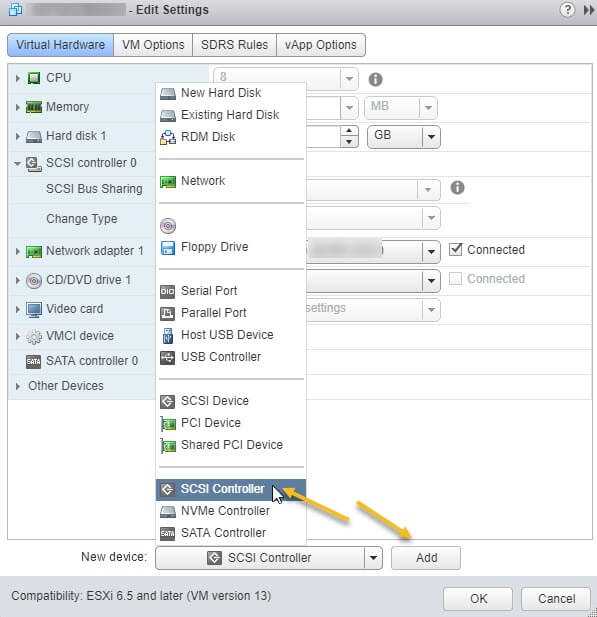

Поэтому нам первым делом необходимо в свойствах виртуальной машины добавить новый SCSI Controller.

Если посмотреть подсказку у LSI Logic SAS контроллера, то вы увидите три его режима:

- None — для работы с не кластерными Multi-Writer дисками

- Physical — виртуальные диски могут быть общими для виртуальной машины и физическим сервером

- Virtual — для работы с общим диском для нескольких виртуальных машин

Хочу отметить, что к одному LSI Logic SAS контроллеру можно одновременно подключить до 16 виртуальных дисков

Делается это через пункт «New Device» и нажатии кнопки Add, для SCSI Controller.

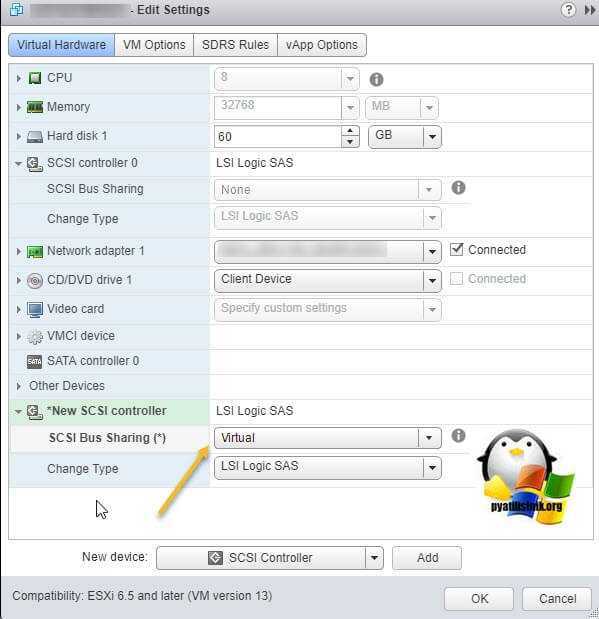

Далее у нового, добавленного контроллера вы в пункте «SCSI Bus Sharing» выберите тип «Virtual». Можете сохранить конфигурацию виртуальной машины, через нажатие кнопки «Ок»

Далее на первой машине, где мы только что добавили новый контроллер, вам нужно создать новый виртуальный диск, делается это так же, через пункт «New Device»

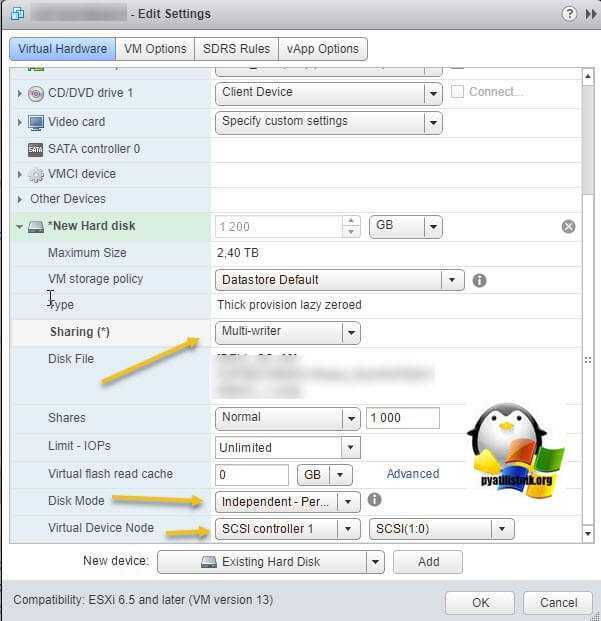

Откройте параметры нового виртуального диска. Для того, чтобы сделать его общим между виртуальными машинами VMware ESXI, вам необходимо выставить соответствующие настройки:

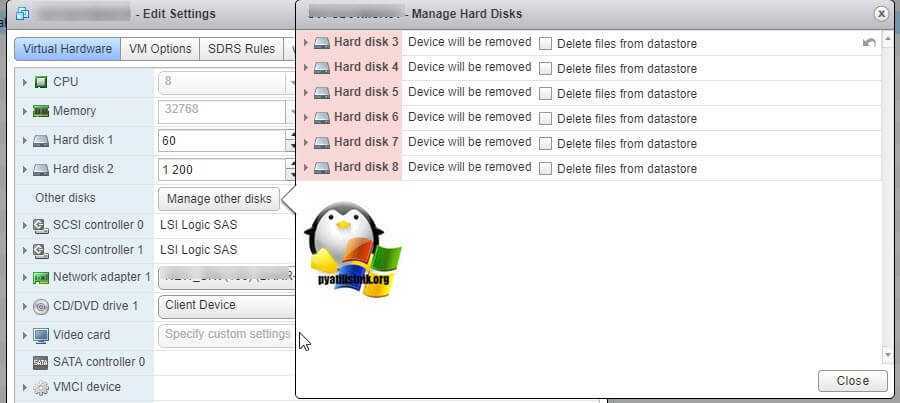

Далее я для своего удобства, хочу чтобы общие диски лежали в отдельной папке, а так как они по умолчанию создаются в папке с виртуальной машиной да и еще имеют имя дисков, как имя машины_цифра, я бы такое хотел поправить. Для этого я в конфигурации виртуальной машины удаляю все созданные диски, но я не ставлю галку «Delete files from datastore», то есть по сути на датасторе они остаются.

Данное действие не обязательное, вы его можете пропустить и просто сохранить настройки, после чего переходить к настройке второй виртуалки, об этом чуть ниже

Далее я иду на датастор на котором находится виртуальная машина с общими дисками (Datastore — Browse Files).

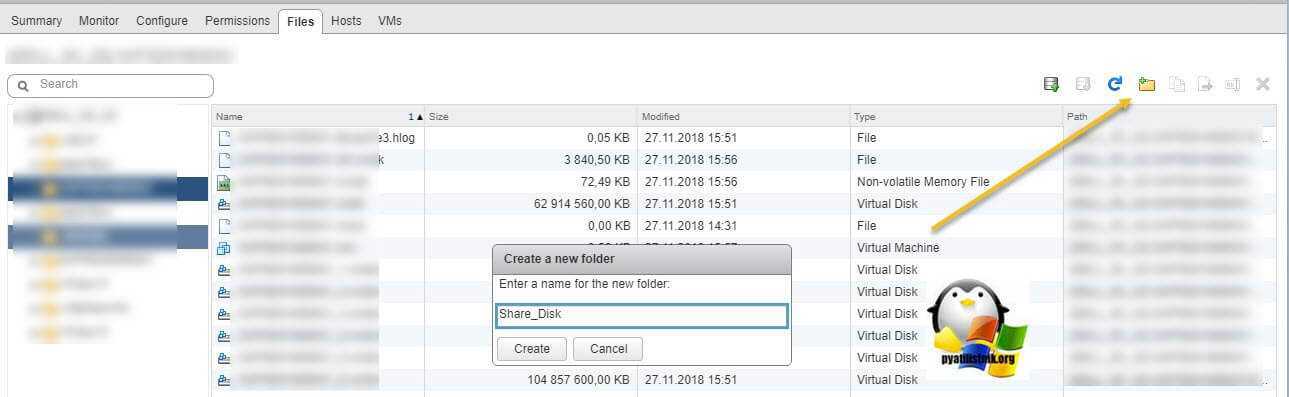

Нахожу нужные мне Multi-Writer диски. Создаю новую папку

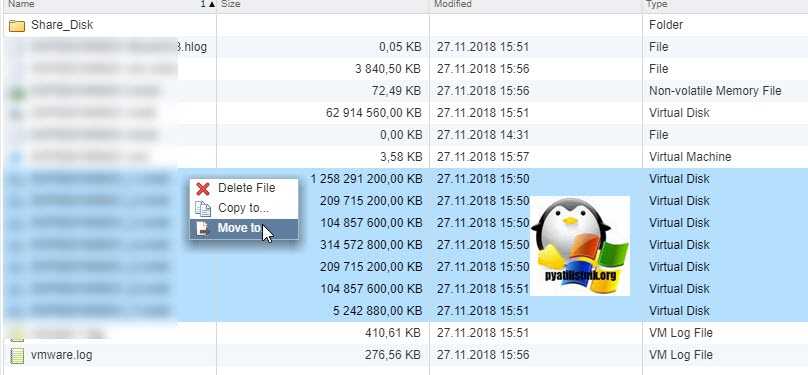

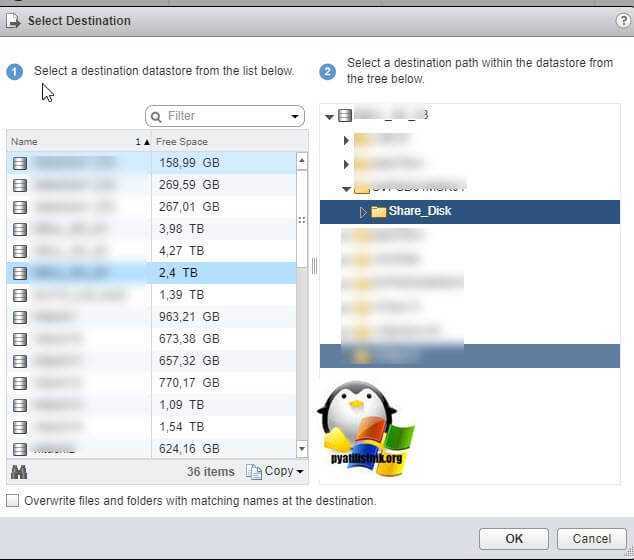

И перемещаю в новую папку общие диски, хочу отметить, что вы их можете переместить на любой общий между хостами ESXI датастор.

Я делаю «Move to» на тот же латасторе, но в новую папку. Этим я добьюсь, что буду видеть явным образом общие кластерные диски.

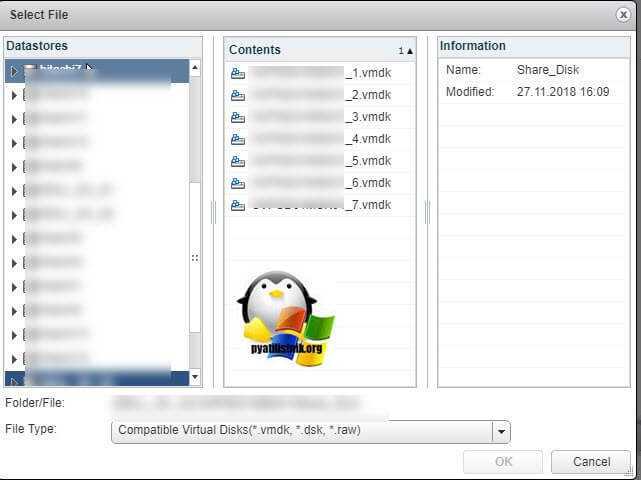

Так как я диски до этого удалил, для удобства, то мне их нужно заново добавить. Если вы до этого не удаляли, то сделайте эти действия только для второй виртуальной машины. Открываем настройки виртуальной машины и нажимаем добавить новое устройство, выбираем пункт «Existing Hard Disk», это у нас выбор существующего общего кластерного диска.

Указываем на каком датасторе у нас лежит Multi-Writer диск и выбираем нужный VMDK, в моем случае их семь.

Выставляем нужные параметры:

- Disk Provisioning — «Thick provision Eager zeroed thick disks»

- Sharing — «Multi-Writer»

- Disk Mode — «Independent Persistent»

- Virtual Device Node — выберите наш новый LSI Logic SAS контроллер, работающий в режиме «SCSI Bus Sharing Virtual»

Если такой диск не один, то добавляем все за один раз для экономии времени. Проделываем такое добавление общих дисков на всех виртуальных машинах, где планируется использовать Multi-Writer.

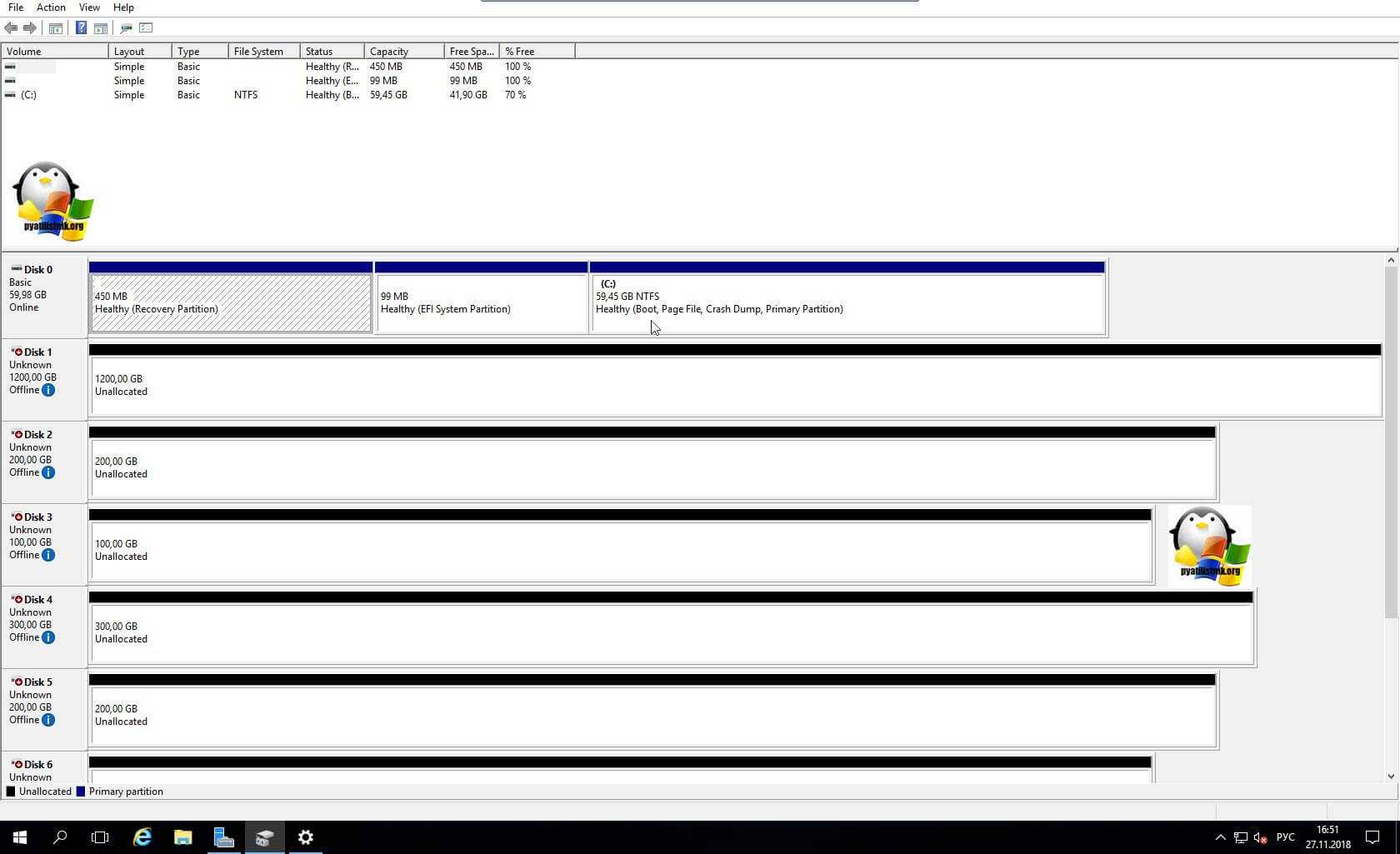

Далее уже в операционной системе Windows Server, зайдя в оснастку «Управление дисками» вы обнаружите ваши диски. Остается их только разметить в GPT формат и отдать под кластер.

Физическая и логическая коммутация

Совокупность оборудования и линий связи между СХД и серверами образуют так называемую SAN сеть. Отказоустойчивое подключение участников SAN сети подразумевает постоянное наличие хотя бы одного пути между инициатором (хост) и таргетом (СХД). Т.к. СХД сейчас практически поголовно имеют минимум два контроллера, каждый сервер должен иметь связь с каждым из них. В простейшем варианте серверы подключаются к СХД напрямую. Такой режим работы называют Direct Attach. СХД Qsan поддерживают такой режим работы. В этом случае каждый сервер должен иметь двухпортовую HBA для соединения с каждым контроллером СХД. Т.е. между сервером и СХД будет 2 пути. При наличии максимального количества опциональных портов в таком режиме к СХД можно подключить до 10 серверов через iSCSI или до 8 серверов через Fibre Channel.

В большинстве случаев серверы соединяются с СХД через коммутаторы. Для большей надежности их должно быть два (в общем случае их, конечно же, может быть больше, но это они все равно делятся на две группы – фабрики). Этим выполняется защита от выхода из строя самого коммутатора, линка и порта контроллера СХД/HBA. В этом случае каждый сервер и каждый контроллер СХД подключается к каждому коммутатору. Т.е. между каждым сервером и СХД будет 4 пути (в случае двух коммутаторов).

Важные замечания по поводу параметров SAN сети:

Фабрики между собой не соединяются для изоляции в случае возникновения ошибок в сети;

Если протокол iSCSI делит использование коммутаторов с другими сервисами, то весь трафик iSCSI должен быть помещен в изолированный VLAN;

Для протокола Fibre Channel необходимо настроить в коммутаторах зонирование по принципу «один инициатор – один или несколько таргетов» для исключения взаимовлияния серверов друг на друга;

Для iSCSI соединений со скоростью 10G и выше рекомендуется включить поддержку кадров большого размера (MTU=9000) с целью увеличения производительности

Важно помнить, что необходимо изменить MTU у всех участников сети: порты контроллера СХД, физические коммутаторы, виртуальные коммутаторы vSwitch, порты vKernel.. Для Qsan параметр MTU меняется на каждом порту каждого контроллера в меню iSCSI Ports

Для Qsan параметр MTU меняется на каждом порту каждого контроллера в меню iSCSI Ports

Для ESXi параметр MTU меняется у vSwitch: хост → Configure → Virtual Switches → Edit для конкретного коммутатора

Для vKernel параметр MTU меняется хост → Configure → Virtual Switches → Edit Settings для конкретного порта

Для получения инструкций по изменению MTU у физических коммутаторов рекомендуем обратиться к документации конкретного производителя.

USB флешка как vmfs datastore – Дополнительная информация

Чем же мы рискуем удалив VMFSL раздел? В данный раздел были объединены разделы small core-dump, large core-dump, locker и scratch.

small core-dump и large core-dump – разделы, куда ESXi может выгружать данные необходимые для диагностики. В случае отсутствии этих разделов, ESXi не сможет выгрузить в них дампы которые могут понадобится платной техподдержке.

scratch – раздел хранящий логи Syslog, результаты команды vm-support и userworld swop файл. В отсутствии этого раздела, ESXi хранит его данные в RAM диске и эти данные каждый раз стираются при перезагрузке сервера.

Всё это было объединено в единый большой раздел, который в случае если наш носитель объёмом меньше 128ГБ, займёт все оставшееся после первых трёх разделов место. Если же носитель больше 128ГБ, то следом будет создан VMFS датастор.

Удаление и создание нового раздела ручками, может привести к тому что прежде чем снова установить на эту флешечку гипервизор, придётся её отформатировать. Из 10 гипервизоров у меня такое случилось с одним. Что привело к такому результату сказать не могу, но флешки везде были sandisk.

Наилучшим решением будет взять нормальную флешку (не сандиск), с помощью утилиты производителя перепрошить эту флешку так чтобы она опознавалась как два отдельных диска (именно диска, не раздела). Диски эти сделать объемом 8ГБ + Всё остальное. В раздел 8ГБ установить гипервизор, он тогда сам спокойно ужмётся до 8 гигов заняв всё пространство этого диска, а на втором диске поднять VMFS датастор. Это будет самое лучшее решение. Но опять же повторюсь что флешку нужно покупать такую, чей контроллер можно перепрошить.

О том как получить и установить ESXi 7 можно почитать тут: Установка ESXi 7. Бесплатная лицензия. Или посмотреть тут:

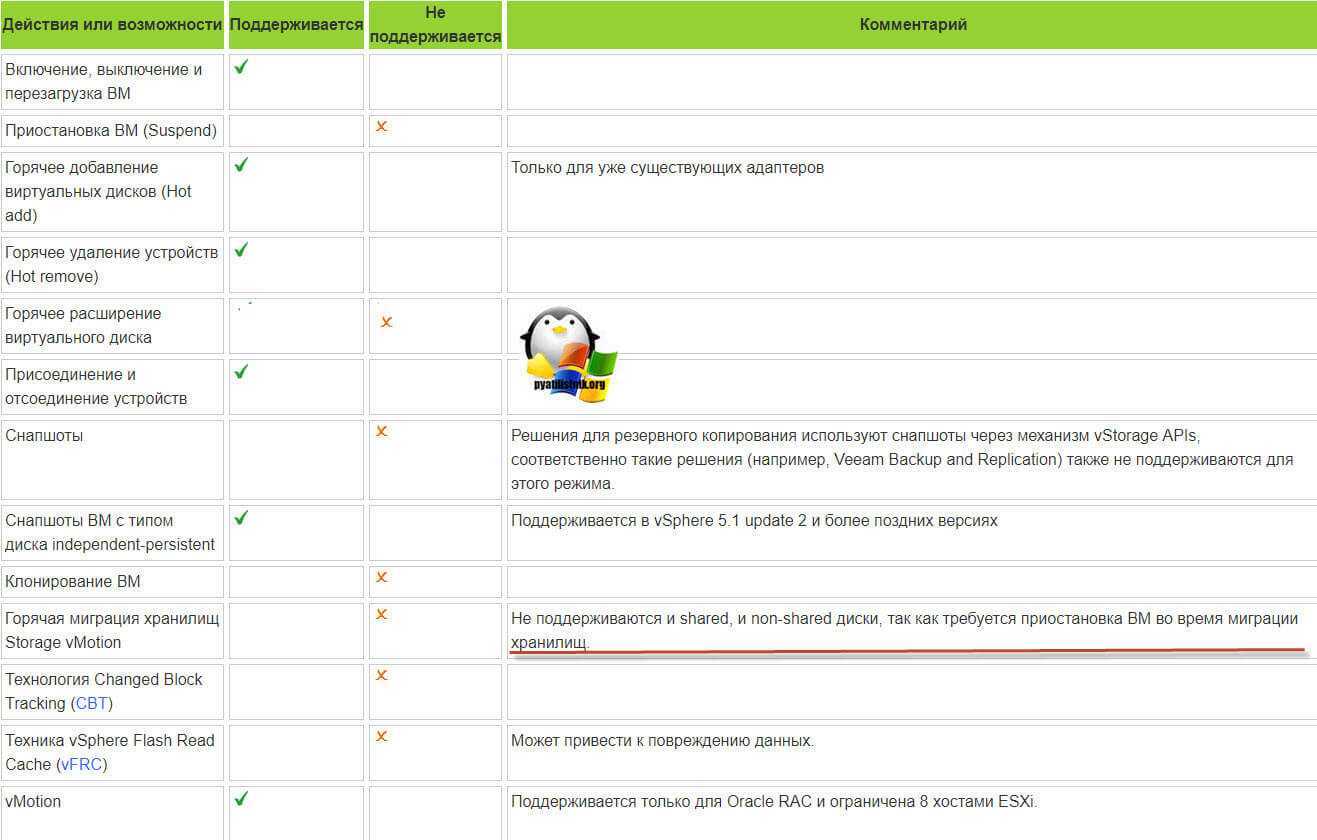

Ограничения общих дисков VMware ESXI

Без некоторых нюансов все же не обошлось, хочу выделить некоторые ограничения при использовании общих дисков:

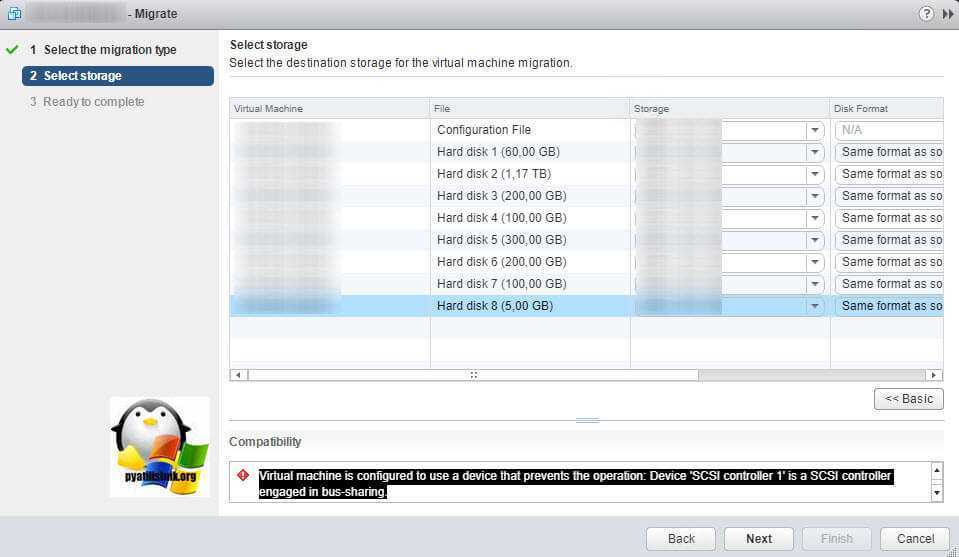

Самое главное, что у вас пропадет возможность производить миграцию виртуальной машины, обычный vMotion и Storage vMotion (Подробнее https://kb.vmware.com/s/article/1003797)

Например, при попытке сделать Storage vMotion вы получите ошибку:

Virtual machine is configured to use a device that prevents the operation: Device ‘SCSI controller 1’ is a SCSI controller engaged in bus-sharing

Если нужно будет мигрировать, то придется выключать виртуалку.

Вы не сможете на живую произвести расширение дисков, при попытке вы получите вот такую ошибку:

The disk extend operation failed: The virtual disk requires a feature not supported by this program. Hot-extend is currently supported only for VMFS flat virtual disks without snapshots opened in persistent mode.

Если вы вдруг разметите оба диска в NTFS на двух хостах и попытаетесь на них писать, создав на одном одну папку, а на втором вторую, то хосты эти папки не увидят, каждый свою, учтите, это вам не общий диск с синхронизацией файлов, Multi-Writer VMDK именно нужен для кластеризации.

Access VMFS Volume from Windows

To connect the VMFS volume and access virtual machine files from Windows, you’ll need a special Java driver – Open Source VMFS Driver. This driver requires Java version 6 or later and allows to mount VMFS volumes in read-only mode.

You can download Open Source VMFS Driver here: https://code.google.com/archive/p/vmfs/. At the current moment this project has not been updated since 2010 and the latest version of the driver that is available on the site is VMFS Driver r95, which supports only VMFS 3 (< ESXi 5).

Note. If you try to connect to a newer version of VMFS, you will receive an error message: No VMware File System detected.

-

- Download Open Source VMFS Driver (fvmfs_r95_dist.zip and unpack it to any directory (e.g., C:\vmfs).

-

You can check the operation of the java-application fvmfs.jar as follows:

1 2

cd \vmfs java -jar fvmfs.jar

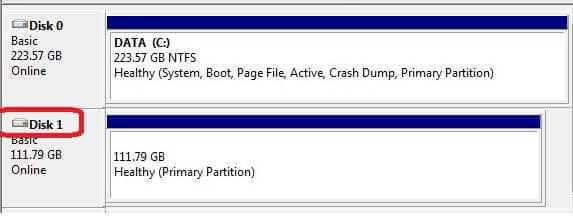

- Next, you need to determine the number of the HDDs containing VMFS storage that is connected to your Windows computer. You can find the disk number in the Disk Management Console or using diskpart (in our example, the connected disk has the index 1 – Disk1. For fvmfs driver, this disk has the following name: \\.\PhysicalDrive1).

-

Try to get information about this disk:

1

java -jar fvmfs.jar \\.\PhysicalDrive1 info

-

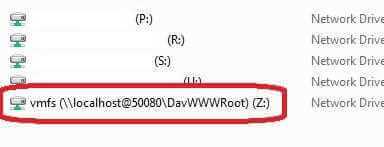

Share this disk with WebDAV:

1

java -jar fvmfs.jar \\.\PhysicalDrive1 webdav

- Make sure that service WebClient is started. If service disabled, run it.

-

Mount the shared disk:

1

net use * http//localhost:50080/vmfs

- A new disk that contains VMFS datastore available for reading should appear in the system;

- A new disk that contains VMFS datastore available for reading should appear in the system;

- Do not close the console window while working with files on the VMFS storage.

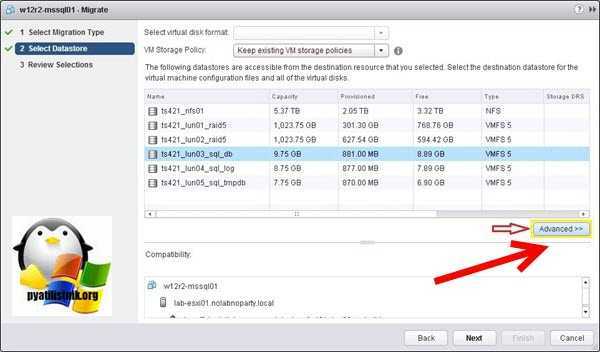

Процесс миграции диска виртуальной машины ESXI в vCenter 6.5

Давайте еще покажу, как это выглядело в vCenter Server 6.5. Так же откройте веб клиента и щелкните правым кликом по виртуальной машине, из контекстного меню выбираем пункт «Migrate».

Чтобы переместить только файлы виртуальных винтов выбираем пункт «Change Datastore» и next

Видим список доступных датасторов, нам необходимо для выбора отдельных дисков нажать кнопку «Advanced».

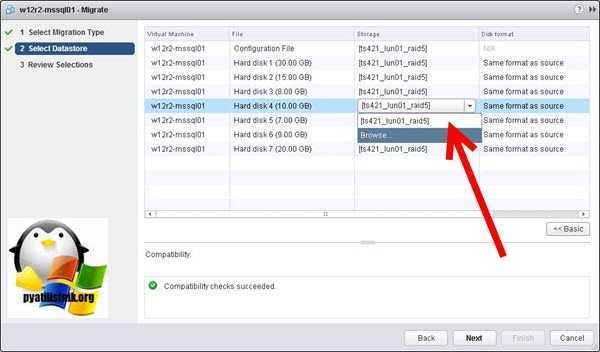

Далее выберите нужный виртуальный диск и в столбце «Storage», у вас откроется список датасторов.

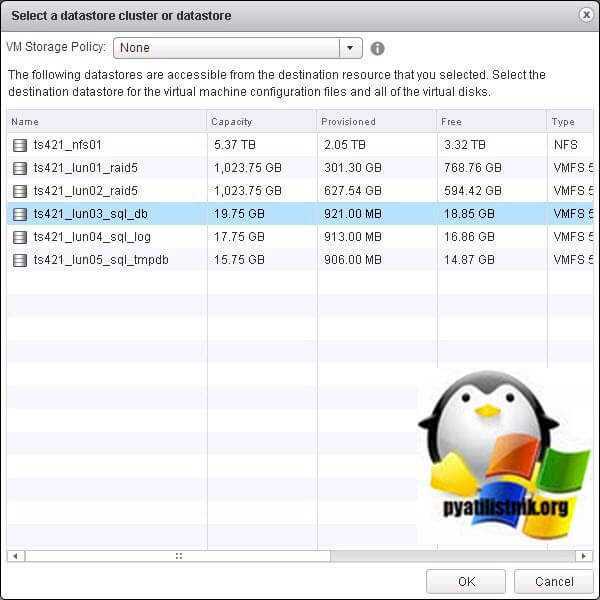

Далее вы можете выбрать другую политику хранилищ и выберите куда его нужно мигрировать.

На следующем шаге у вас есть возможность выбрать тип диска.

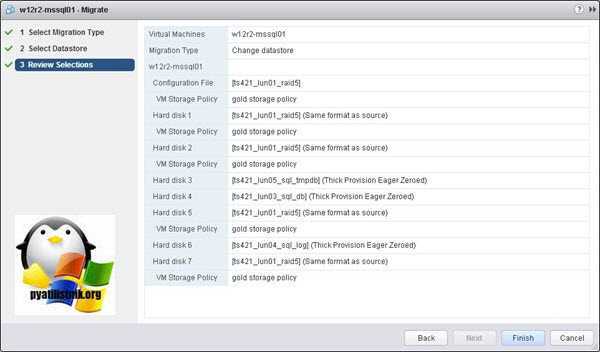

Проверяем, что все указано верно. Если так, то запускаем процесс миграции.

Как я и писал выше, время переезда зависит от размера виртуальных дисков и скорости вашего СХД.

How to access VMFS Datastore from Linux, Windows, and ESXi

Now let’s take a look at how our Support Engineers access the data stored on the VMFS database of the ESXi host.

If the ESXi host crashes, but the local disk (disks) of the server are still functional, then it is always possible to copy the virtual machine files (both data drives and configuration files) from VMFS datastore and run VM on a different server (even on VMware Workstation or Hyper-V). The main problem is that the common operating systems (Windows and Linux) by default do not recognize the partition with the VMFS file system, because they do not have a VMFS driver.

Let’s see the different ways of accessing data on the VMFS datastore.

How to Mount VMFS file system on Linux (Ubuntu)

First, we connect to a physical disk with the VMFS file system to the computer (server) with Ubuntu.

In order to access the data on the VMFS volume, we have to install a special third-party vmfs-tools package. This package allows accessing VMFS from non-ESXi hosts. It is possible to access data on this partition in read-only mode.

We run the below command to install the package.

Next, to install package dependencies, we run the below command.

After the package is installed, we need to create a mount point in which the VMFS partition will be mounted:

The next step is to look into the partitions on the disks. Creates a number of service partitions when installed in addition to the partition for virtual machine files (VMFS partition).

If the ESXi version is 4 or earlier, or a VMFS storage has been updated from VMFS 3 to VMFS 5, and its size doesn’t exceed 2TB, then we can display the list of disks and partitions by executing below command.

As a result of the above command, we found VMFS partition is /dev/sdb3

Now we only have to mount a partition with the VMFS storage:

Then list the contents of the mounted partition:

Now we see all the virtual machine files on the VMFS storage that is available in read-only mode. It means that we can now copy the directories and/or individual files of the necessary virtual machines to a separate drive and run them on another ESXi host.

Access VMFS Volume from Windows

In order to connect the VMFS volume and access virtual machine files from Windows, we’ll need a special Java driver – Open Source VMFS Driver. This driver requires Java version 6 or later. It allows mounting VMFS volumes in read-only mode.

- First, we download Open Source VMFS Driver (fvmfs_r95_dist.zip and unpack it to any directory (e.g., C:\vmfs).

- Next, we can check the operation of the java-application fvmfs.jar by running the below commands.

- Next, we determine the number of HDDs containing VMFS storage that is connected to the Windows computer. We can find the disk number in the Disk Management Console or using diskpart (in our example, the connected disk has the index 1 – Disk1. For fvmfs driver, this disk has the following name: \\.\PhysicalDrive1).

- Then we try to get information about this disk:

- After that, we share this disk with WebDAV:

- Then mount the shared disk:

- A new disk that contains VMFS datastore available for reading should appear in the system;

However, we don’t close the console window while working with files on the VMFS storage.

Mounting an existing VMFS Datastore on a new ESXi host

As we saw earlier in both of the above cases, third-party VMFS drivers for Linux and Windows do not allow working with VMFS 6.0. Therefore, the best way to access data on a VMFS partition of a failed server is to connect its disks to a new ESXi server.

The new ESXi host must correctly identify the attached VMFS datastore and then we will be able to access the files on it.

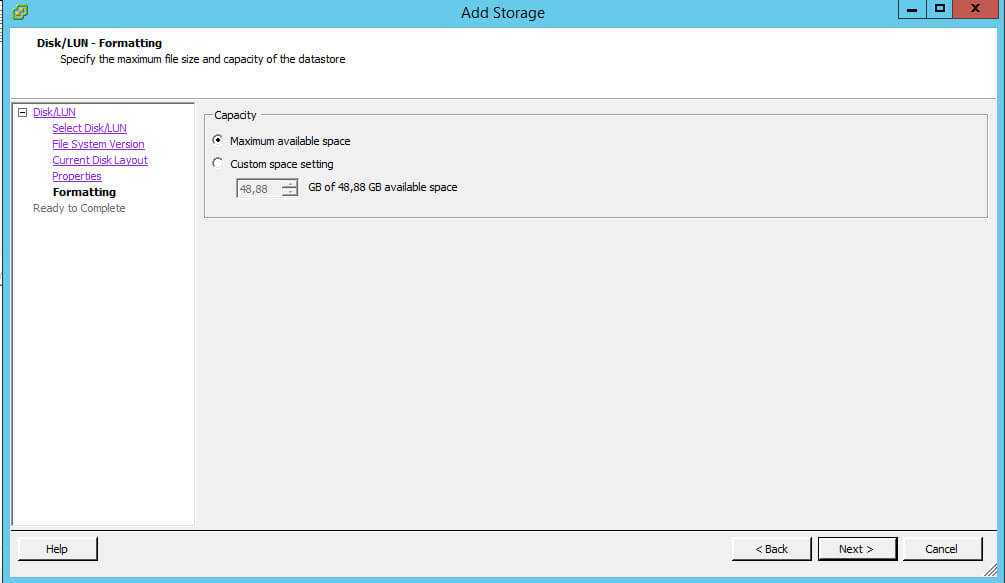

Here are the steps that we follow to connect an existing VMFS storage to a new ESXi host without formatting it:

- First, we connect to the new ESXi server using the vSphere Web Client;

- Next, we connect the drive to the new server and run Storage rescan;

- Then we go to the Configure >> Datastores section and select Create a new datastore item;

- After that, we select the storage type: Disk or LUN;

- In the list of available devices, we select the connected drive (LUN) with the VMFS storage;

- Then we select the connection mode. Select Keep the existing signature item;

- We click the Finish button.

- We go to the host’s storage section. Here we select the connected storage. Its contents can be displayed by clicking on the

- Datastore browser button;

- Finally, now we can find the necessary vmx files, register them on the host, and immediately start the critical virtual machines.

USB флешка как vmfs datastore – Ищем нужный раздел через Web Client

-

Переходим в Storage > Devices

Тут должна быть отображена наша флешка, на которую установлен гипервизор. Кликаем на строку с ней.

-

Смотрим информацию по нашей флешке

Видим что ESXi7 запилился в начало флешки, а всю область за разделом 6. Basic Data и до конца он разметил как VMFSL раздел. Окончание L означает что этот раздел предназначается лишь для использования текущим хостом и на нём не применяются механизмы применяемые для vmfs5 и vmfs6 разделов расчитанных на то что с файлами может работать одновременно несколько гипервизоров. На месте 7-го раздела мы и разместим наш датастор :). Путь к нашему разделу выглядит как

. Именно его мы будем указывать в командах ниже.

Доступ к VMFS разделу из Ubuntu

В этой секции мы покажем, как смонтировать раздел с файловой системой VMFS на компьютере с установленной ОС Ubuntu (Live CD с Ubuntu в этом сценарии нам не подойдет, скачать серверные ubuntu с 10 по 14 версии и выше).

В первую очередь необходимо подключить физический диск с VMFS к компьютеру с Ubuntu.

Чтобы получить доступ к данным на VMFS томе, нам понадобиться установить специальный пакет vmfs-tools. Данный пакет позволяет получить доступ к файловой системе раздела VMFS с не ESX/ESXi хостов. Доступ возможен в режиме только на чтение (read-only).

Установим пакет следующей командой

apt-get install vmfs-tools

Примечание. В репозитариях Ubuntu пока доступна только версия vmfs-tools 0.2.1, основной ее недостаток – она умеет работать только с файловой системой VMFS v4. Если вам нужно смонтировать датастор с VMFS 5, придется самостоятельно скачать и установить версию vmfs-tools не ниже 0.2.5, например, здесь: http://ge.archive.ubuntu.com/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_i386.deb – пакет для 32 битной системы http://de.archive.ubuntu.com/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_amd64.deb – пакет для 64 битной системы

Качаем соответствующую версию пакета так:#wget http://de.archive.ubuntu.com/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_amd64.deb

И устанавливаем его:#dpkg -i vmfs-tools_0.2.5-1_amd64.deb

Если нужно будет удовлетворить зависимости, воспользуемся командой:#apt-get install vmfs-tools

После установки пакета, создадим каталог для точки монтирования:#mkdir /mnt/vmfs

Следующий шаг – нужно разобраться с разделами на дисках. Гипервизор ESXi при установке помимо, собственно, раздела для файлов виртуальных машин (VMFS) создает множество служебных разделов. Если версия ESXi 4 или ниже, или VMFS хранилище было обновлено с версии VMFS 4 до VMFS 5, а его размер не превышает 2 Тб, выведем список дисков и разделов так:#fdisk -l

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Как мы видим, раздел с файловой системой VMFS – /dev/sd3 (метка VMware VMFS) Важно. Т.к

в ESXi 5 используется VMFS v5 с таблицей разделов GPT (таблица GUID Partition Table используется вместо MBR, что позволяет создавать хранилища большего размера и пробрасывать RDM диски в режиме физической совместимости размером более 2 TB). Поэтому для просмотра таблицы разделов придется вместо fdisk использовать команду parted. Итак, выведем информацию о разделах так:#parted -l

Осталось смонтировать партицию с хранилищем VMFS:#vmfs-fuse /dev/sdb3 /mnt/vmfs

Выведем содержимое смонтированного раздела:#ls -all /mnt/vmfs

Итак, теперь мы видим все файлы виртуальных машин на VMFS хранилище, которое доступно нам для чтения, а это значит, что мы можем скопировать каталоги и/или отдельные файлы нужных виртуальных машин на отдельный диск и запустить их на другом гипервизоре ESXi. Доступ к VMFS разделу из Windows

Для доступа к данным на VMFS разделе из Windows, нам понадобится специальный открытый драйвер Open Source VMFS Driver, написанный на Java. Драйвер требует версию Java не ниже 6 и также позволяет монтировть VMFS-тома только для чтения Итак, качаем Open Source VMFS Driver по этой ссылке https://code.google.com/p/vmfs/ и распаковываем его в произвольный каталог (допустим C:\vmfs) Проверить работу java-приложения fvmfs.jar можно так:cd \vmfsjava -jar fvmfs.jar Определяем номер диска с хранилищем VMFS, подключенный к нашему Windows-компьютеру. Номер диска можно узнать с помощью консоли управление дисками или diskpart. (В нашем примере подключенный диск имеет индекс 1 – Disk1. Для драйвера утилиты fvmfs, этот диск будет именоваться так: \\.\PhysicalDrive1)

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Попытаемся получить информацию о диске: java -jar fvmfs.jar \\.\PhysicalDrive1 info

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Предоставим общий доступ к данному диску с помощью webdav: java -jar fvmfs.jar \\.\PhysicalDrive1 webdav

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Подключим расшаренный диск: net use * http://localhost:50080/vmfs

В системе должен появиться новый диск, с содержимым датастора VMFS, доступный для чтения.

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Вот так вот просто получить доступ к данным на VMFS разделе из-под Windows / Linux. До новых встреч. С вами был Иван Семин, автор и создатель IT портала Pyatilistnik.org

![Fc подключение к схд сервера под vmware esxi [colobridge wiki]](http://smartshop124.ru/wp-content/uploads/c/5/c/c5c2943cd94d054ce420e6b79363c446.jpeg)

![Fc подключение к схд сервера под vmware esxi [colobridge wiki]](http://smartshop124.ru/wp-content/uploads/4/5/4/45410889009fefb14be5e66a5ce5f2e0.jpeg)