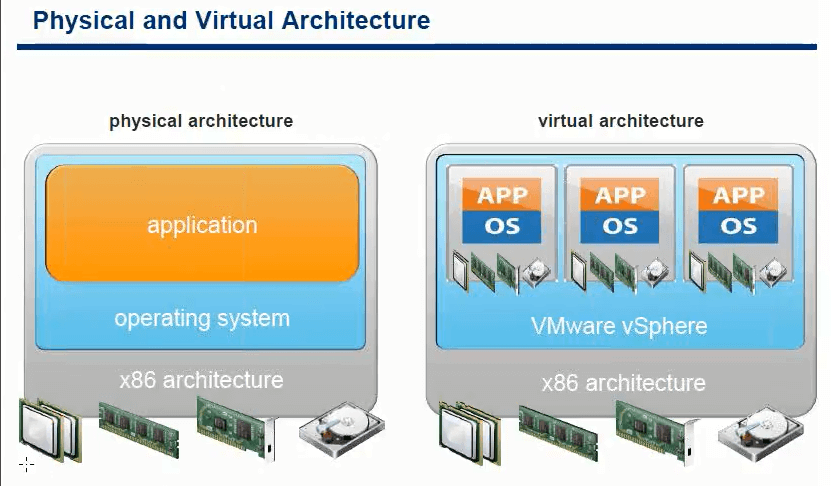

Физическая и виртуальная архитектура

Ниже представлена картинка как выглядит Physical архитектура и виртуализация vmware. В физической архитектуре, ос функцианирует по верх железного оборудования. Рассматривая виртуализацию vmware, тут уже все немного иначе. Отличие в прослойке гипервизора ESXI (VMware vSphare). VMware vSphare Позволяет запускать экземпляры виртуальных машин, эмулируя для них оборудование. В такой реализации будет другая схема общения с ресурсами. Об этом мы поговорим в будущем.

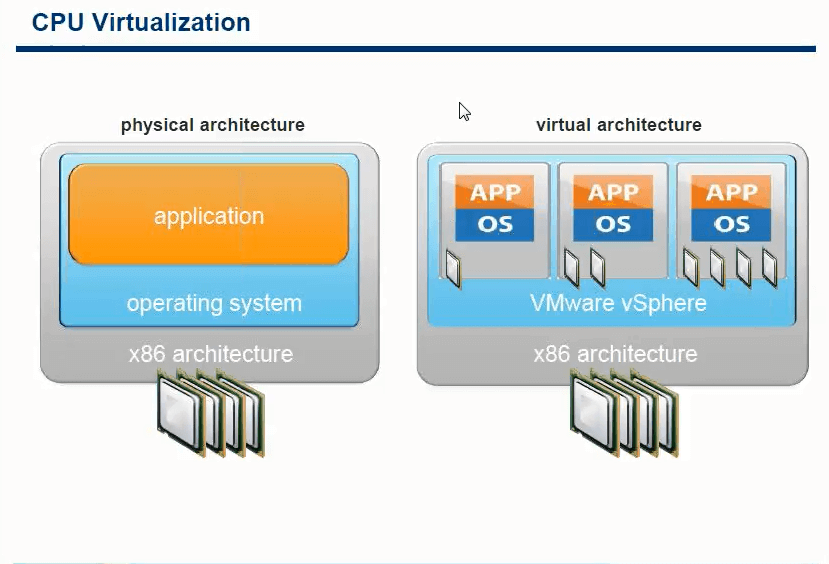

В мире виртуализации есть одна вещь, которая никогда не виртуализовывается, это друзья процессор CPU. Виртуализация vmware или MS этого делать не умеют. Стартуя виртуальная машина, в зависимости от настроек получает одно или более ядер, виртуалка осознает какой тип CPU, версия и частотность на нем, все команды она на прямую отправляет на него

По этому очень важно, правильное распределение по ядрам CPU, чтобы виртуальные машины не мешали друг другу

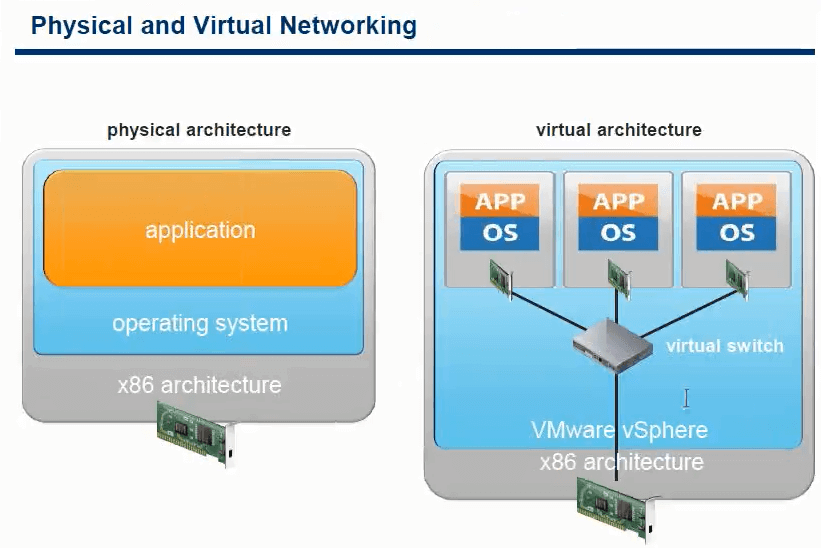

Что касается виртуализации сети, тут дело выглядит следующим образом. Если рассматривать физический сервер, то имея у себя сетевой адаптер, он использует его монопольно, со всей полосой пропускания. Рассматривая virtual архитектуру, то есть виртуальный коммутатор, в который подключенный виртуализованные сетевые адаптеры, а виртуальный коммутатор, общается уже с физическим сетевым адаптером или адаптерами. Вся пропускная способность делится на все виртуальные машины, но можно настроить приоритеты.

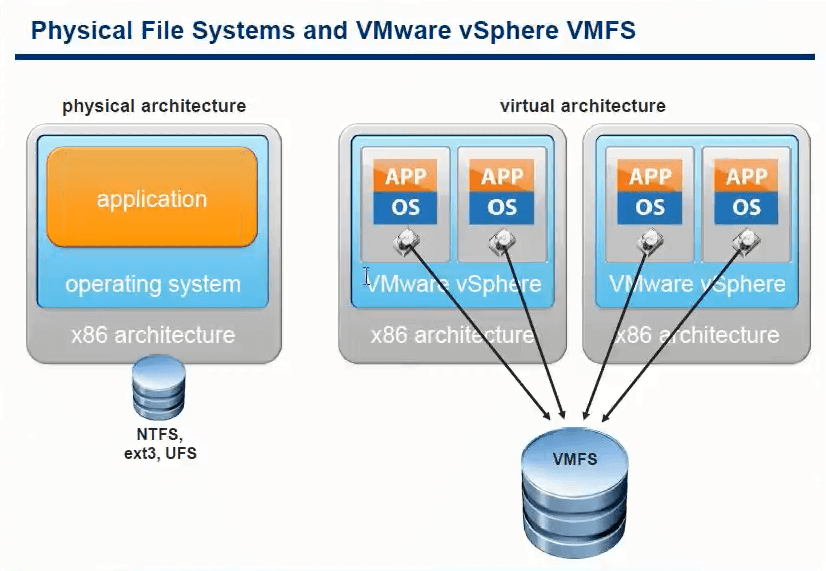

Осталось рассмотреть еще дисковую подсистему

Слева классическая ситуация с железным хостом, не важно как ос, использоваться все будет в монопольном режиме. Рассматривая виртуальные жесткие диски, тут иначе

Каждая ос думает, что у нее настоящий жесткий диск, но по факту это файл лежащий на общем хранилище, как и файлы других виртуальных машин. И не важно по какому протоколу соединено с хостом хранилище.

Надеюсь вы теперь представляете что такое виртуализация и как ее использовать, а главное для чего. Далее советую вам почитать, Виртуальная машина, что это такое.

Материал сайта pyatilistnik.org

vMotion: як мігрувати ВМ між серверами

Щоб за допомогою vMotion перенести запущену ВМ між двома ESXi хостами, запустіть vSphere Client, клацніть по ВМ і виберіть Migrate.

Виберіть тип міграції, який ви хочете використовувати:

- Change compute resource only — міграція ВМ на інший сервер ESXi;

- Change storage only — мається на увазі Storage vMotion — зміна Datastore, на якому зберігаються файли ВМ;

- Change both compute resource and storage — режим міграції без загального сховища (vMotion without shared storage / Shared-Nothing), при цьому файли ВМ копіюються між хостами черга мережу).

Я вибрав перший варіант.

Майстер міграції запропонує вибрати хост, кластер, resourse pool або vApp, в який потрібно перенести цю віртуальну машину. Виберіть хост. Якщо vMotion налаштований правильно, і не виявлено конфліктів, в секції Compatibility буде вказано: Compatibility checks succeeded.

натисніть Next.

Майстер міграції ВМ запропонує вибрати в яку мережі потрібно помістити vNIC мережевий ВМ при міграції. Якщо ви хочете, щоб ВМ була доступна після міграції, вона повинна бути поміщена в той же самий сегмент (VLAN), як і на вихідному хості. Якщо у вас використовується стандартний vSphere Switch, потрібно створити однакові групи портів (Port Group) на всіх ESXi хостах. При використанні VDS, групи портів на всіх хостах кластера однакові.

На останньому етапі потрібно вибрати пріоритет завдання міграції vMotion. За замовчуванням використовується найвищий пріоритет (Schedule vMotion with high priority). Я завжди використовую саме його.

залишилося натиснути Next -> Finish і запуститься процедура міграції ВМ на інший хост. За статусом міграції можна стежити в панелі Recent Tasks (завдання Relocate virtual machine). У моєму випадку процес міграції ВМ за допомогою vMotion по 10 Гб Ethernet зайняв близько 3 секунд.

Переконайтеся, що ваша ВМ тепер запущена на іншому хості ESXi.

Можна перемістити запущену ВМ на інший хост за допомогою PowerShell командлет Move-VM з PowerCLI. Наприклад, ми хочемо перенести все ВМ з хоста esxi-1 на esxi-2:

Как подключить общий диск в VMware ESXI 6.5 и выше

Предположим, что общее внешнее хранилище (подключенное к каждому хосту ESXi с использованием iSCSI или Fibre Channel SAN) уже представлено всем хостам VMWare ESXi, на которых запущены виртуальные машины, которым вы хотите добавить общий виртуальный диск. На обеих виртуальных машинах вам нужно добавить новый контроллер SCSI. Объясню для чего нужно добавлять новый SCSI Controller. Когда вы создаете новую виртуальную машину ESXI у вас по умолчанию уже будет один LSI Logic SAS контроллер (SCSI Controller), но он работает во первых в режиме SCSI Bus Sharing «None», то есть не работает с общими дисками VMDK, это можно поправить при выключенной машине, но VMWare не рекомендует совмещать при работе обычных дисков и Multi-Writer VMDK дисков на одном LSI Logic SAS контроллере.

Поэтому нам первым делом необходимо в свойствах виртуальной машины добавить новый SCSI Controller.

Если посмотреть подсказку у LSI Logic SAS контроллера, то вы увидите три его режима:

- None — для работы с не кластерными Multi-Writer дисками

- Physical — виртуальные диски могут быть общими для виртуальной машины и физическим сервером

- Virtual — для работы с общим диском для нескольких виртуальных машин

Хочу отметить, что к одному LSI Logic SAS контроллеру можно одновременно подключить до 16 виртуальных дисков

Делается это через пункт «New Device» и нажатии кнопки Add, для SCSI Controller.

Далее у нового, добавленного контроллера вы в пункте «SCSI Bus Sharing» выберите тип «Virtual». Можете сохранить конфигурацию виртуальной машины, через нажатие кнопки «Ок»

Далее на первой машине, где мы только что добавили новый контроллер, вам нужно создать новый виртуальный диск, делается это так же, через пункт «New Device»

Откройте параметры нового виртуального диска. Для того, чтобы сделать его общим между виртуальными машинами VMware ESXI, вам необходимо выставить соответствующие настройки:

Далее я для своего удобства, хочу чтобы общие диски лежали в отдельной папке, а так как они по умолчанию создаются в папке с виртуальной машиной да и еще имеют имя дисков, как имя машины_цифра, я бы такое хотел поправить. Для этого я в конфигурации виртуальной машины удаляю все созданные диски, но я не ставлю галку «Delete files from datastore», то есть по сути на датасторе они остаются.

Данное действие не обязательное, вы его можете пропустить и просто сохранить настройки, после чего переходить к настройке второй виртуалки, об этом чуть ниже

Далее я иду на датастор на котором находится виртуальная машина с общими дисками (Datastore — Browse Files).

Нахожу нужные мне Multi-Writer диски. Создаю новую папку

И перемещаю в новую папку общие диски, хочу отметить, что вы их можете переместить на любой общий между хостами ESXI датастор.

Я делаю «Move to» на тот же латасторе, но в новую папку. Этим я добьюсь, что буду видеть явным образом общие кластерные диски.

Так как я диски до этого удалил, для удобства, то мне их нужно заново добавить. Если вы до этого не удаляли, то сделайте эти действия только для второй виртуальной машины. Открываем настройки виртуальной машины и нажимаем добавить новое устройство, выбираем пункт «Existing Hard Disk», это у нас выбор существующего общего кластерного диска.

Указываем на каком датасторе у нас лежит Multi-Writer диск и выбираем нужный VMDK, в моем случае их семь.

Выставляем нужные параметры:

- Disk Provisioning — «Thick provision Eager zeroed thick disks»

- Sharing — «Multi-Writer»

- Disk Mode — «Independent Persistent»

- Virtual Device Node — выберите наш новый LSI Logic SAS контроллер, работающий в режиме «SCSI Bus Sharing Virtual»

Если такой диск не один, то добавляем все за один раз для экономии времени. Проделываем такое добавление общих дисков на всех виртуальных машинах, где планируется использовать Multi-Writer.

Далее уже в операционной системе Windows Server, зайдя в оснастку «Управление дисками» вы обнаружите ваши диски. Остается их только разметить в GPT формат и отдать под кластер.

Как работает «Shared-Nothing» vMotion (Enhanced vMotion) в VMware vSphere 5.1.

Как знают многие пользователи, среди новых возможностей VMware vSphere 5.1 есть так называемая Enhanced vMotion или «Shared-Nothing» vMotion — функция, позволяющая переместить работающую виртуальную машину на локальном хранилище ESXi на другой хост и хранилище с помощью комбинации техник vMoton и Storage vMotion в одной операции. Это означает, что для такого типа горячей миграции не требуется общее хранилище (Shared Storage), а значит и затрат на его приобретение. Напомним также, что функция Enhanced vMotion включена во все коммерческие издания VMware vSphere, кроме vSphere Essentials.

Давайте посмотрим поближе, как это все работает:

Как включить VMotion В vmware Sphere 5.x и мигрировать vm-07

Сначала приведем требования и особенности работы vMotion при отсутствии общего хранилища:

- Хосты ESXi должны находиться под управлением одного сервера vCenter.

- Хосты должны находиться в одном контейнере Datacenter.

- Хосты должны быть в одной Layer 2 подсети (и, если используется распределенный коммутатор, на одном VDS).Enhanced vMotion — это исключительно ручной процесс, то есть функции DRS и Storage DRS не будут использовать миграцию машин без общего хранилища. Это же касается и режима обслуживания хоста (Maintenance Mode).

- Для одного хоста ESXi может быть проведено не более 2-х Enhanced vMotion единовременно. Таким образом, на хост ESXi может одновременно приходиться максимум 2 штуки Enhanced vMotion и 6 обычных vMotion (всего 8 миграций на хост) + 2 операции Storage vMotion, либо 2 Enhanced vMotion (так как это также задействует Storage vMotion).

- Enhanced vMotion может проводить горячую миграцию одновременно по нескольким сетевым адаптерам хоста ESXi, если они имеются и настроены корректно.

Миграция Enhanced vMotion может быть проведена только через тонкий клиент vSphere Web Client (в обычном клиенте эта функция недоступна — см. комментарии):

Как включить VMotion В vmware Sphere 5.x и мигрировать vm-08

Миграция Enhanced vMotion идет по обычной сети vMotion (а не по Storage Network), по ней передаются и диск ВМ, и ее память с регистрами процессора для обеспечения непрерывной работоспособности виртуальной машины во время миграции:

Как включить VMotion В vmware Sphere 5.x и мигрировать vm-09

Теперь как это все работает последовательно. Сначала механизм Enhanced vMotion вызывает подсистему Storage vMotion, которая производит копирование данных по сети vMotion. Здесь важны 2 ключевых компонента — bulk copy и mirror mode driver.

Как включить VMotion В vmware Sphere 5.x и мигрировать vm-10

Сначала механизм bulk copy начинает копирование блоков данных с максимально возможной скоростью. Во время этого часть блоков на исходном хранилище хоста может измениться — тут и вступает в дело mirror mode driver, который начинает поддерживать данные блоки на исходном и целевом хранилище в синхронном состоянии.

Mirror mode driver во время своей работы игнорирует те блоки исходного хранилища, которые меняются, но еще не были скопированы на целевое хранилище. Чтобы поддерживать максимальную скорость копирования, Mirror mode driver использует специальный буфер, чтобы не использовать отложенную запись блоков.

Как включить VMotion В vmware Sphere 5.x и мигрировать vm-11

Когда диски на исходном и целевом хранилище и их изменяющиеся блоки приходят в синхронное состояние, начинается передача данных оперативной памяти и регистров процессора (операция vMotion). Это делается после Storage vMotion, так как страницы памяти меняются с более высокой интенсивностью. После проведения vMotion идет операция мгновенного переключения на целевой хост и хранилище (Switch over). Это делается традиционным способом — когда различия в памяти и регистрах процессора весьма малы, виртуальная машина на мгновение подмораживается, различия до передаются на целевой хост (плюс переброс сетевых соединений), машина размораживается на целевом хосте и продолжает исполнять операции и использовать хранилище с виртуальным диском уже целевого хоста.

Ну а если вы перемещаете виртуальную машину не между локальными дисками хост-серверов, а между общими хранилищами, к которым имеют доступ оба хоста, то миграция дисков ВМ идет уже по Storage Network, как и в случае с обычным Storage vMotion, чтобы ускорить процесс и не создавать нагрузку на процессоры хостов и сеть vMotion. В этом случае (если возможно) будет использоваться и механизм VAAI для передачи нагрузки по копированию блоков на сторону дискового массива.

Как включить VMotion В vmware Sphere 5.x и мигрировать vm-12

Как включить Vmotion в vCenter 7

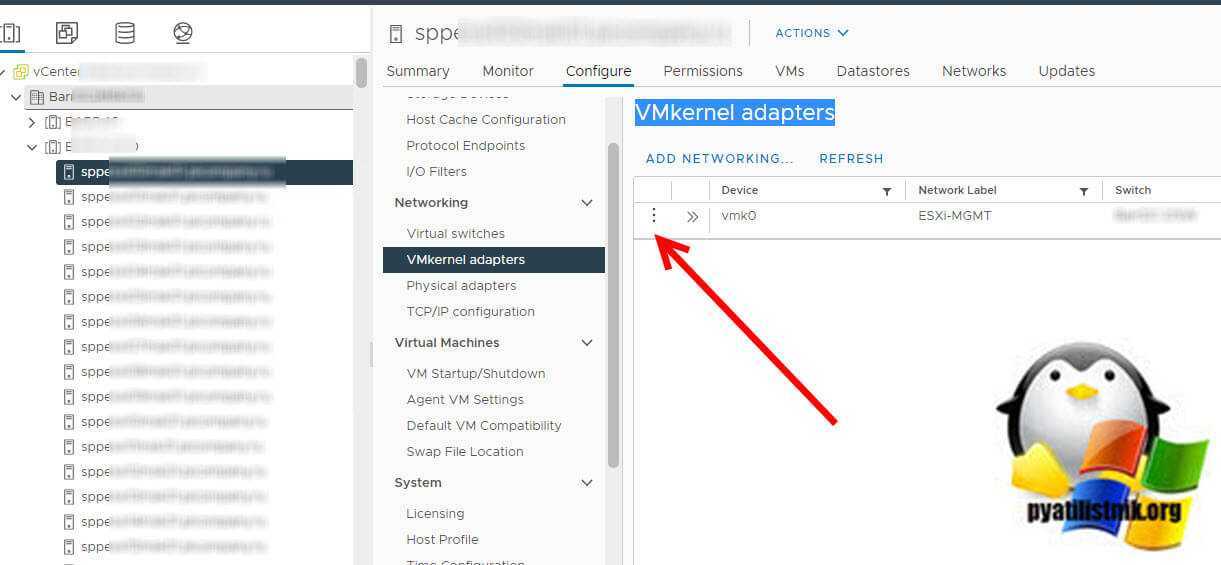

Давайте покажу как активируется vMotion на хостах ESXI 7 через vCenter 7. Откройте HTML клиента и выберите нужный вам хост, перейдите на вкладку «Configure — Networking — VMkernel adapters». У вас тут будет список интерфейсов VMkernel. Слева вы можете увидеть совершенно непримечательную кнопку в виде трех вертикальных точек, нажмите ее.

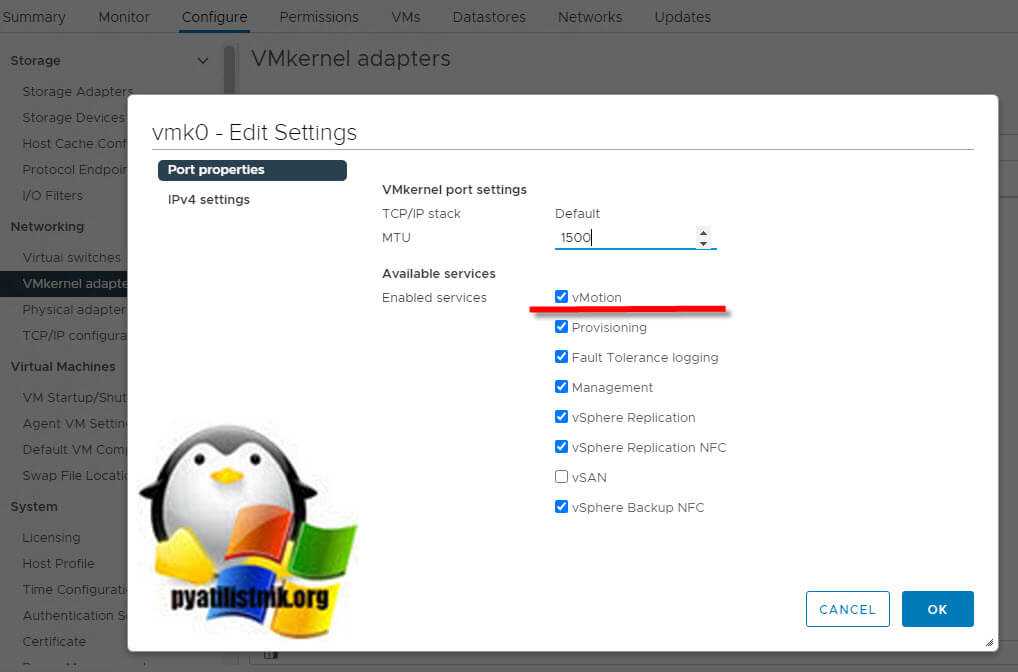

Далее вам остается просто активировать на данном VMkernel нужную галку «vMotion». Так, что если вы до этого не знали, где активируется vMotion в vCenter 7, то вам придется попотеть в поисках данной кнопки.

1. Открытие виртуальных машин в VMware Workstation

Если работа с виртуальными машинами будет производиться и далее в среде VMware Workstation, нет в принципе нужды экспортировать машины. После переустановки хост-системы Windows нужно установить гипервизор и в меню «Файл» выбрать «Сканирование виртуальных машин».

Далее указываем каталог расположения машин, тот, что был до переустановки хостовой Windows.

И добавляем все обнаруженные машины в библиотеку VMware Workstation. Если нужны не все, то, соответственно, снимаем галочки с ненужных.

Далее открываем программную библиотеку и можем работать с добавленными в интерфейс машинами.

По этому же принципу можем поступить и при переходе на другой компьютер. Мы физически переносим каталог хранения виртуальных машин VMware на диск другого компьютера. И в установленной на том другом компьютере программе VMware Workstation добавляем перенесённые виртуальные машины. При добавлении новых готовых машин программа во время их первого запуска обычно выдаёт запрос: мол, обнаружено, что это перенесённая или скопированная машина. Но программе необходимо точно указать, машина перенесена или скопирована. Это нужно для настройки сети и других функций. И вот в ответ на такой запрос нажимаем кнопку «I Moved It», т.е. указываем, что машина перенесённая.

Перенос непосредственно каталога виртуальных машин на другой компьютер – как видим, способ чрезвычайно простой, но он хорош для случаев, когда мы не стеснены средствами переноса данных. К примеру, у нас есть нужного объёма USB-HDD, либо же мы можем перенести каталог с виртуальными машинами в онлайне с использованием торрент-технологии. Но если у нас нет USB-HDD, а каталог с машинами нужно какое-то время где-то передержать, прежде чем он может быть помещён на целевой компьютер, машины лучше экспортировать. Экспортировать с целью сжатия данных. К примеру, в нашем случае папка одной виртуальной машины с фиксированным виртуальным диском весит 50 Гб.

А вес файлов экспортированной машины будет составлять даже менее 5 Гб.

Ограничения на одновременные миграции

vCenter Server устанавливает ограничения на количество одновременных операций миграции и подготовки виртуальных машин, которые могут выполняться на каждом узле, сети и хранилище данных. Каждой операции, такой как миграция с помощью vMotion или клонирование виртуальной машины, назначается стоимость ресурсов. Каждый хост, хранилище данных или сетевой ресурс имеет максимальную стоимость, которую он может поддерживать в любой момент. Любая новая операция миграции или подготовки, которая приводит к превышению максимальной стоимости ресурса, не выполняется немедленно, а ставится в очередь до тех пор, пока другие операции не завершатся и не освободят ресурсы. Для продолжения операции должны быть соблюдены все ограничения для сети, хранилища данных и хоста.

Доступ к VMFS разделу из Ubuntu

В этой секции мы покажем, как смонтировать раздел с файловой системой VMFS на компьютере с установленной ОС Ubuntu (Live CD с Ubuntu в этом сценарии нам не подойдет, скачать серверные ubuntu с 10 по 14 версии и выше).

В первую очередь необходимо подключить физический диск с VMFS к компьютеру с Ubuntu.

Чтобы получить доступ к данным на VMFS томе, нам понадобиться установить специальный пакет vmfs-tools. Данный пакет позволяет получить доступ к файловой системе раздела VMFS с не ESX/ESXi хостов. Доступ возможен в режиме только на чтение (read-only).

Установим пакет следующей командой

apt-get install vmfs-tools

Примечание. В репозитариях Ubuntu пока доступна только версия vmfs-tools 0.2.1, основной ее недостаток – она умеет работать только с файловой системой VMFS v4. Если вам нужно смонтировать датастор с VMFS 5, придется самостоятельно скачать и установить версию vmfs-tools не ниже 0.2.5, например, здесь: http://ge.archive.ubuntu.com/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_i386.deb – пакет для 32 битной системы http://de.archive.ubuntu.com/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_amd64.deb – пакет для 64 битной системы

Качаем соответствующую версию пакета так:#wget http://de.archive.ubuntu.com/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_amd64.deb

И устанавливаем его:#dpkg -i vmfs-tools_0.2.5-1_amd64.deb

Если нужно будет удовлетворить зависимости, воспользуемся командой:#apt-get install vmfs-tools

После установки пакета, создадим каталог для точки монтирования:#mkdir /mnt/vmfs

Следующий шаг – нужно разобраться с разделами на дисках. Гипервизор ESXi при установке помимо, собственно, раздела для файлов виртуальных машин (VMFS) создает множество служебных разделов. Если версия ESXi 4 или ниже, или VMFS хранилище было обновлено с версии VMFS 4 до VMFS 5, а его размер не превышает 2 Тб, выведем список дисков и разделов так:#fdisk -l

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Как мы видим, раздел с файловой системой VMFS – /dev/sd3 (метка VMware VMFS) Важно. Т.к

в ESXi 5 используется VMFS v5 с таблицей разделов GPT (таблица GUID Partition Table используется вместо MBR, что позволяет создавать хранилища большего размера и пробрасывать RDM диски в режиме физической совместимости размером более 2 TB). Поэтому для просмотра таблицы разделов придется вместо fdisk использовать команду parted. Итак, выведем информацию о разделах так:#parted -l

Осталось смонтировать партицию с хранилищем VMFS:#vmfs-fuse /dev/sdb3 /mnt/vmfs

Выведем содержимое смонтированного раздела:#ls -all /mnt/vmfs

Итак, теперь мы видим все файлы виртуальных машин на VMFS хранилище, которое доступно нам для чтения, а это значит, что мы можем скопировать каталоги и/или отдельные файлы нужных виртуальных машин на отдельный диск и запустить их на другом гипервизоре ESXi. Доступ к VMFS разделу из Windows

Для доступа к данным на VMFS разделе из Windows, нам понадобится специальный открытый драйвер Open Source VMFS Driver, написанный на Java. Драйвер требует версию Java не ниже 6 и также позволяет монтировть VMFS-тома только для чтения Итак, качаем Open Source VMFS Driver по этой ссылке https://code.google.com/p/vmfs/ и распаковываем его в произвольный каталог (допустим C:\vmfs) Проверить работу java-приложения fvmfs.jar можно так:cd \vmfsjava -jar fvmfs.jar Определяем номер диска с хранилищем VMFS, подключенный к нашему Windows-компьютеру. Номер диска можно узнать с помощью консоли управление дисками или diskpart. (В нашем примере подключенный диск имеет индекс 1 – Disk1. Для драйвера утилиты fvmfs, этот диск будет именоваться так: \\.\PhysicalDrive1)

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Попытаемся получить информацию о диске: java -jar fvmfs.jar \\.\PhysicalDrive1 info

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Предоставим общий доступ к данному диску с помощью webdav: java -jar fvmfs.jar \\.\PhysicalDrive1 webdav

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Подключим расшаренный диск: net use * http://localhost:50080/vmfs

В системе должен появиться новый диск, с содержимым датастора VMFS, доступный для чтения.

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Вот так вот просто получить доступ к данным на VMFS разделе из-под Windows / Linux. До новых встреч. С вами был Иван Семин, автор и создатель IT портала Pyatilistnik.org

Мониторинг оборудования (В том числе SNMP)

Модель CIM — это открытый стандарт, определяющий характеристики платформы мониторинга аппаратных ресурсов узлов vSphere, на которых развертывается архитектура ESXi. Особенностями такой платформы являются отсутствие агентов и использование стандартов в качестве основы. В состав этой платформы входит диспетчер объектов CIM, который также называют брокером CIM, и набор подключаемых модулей — поставщиков CIM.

Доступ для управления драйверами устройств и соответствующим оборудованием реализован с помощью поставщиков услуг управления облачной инфраструктурой (CIM). Поставщики оборудования, в том числе производители серверов и специализированных устройств, могут регистрировать таких поставщиков для мониторинга и администрирования собственных устройств.

Это относится и к компании VMware, которая разрабатывает модули для мониторинга инфраструктуры серверного аппаратного хранилища и ресурсов, используемых для виртуализации. Эти модули работают на узле vSphere, поэтому они занимают очень мало места и применяются для выполнения конкретных задач в области управления. Брокер CIM собирает данные всех поставщиков CIM и выводит их во внешнюю инфраструктуру с использованием стандартных API-интерфейсов, таких как WS-MAN и CIM-XML. Любое программное средство, которое поддерживает один из этих API-интерфейсов, например HP SIM или Dell OpenManage, может считывать эту информацию и, соответственно, выполнять мониторинг оборудования узла vSphere.

Одной из точек обработки данных CIM является сервер VMware vCenter. В клиенте или веб-клиенте vSphere можно в любой момент просмотреть состояние оборудования любого узла vSphere в среде. Таким образом формируется единое представление показателей работоспособности физических и виртуальных компонентов системы. Можно также настроить сервер vCenter для отправки оповещений, чтобы своевременно узнавать о таких событиях в физической инфраструктуре, как изменение температуры или отключение электричества, а также о серьезных отклонениях от заданных параметров.

Кроме того, решение vSphere использует стандарт SNMP для передачи данных о состоянии оборудования другим средствам управления, которые применяют этот же стандарт. Доступ к ловушкам SNMP возможен как с узла vSphere, так и с сервера vCenter.

Каковы варианты использования Storage vMotion?

- Миграция со старого хранилища на новые системы хранения или миграция на хранилище другого поставщика без простоев на виртуальные машины.

- Выполнение запланированных действий, таких как обновление хранилища на исходном Lun.

- Преобразование типа диска виртуальной машины из толстого в тонкий и из тонкого в толстый.

- Перенос критически важных виртуальных машин в высокопроизводительные массивы хранения для повышения производительности виртуальной машины.

- Миграция рабочей нагрузки между различными физическими LUN

- Балансировка нагрузки IOPS (с кластерами sDRS Datastore)

- svMotion не зависит от хранилища, что означает, что он может работать со всем, что может предоставить хранилище данных VMware. (iSCSI, FCoE, vSAN, NFS, NAS и т. д.)

Отказоустойчивость

Что будет, если упадёт кластер KMS

Очевидно, что ничего хорошего. В окне конфигурации Key Management Servers в vCenter будет такая картина.

Падение KMS не повлияет на уже запущенные VM, которые продолжать работать (и их можно будет выключать, включать, мигрировать на другие хосты) до тех пор, пока в ОЗУ ESXi хранятся KEK, ранее полученные у KMS. KEK будут храниться в памяти до перезагрузки ESXi хоста.

При попытке включить VM Encryption при неработающем KMS пойдут ошибки генерации ключа.

Что произойдёт при перезагрузке ESXi хоста

Хост будет требовать включить шифрование вручную

VM, будучи зарегистрированной на хосте, который не хранит в ОЗУ KEK для этой VM (например, если ESXi хост был перезагружен или был добавлен в кластер после первичной инициализации шифрования), будет требовать разблокировать её, передав KEK на ESXi хост.

Что мы будем делать

Мы подготовим максимально гибкий шаблон без привязки к адресу подсети, доменному имени, количеству выделяемых ресурсов и т.п. Будем делать так, чтобы при развертывании шаблона администратор мог произвести тонкую настройку. Подготовка шаблона выполняется в сети 10.0.0.0/24, а за стандартные значения при развертывании готового шаблона примем домен Domain.local и сеть 192.168.2.0/24.

Имя домена domain.local и сеть 192.168.2.0/24 выберем как значения по умолчанию, которые можно изменять в процессе развёртывания шаблона.

Мы подготовим шаблон, включающий в себя 6 виртуальных машин.

1.1. Список VM в шаблоне

-

VMware ESXi – 1 Гипервизор;

-

VMware ESXi – 2 Гипервизор;

-

VMware ESXi – 3 Гипервизор;

-

VMware vCenter Server Appliance with Embedded Platform Services Controller в конфигурации Tiny;

-

Ubuntu 18.04 LTS в качестве общего NFS хранилища;

-

Windows Server 2019 в качестве DNS сервера и Management machine. В последствии, с нее будет производится управления vCenter.

1.2. Требования

-

VDC в VMware Cloud Director:

a. 28 vCPU;

b. 50GB RAM;

c. 2TB Storage.

-

Дистрибутивы ПО:

a. ISO с дистрибутивом VMware ESXi 6.7U3b;

b. ISO (или OVA) с дистрибутивом VMware vCenter Server Appliance 6.7U3b;

c. ISO (или OVA) с Windows Server 2019;

d. ISO (или OVA) с Ubuntu1804.

-

Дополнительное ПО (опционально):

a. Браузер Google Chrome;

b. Текстовый редактор Notepad++;

c. SFTP клиент WinSCP.

d. 7-Zip

-

Убедитесь, что в нашей локальной сети на уровне vCenter облачного провайдера переключены в состоянии Accept политики Promiscuous mode и Forged transmits. Иначе не будет связи между сетью виртуального дата-центра и сетью внутри подготавливаемого шаблона. .

Дистрибутивы продуктов VMware можно скачать с официального сайта, зарегистрировавшись в программе обучения и получив VMware Evaluation License на 60 дней.

Возможностей VMware Cloud Director для подготовки данного шаблона будет недостаточно, поэтому сначала развернём нашу рабочую среду «Working Environment» в виртуальном дата-центре VMware Cloud Director.

В рабочую среду мы установим ESXi гипервизор, vCenter Server Appliance и Windows Server 2019 в качестве ManagementVM. Подготовку шаблона будем выполнять, используя интерфейс vSphere Client в рабочей среде.