Введение

В некоторых случаях иногда бывает необходимо физические машины объединить в одну сетевую инфраструктуру с виртуальными машинами. При этом обеспечить изолированность каждого адресного пространства друг от друга, но предоставить доступ к общим виртуальным машинам с любого устройства внутри инфраструктуры.

Приведу первоначальную топологию.

Что имеем:

- Коммутатор D-Link. К нему подключены физические машины и сервер с VMWare ESXI. Сам коммутатор подключен к вышестоящему оборудованию организации.

- Некоторый парк физических машин.

- Набор виртуальных машин.

- Одна виртуальная машины, на которой установлен Windows Server и AD.

Ограничения общих дисков VMware ESXI

Без некоторых нюансов все же не обошлось, хочу выделить некоторые ограничения при использовании общих дисков:

Самое главное, что у вас пропадет возможность производить миграцию виртуальной машины, обычный vMotion и Storage vMotion (Подробнее https://kb.vmware.com/s/article/1003797)

Например, при попытке сделать Storage vMotion вы получите ошибку:

Virtual machine is configured to use a device that prevents the operation: Device ‘SCSI controller 1’ is a SCSI controller engaged in bus-sharing

Если нужно будет мигрировать, то придется выключать виртуалку.

Вы не сможете на живую произвести расширение дисков, при попытке вы получите вот такую ошибку:

The disk extend operation failed: The virtual disk requires a feature not supported by this program. Hot-extend is currently supported only for VMFS flat virtual disks without snapshots opened in persistent mode.

Если вы вдруг разметите оба диска в NTFS на двух хостах и попытаетесь на них писать, создав на одном одну папку, а на втором вторую, то хосты эти папки не увидят, каждый свою, учтите, это вам не общий диск с синхронизацией файлов, Multi-Writer VMDK именно нужен для кластеризации.

Настройка системы

Для того чтобы запустить и настроить устройство, вам понадобится подключить монитор, мышку и клавиатуру.

Сразу после первого включения нам предлагают установить язык и регион и ввести ключ продукта, который написан на верхней части корпуса. После этого нас заставляют придумать пароль Администратора с использованием цифр и букв разного регистра.

Далее нам предлагают воспользоваться программой для упрощения начала работы. В ней вы по пунктам сможете пройти ряд основных системных настроек. В целом это достаточно упрощенный вариант, и если вы хотите настроить систему более гибко и не сильно разбираетесь в такого рода системах, то без опытного администратора вы вряд ли сможете это сделать. Вы не найдёте никаких туториалов в коробке или ещё каких-то вспомогательных программ для понятия системы. Так что сразу приготовьтесь скачивать много литературы или читать большое количество статей и обучений, если же сами хотите работать с этой системой.

Реализация

Первоначально начнем с того, что на коммутаторе порты к которым подключены физические машины поместим в собственные VLAN, которых нет в инфраструктуре организации. В итоге получается что в каждом VLAN оказывается по две физические машины. Далее все созданные VLAN помешаем на сервер где установлен VMWare.

На виртуальном switch VMWare получаем следующую структуру:

Для того, чтобы организовать маршрутизацию и разделение на подсети используем Mikrotik CHR. На сервере VMWare разнесем созданные VLAN между виртуальными машинами и Mikrotik. В итоге получаем следующим вид для каждого VLAN:

Новая топологию с Mikrotik CHR выглядит следующим образом:

На виртуальный маршрутизатор в итоге приходят следующие интерфейсы:

- Интерфейс для доступа к внутренней сети организации

- Интерфейс с реальным IP адресов

- Интерфейс каждого созданного VLAN

Перенос операционной системы в гипервизор ESXi при помощи Remote Windows machine

Тут процедура точно такая же, только вместо Powered on выбираем Powered off и Remote Windows machine, а поскольку это машина удалённая, то нам нужно будет

дополнительно прописать доступы к ней (ip адрес, имя пользователя и пароль). После того как соединение с машиной-источником установим нам будет предложено выбрать в диалоговом окне каким образом

мы удалим с конвертируемой машины агента Standalone. Автоматически после переноса или самостоятельно своими ручками чуть позже.

Дальше процесс никак не отличается от клонирования . Не вижу смысла повторять одно и тоже по нескольку раз.

Действия на стороне хоста

При использовании протокола iSCSI необходимо выполнить:

один раз добавить Software iSCSI адаптер, если этого не было сделано ранее: Хост → Configure → Storage adapters → Add Software Adapter.

Создать отдельные vKernel для работы с iSCSI (минимум два – для связи с каждым контроллером СХД). Можно подключить их на существующий vSwitch, но желательно подключить на отдельный, не имеющий Port Group с виртуальными машинами с целью упрощения администрирования. У данного vSwitch должно быть минимум 2 физических линка для отказоустойчивости. vKernel следует назначить IP адреса из разных подсетей, чтобы хост мог однозначно маршрутизировать трафик

Также очень важно для каждого vKernel изменить параметр Failover таким образом, чтобы он использовал только один физический линк, т.к. VMware не поддерживает Teaming для iSCSI

В итоге должно получиться следующее:

| VMkernel Adapter (vmk#) | Physical Network Adapter (vmnic#) |

|---|---|

| iSCSI-1 (СХД Контроллер 1) | Active Adapters vmnic1 Unused Adapters vmnic3 |

| iSCSI-2 (СХД Контроллер 2) | Active Adapters vmnic3 Unused Adapters vmnic1 |

Установки Failover меняются через изменение настроек Port Group

При использовании протокола Fibre Channel все гораздо проще: достаточно выполнить Rescan для обнаружения нового тома. В нашем примере это том с LUN ID = 1, доступный по 4 путям (по 2 на каждом порту HBA).

Следующим шагом будет создание Datastore на новом томе: Хост → Actions → Storage → New Datastore.

По умолчанию VMware использует политику работы с многопутевыми устройствами как Most Recently User (MRU). Для большей эффективности и повышения производительности необходимо для каждого Datastore изменить политику на Round Robin, при которой все доступные пути до СХД будут использоваться равномерно. Политика меняется в меню Хост → Storage Devices → Наше Устройство → Properties → Edit Multi-Path. После применения политики Round Robin все пути будут использоваться для ввода/вывода (Active I/O).

В случае использования кластера из нескольких хостов ESXi действия, описанные выше, необходимо повторить на каждом из хостов кроме создания нового Datastore. Т.к. Datastore уже был создан ранее, он появится у остальных членов кластера после выполнения команды Rescan.

Vmware Workstation

С Vmware Workstation немного по другому. Официально считается, что данная функция доступна только для vSphere. Но это немного не так. Просто не все доступно через графический интерфейс. Придется вносить руками небольшие правки в конфигурационные файлы виртуальных машин.

- Выключаем обе виртуальные машины.

- Добавляем в конфигурацию первой виртуальной машины новый жесткий диск с указанными параметрами. Физически распологаем этот жесткий диск НЕ в папке, в которой расположена виртуальная машина.При добавлении диска не забываем проследить, что бы расширение файла было .vmdk

- Далее закрываем Vmware Workstation и отредактируем файл конфигурации первой виртуальной машины (.VMX):Добавляем строки для создания второго канала SCSIscsi1.present = “TRUE”scsi1.virtualDev = “lsilogic”Изминяем дополнительный жесткий диск, который будет подключен к новому каналу:scsi1:1.present = “TRUE”scsi1:1.fileName = “C:\VMs\Share_disk\share.vmdk”scsi1:1.mode = “independent-persistent”Отключаем блокировку и кэширование дискаdisk.locking = “false”diskLib.dataCacheMaxSize = “0”

- Добавляем новый диск к второй виртуальной машине. При добавлении выбираем опцию «подключить существующий диск» и указываем диск, созданный на предыдущем этапе.

- Задаем параметры диска такие же, как и на первом этапе.

- Вносим те же изменения в файл конфигурации (.VMX) второй виртуальной машины.

- Включаем первую виртуальную машину.

- Создаем на новом диске файловую систему и подключаем диск способом, доступном ОС этой виртуальной машине.

- Включаем вторую виртуальную машину и подключаем (монтируем) диск аналогично первой ВМ.

Для чего пробрасывают в vmware usb

Ну в vmware usb устройства, пробрасывают в конкретные виртуальные машины, для сервисов которые используют аппаратные ключи для своей работы или те же самые модемы, для службы оповещения например. Данный режим прокидывания называется Host-Connected USB Passthrough, ниже я хочу определиться с требованиями, которые должны быть выполнены.

Требования для проброса

- Первое правило весьма логичное, что одно usb устройство, может быть добавлено, только в одну виртуальную машину. У данной машины может быть не более 20 юсби устройств, этого и так за глаза.

- Версия Virtual Hardware должна быть не ниже 8

- На хосте должен быть USB-контроллер. USB arbitrator хоста ESXi может управлять 15-ю контроллерами

- С данными виртуальными машинами, можно проводить процедуру миграции (vMotion), но usb с ней не переедет, это нужно учитывать.

- Перед, добавлением юсби устройства, нужно добавить USB-контроллер в устройства виртуалки

- Перед отключением проброшенного в ВМ ЮСБИ-устройства рекомендуется отключать проброс контроллера в Virtual Machine

- Если у вас используется горячее добавление памяти и CPU, то перед добавлением выключите USB-устройства от ВМ, иначе при увеличении ресурсов usb отвалятся, что может привести к потере данных

- Виртуальная машина не может загружаться с проброшенного устройства USB

Официально Vmware поддерживает вот такие устройства, но это не означает, что если вашего в списке нет, то работать не будет.

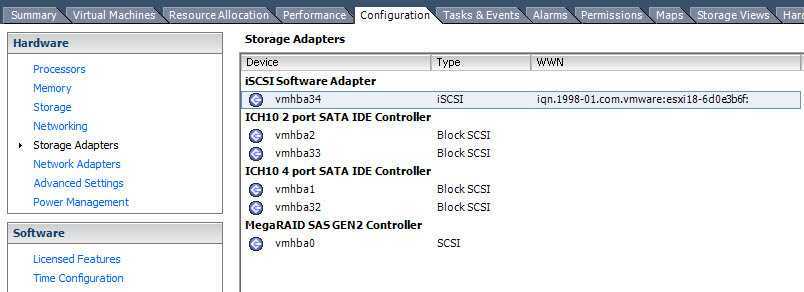

Как узнать IQN в VMware ESXI 5.5

Подключаемся к вашему vCenter и выбираем нужный ESXI хост. Переходим в Configuration-Storage Adapters. Выбираем ваш ISCSI Software Adapter, если его нет то его нужно добавить.

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-09

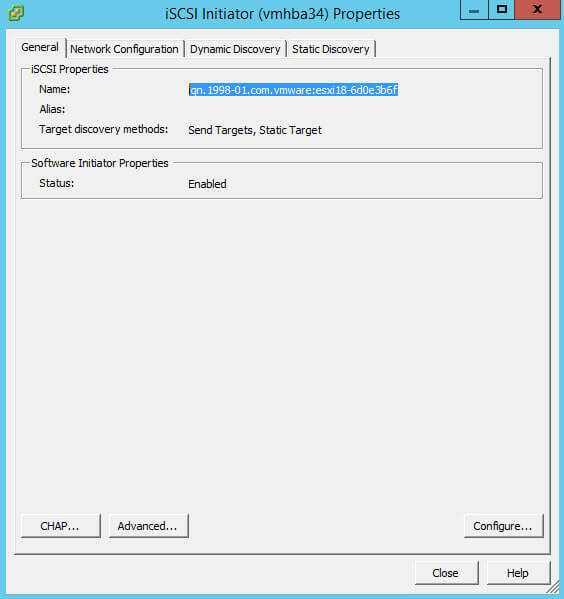

Правым кликом по нему и выбираем Properties.

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-10

и на вкладке General видим Name iqn.1998-01.com.vmware:чего то там. Всю эту запись и нужно скопировать.

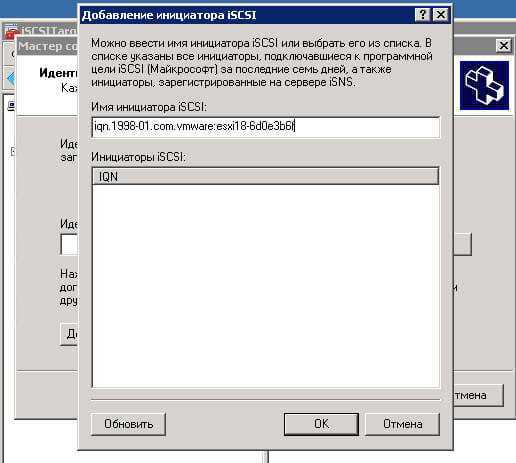

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-11

Добавляем эту строку в инициатор ISCSI.

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-12

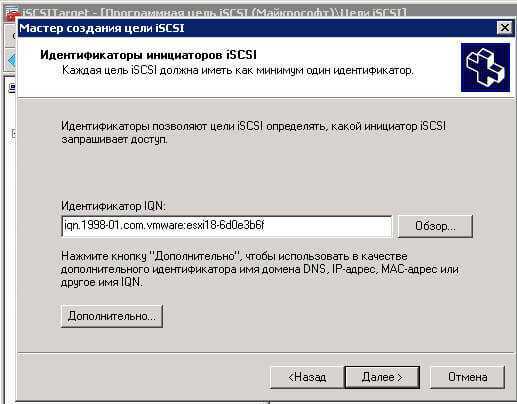

Далее.

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-13

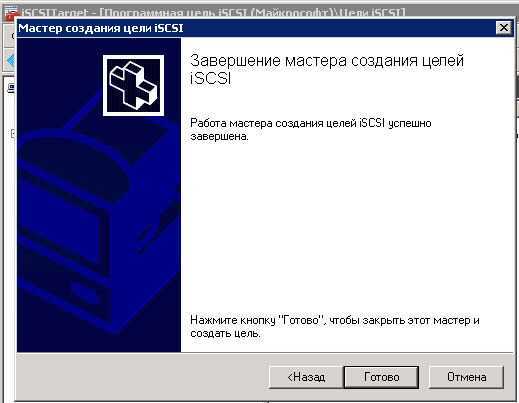

Готово.

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-14

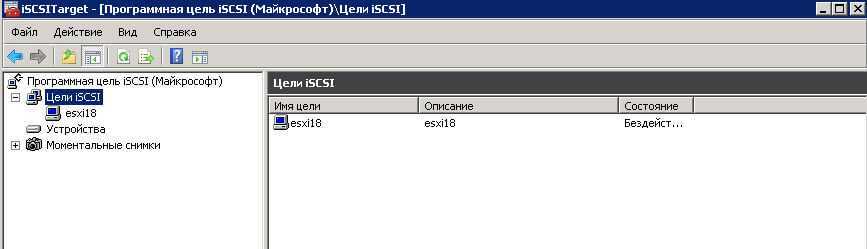

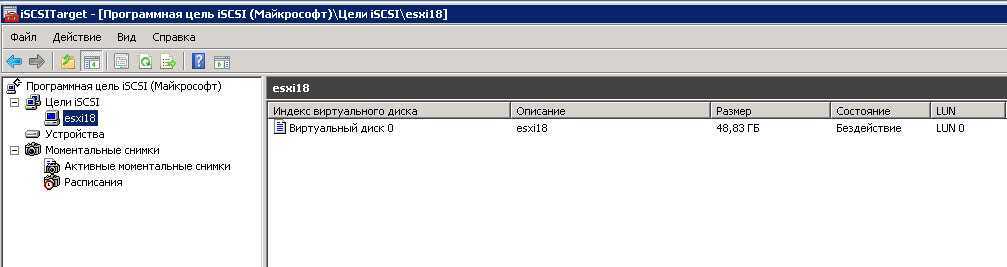

Видим цель iscsi создана.

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-15

Щелкаем по esxi18 правым кликом и выбираем, Добавить существующий виртуальный диск к цели iSCSI.

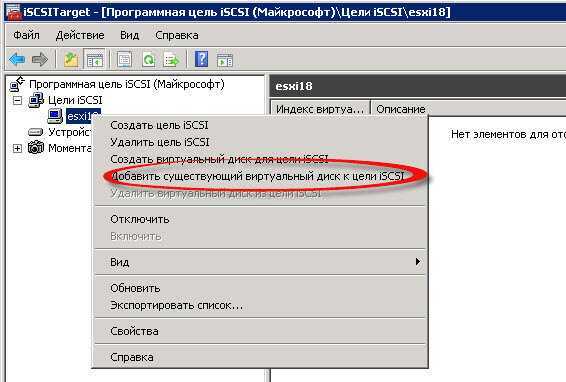

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-16

Выбираем диск и жмем ок

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-17

Всем видим диск добавился.

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-19

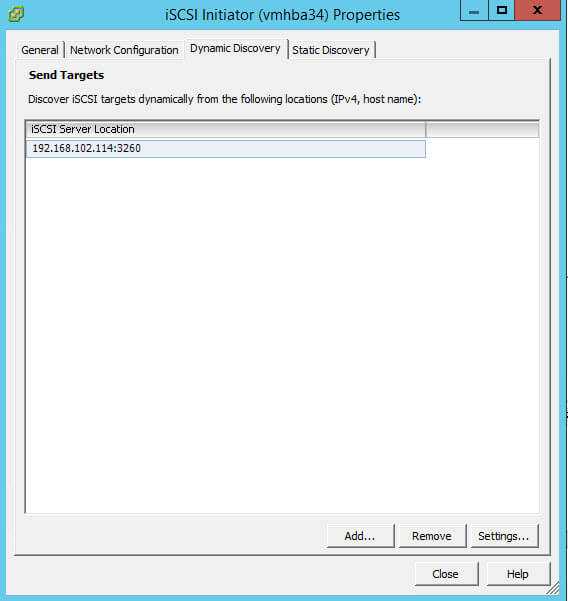

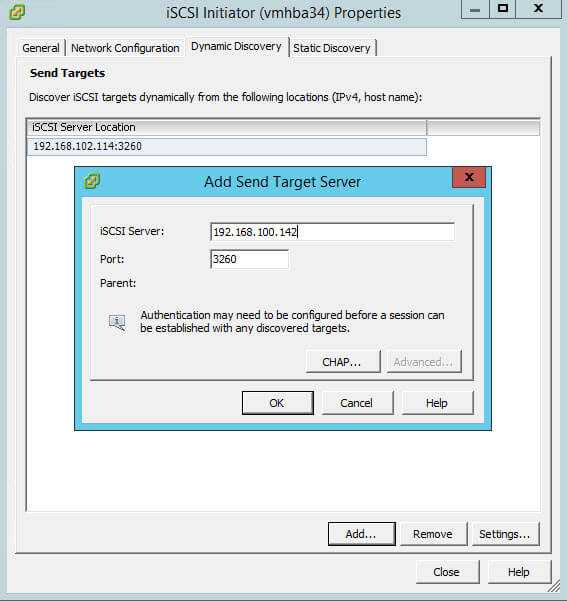

Снова идем в Configuration-Storage Adapters. Выбираем ваш ISCSI Software Adapter и переходим в его свойства. Переходим на вкладку Dinamic Discovery и жмем Add

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-30

задаем ip адрес вашего сервера iscsi и iscsi порт у меня это стандартный 3260.

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-31

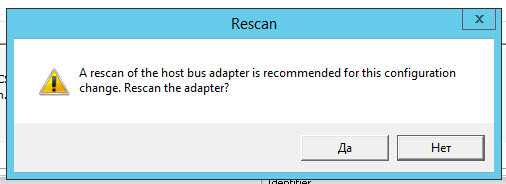

На вопрос сделать ли rescan адаптера жмем да

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-32

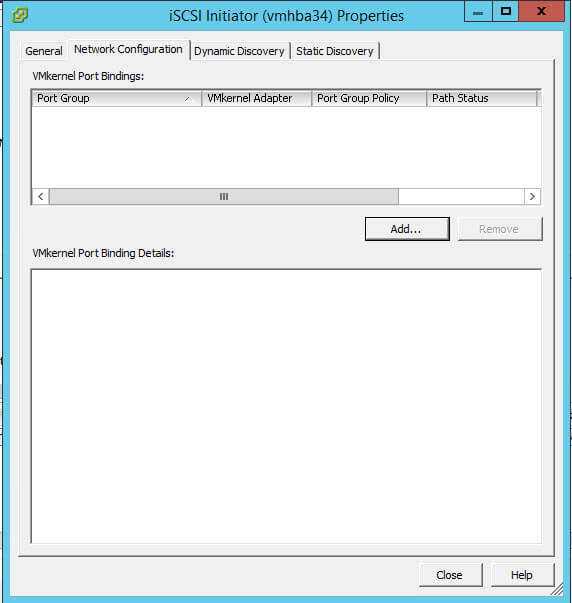

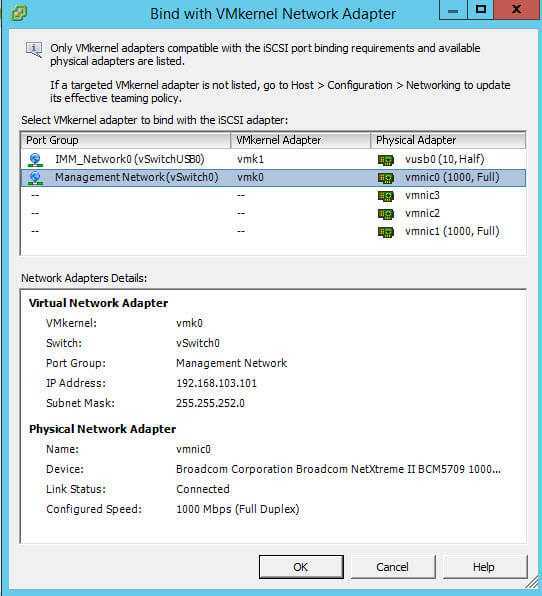

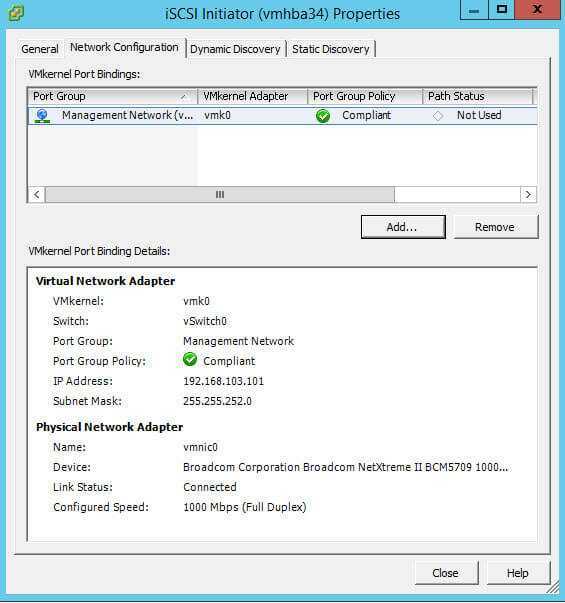

При желании если у вас отдельный виртуальный свитч со своим физическим адаптером, специально под iscsi трафик, то можно указать его в качестве устройства через которое все это дело пойдет. (Когда создаете vSphere Standard Switch в vCenter 5.5, не забудьте сделать MTU 9000 при условии что железки поддерживают, так вы получите максимум производительности). Идем на вкладку Network Configuration и жмем Add.

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-33

Выбираем нужный VMkernel adapter

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-34

добавили

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-35

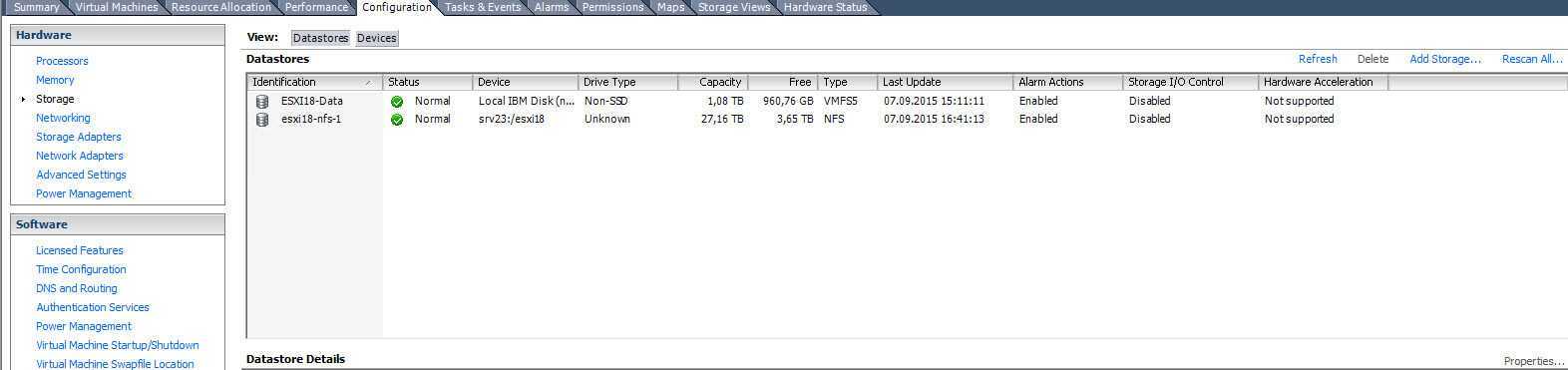

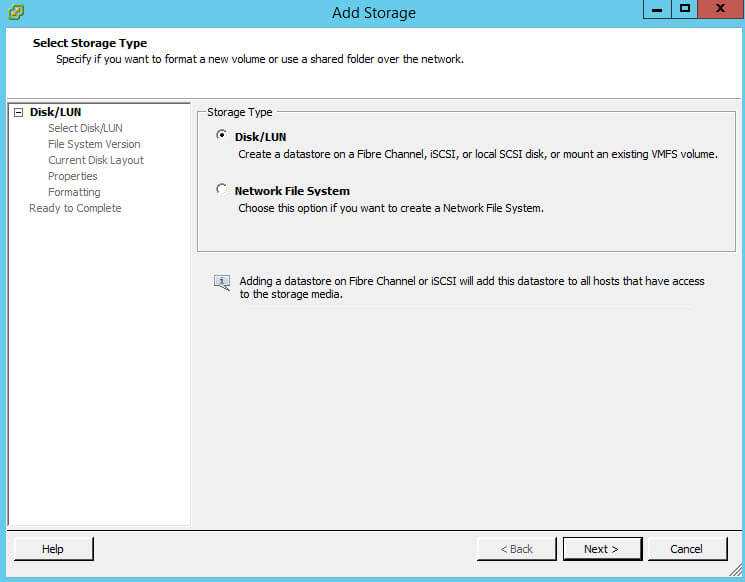

Теперь переходим Configuration-Storage и жмем Add Storage

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-28

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-28

Выбираем Disk/LUN

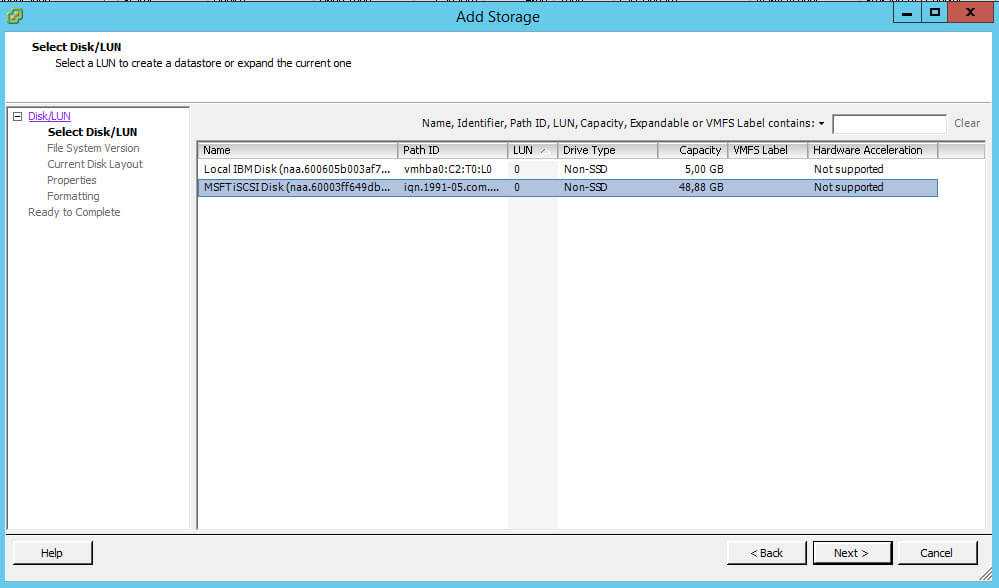

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-29

Видим, наш 50 гб диск

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-36

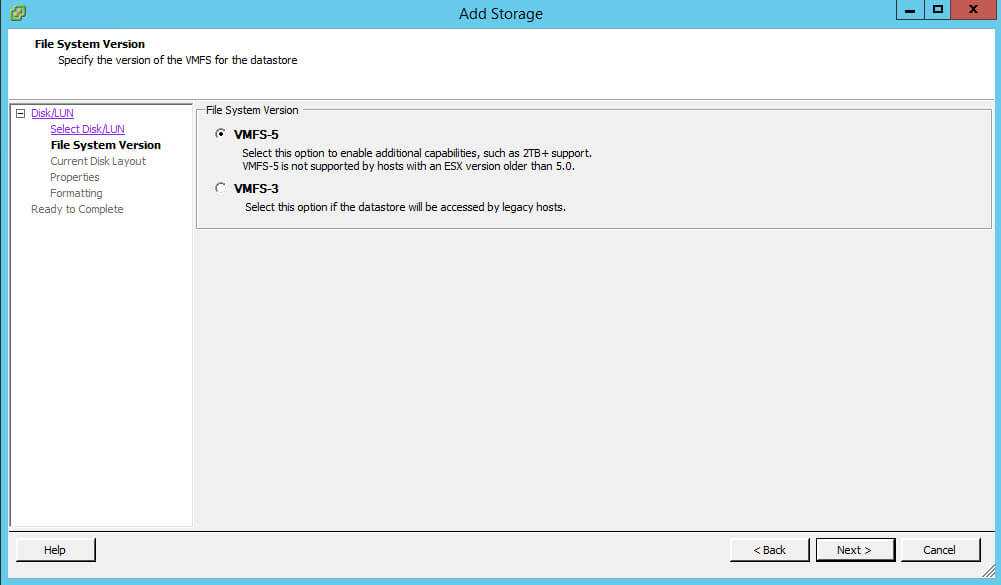

Тип файловой системы VMFS-5

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-37

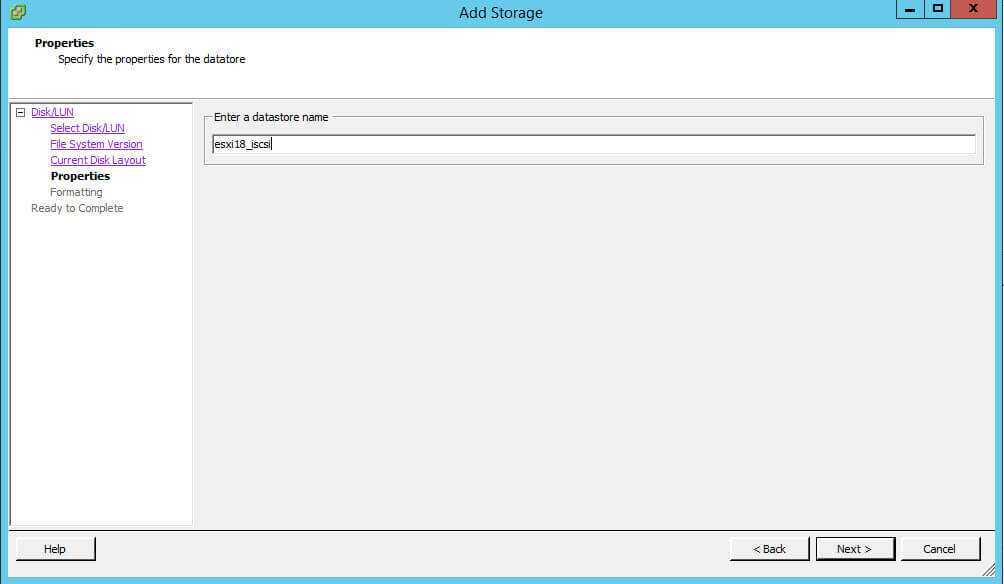

Указываем имя датастора

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-39

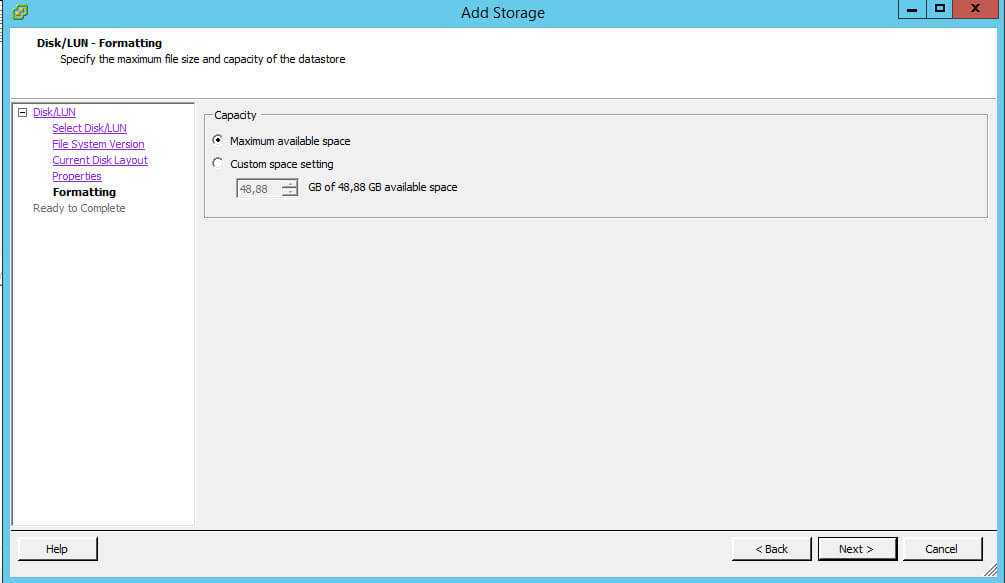

Выбираем размер диска

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-40

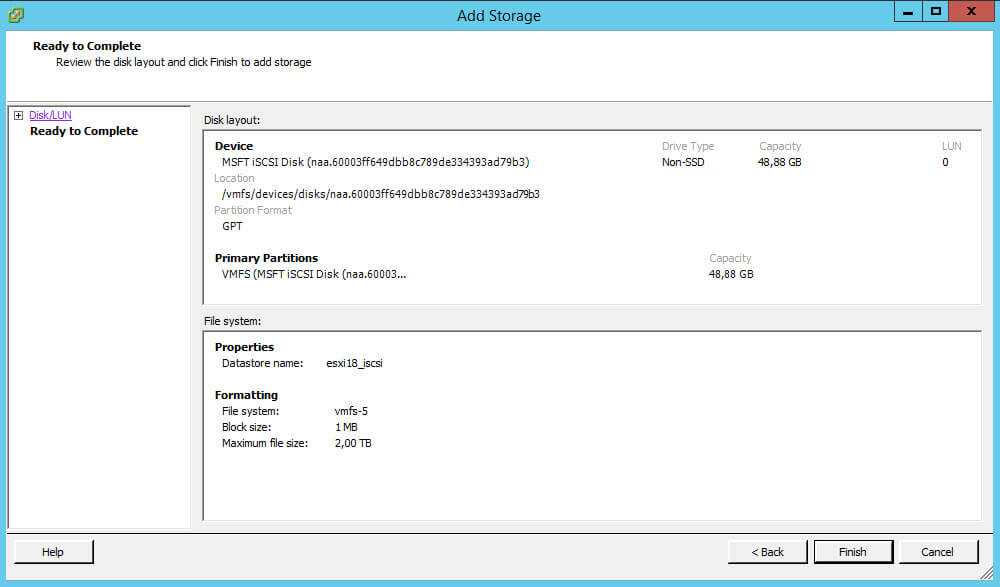

Finish

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-41

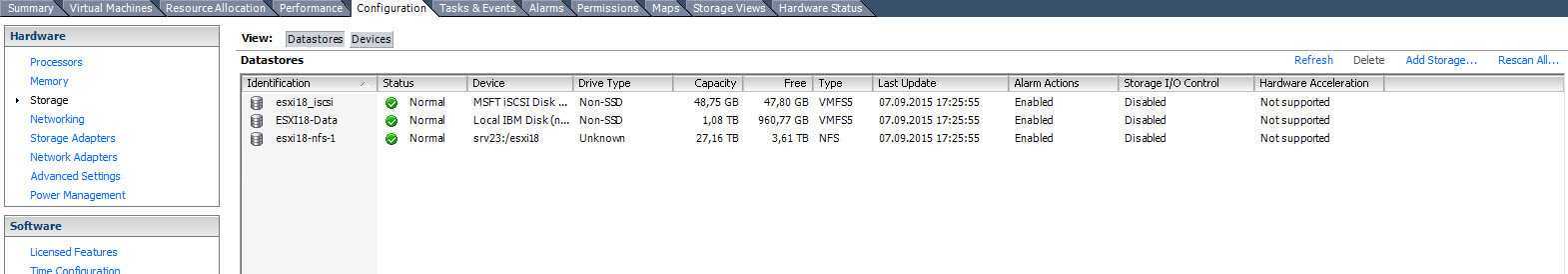

наш новый datastore появился в списке.

Как создать и подключить ISCSI диск из Windows Server 2008 R2 в VMware ESXI 5.5-42

2. Экспорт виртуальной машины VMware

Экспорт-импорт машин VMware обеспечивается поддержкой в программе VMware Workstation универсального формата хранения виртуальных машин Open Virtual Appliance. Это формат OVA или OVF. С этим форматом нативно работает и VirtualBox, что делает возможным перенос виртуальных машин ещё и между этими двумя гипервизорами. Open Virtual Appliance – это архив, включающий информацию о конфигурации виртуальной машины и хранящий в сжатом виде непосредственно содержимое виртуального жёсткого диска.

Чтобы экспорт машины VMware был возможен, необходимо отключить от её виртуального привода прикреплённые ISO-образы.

Сам процесс экспорта чрезвычайно прост: в меню «Файл» кликаем «Экспорт в OVF».

И указываем путь сохранения архива машины.

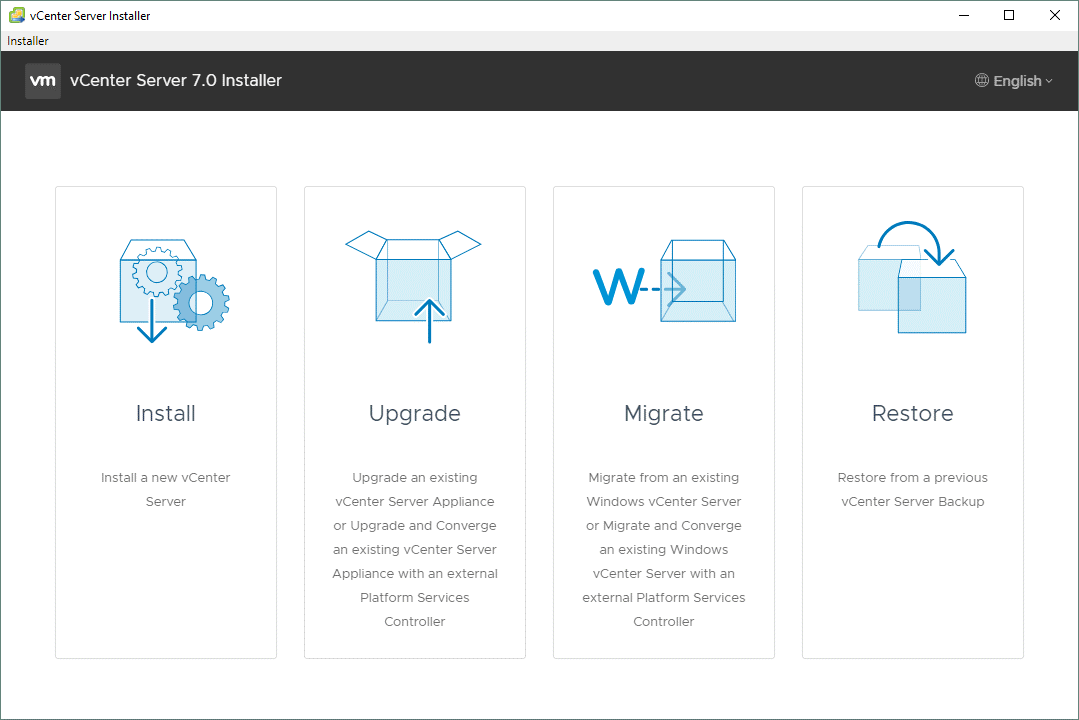

Развертывание vCenter Server

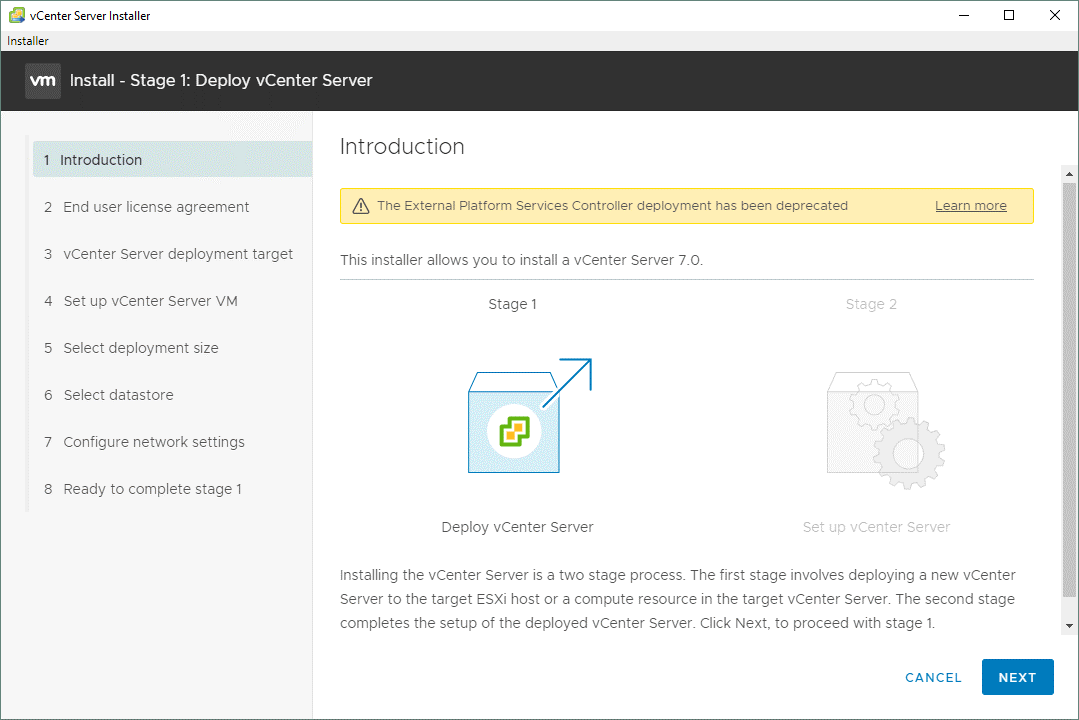

Для установки vCenter 7.0 сохраняем скаченный ISO на управляющую средой vSphere машину с Windows в D:\Install\VMware\VMware vSphere 7\VMware vCenter 7. Далее монтируем ISO-образ как виртуальный диск DVD на компьютере, с которого осуществляется подключение к ESXi-хостам, либо извлекаем содержимое в каталог пользователя. Переходим в каталог «vcsa-ui-installer\win32» и запускаем «installer.exe» (в случае с Linux ищем каталог «vcsa-ui-installer/lin64»). Нажимаем «Install» для установки нового vCenter Server:

Мастер-установщик vCenter Server проходит два этапа.

Stage 1

Introduction. Здесь нам подробно показывают, как будет устанавливаться наш vCenter. Кнопочкой «Next» проходим до конца:

End user license agreement. Здесь лицензионное соглашение, которое следует принять.

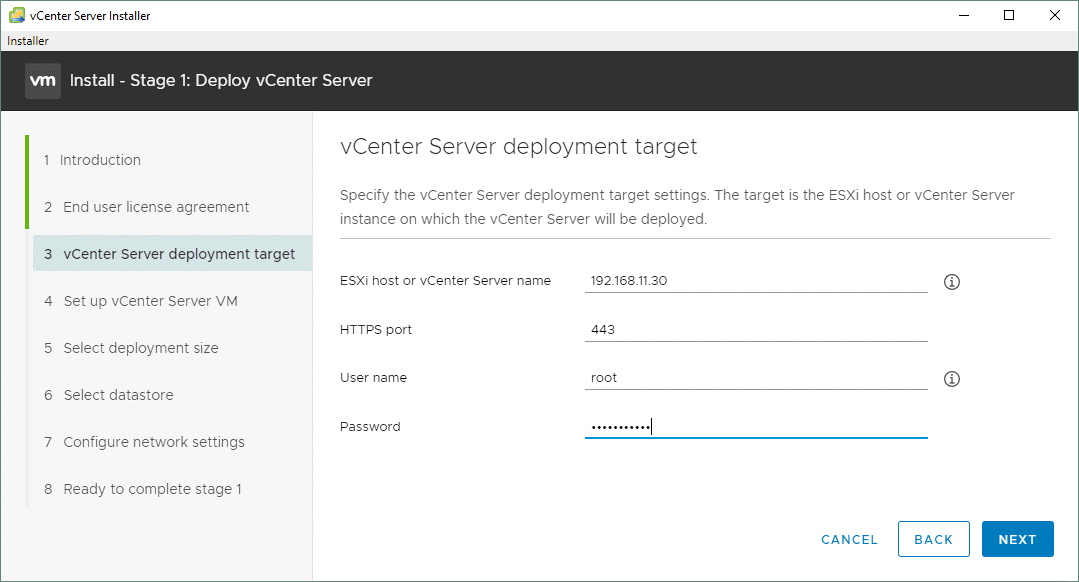

vCenter Server deployment target. На этом этапе следует указать параметры первого хоста ESXi, где будет развернут в итоге vCenter:

ESXi host or vCenter Server name: 192.168.11.30

HTTPS port: 443

User name: root

Password: ************

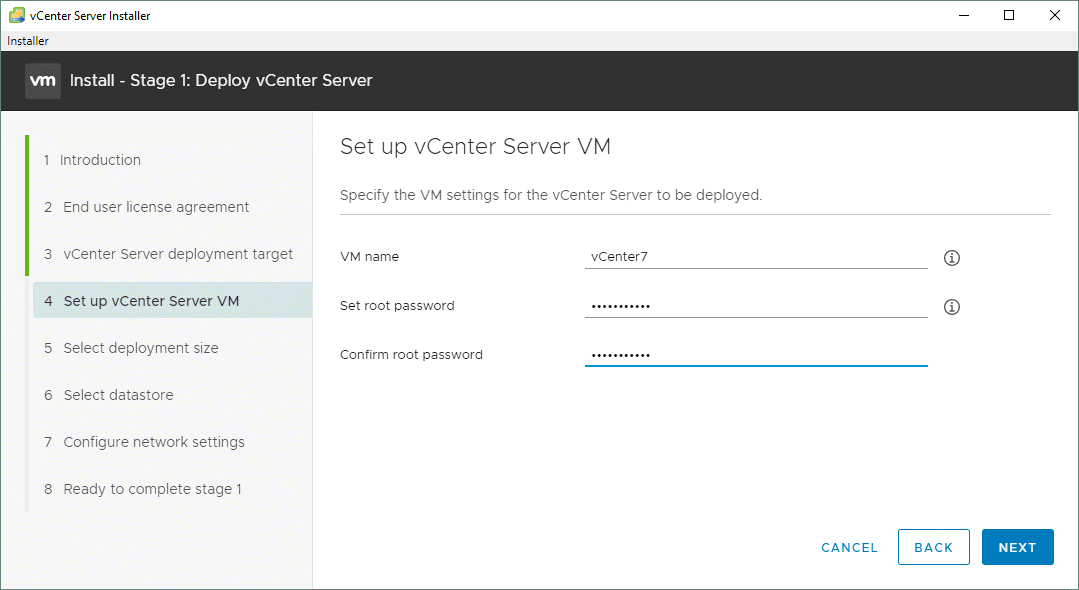

Set up vCenter Server VM. Здесь вводится имя vCenter VM и устанавливается пароль администратора для vCenter Server Appliance:

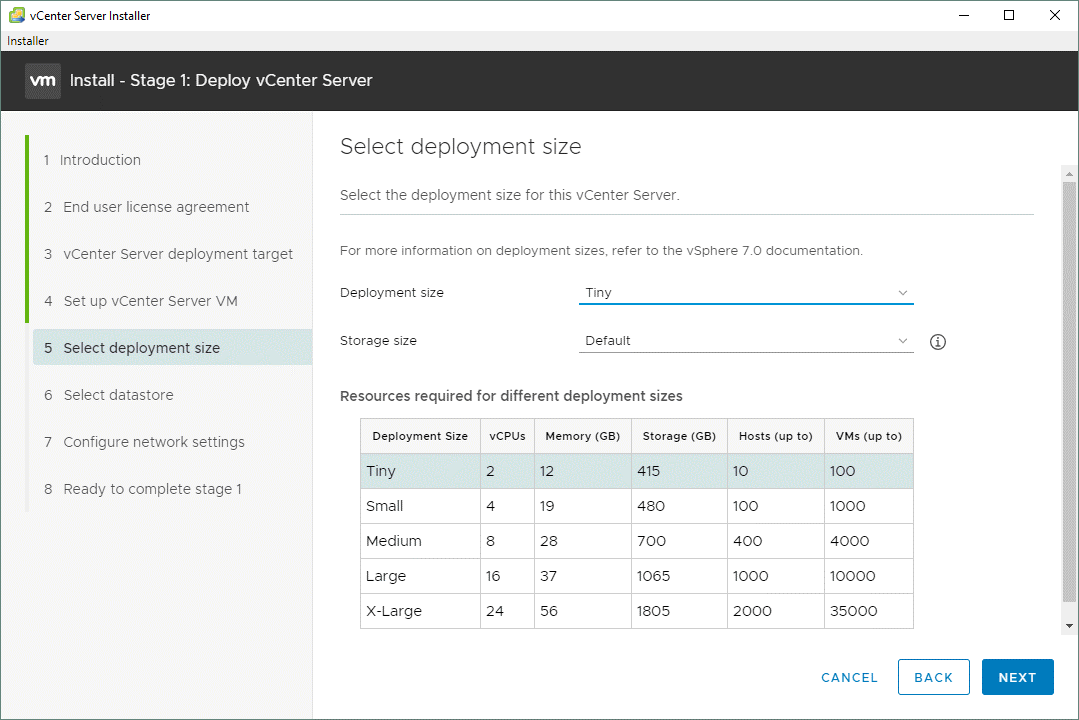

Set deployment size. Выбираем тип размера развертывания (у нас — Tiny) и размер хранилища. Прямо под полями удобная табличка для сопоставления нужного количества хостов и машин с типом развертывания, параметрами памяти, размера хранилища и количеством vCPU:

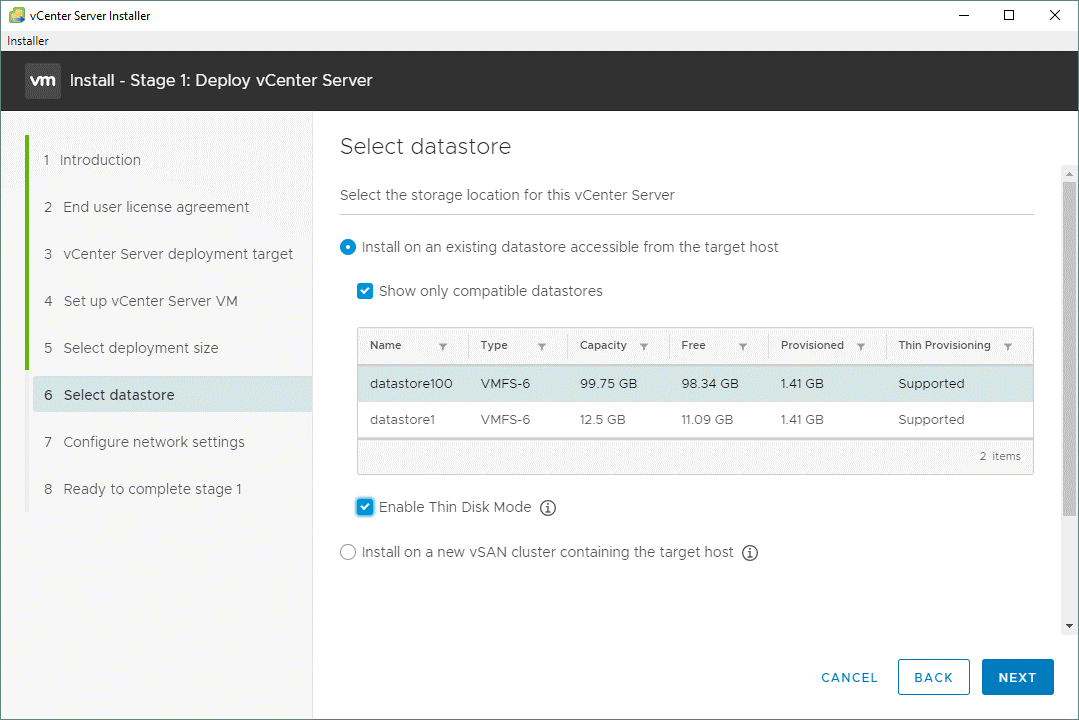

Select datastore. В этом разделе выбирается место хранения этого vCenter Server, достаточное для развертывания виртуальной машины. У нас он уже готов – это «datastore100». Включаем режим тонкого диска («Enable Thin Disk Mode»):

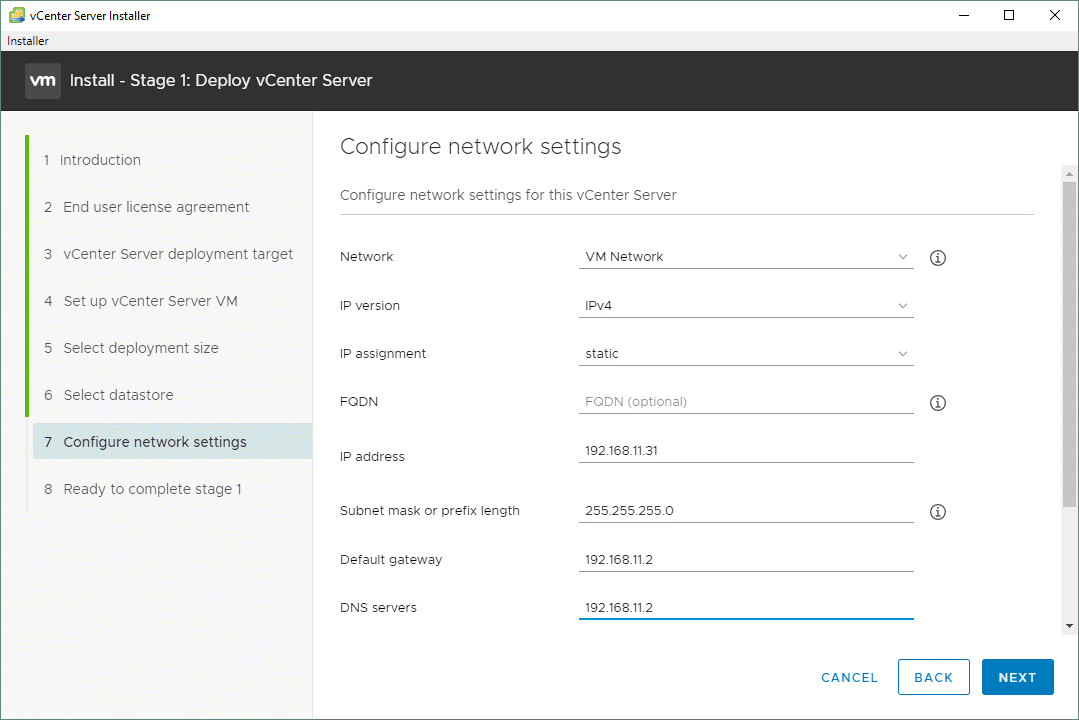

Configure network settings. Сетевые настройки в нашем случае будут следующими:

Network: VM Network

IP version: IPv4

IP assignment: static

FQDN: (optional)

IP address: 192.168.11.31

Subnet mask of prefix length: 255.255.255.0

Default gateway: 192.168.11.2

DNS servers: 192.168.11.2

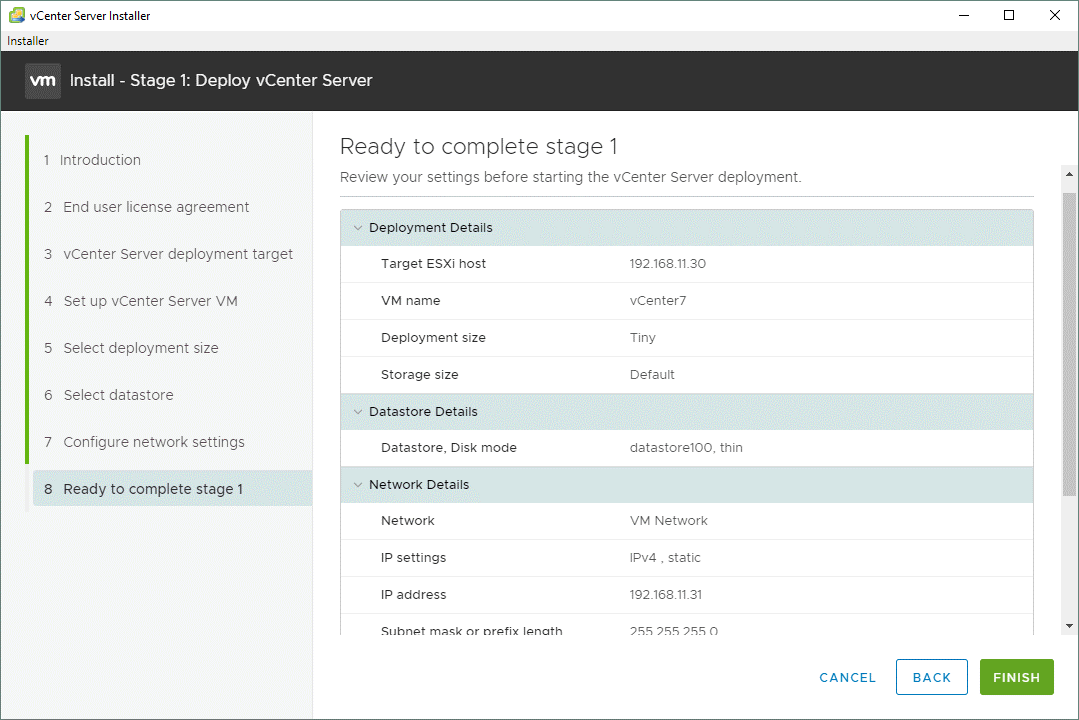

Ready to complete stage 1. Проверяем все настройки и соглашаемся с завершением первого этапа установки:

Какое-то время на экране будет прогресс-бар разворота vCenter 7.0.

Stage 2

Introduction. Нам аналогично сообщают, что будет происходить на данном этапе. Чтобы продолжить, нажимаем «Next».

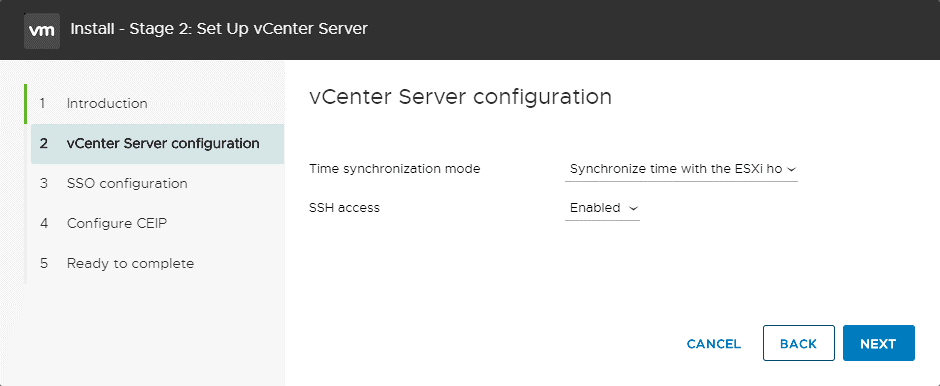

vCenter Server configuration. Выбираем настройки синхронизации времени и включаем доступ к SSH:

Time synchronization mode: Synchronize with the ESXi host

SSH access: Enabled

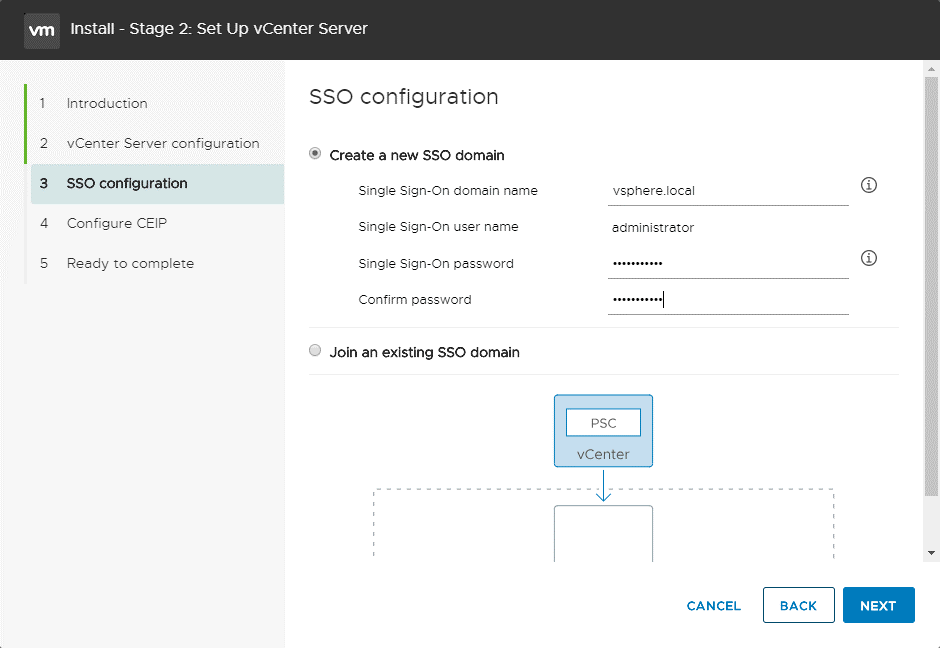

SSO configuration. Выбираем опцию «Create a new SSO domain»:

Single Sign-On domain name: vsphere.local

Single Sign-On user name: administrator

Single Sign-On password: Enter a password and confirm the password

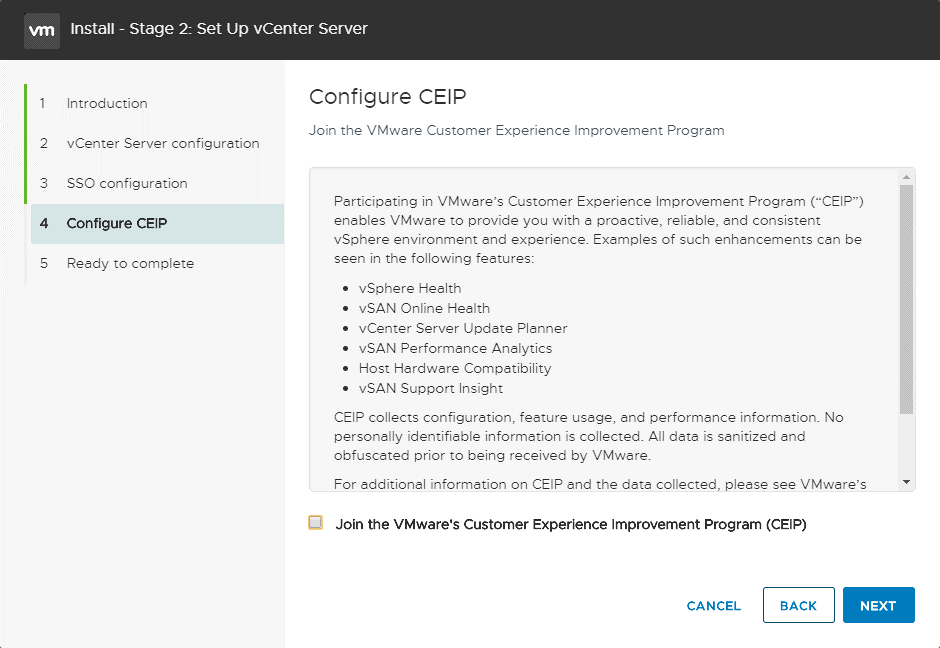

Configure CEIP. Убираем галочку, если не хотим отправлять статистику в VMware и идем далее:

Ready to complete. Проверяем все, что задали, и жмем «Finish».

1. Открытие виртуальных машин в VMware Workstation

Если работа с виртуальными машинами будет производиться и далее в среде VMware Workstation, нет в принципе нужды экспортировать машины. После переустановки хост-системы Windows нужно установить гипервизор и в меню «Файл» выбрать «Сканирование виртуальных машин».

Далее указываем каталог расположения машин, тот, что был до переустановки хостовой Windows.

И добавляем все обнаруженные машины в библиотеку VMware Workstation. Если нужны не все, то, соответственно, снимаем галочки с ненужных.

Далее открываем программную библиотеку и можем работать с добавленными в интерфейс машинами.

По этому же принципу можем поступить и при переходе на другой компьютер. Мы физически переносим каталог хранения виртуальных машин VMware на диск другого компьютера. И в установленной на том другом компьютере программе VMware Workstation добавляем перенесённые виртуальные машины. При добавлении новых готовых машин программа во время их первого запуска обычно выдаёт запрос: мол, обнаружено, что это перенесённая или скопированная машина. Но программе необходимо точно указать, машина перенесена или скопирована. Это нужно для настройки сети и других функций. И вот в ответ на такой запрос нажимаем кнопку «I Moved It», т.е. указываем, что машина перенесённая.

Перенос непосредственно каталога виртуальных машин на другой компьютер – как видим, способ чрезвычайно простой, но он хорош для случаев, когда мы не стеснены средствами переноса данных. К примеру, у нас есть нужного объёма USB-HDD, либо же мы можем перенести каталог с виртуальными машинами в онлайне с использованием торрент-технологии. Но если у нас нет USB-HDD, а каталог с машинами нужно какое-то время где-то передержать, прежде чем он может быть помещён на целевой компьютер, машины лучше экспортировать. Экспортировать с целью сжатия данных. К примеру, в нашем случае папка одной виртуальной машины с фиксированным виртуальным диском весит 50 Гб.

А вес файлов экспортированной машины будет составлять даже менее 5 Гб.

Доступ к VMFS разделу из Ubuntu

В этой секции мы покажем, как смонтировать раздел с файловой системой VMFS на компьютере с установленной ОС Ubuntu (Live CD с Ubuntu в этом сценарии нам не подойдет, скачать серверные ubuntu с 10 по 14 версии и выше).

В первую очередь необходимо подключить физический диск с VMFS к компьютеру с Ubuntu.

Чтобы получить доступ к данным на VMFS томе, нам понадобиться установить специальный пакет vmfs-tools. Данный пакет позволяет получить доступ к файловой системе раздела VMFS с не ESX/ESXi хостов. Доступ возможен в режиме только на чтение (read-only).

Установим пакет следующей командой

apt-get install vmfs-tools

Примечание. В репозитариях Ubuntu пока доступна только версия vmfs-tools 0.2.1, основной ее недостаток – она умеет работать только с файловой системой VMFS v4. Если вам нужно смонтировать датастор с VMFS 5, придется самостоятельно скачать и установить версию vmfs-tools не ниже 0.2.5, например, здесь: http://ge.archive.ubuntu.com/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_i386.deb – пакет для 32 битной системы http://de.archive.ubuntu.com/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_amd64.deb – пакет для 64 битной системы

Качаем соответствующую версию пакета так:#wget http://de.archive.ubuntu.com/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_amd64.deb

И устанавливаем его:#dpkg -i vmfs-tools_0.2.5-1_amd64.deb

Если нужно будет удовлетворить зависимости, воспользуемся командой:#apt-get install vmfs-tools

После установки пакета, создадим каталог для точки монтирования:#mkdir /mnt/vmfs

Следующий шаг – нужно разобраться с разделами на дисках. Гипервизор ESXi при установке помимо, собственно, раздела для файлов виртуальных машин (VMFS) создает множество служебных разделов. Если версия ESXi 4 или ниже, или VMFS хранилище было обновлено с версии VMFS 4 до VMFS 5, а его размер не превышает 2 Тб, выведем список дисков и разделов так:#fdisk -l

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Как мы видим, раздел с файловой системой VMFS – /dev/sd3 (метка VMware VMFS) Важно. Т.к

в ESXi 5 используется VMFS v5 с таблицей разделов GPT (таблица GUID Partition Table используется вместо MBR, что позволяет создавать хранилища большего размера и пробрасывать RDM диски в режиме физической совместимости размером более 2 TB). Поэтому для просмотра таблицы разделов придется вместо fdisk использовать команду parted. Итак, выведем информацию о разделах так:#parted -l

Осталось смонтировать партицию с хранилищем VMFS:#vmfs-fuse /dev/sdb3 /mnt/vmfs

Выведем содержимое смонтированного раздела:#ls -all /mnt/vmfs

Итак, теперь мы видим все файлы виртуальных машин на VMFS хранилище, которое доступно нам для чтения, а это значит, что мы можем скопировать каталоги и/или отдельные файлы нужных виртуальных машин на отдельный диск и запустить их на другом гипервизоре ESXi. Доступ к VMFS разделу из Windows

Для доступа к данным на VMFS разделе из Windows, нам понадобится специальный открытый драйвер Open Source VMFS Driver, написанный на Java. Драйвер требует версию Java не ниже 6 и также позволяет монтировть VMFS-тома только для чтения Итак, качаем Open Source VMFS Driver по этой ссылке https://code.google.com/p/vmfs/ и распаковываем его в произвольный каталог (допустим C:\vmfs) Проверить работу java-приложения fvmfs.jar можно так:cd \vmfsjava -jar fvmfs.jar Определяем номер диска с хранилищем VMFS, подключенный к нашему Windows-компьютеру. Номер диска можно узнать с помощью консоли управление дисками или diskpart. (В нашем примере подключенный диск имеет индекс 1 – Disk1. Для драйвера утилиты fvmfs, этот диск будет именоваться так: \\.\PhysicalDrive1)

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Попытаемся получить информацию о диске: java -jar fvmfs.jar \\.\PhysicalDrive1 info

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Предоставим общий доступ к данному диску с помощью webdav: java -jar fvmfs.jar \\.\PhysicalDrive1 webdav

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Подключим расшаренный диск: net use * http://localhost:50080/vmfs

В системе должен появиться новый диск, с содержимым датастора VMFS, доступный для чтения.

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Вот так вот просто получить доступ к данным на VMFS разделе из-под Windows / Linux. До новых встреч. С вами был Иван Семин, автор и создатель IT портала Pyatilistnik.org

Шаг 2. Настройка сети

если вы развертываете дисковые пространства прямо внутри виртуальных машин, пропустите этот раздел.

дисковые пространства Direct требует сети с высокой пропускной способностью и низкой задержкой между серверами в кластере. Требуется по крайней мере 10 сетей GbE, и рекомендуется использовать удаленный доступ к памяти (RDMA). вы можете использовать либо iWARP, либо роце, если у него есть логотип Windows Server, соответствующий вашей версии операционной системы, но iWARP, как правило, проще в настройке.

Важно!

В зависимости от сетевого оборудования и, особенно с Роце версии 2, может потребоваться настройка коммутатора верхнего уровня. правильная конфигурация коммутатора важна для обеспечения надежности и производительности дисковые пространства Direct.

в Windows Server 2016 введена команда объединения коммутаторов (SET) в виртуальном коммутаторе Hyper-V. Это позволяет использовать одни и те же физические порты сетевого адаптера для всего сетевого трафика при использовании RDMA, уменьшая число необходимых портов физического сетевого адаптера. объединение встроенных коммутаторов рекомендуется для дисковые пространства Direct.

Взаимосвязи узлов с переключением и с переключением

- Переключение: Сетевые коммутаторы должны быть правильно настроены для работы с пропускной способностью и типом сети. Если используется RDMA, который реализует протокол Роце, сетевое устройство и Конфигурация коммутатора еще более важны.

- Без переключения: узлы могут быть взаимосоединены с помощью прямых подключений, избегая использования коммутатора. Необходимо, чтобы каждый узел имел прямое соединение со всеми остальными узлами кластера.

инструкции по настройке сети для дисковые пространства Direct см. в разделе руководств по развертыванию Windows Server 2016 и 2019.

Итог

Коробка получилась интересной. С одной стороны, если бы здесь не стояла сразу Windows, то можно было бы установить сюда тот же Linux и загрузить сервачка по всем его техническим возможностям. У нас же коробка сразу с бонусом в виде установленной Windows Server, которая отлично подойдёт для малого и среднего бизнеса. Да, сама система не такая простая в настройках, как хотелось бы, но если вам нужен специальный софт, который есть только под Windows, научиться ей пользоваться всё же придётся. А вот к железной составляющей претензий в целом нету. Компактное, тихое и в меру производительное устройство. Коробка стояла на столе в 30 см от меня, и из звуков было слышно только работу жестких дисков, и то всё в рамках комфорта. Думаю, что если вы не хотите забивать себе голову, какой сервак собрать и какое железо туда установить, то готовые решения такого плана, как наш, может сэкономить много времени, а в бизнесе, как говорится, «Время — деньги».

![Оптимизация операционной системы vmware esxi 6 для работы с схд [colobridge wiki]](http://smartshop124.ru/wp-content/uploads/e/e/5/ee5ae5780bed4513eda67c2cc6c318ce.jpeg)