Подключение СХД Qsan к гипервизору VMware ESXi +1

- 16.06.20 06:53

•

Skilline

•

#506522

•

Хабрахабр

•

Tutorial

•

•

2400

Виртуализация, IT-инфраструктура, Хранение данных, SAN, Блог компании Skilline

Эксплуатация технически сложного оборудования, типа систем хранения данных, подразумевает наличие у администратора определенных навыков. Однако высокие технологии шагают в массы. И, соответственно, растет число пользователей, впервые столкнувшиеся с ними. Уверены, что статьи в стиле How To являются отличным способом пополнить багаж знаний как для новичков, так и узнать нюансы и особенности для опытных пользователей.

В данной статье мы рассмотрим порядок подключения СХД Qsan к гипервизору VMware ESXi, а также по возможности дадим практические советы по тюнингу настроек для достижения максимальной эффективности использования оборудования.

В рамках данной статьи мы рассмотрим процессы подключения СХД Qsan с использованием блочных протоколов доступа iSCSI и Fibre Channel. Условно в процессе подключения можно выделить несколько основных этапов:

- Физическая и логическая коммутация

- Действия на стороне СХД

- Действия на стороне хоста(ов)

В статье приведены скриншоты настройки гипервизоров ESXi 6.7 под управлением vSphere. В случае Standalone ESXi пункты меню могут называться чуть иначе и ряд настроек отсутствовать.

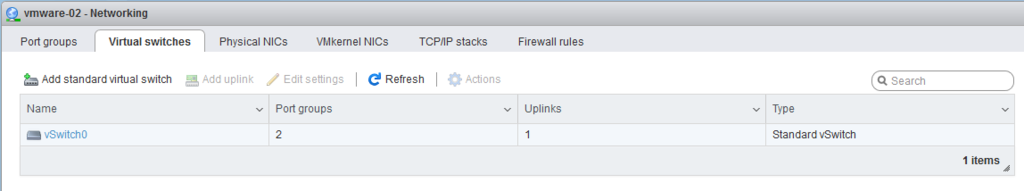

Networking ^

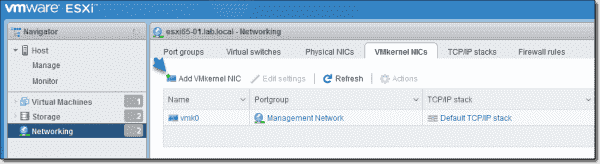

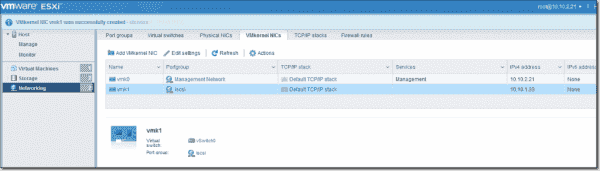

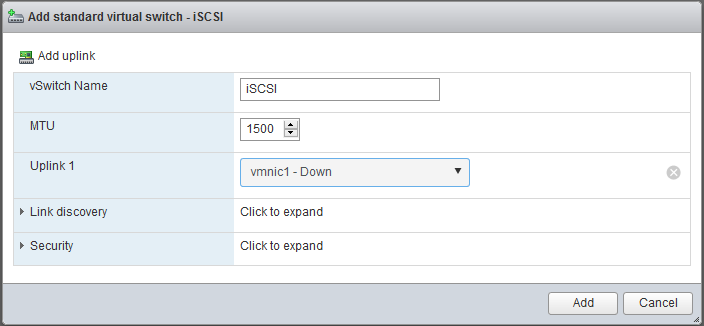

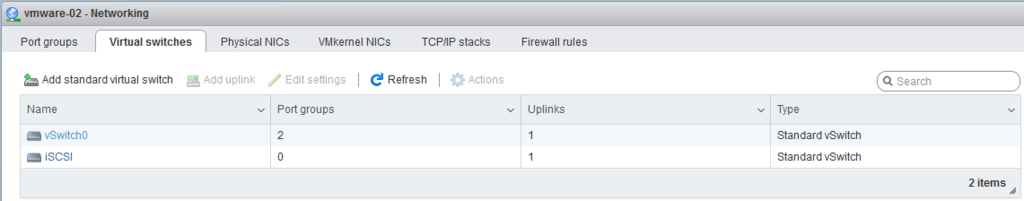

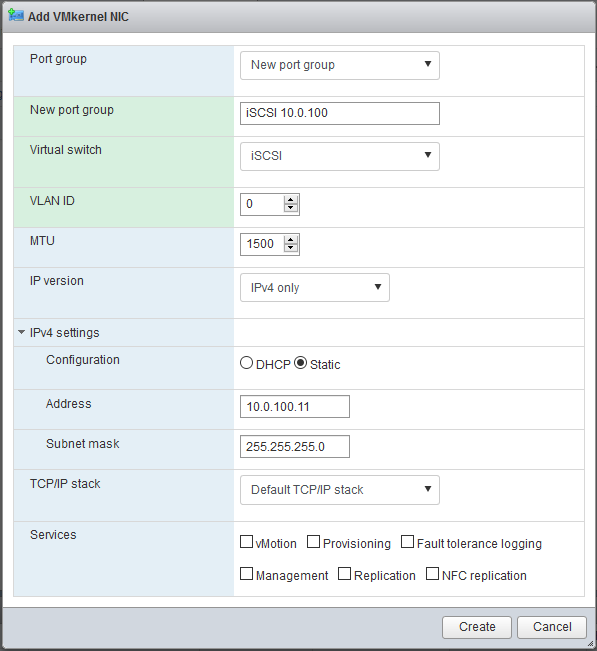

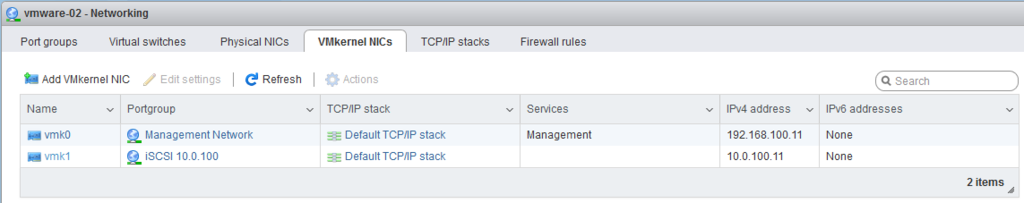

First, we need to add a VMkernel network interface card (NIC) to our system so the ESXi host can connect to the remote storage device. To do so select Networking > VMkernel NICs > Add VMkernel NIC.

Add a VMkernel NIC

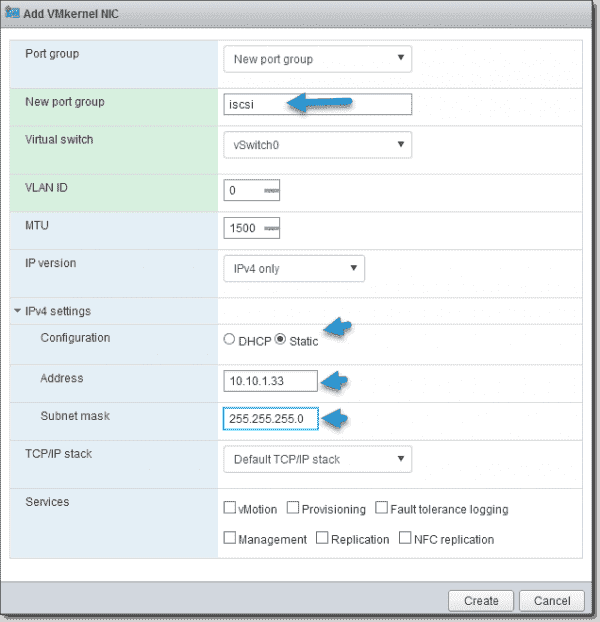

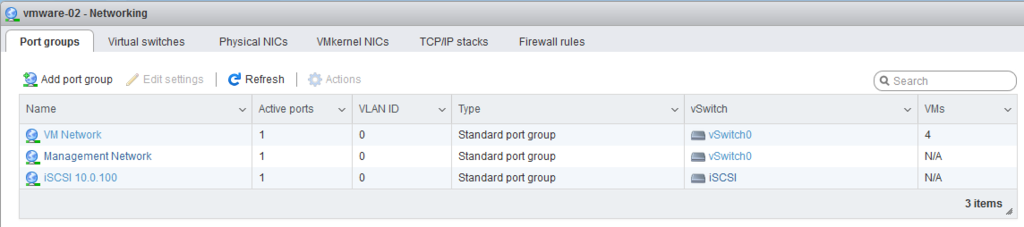

We will also add a new port group. Please name the port group accordingly. In my example, I named it simply iscsi. Note that our storage system is on another subnet.

Create a new port group

The result should look like the screenshot below:

Add a VMkernel NIC for the iSCSI connection

But that’s not all. Before we go further, we need to make sure that:

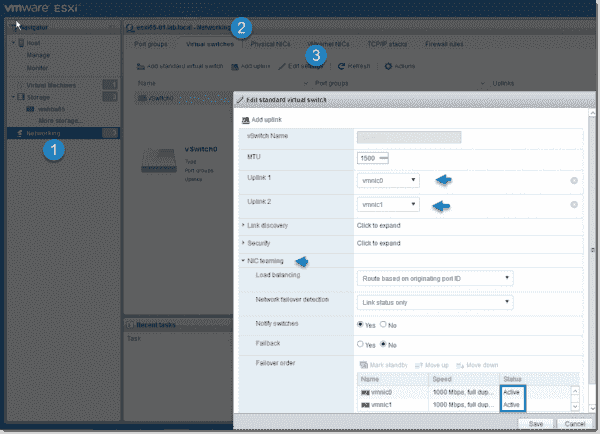

- At the vSwitch level: Both physical NICs connected to the ESXi hosts are active.

- At the port group level: A single NIC is set as active. The other one is set as unused.

Navigate to Networking > Virtual Switches > select vSwitch0 > Edit settings, expand the NIC teaming section and make sure both NICs are marked as active. If for some reason one of the NICs isn’t active, please select the NIC and click the Mark as active button.

NIC teaming at the vSwitch level

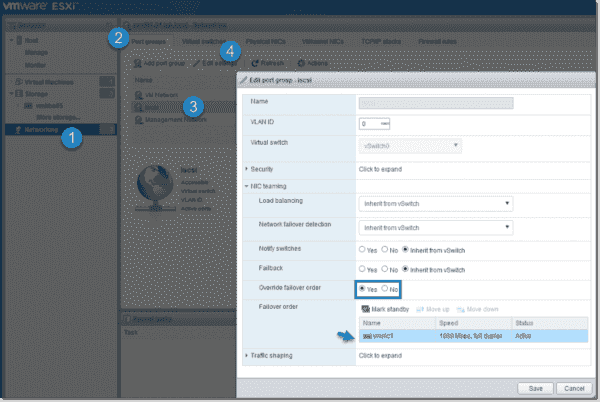

We also need to override the failover order at the port group level because by default, the port group inherits the setting from our vSwitch. First, navigate to Networking > Port groups TAB, select the iscsi port group > Edit settings > expand the NIC teaming section and then make sure to select Override failover order – Yes. Use the correct NIC for iSCSI storage traffic (vmnic1 in our case).

Override failover order on the iSCSI port group

Next, do the same for the Management Network and the VM network, and now, only select vmnic0.

Override failover order on the Management and VM network port groups

Описание VMware ESXi

Гипервизор VMware ESXi – самый популярный, функциональный и уникальный в своем сегменте программный продукт для серверной виртуализации. Популярность и, как следствие, массовое использование в корпоративном секторе позволили разработчикам к 7-ой версии исправить ошибки, которыми болеют другие гипервизоры-конкуренты. Выбирая, ESXi, даже в бесплатной версии, вы гарантированно получаете продукт высшего качества, который будет работать стабильнее других, по которому всегда можно найти исчерпывающую официальную информацию, документацию, а теперь и видео. Помимо официального сайта есть форумы и блоги, с описаниями установки, способами миграции с физических серверов в виртуальные, вариантами проектов и прочим полезным материалом.

Основная функциональная возможность, которую реализует гипервизор ESXi – это создание виртуальных машин на физическом сервере. В качестве гостевых операционных систем поддерживаются все основные версии, используемые в корпоративном секторе.

Развертывание VMware Virtual SAN Appliance.

В настоящий момент актуальной версией VMware Virtual SAN Witness Appliance является . Переходим по и скачиваем OVA-темплейт, подключаемся к Vcenter Server’у через vSphere Client. Можно так же через веб-интерфейс:

https://<IP_adress_of_vsphere_server>/vsphere-client/

или открываем в vSphere Client пункты меню:

File -> OVF Template

и открываем скачанный OVA-темплейт. В открывшемся мастере будет предложен масштаб для деплоймента (до 10, до 500, или более 500 виртуальных машин), для каждого из которых свои требования к ресурсам виртуальной машины (рис. 1).

Рис. 1. Требования для VMware Virtual SAN Appliance в зависимости от выбранного масштаба.

Если вы разворачивали VMware Virtual SAN Appliance на кластере хостов ESXi на момент настройки vSAN режим vSphere HA лучше отключить. Для этого открываем в vSphere Client по правой кнопкой на кластере “Edit Settings -> Cluster Features” и снимаем чек-бокс с “Turn On vSphere HA”, или переходим в веб-консоли vSphere (рис. 2):

Hosts and clusters -> Cluster_Name -> Manage -> Settings

Рис. 2. Выключение vSphere HA.

Выбираем носитель и формат диска (лучше выбрать “Thin Provision”), используемую сеть (Network Mapping) и задаем пароль. По завершению установки открываем консоль из vSphere Client, логинимся и настраиваем сеть.

Рис. 3. VSAN Port Group.

Можно создать для Virtual SAN трафика отдельный port group на распределенном свитче (distributed switch) (рис. 3). В принципе, для тестовых условий можно трафик не отделять — достаточно разрешить его на существующей виртуальной Сетевой коммутации (поставить чек-бокс, как показано на рис. 4).

Для того, чтобы настроить сеть vSAN VMkernel на распределенном свитче откройте веб-консоль vSphere и выберите режим просмотра “Networking”, а затем:

- Выберите распределенный свитч, который нужно изменить.

- Выберите “Manage host networking” и нажмите “Next”.

- Кликните на “Attached Hosts”, выберите хосты, которые нужно ассоциировать с распределенным свитчем и нажмите “Next”.

- Выберите “Manage VMkernel adapters”, нажмите “Next” и выберите “New adapter”.

- На странице выбора выбора устройства выберите существующую группу портов и нажмите “Next”.

- На странице “ Port properties” ставим чек-бокс на опции “Virtual SAN traffic” (рис. 4) и переходим к настройке VMkernel-адаптера: указываем Network Label, VLAD ID для разделения vSAN-трафика и IP Settings.

Для того, чтобы настроить сеть vSAN VMkernel на стандартном виртуальном свитче (standart virtual switch) в веб-консоли vSphere выбираем режим “Hosts and Clusters”, а затем:

- Выбираем хост, который нужно сконфигурировать для vSAN, открываем вкладку “Manage” и выбираем “Networking”.

- Выбираем “VMkernel Adapters”, кликаем на “Add host networking” и кликаем “Next”.

- На странице выбора выбираем существующий стандартный свитч (standard switch), или создаем новый и кликаем “Next”. Если вы создаете новый, то убедитесь, что вы приаттачили к нему физический сетевой адаптер.

- На странице “Port properties” ставим чек-бокс на опции “Virtual SAN traffic” (рис. 4) и переходим к настройке VMkernel-адаптера (аналогично п. 6 настройки распределенного свитча).

Рис. 4. Add vSAN traffic.

Подробней о настройке VMware SAN 5.5.x-6.5.x можно прочитать здесь (особое внимание стоит уделить ссылкам на vSphere 6.0 / vSphere 5.5 Networking Guide). Завершающим штрихом в настройке Virtual SAN будет назначение дисковых групп

Дисковая группа — это логический “контейнер” для дисков, используемых vSAN. Каждой дисковой группе нужен минимум один магнитный жесткий диск (HDD), тогда как максимально можно использовать 7. На каждую дисковую группу так же нужен один flash-диск, который является буфером и кэш-слоем для каждой дисковой группы. Очевидно, что любой диск имеет предельную пропускную способность, определенное количество IOPS. Если flash-диск был недоступен, то вся дисковая группа будет недоступна в течении того же промежутка времени. Таким образом, создание дополнительной дисковой группы может служить, как для отказоустойчивости, так и для повышения пропускной способности. Если в цифрах, то наглядный пример иллюстрирован здесь.

Назначаем (Claim) диски для кэша и данных (как показано на простейшем примере на рис. 5) по переходу в веб-консоли vSphere:

Hosts and clusters -> Cluster_Name -> Manage -> Setting -> Virtual SAN -> Disk Management -> Claim Disks

Рис. 5. Claming disks.

For VMware vSphere Windows Version

Server and Storage Network Settings

|

Server Network Settings |

||

|---|---|---|

|

Role |

IP |

Description |

|

ESXi host |

192.168.217.1 |

VMware ESXi host |

|

Data Network 1 |

10.10.10.1 |

10G Data port 1 in ESXi host |

|

Data Network 2 |

10.10.20.1 |

10G Data port 2 in ESXi host |

|

Storage Network Settings |

||

|---|---|---|

|

Setting |

Value |

Description |

|

SCA Management IP |

192.168.217.61 |

Management IP of controller A |

|

SCA Ethernet1 IP |

10.10.10.61 |

Data port 1 IP of controller A |

|

SCA Ethernet2 IP |

10.10.20.61 |

Data port 2 IP of controller A |

|

SCB Management IP |

192.168.217.62 |

Management IP of controller B |

|

SCB Ethernet1 IP |

10.10.10.62 |

Data port 1 IP of controller B |

|

SCB Ethernet2 IP |

10.10.20.62 |

Data port 2 IP of controller B |

|

Pool allocate to SCA |

Pool1 |

RAID6 pool at controller A |

With the information listed in the above table, assuming a 100GB LUN is deployed on ES dual controller A (SCA), it can be mounted using the following steps on the ESXi host.

Add iSCSI Targets on VMware ESXi Hosts

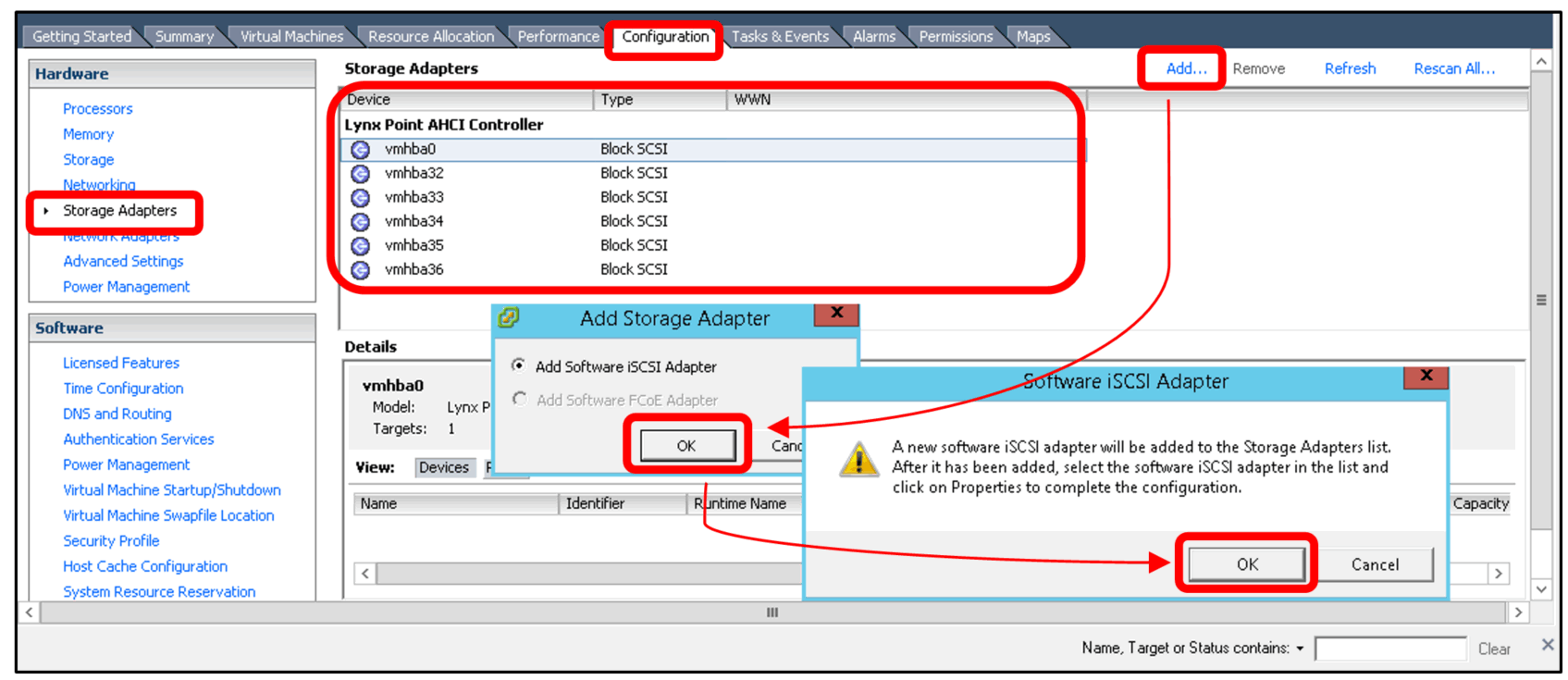

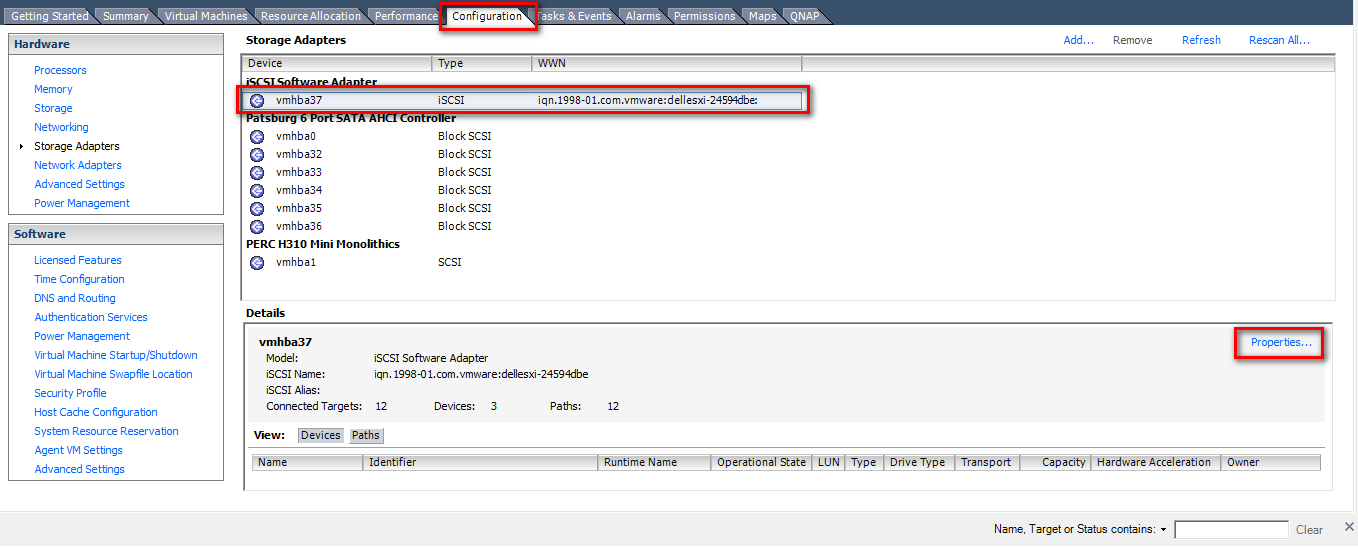

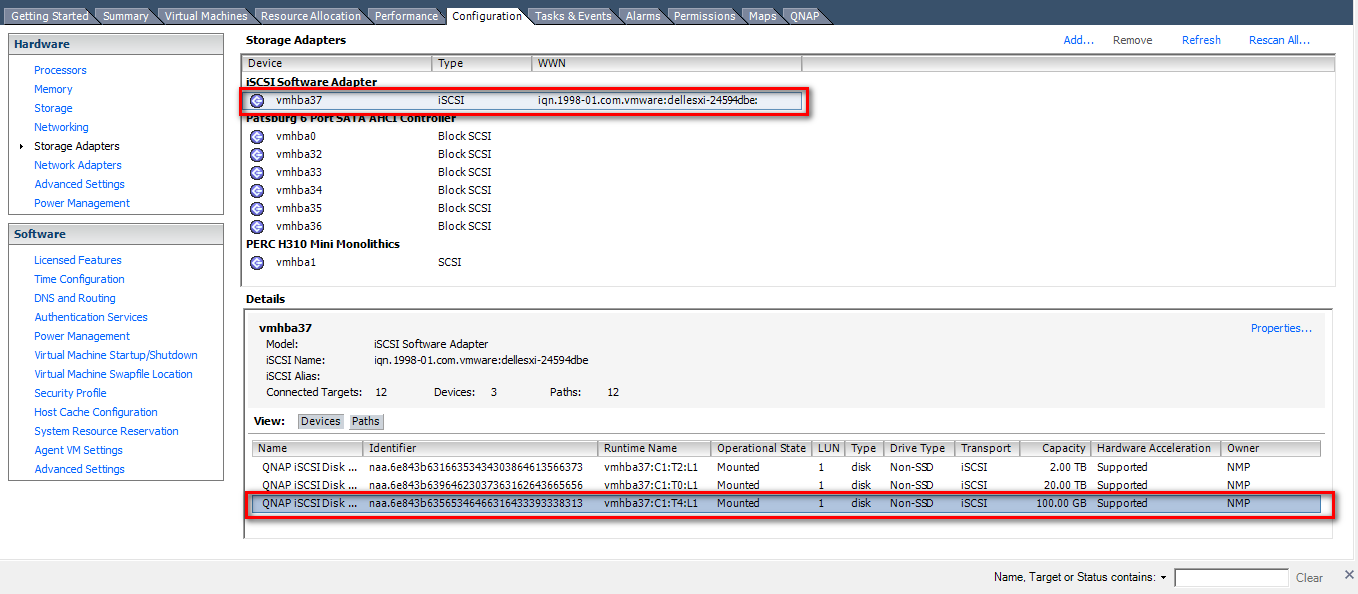

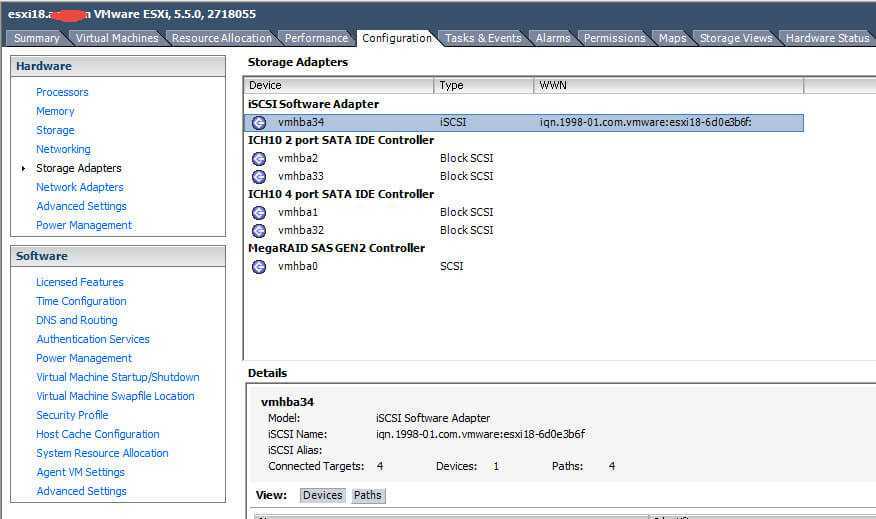

Step 1: Log in to vSphere Client and select a host from the inventory panel. Go to the “Configuration” tab and click “Storage Adapters” in the Hardware panel. Click “Add…” on the top right of the window to add a storage adapter.

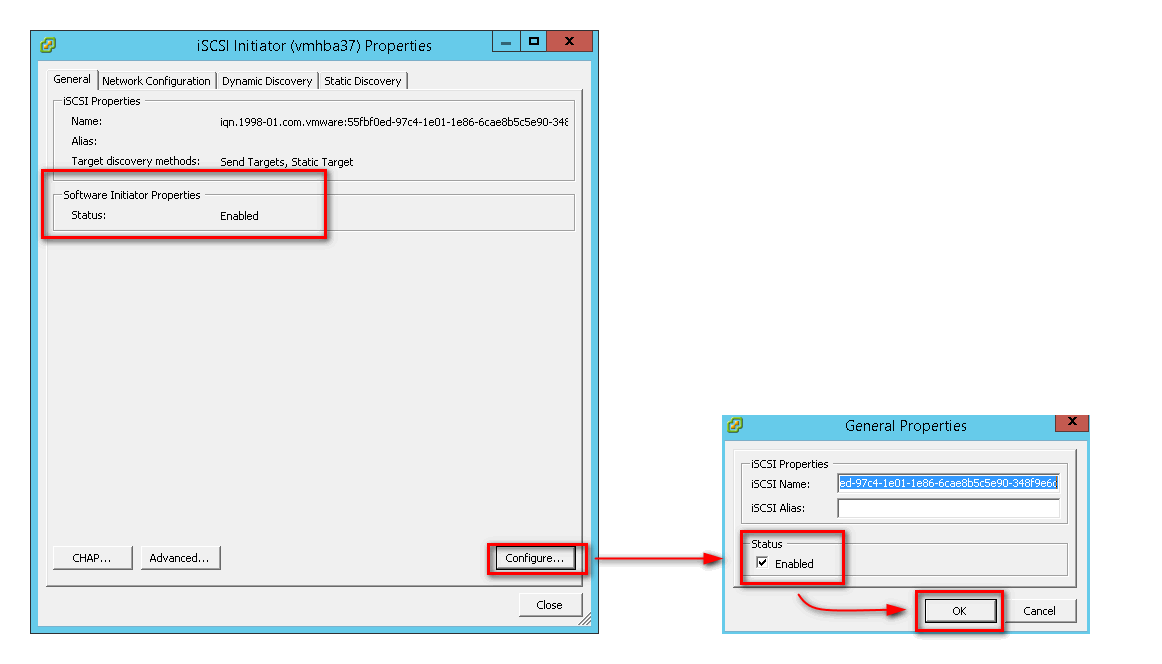

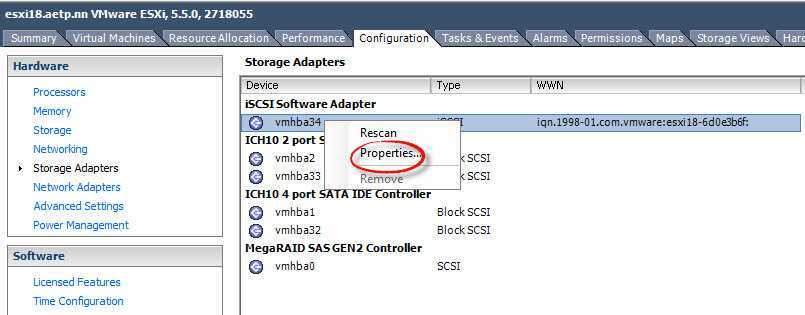

Step 2: A new software iSCSI adapter will be added to the Storage Adapter list. Select the new software iSCSI adapter on the list and click “Properties”.

Step 3: Ensure the adapter is enabled. If not, click “Configure…”, check «Enabled» and click “OK”.

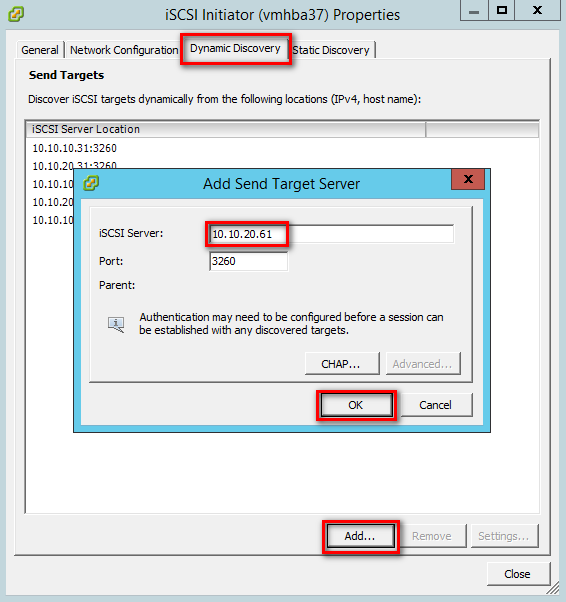

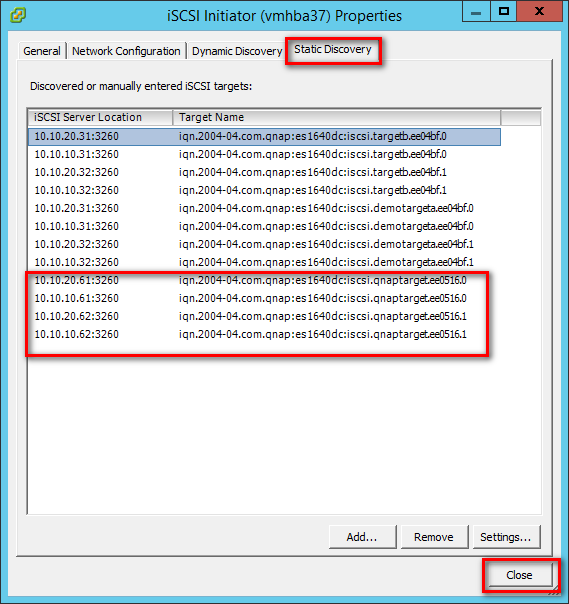

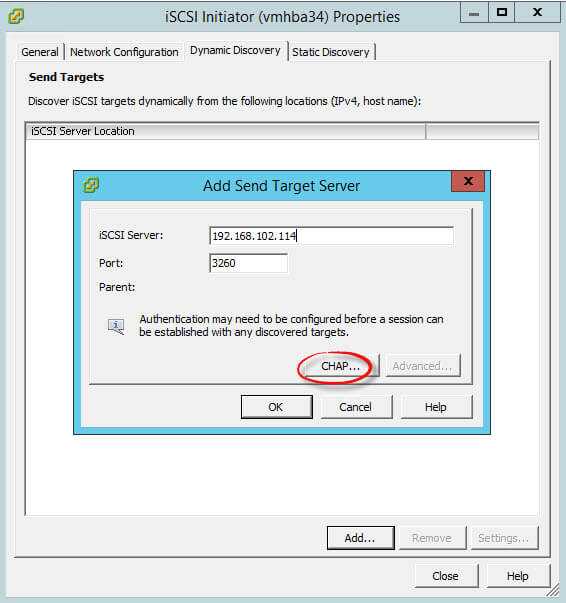

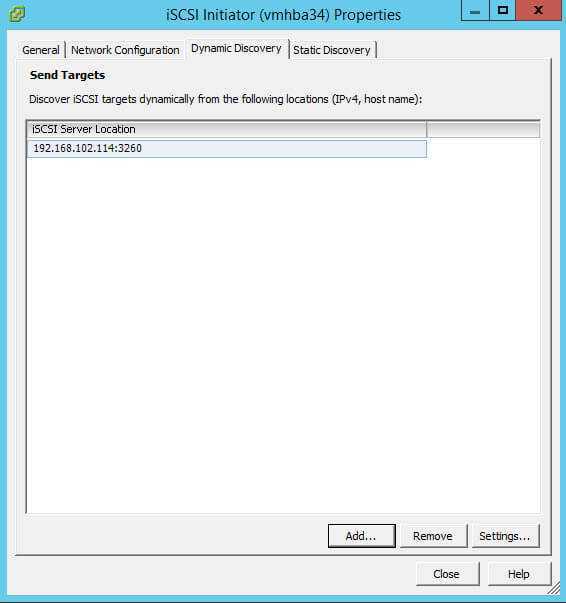

Step 4: After enabling the adapter, you must set up target discovery addresses so that the iSCSI adapter can determine which storage resource on the network is available. Go to the “Dynamic Discovery” tab and click “Add…” to add the data ports’ IP addresses of both controllers. Then go to the “Static Discovery” tab to view the names and IP addresses of these targets.

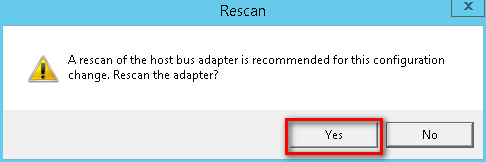

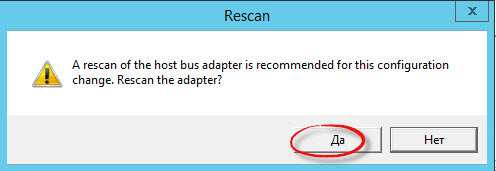

Step 5: Click “Close” to close the Properties window. The “Rescan” window will appear. Click “Yes”.

Note:

If CHAP is enabled in the QES NAS iSCSI Target, you should have the same configuration in “CHAP…” in the “Add Send Target Server” window.

Step 6: You can now find the corresponding iSCSI device for the added iSCSI adapter.

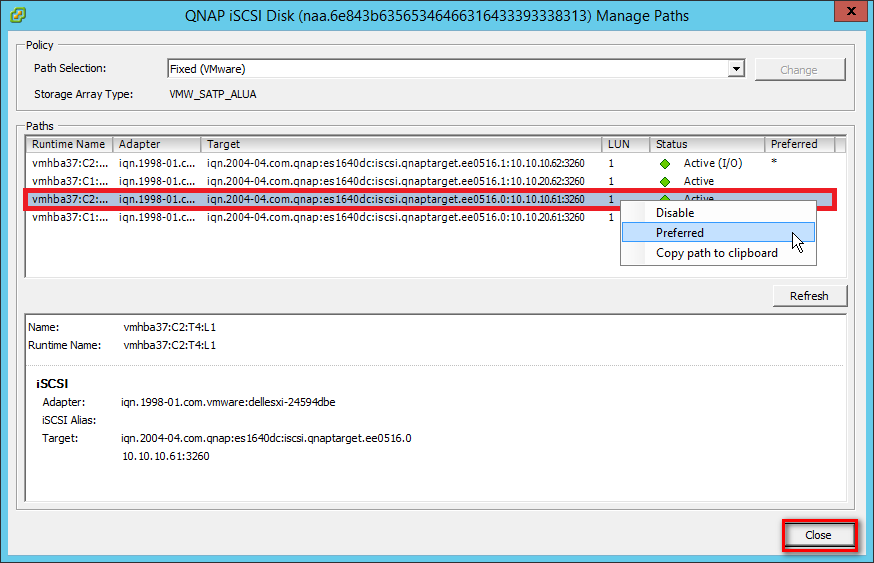

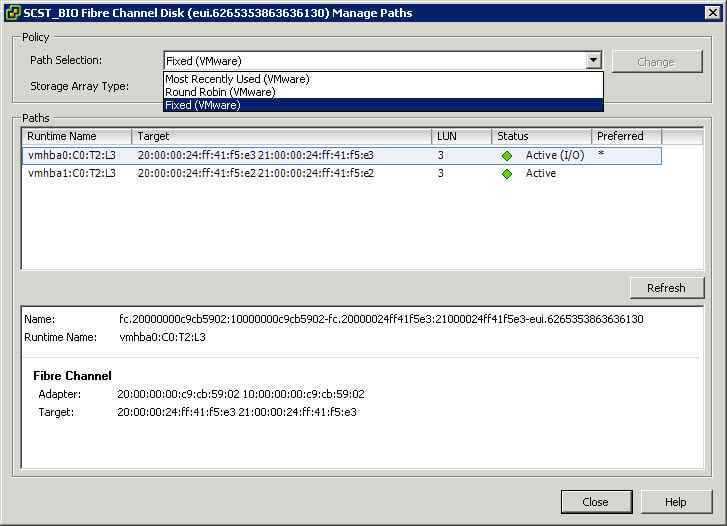

Configure the Path for iSCSI Connection

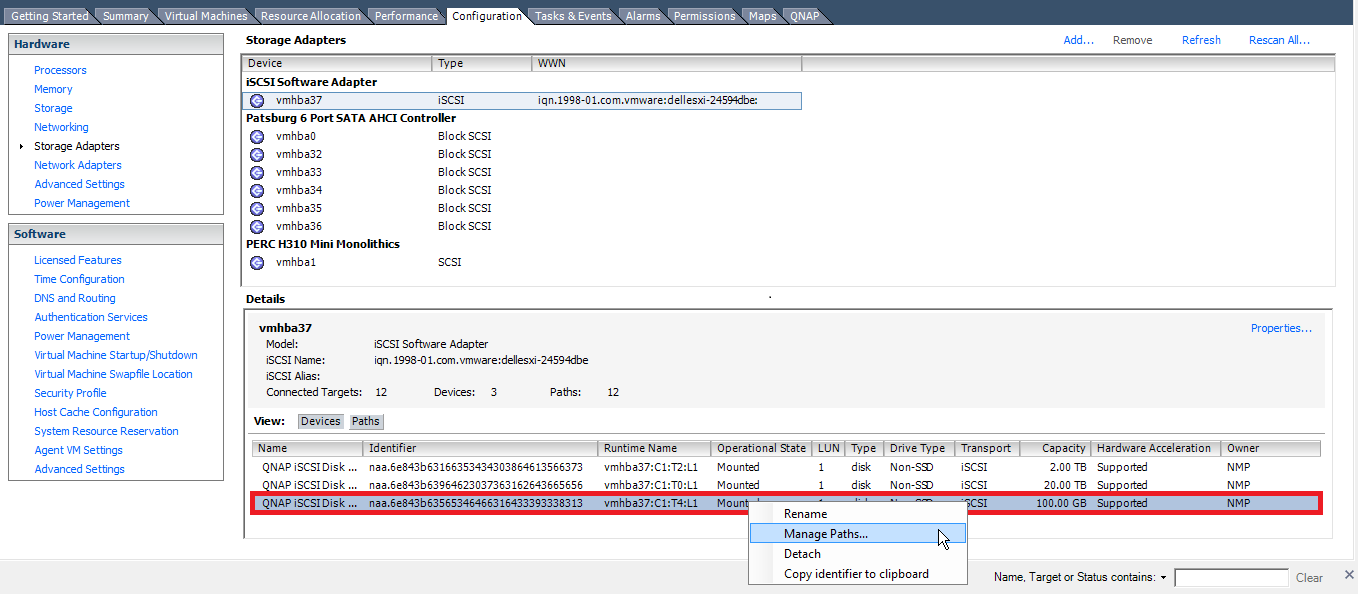

Step 7: Right-click on an iSCSI disk and select “Manage Paths…”

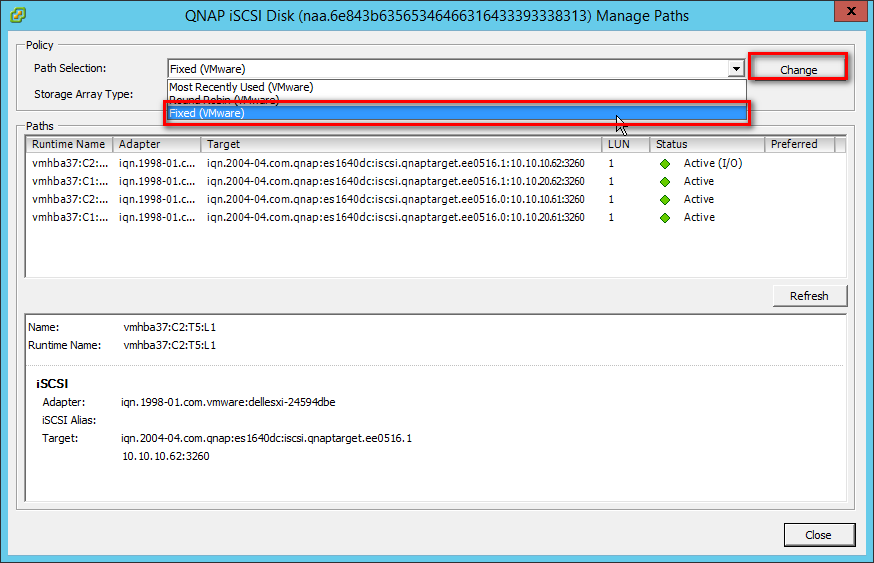

Step 8: Select “Fixed (VMware)” from the “Path Selection” drop-down menu as the path selection policy. Then click “Change” to apply the changes.

Step 9: Specify the preferred path by right-clicking the path you want to assign as the preferred path and select “Preferred”. Then click “OK” to save your settings and exit the dialog box.

Note:

For better iSCSI performance, select the path or Ethernet port which belongs to the Storage Controller that owns the iSCSI LUN. In our example, we chose ports (10.10.10.61/10.10.20.61) which belong to SCA on which Pool 1 was created.

The data port shows below the Target name.

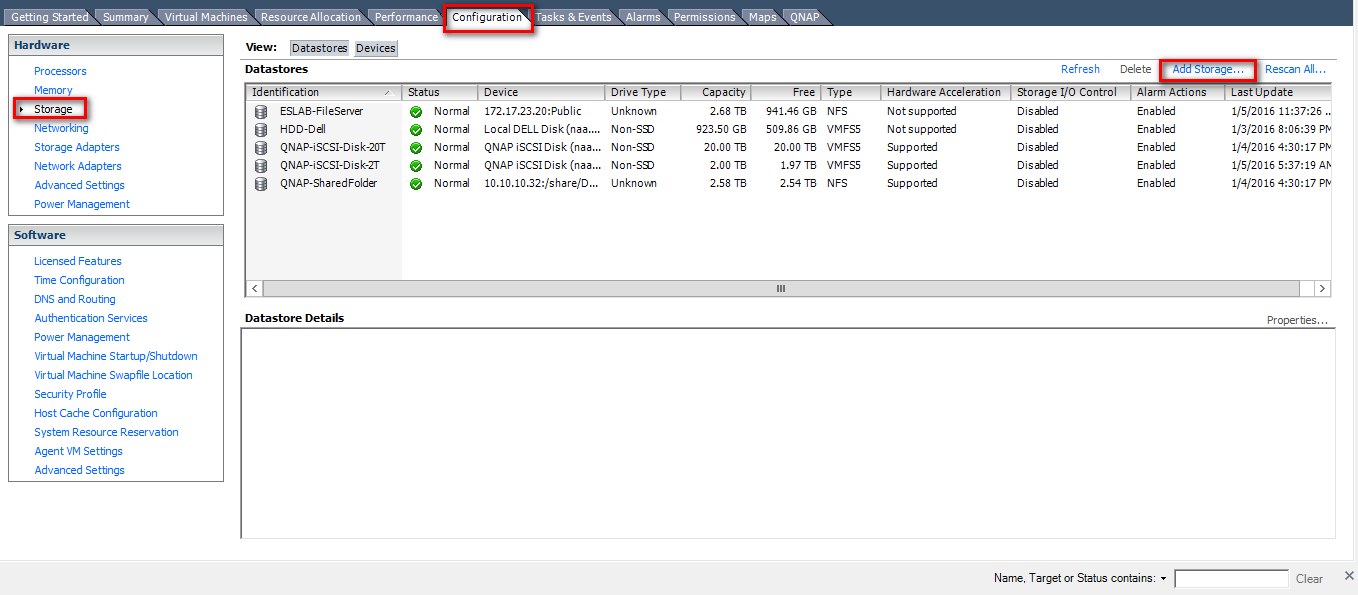

Create a VMFS Datastore in the vSphere Client

Before creating datastores, use the “Rescan” function for the adapters to discover newly added storage devices.

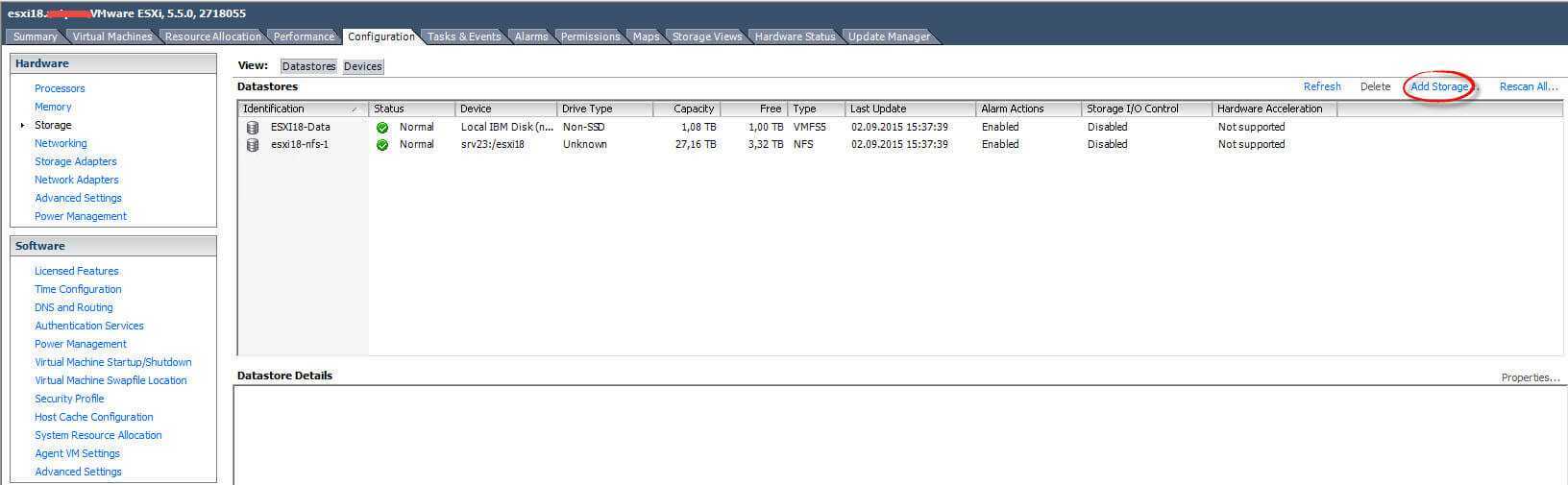

Step 10: Go to the “Configuration” tab and click “Storage” in the Hardware panel. Then click “Datastores” > “Add Storage”.

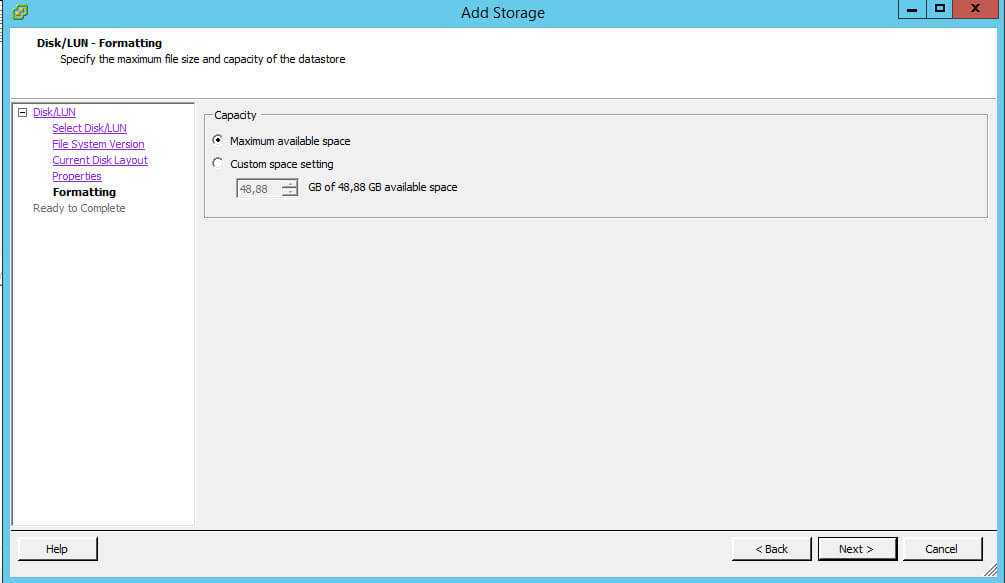

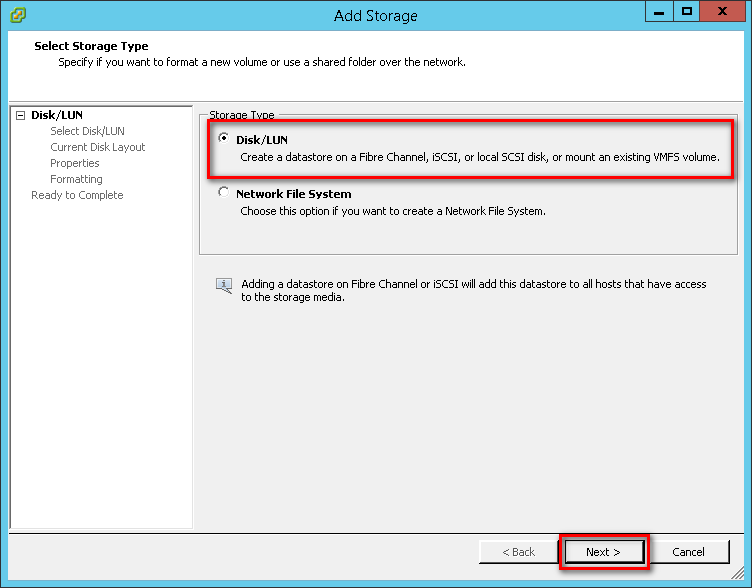

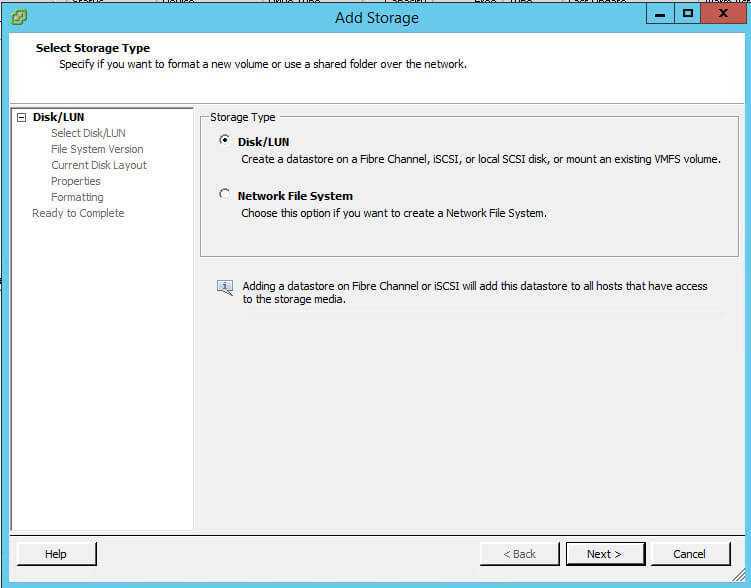

Step 11: Select “Disk/LUN” as the Storage Type and click “Next”.

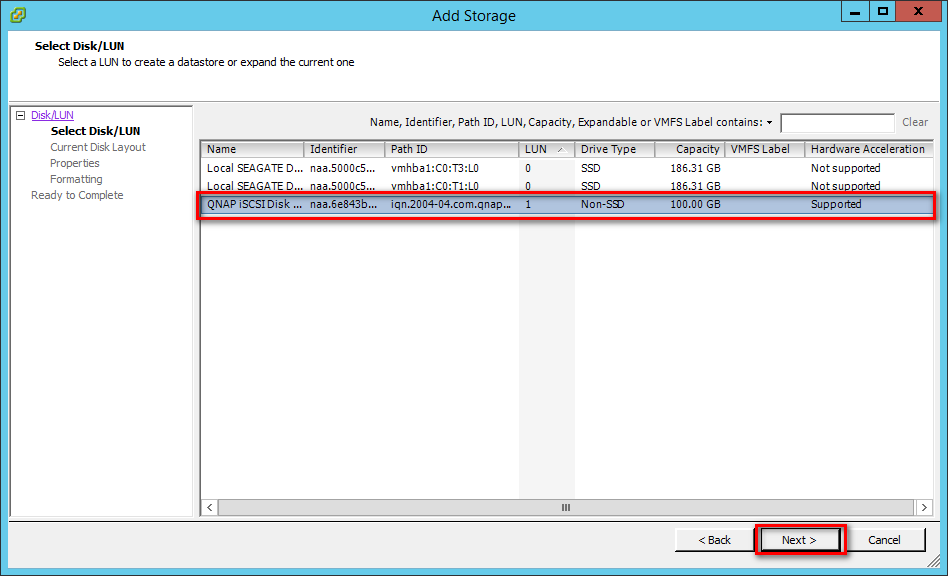

Step 12: Select the iSCSI device to use for your datastore and click “Next”.

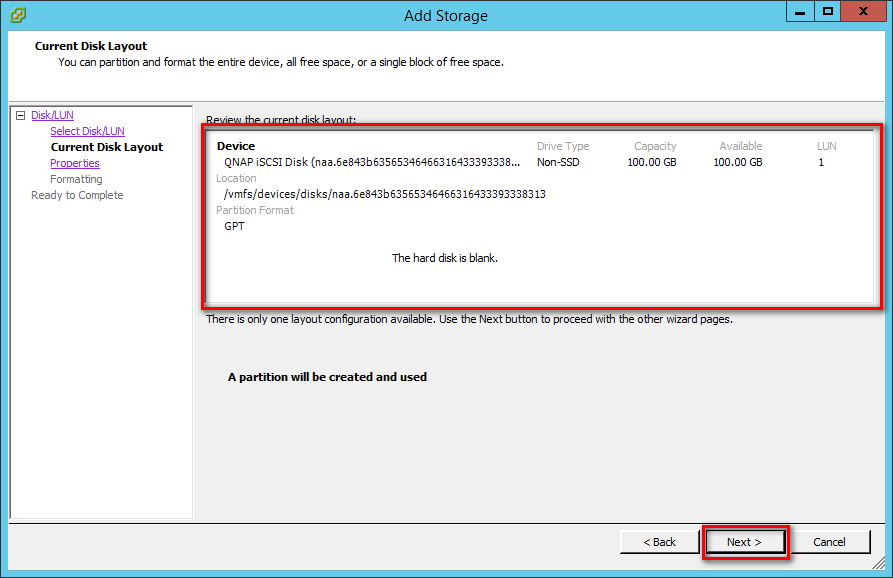

Step 13: The “Current Disk Layout” page presents the information about this iSCSI disk and its space usage. Confirm the settings and click “Next”.

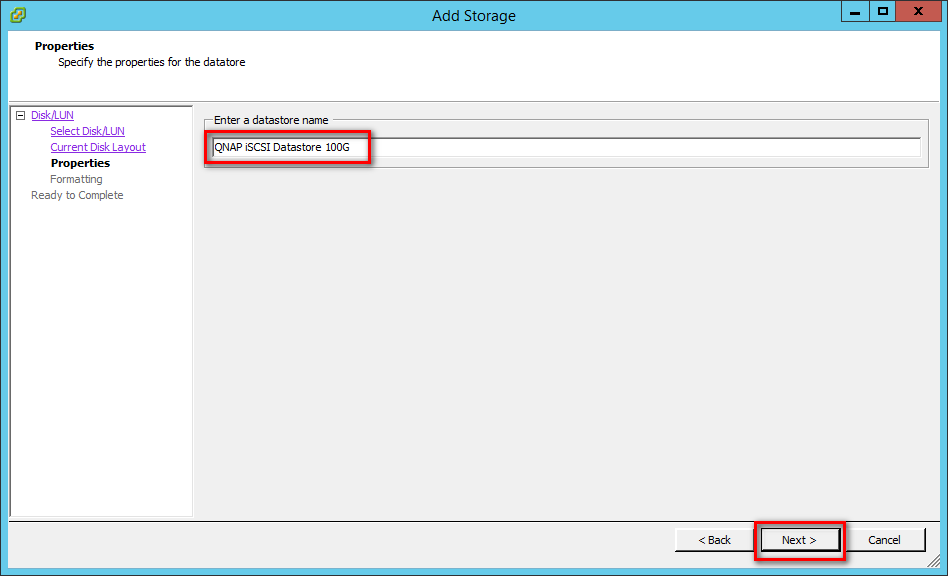

Step 14: Enter a name for the datastore and click “Next”.

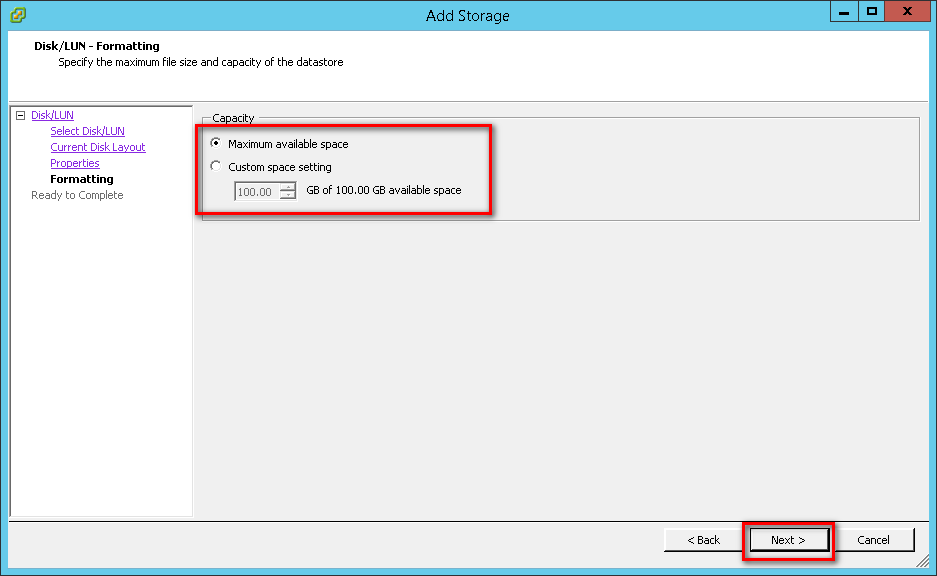

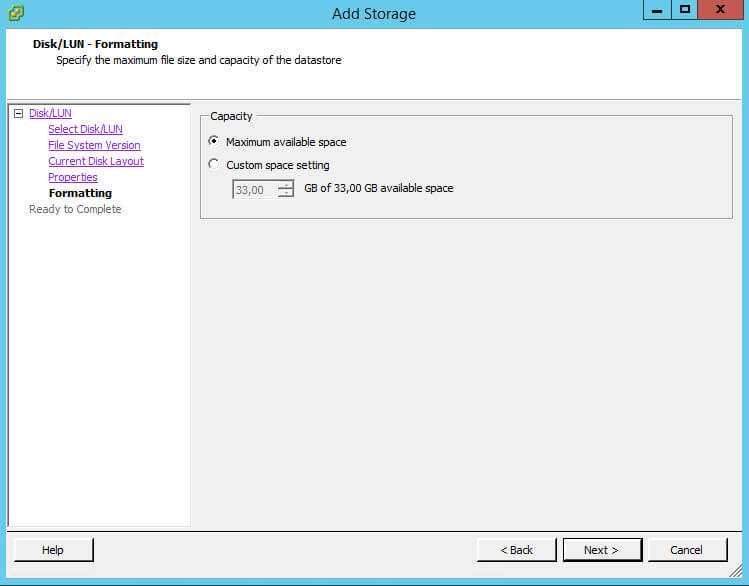

Step 15: Adjust the capacity values and click “Next”. By default, the entire space on the storage device is available.

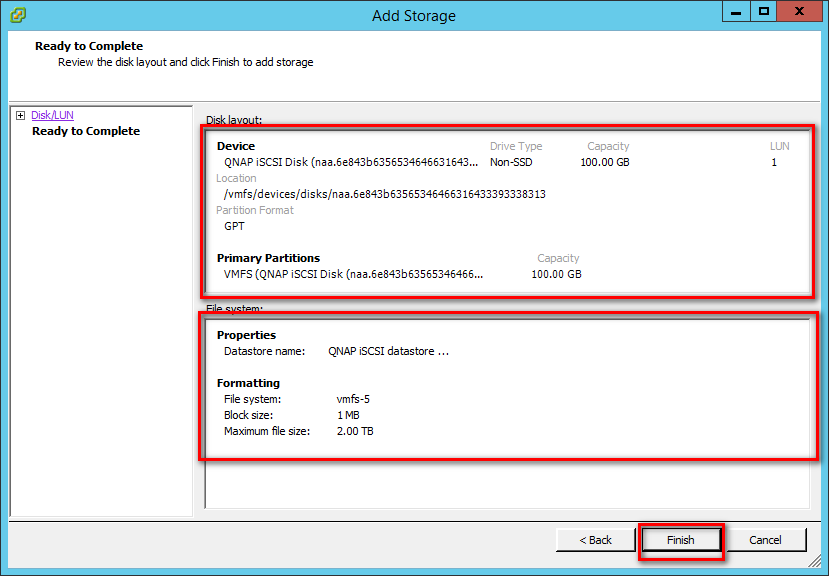

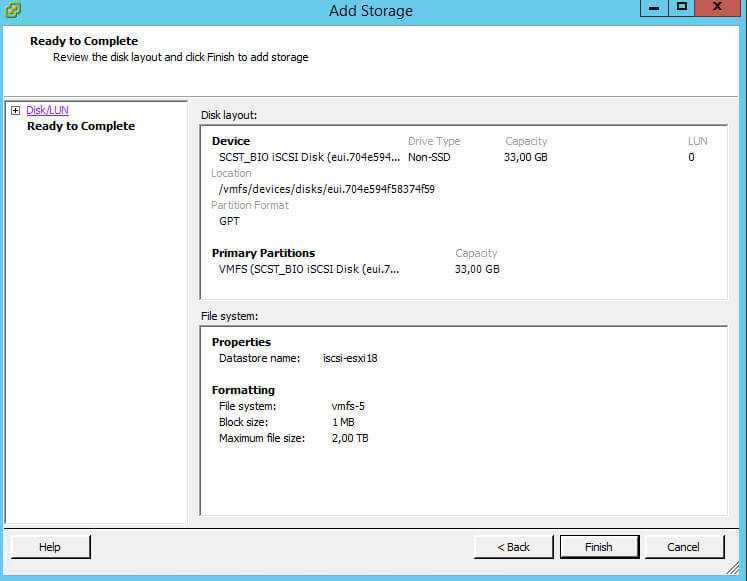

Step 16: Review the datastore configuration information and click “Finish”.

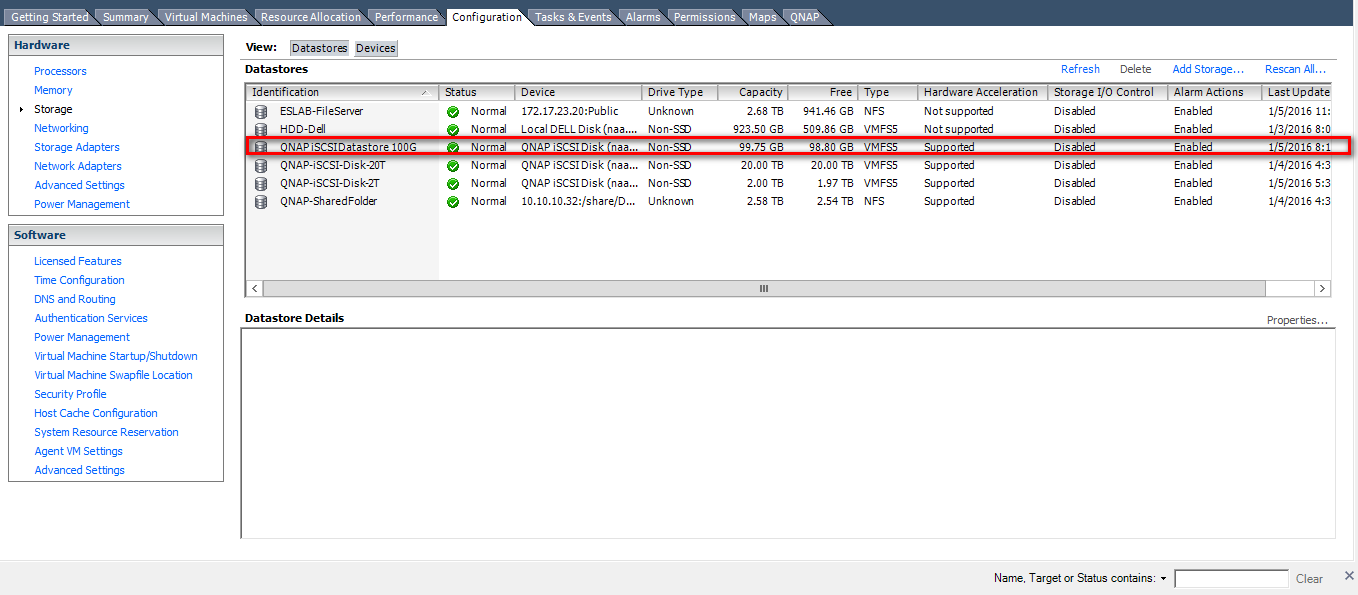

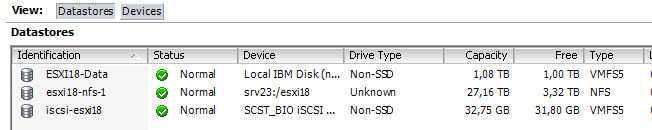

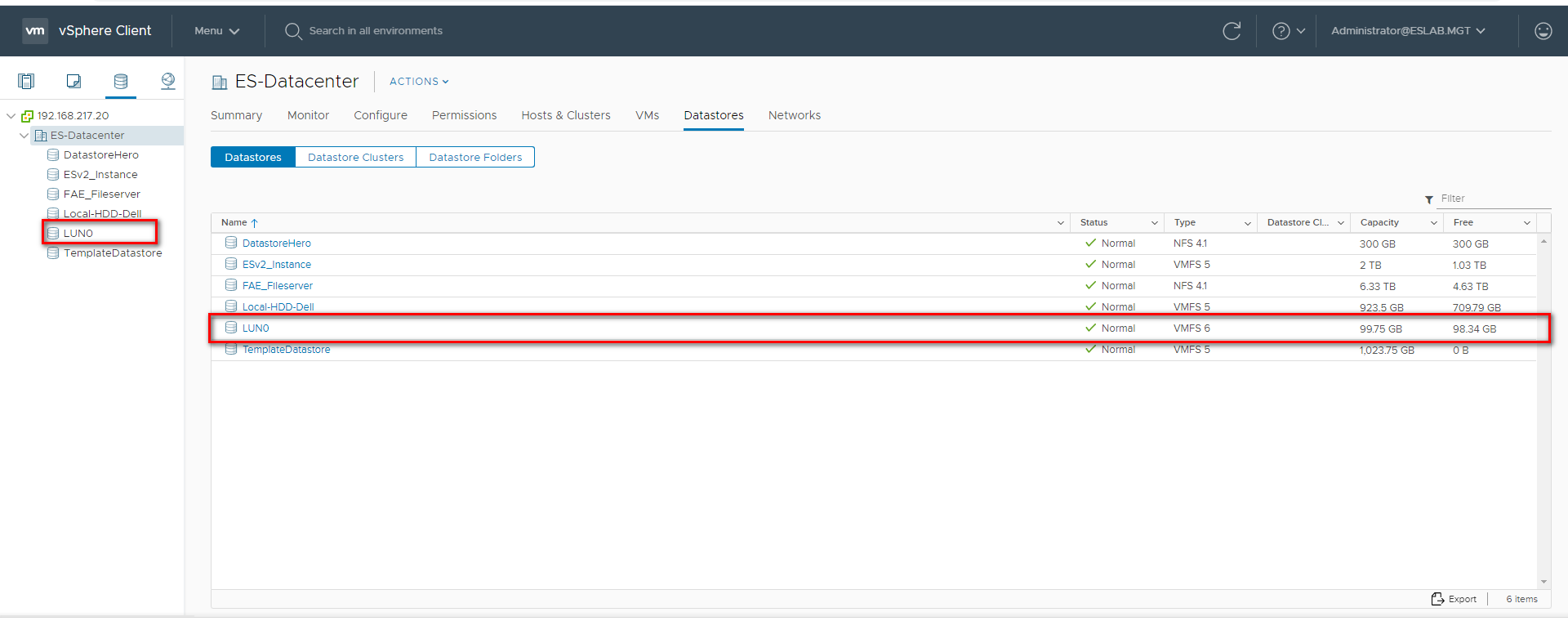

Step 17: The newly-created datastore on the iSCSI-based storage device will be listed.

ISCSI компоненты

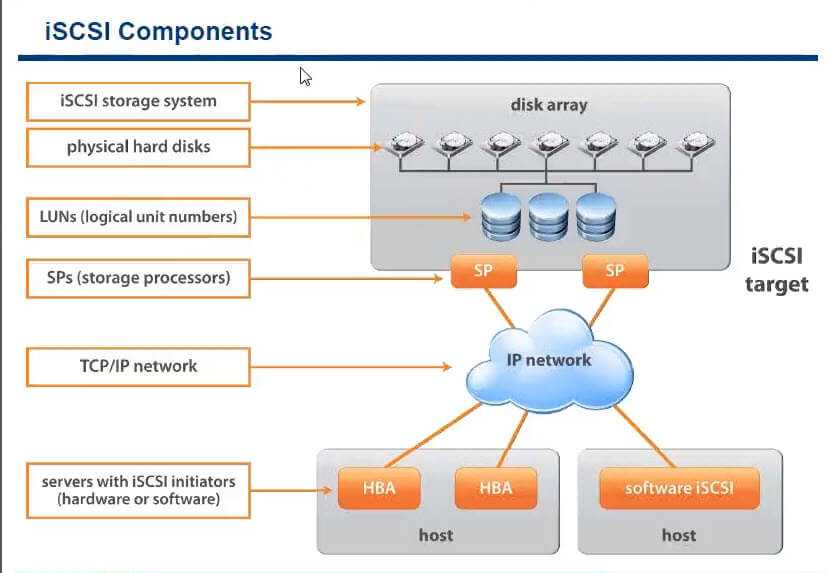

И так ранее я рассказывал как подключить iscsi диск к VMware ESXI 5.5, ознакомьтесь кто хочет попрактиковаться, мы же рассмотрим как это работает

И так есть сервер на котором установлена, не важно какая операционная система, она предоставляет нарезанные луны, нарезанные на физических дисках. У данного сервера есть такой параметр (адрес) ISCSI target, цель к которой мы будем подключаться

Далее по обычной ethernet сети, по TCP/IP, хост с гипервизором, подключается к ISCSI targe, за счет ISCSI Initiators (софтового или железного о них ниже). В итоге хост получает нужные ему lun, форматирует их и все.

Преимущества и недостатки ISCSI

- Легкость внедрения, данная технология уже легко идет в коробке с Windows Server 2008 R2 и выше, просто компонент, настроил и забыл

- Очень дешево, не нужно ничего кроме сетевой карты

- Не нужно ничего докупать

- Расстояние подключения, довольно высокое, хоть в соседний город, но будет скорость зависимая от интернета конечно, оптике проигрывает на порядок.

- Из недостатков, скорость, ограниченная сетевой картой и скоростью коммутатора, хотя есть возможность на нем настроить LACP да и на самом target, тоже можно сделать nic teeaming, за счет чего увеличить пропускную способность

- соединение не совсем надежное, если нет дублирования конечно

- нагрузка на вычислительные мощности процессора

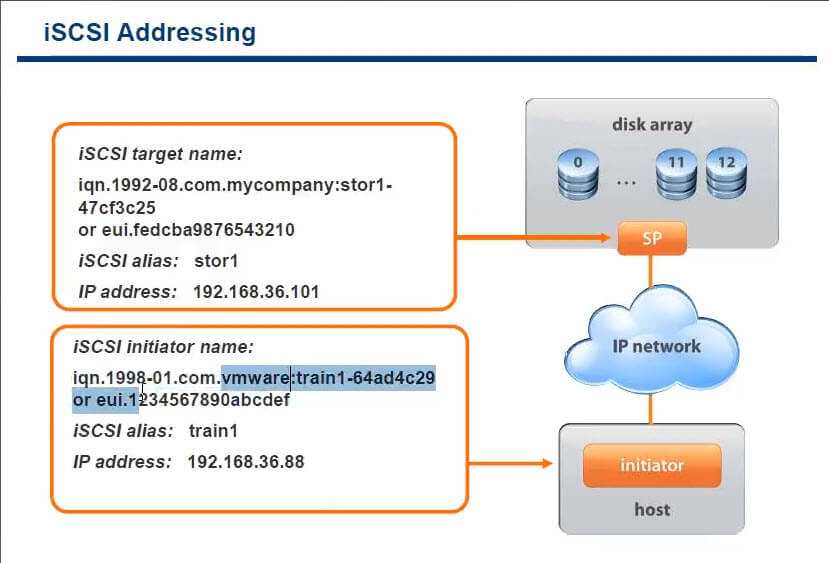

В качестве адресации в ISCSI taget или ISCSI initiator, используются аля wwn, под названием IQN. IQN это уникальный идентификатор устройства в рамках ISCSI сети.

так же можно организовать и по mac адресам и по ip адресам.

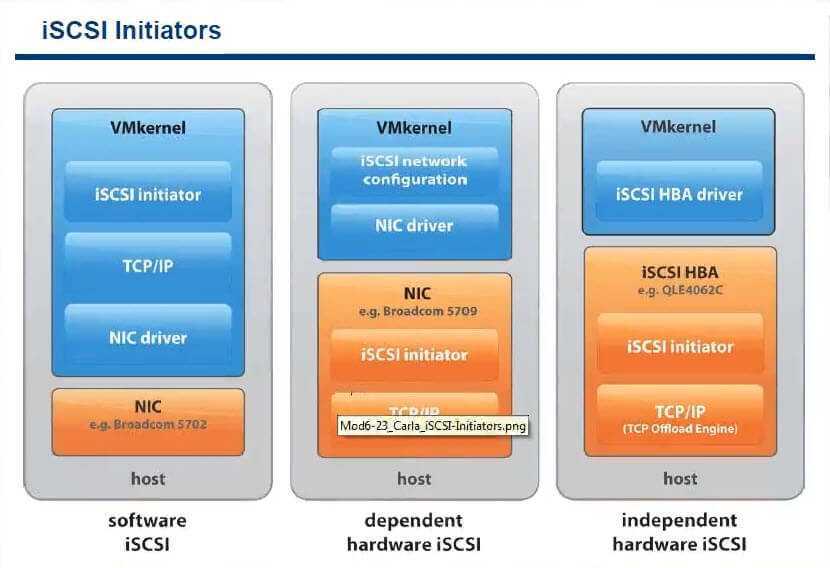

Виды ISCSI initiators

- Софтовые идут в комплекте ESXI или Windows например

- Физические зависимые > тут инкапсуляция и обработка трафика делается карточкой, но все равно используется процессор

- Физические не зависимые > тут весь ISCSI трафик обрабатывается за счет мощностей железки, тем самым снимая нагрузку с CPU.

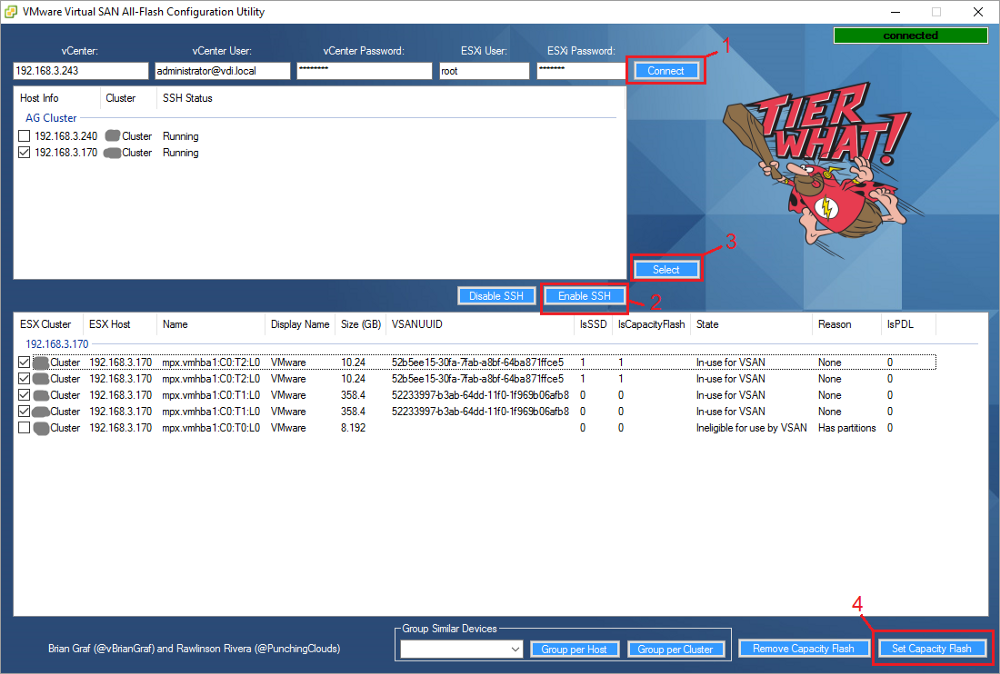

Использование Virtual SAN All-Flash Configuration Utility.

Подключение по SSH к каждому из хостов ESXi, или vSAN Appliance помогает выявить проблемы с типом накопителей, а так же понять логику работы. Однако управление несколькими хостами удобней осуществлять из VMware Virtual SAN All-Flash Configuration Utility, которую можно скачать по прямой ссылке.

Рис. 7. Virtual SAN All-Flash Configuration Utility.

Для работы утилиты требуется:

- PowerShell 2.0.

- vSphere PowerCLI 5.5, или выше.

- Интернет соединение для скачивания plink.exe (вручную создать папку c:\temp).

- ESX(i)-хосты с одинаковым паролем.

Скачиваем, запускаем, указываем логин/пароль, выбираем хосты, выбираем диски и конфигурируем (рис. 7).

Как подключить ISCSI диск с Open-e 7 в VMware ESXI 5.5 через vsphere client

Теперь идем в vmware vsphere на ваш ESXI хост в раздел Configuration-Storage Adapters

Как создать и подключить ISCSI диск с Open-e 7 в VMware ESXI 5.5-11

щелкаем правым кликом по нашему адаптеру и выбираем properties

Как создать и подключить ISCSI диск с Open-e 7 в VMware ESXI 5.5-12

Переходим в пункт Dynamic Discovery и жмем Add. В открывшемся окне заполняем ISCSI Server вашим ip адресом сервера. при желании можно ввести данные CHAP.

Как создать и подключить ISCSI диск с Open-e 7 в VMware ESXI 5.5-13

Все сервер мы добавили, и теперь сможем подключить iscsi диск.

Как создать и подключить ISCSI диск с Open-e 7 в VMware ESXI 5.5-14

Вас попросят сделать пересканирование, жмем yes.

Как создать и подключить ISCSI диск с Open-e 7 в VMware ESXI 5.5-15

теперь в vsphere client идем в Configuration-Storage и жмем Add storage, чтобы начать подключение диска iscsi

Как создать и подключить ISCSI диск с Open-e 7 в VMware ESXI 5.5-16

выбираем Disk/LUN

Как создать и подключить ISCSI диск с Open-e 7 в VMware ESXI 5.5-17

next

Как создать и подключить ISCSI диск с Open-e 7 в VMware ESXI 5.5-21

Finish.

Как создать и подключить ISCSI диск с Open-e 7 в VMware ESXI 5.5-22

Все видим, наш iscsi диск успешно добавлен

Как создать и подключить ISCSI диск с Open-e 7 в VMware ESXI 5.5-23

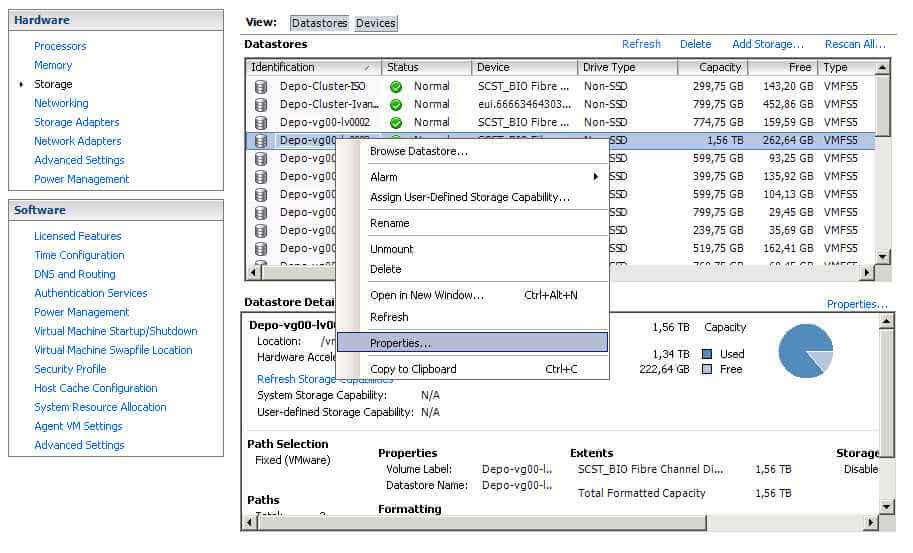

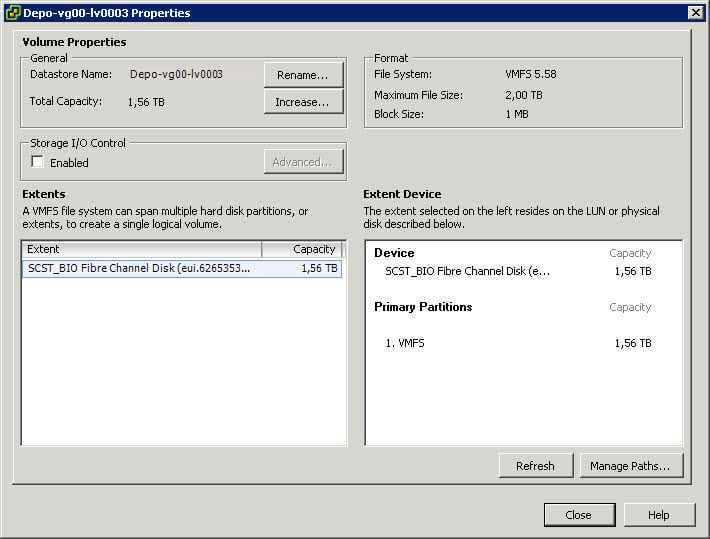

Как посмотреть пути к лунам в VMware ESXI 5.x в графическом режиме

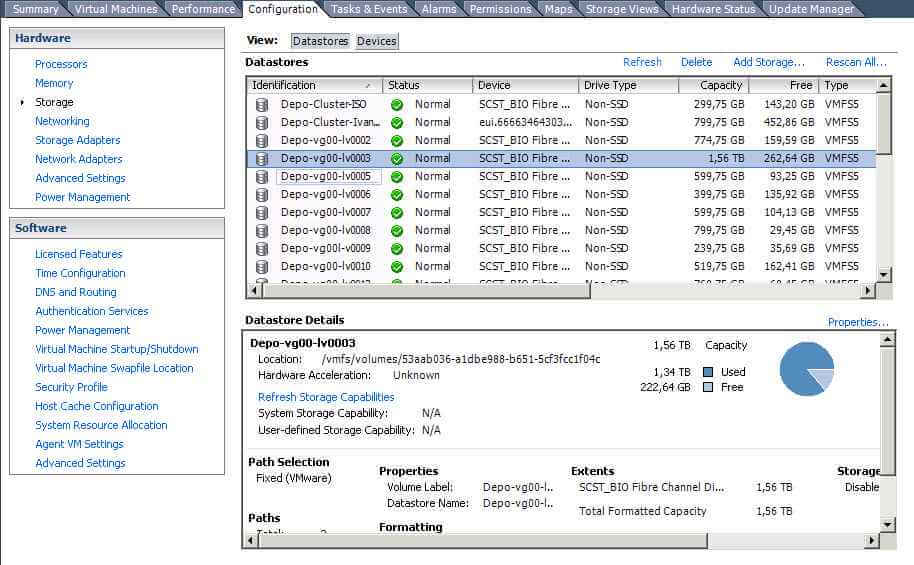

Заходим на ваш ESXI. Переходим в меню-Configuration-Storage. Выбираем нужный лун.

Как посмотреть пути к лунам в VMware ESXI 5.x.x (Графически и с помощью esxcfg-mpath)-01

Щелкаем правым кликом и выбираем Properies.

Как посмотреть пути к лунам в VMware ESXI 5.x.x (Графически и с помощью esxcfg-mpath)-02

Жмем кнопку Manage Paths

Как посмотреть пути к лунам в VMware ESXI 5.x.x (Графически и с помощью esxcfg-mpath)-03

Видим что в данный момент есть два пути оба Active. Выставлен режим Fixed.

Как посмотреть пути к лунам в VMware ESXI 5.x.x (Графически и с помощью esxcfg-mpath)-04

Безусловно, для обеспечения отказоустойчивости решения необходимо проектировать SAN-сеть с множественными путями доступа. VMware Infrastructure обладает встроенными средствами мультипасинга, что делает ненужным приобретение дополнительного ПО. VMware предлагает выбор из двух видов мультипасинга – фиксированный «Fixed» и MRU (Most Recently Used). Первый из них отличается тем, что основной путь является приоритетным и, в случае падения основного пути, после его восстановления система автоматически возвращается к использованию приоритетного пути. В случае применения MRU, возврата не происходит и новый путь становится новым «Most Recently Used». В общем случае для массивов, контроллеры которых работают в режиме active\active, рекомендуется использовать режим «Fixed» и назначать активные пути вручную, распределяя нагрузку между контроллерами. Для массивов же, контроллеры которых работают в режиме active\passive, лучше использовать «Most recently used» режим.

For VMware vSphere Web Client HTML5

Server and Storage Network Settings

|

Server Network Settings |

||

|---|---|---|

|

Role |

IP |

Description |

|

ESXi host |

192.168.217.2 |

VMware ESXi host |

|

Data Network 1 |

10.30.10.2 |

10G Data port 1 in ESXi host |

|

Data Network 2 |

10.40.20.2 |

10G Data port 2 in ESXi host |

|

Storage Network Settings |

||

|---|---|---|

|

Setting |

Value |

Description |

|

SCA Management IP |

192.168.217.41 |

Management IP of controller A |

|

SCA Ethernet1 IP |

10.30.10.41 |

Data port 1 IP of controller A |

|

SCA Ethernet2 IP |

10.40.10.41 |

Data port 2 IP of controller A |

|

SCB Management IP |

192.168.217.42 |

Management IP of controller B |

|

SCB Ethernet1 IP |

10.30.10.42 |

Data port 1 IP of controller B |

|

SCB Ethernet2 IP |

10.40.10.42 |

Data port 2 IP of controller B |

|

Pool allocate to SCB |

Pool2 |

RAID6 pool at controller B |

With the information listed in the above table, assuming a 100GB LUN is deployed on ES dual controller B (SCB), it can be mounted using the following steps on the ESXi host.

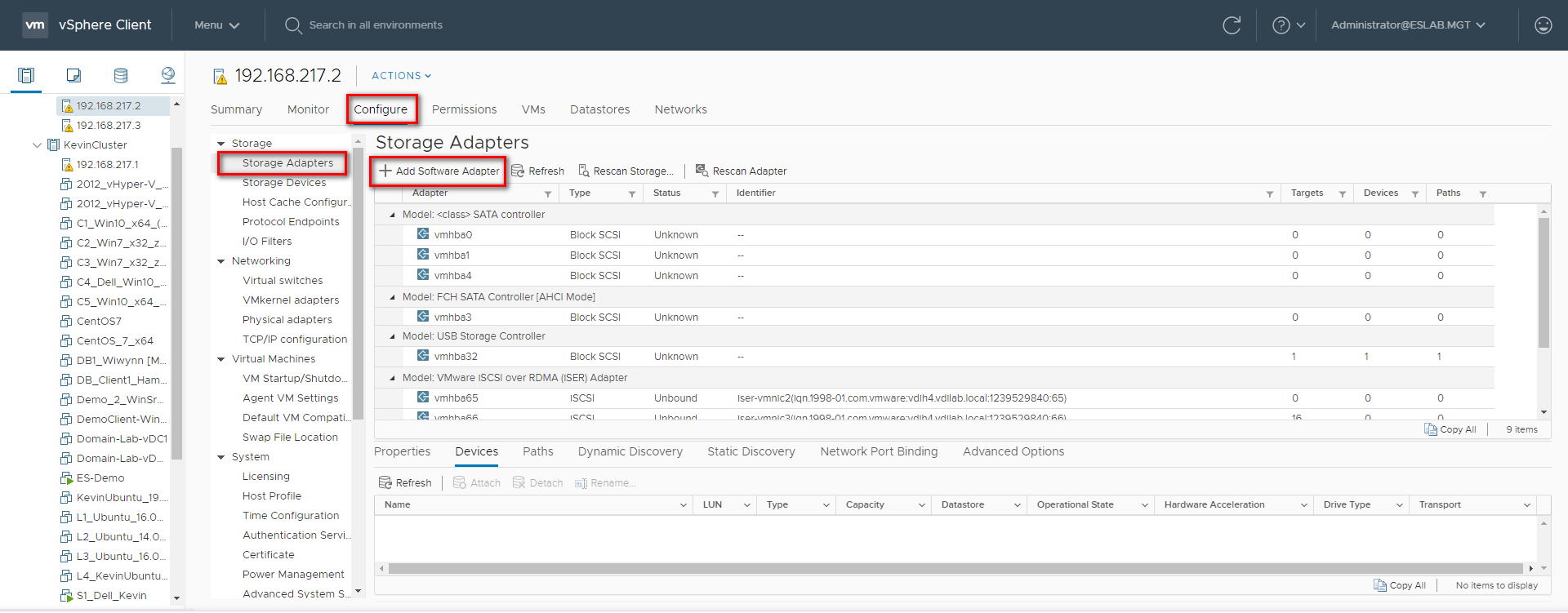

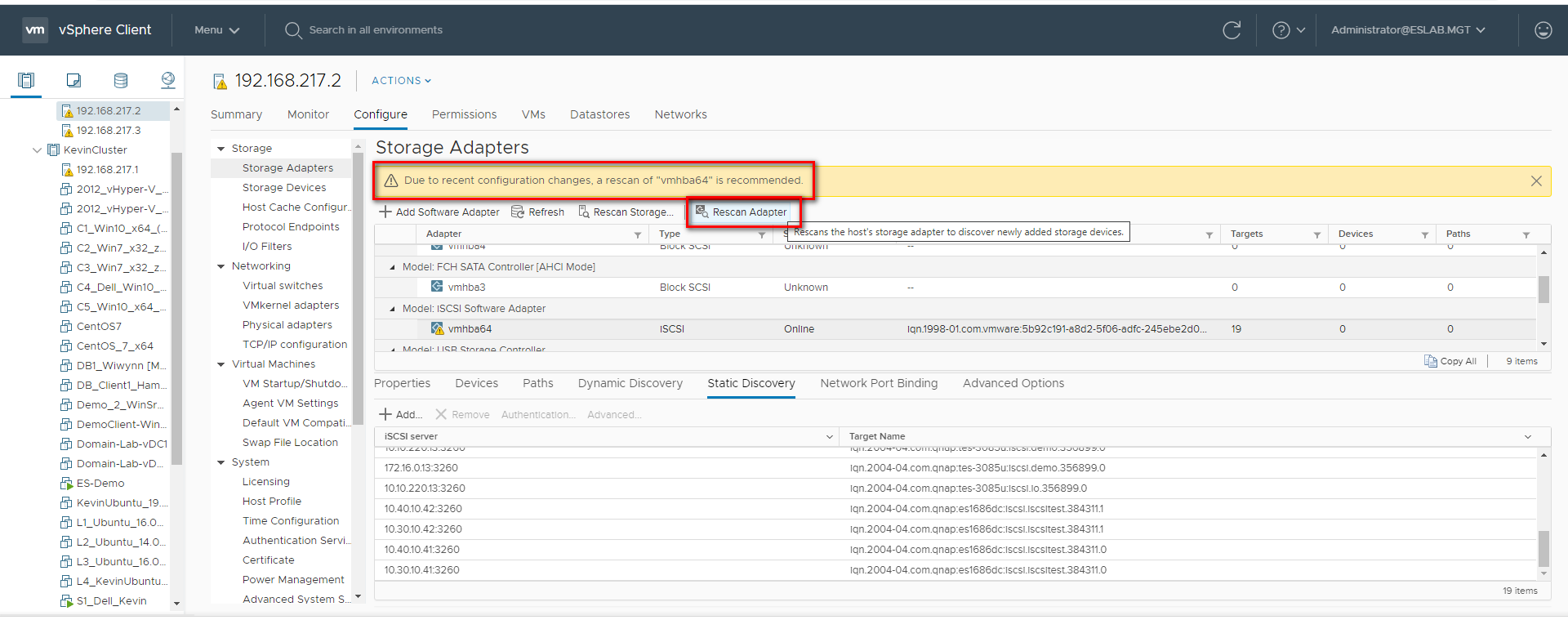

Add iSCSI Targets on VMware ESXi Hosts

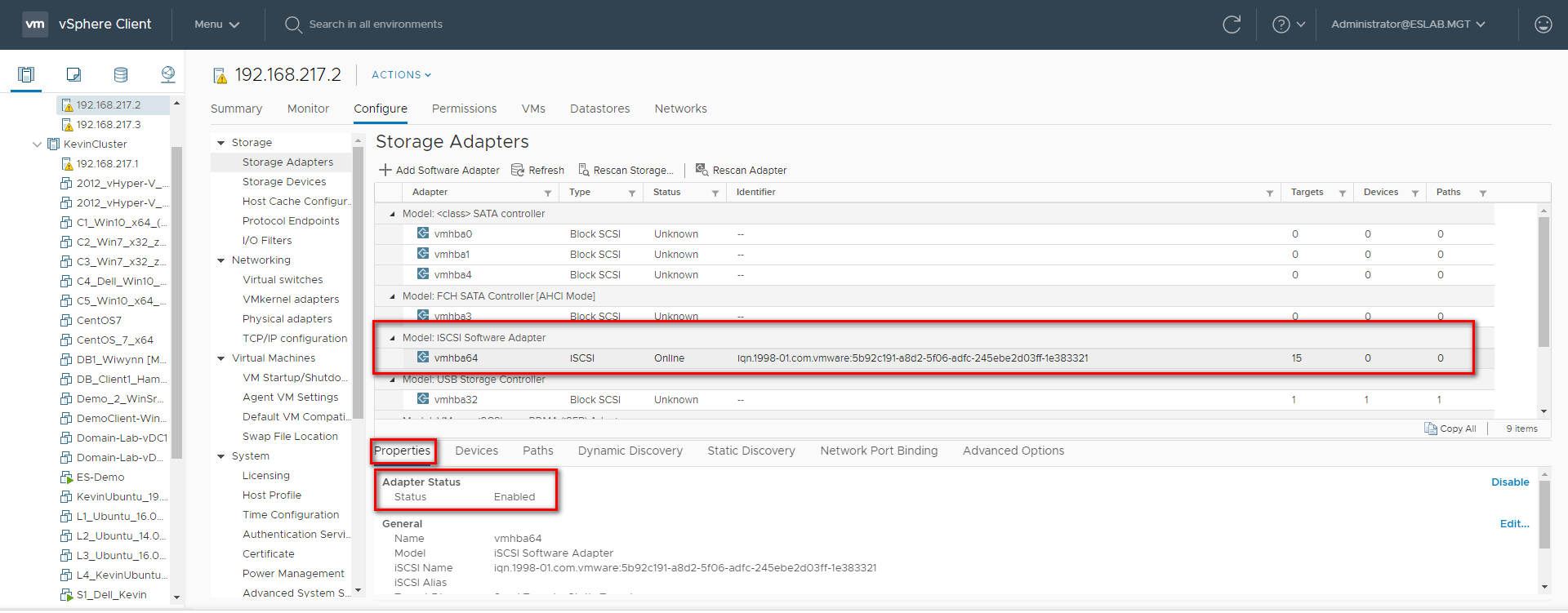

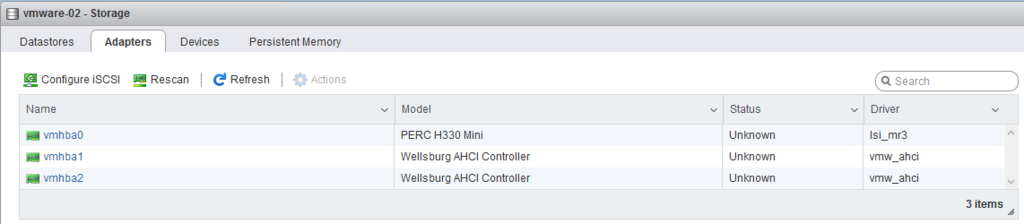

Step 1: Log in to the vSphere Web Client and select a host from the inventory panel. Go to the “Configure” tab and then the “Storage Adapters” tab. Click “+ Add Software Adapter” to add a new storage adapter.

Step 2: A new software iSCSI adapter will be added to the Storage Adapter list. Select the software iSCSI adapter on the list and click “Properties” to ensure the adapter is enabled.

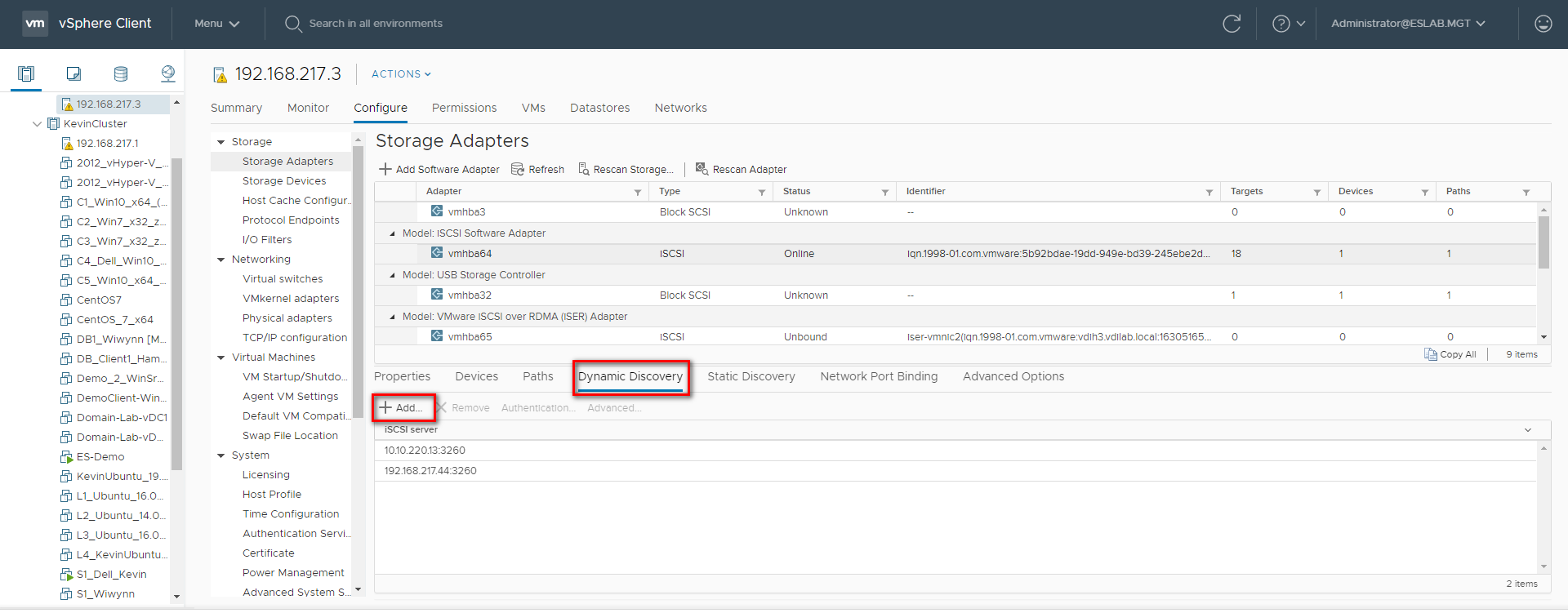

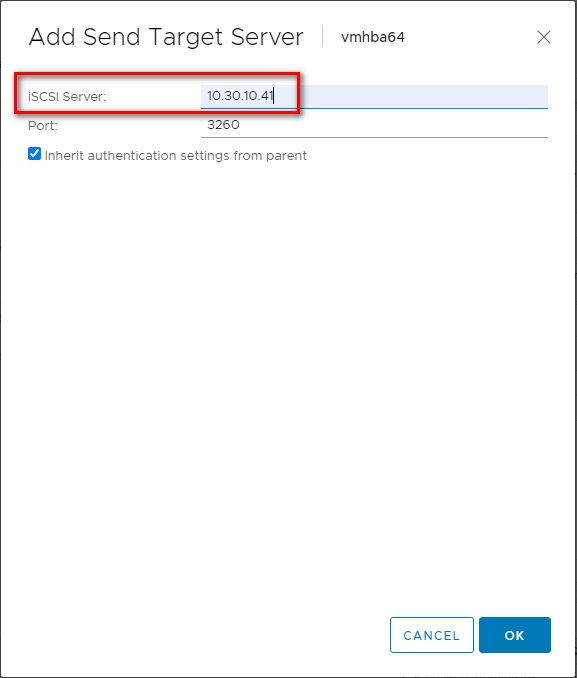

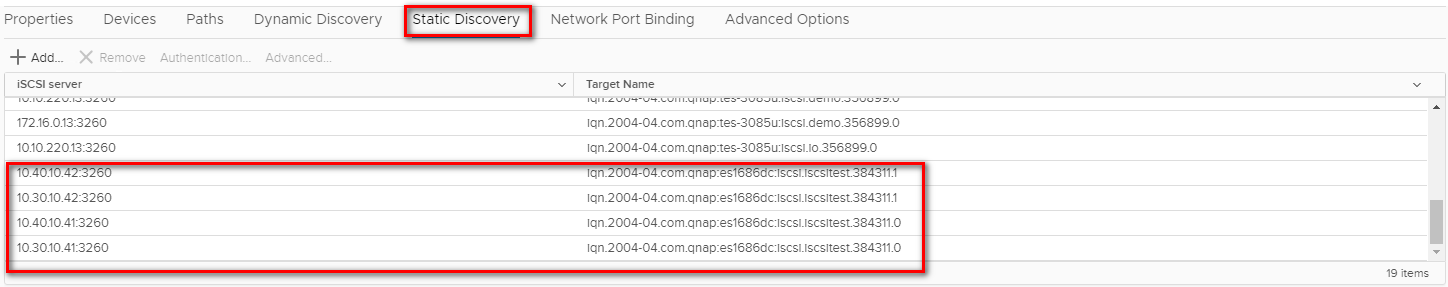

Step 3: Click “Dynamic Discovery” and then click “Add…” to add the data ports’ IP addresses of both controllers. Then go to “Static Discover” tab to view the names and IP addresses of these targets. If you remove a static target added by dynamic discovery, the target might be returned to the list the next time a rescan happens, the HBA is reset, or the host is rebooted.

Step 4: Click “Rescan” to scan the newly added devices.

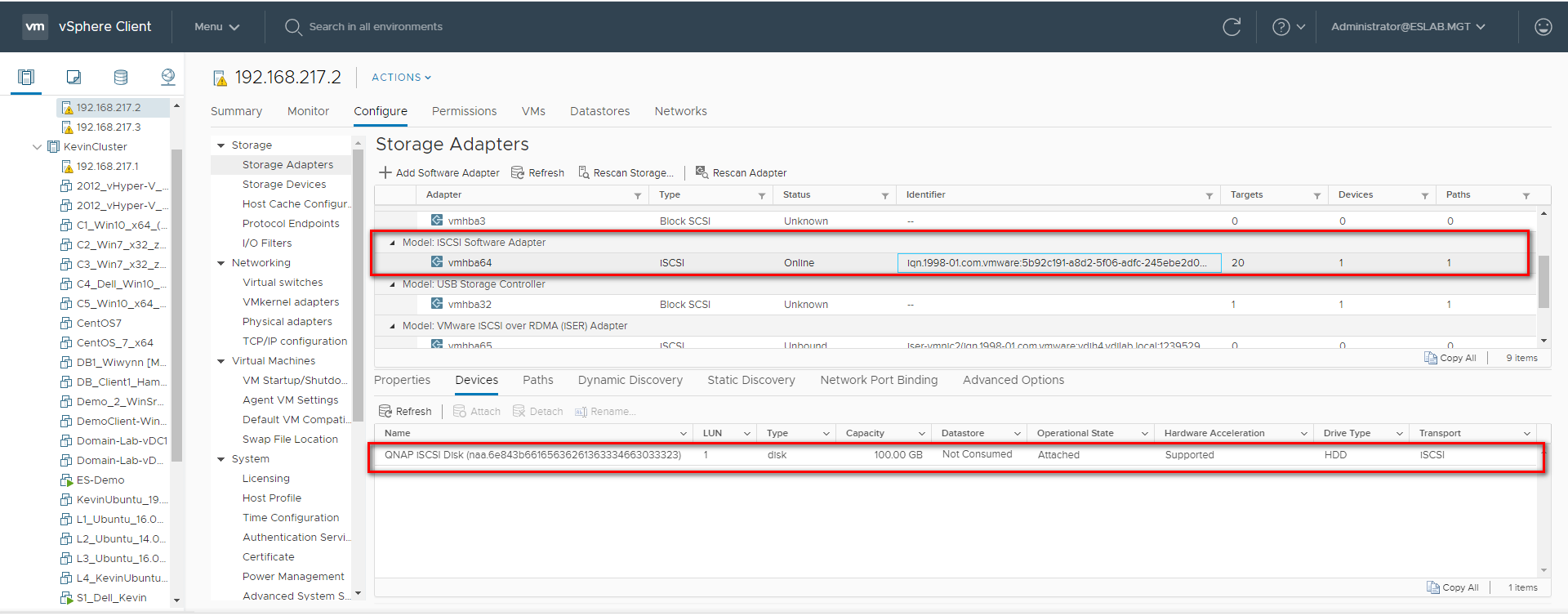

Step 5: You can now find the corresponding iSCSI device for the added iSCSI adapter.

Configure the Path for iSCSI Connection

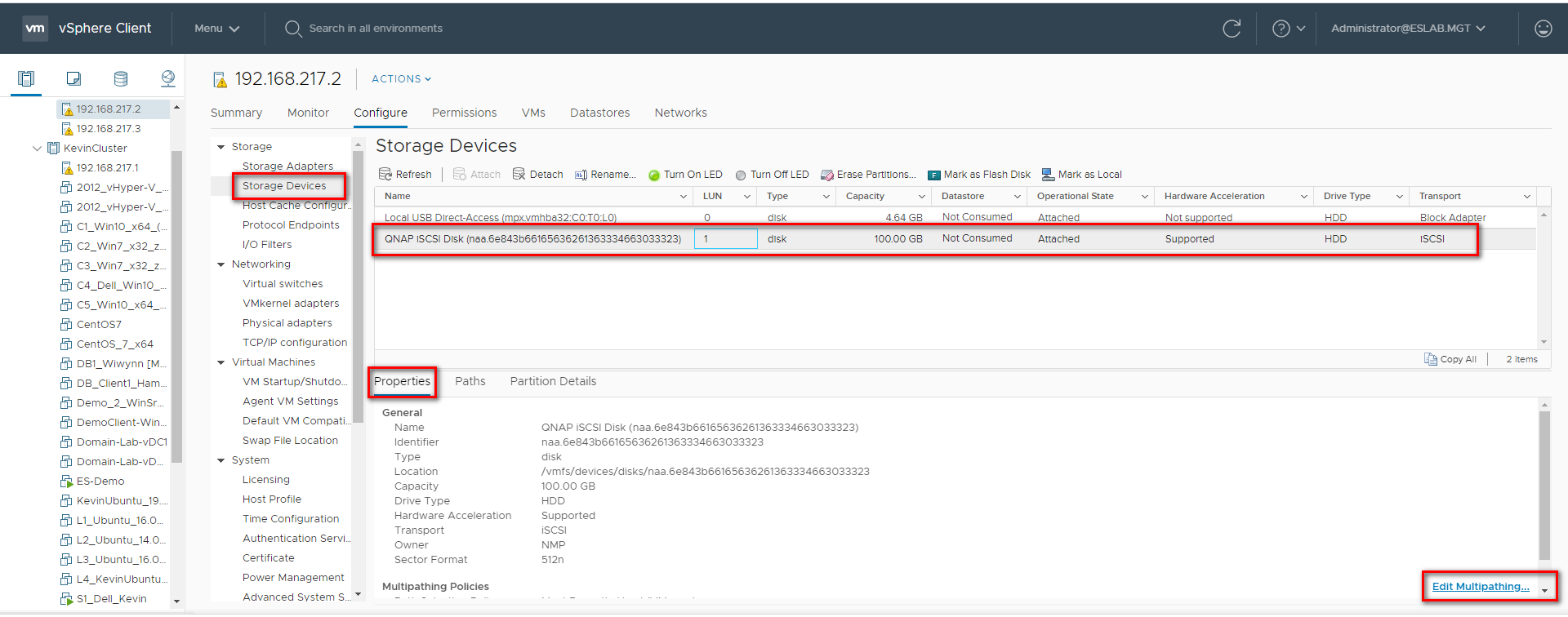

Step 6: Click “Storage Devices”, select the iSCSI Disk, and then click “Properties” > “Edit Multipathing…”

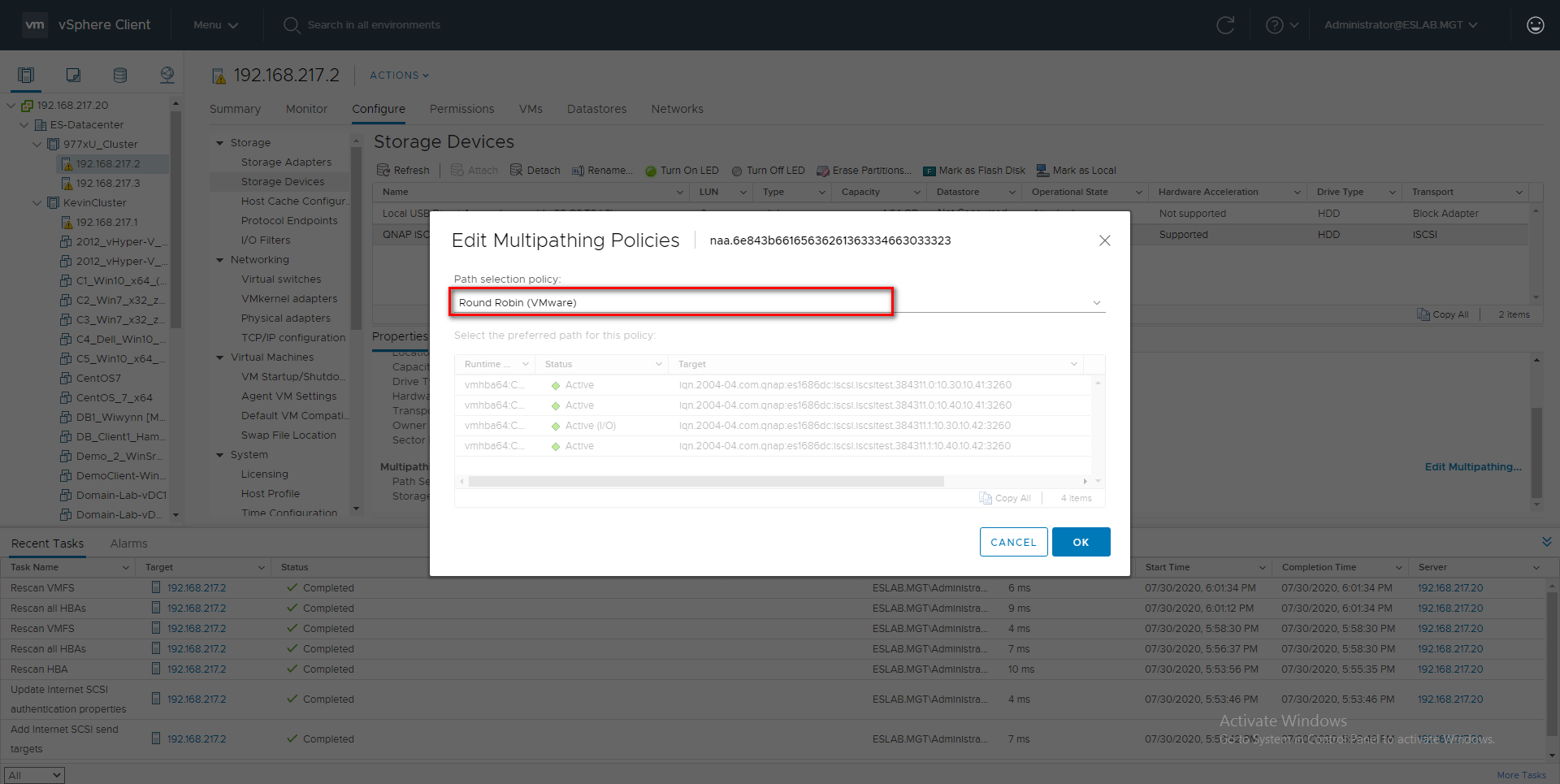

Step 7: Select “Round Robin (VMware)*” in Path selection policy, then select one path as the preferred path and click “OK”.

Reference:

*https://storagehub.vmware.com/t/vsphere-6-7-core-storage-1/vsphere-6-7-u1-enhanced-round-robin-load-balancing/

Create a VMFS Datastore in the vSphere Client

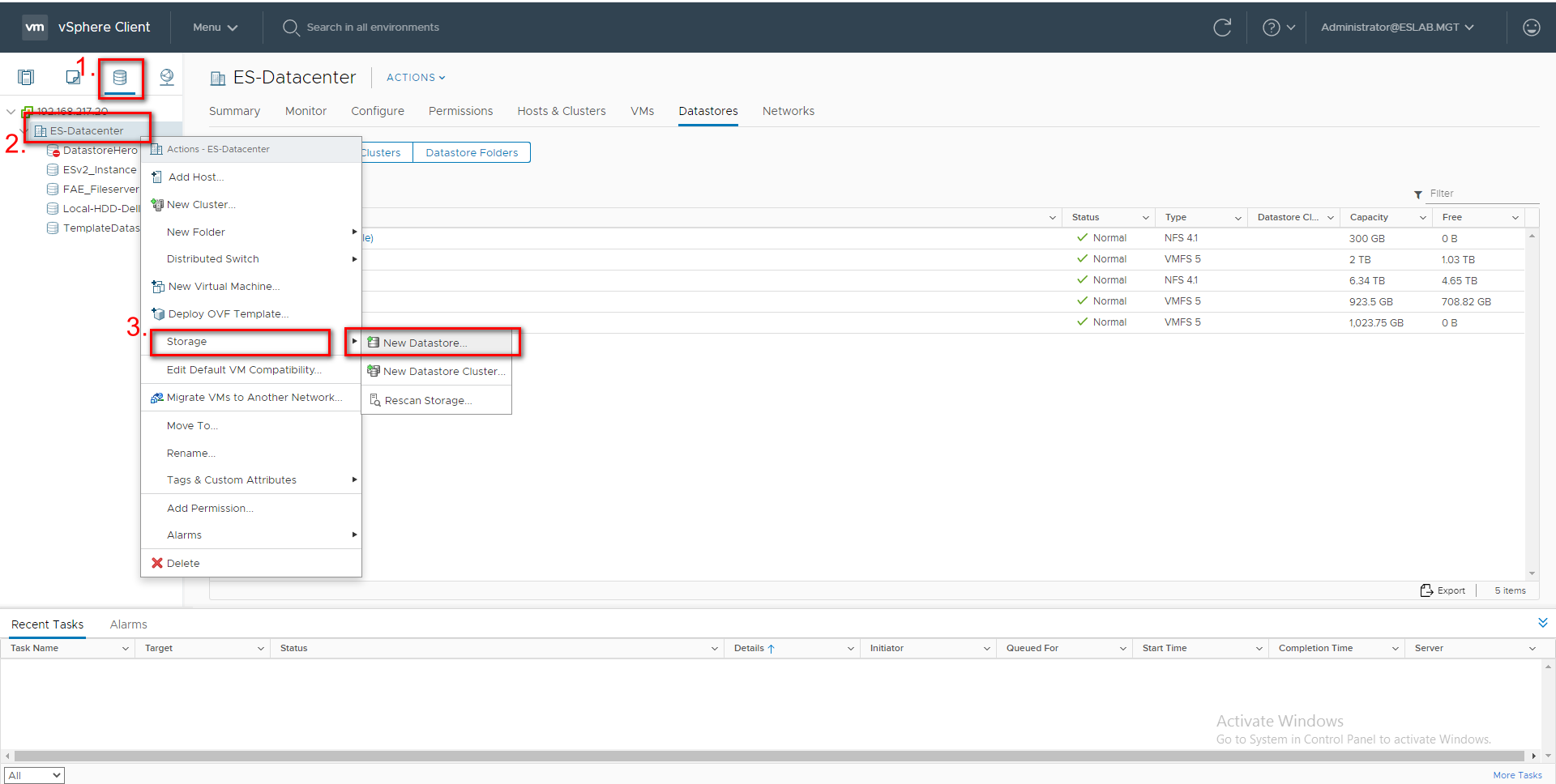

Step 8: Go to the “Storage” tab and right click on the Datacenter. Select “Storage” > “New Datastore…”.

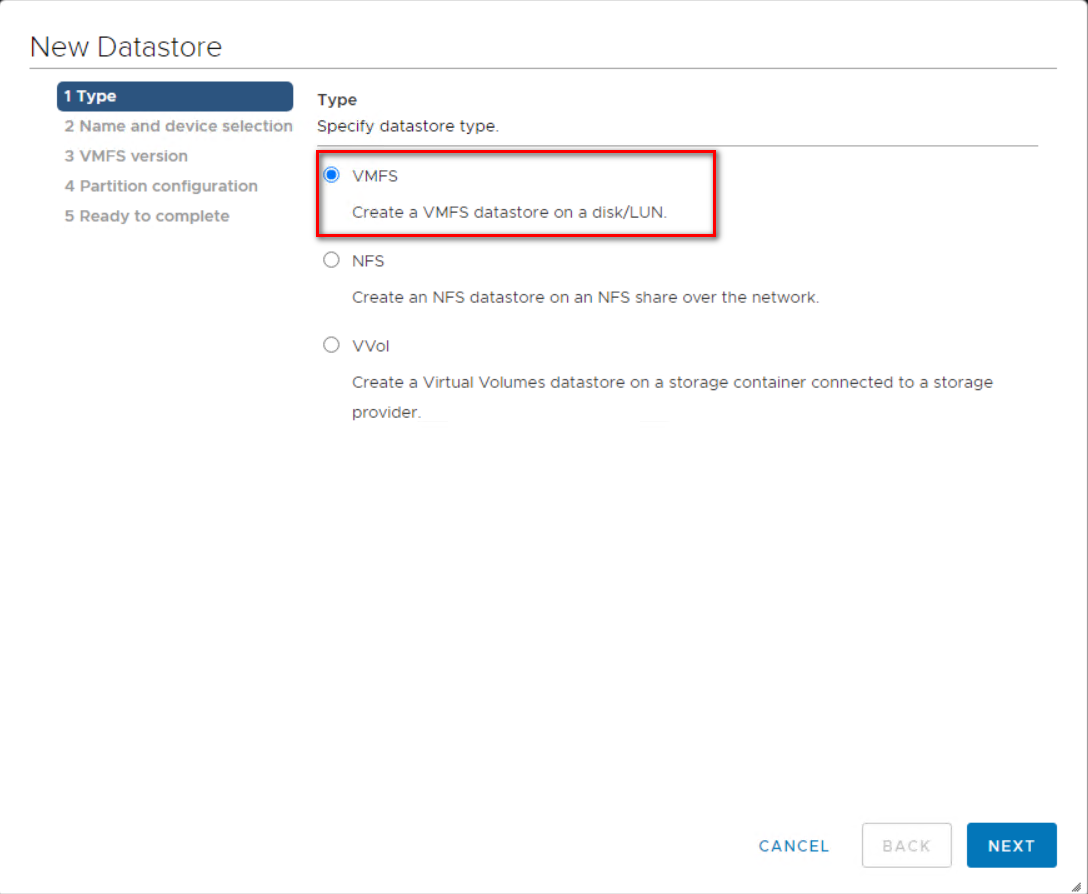

Step 9: Select “VMFS” as the Type and click “Next”

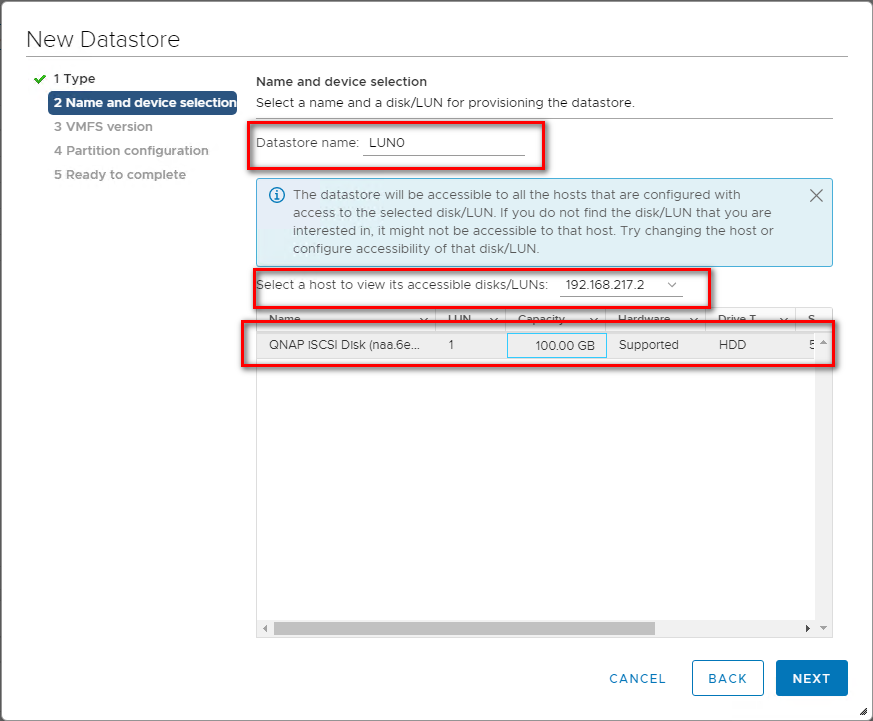

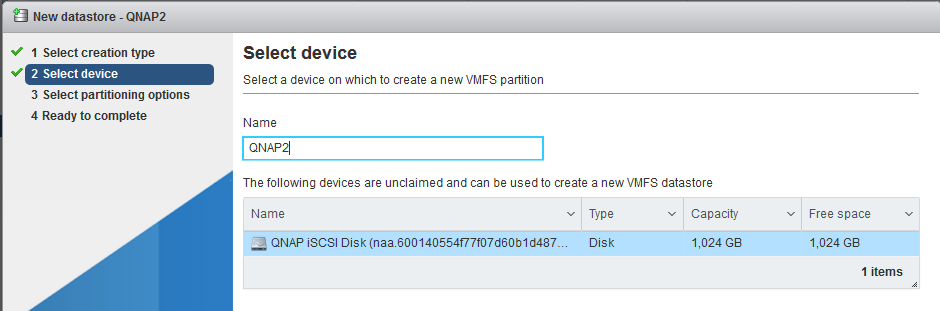

Step 10: Enter a name for the datastore, select a host, and select the iSCSI device to use for your datastore.

Click “Next”.

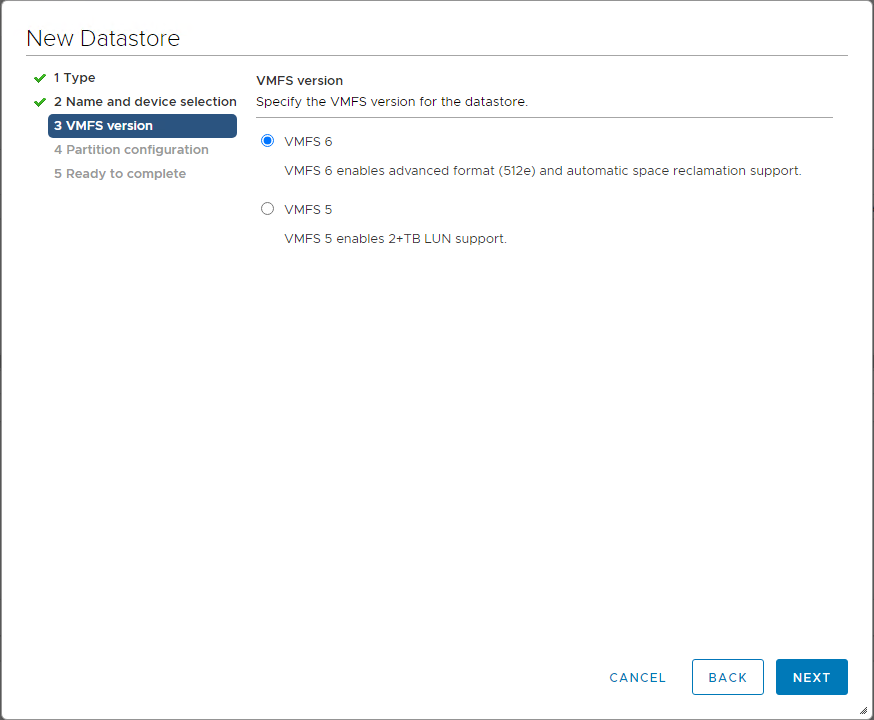

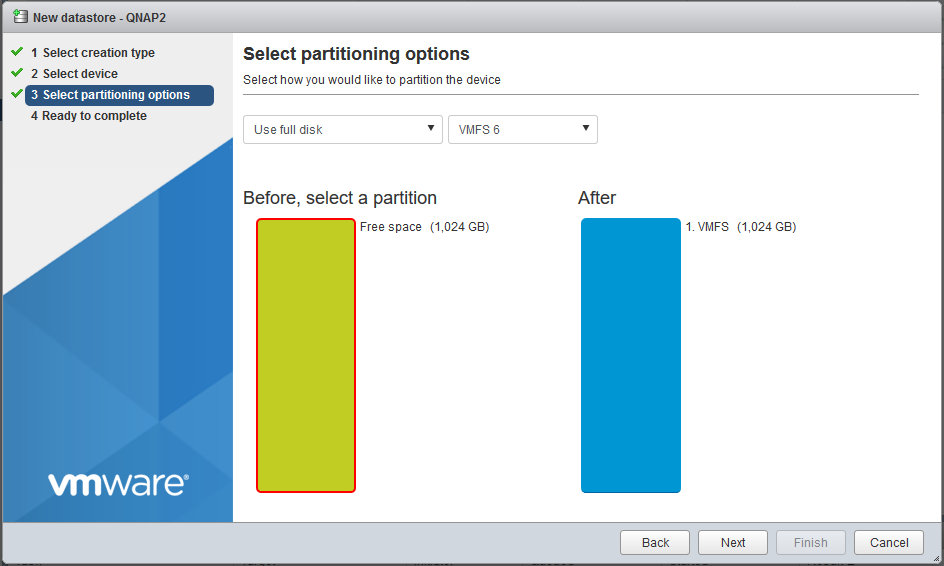

Step 11: Select VMFS 6 or VMFS 5 and click “Next”.

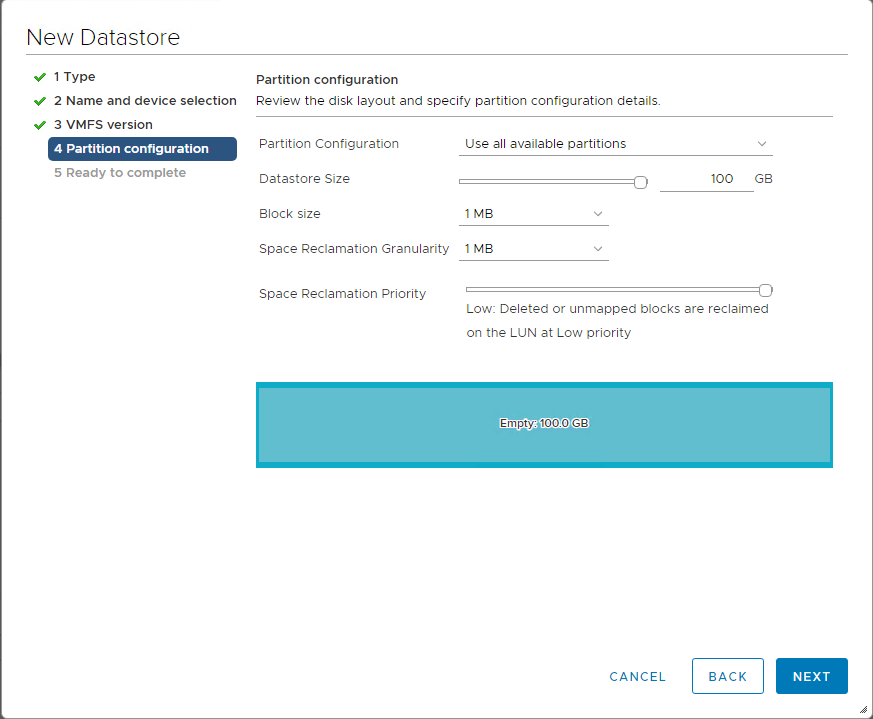

Step 12: Adjust the capacity values and click “Next”. By default, the entire space on the storage device is available.

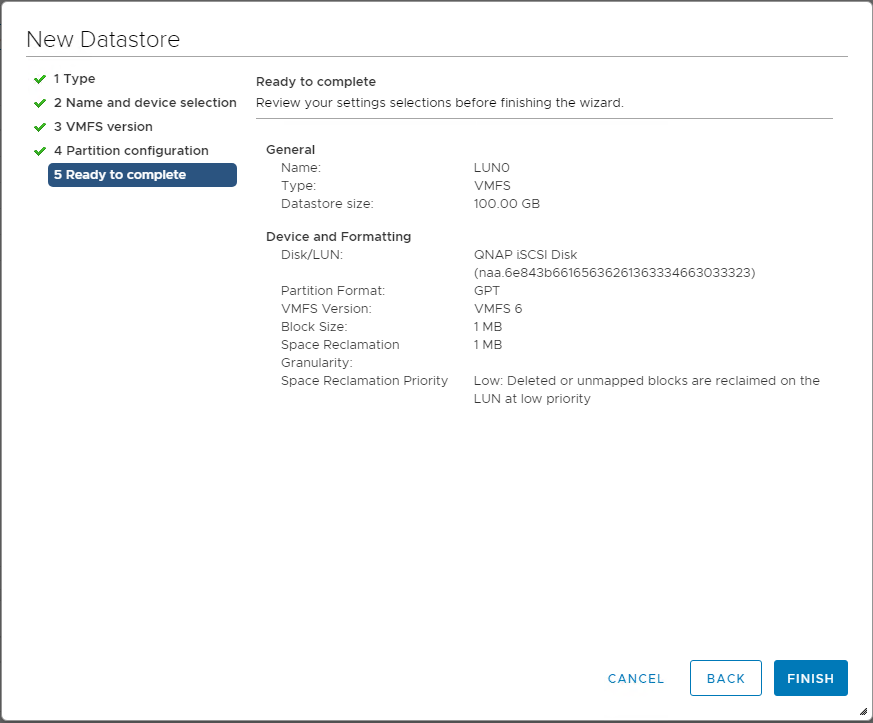

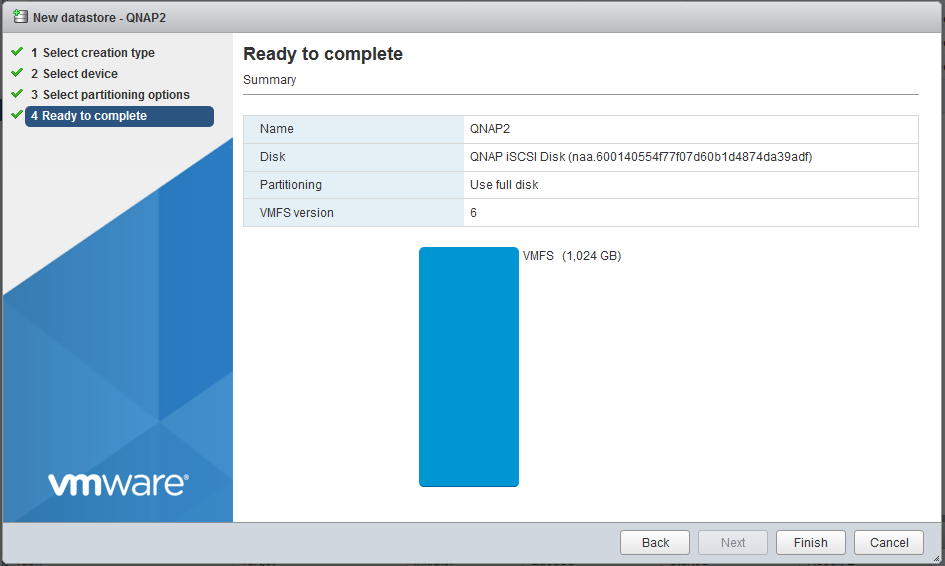

Step 13: Review the datastore configuration information and click “Finish”.

Step 14: The datastore on the iSCSI-based storage device will be listed.

Что такое общий диск Multi-writer в VMware ESXI

Сейчас уже очень сложно себе представить серьезный сервис без отказоустойчивости, которая может быть реализована на разных уровнях работы инфраструктуры. Очень частым решением выступает отказоустойчивый кластер, который подразумевает использование разных серверов для одного сервиса. Выход из строя одного из серверов не влияет на работоспособность предоставляемых услуг клиентам. Очень часто в кластерах используются общие диски, для хранения баз данных (Microsoft SQL или Oracle), файловые ресурсов. Общие диски могут презентованы, как отдельные LUN с СХД, через ISCSI протокол, через общий диск или RDM в случае с виртуальными машинами.

В данной заметке я опишу реализацию с помощью общего диска для виртуальных машин VMware ESXI 6.5. В некоторых случаях (как правило, в сценариях кластеризации) может потребоваться совместное использование одного и того же диска между двумя (или более) виртуальными машинами. Наиболее оптимальным способом является использование диска vmdk, физически расположенного на общем хранилище или локально на хосте ESXi. Если вы хотите использовать общие диски на разных хостах ESXi, то вы можете использовать только разделяемое хранилище

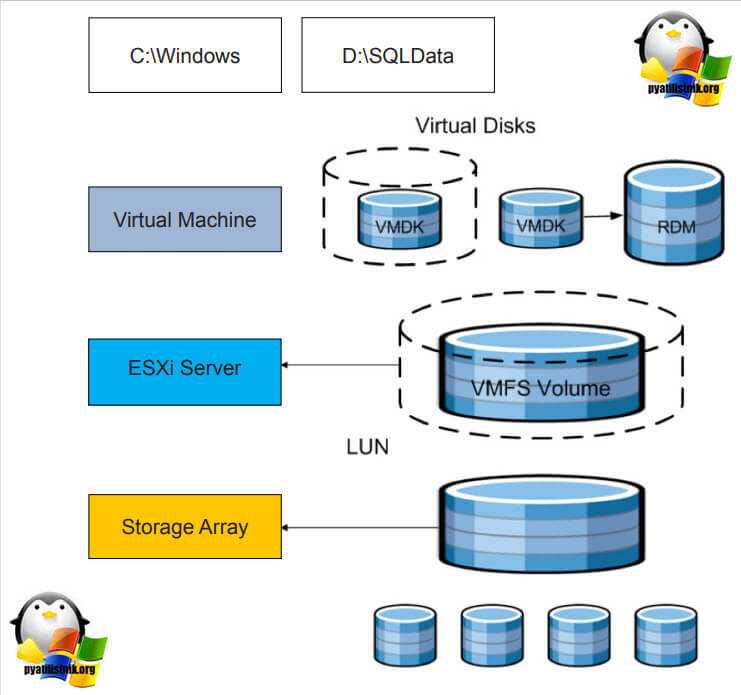

.На представленной ниже схеме вы видите:

- Storage Array, по сути это ваша система хранения данных, на которой реализован RAID массив, по рекомендации производителя.

- RAID массив порезан на LUN, это логически порезанное место на вашей системе хранения данных

- Далее LUN презентуется хостам VMware ESXI 6.5 и размечается файловой системой VMFS 6. Где из LUN получаются разделы (Datastore-Volume) для гипервизора.

- Далее на на Datastore уже разворачиваются виртуальные машины

Вот на таком общем VMFS Volume диске вы создаете общий VMDK диск, который будет доступен двум и более виртуальным машинам под чтение и запись. Сами виртуальные машины могут находится на разных физических хостах и разных географических локациях.Такой режим называется Multi-Writer VMDK, его часто применяют в построении кластеров MS SQL, Oracle RAC, такой режим работы диска применяется в технологии VMware Fault Tolerance.

21 Steps total

Via the VM Host control panel setup your Virtual Switch.

Step 2: Create Virtual Switch in EXSi

Name your new vswitch something recognizable and select the correct physical NIC for your iscsi network.

Click «Add» to save and add this new vswitch.

Here is what you should see after you create your vSwitch

Step 4: Add VMkernel NIC in ESXi

a) Enter whatever you like for the «Port Group» description, suggest using the service and IP network for visual cues on what port group does what.

b) Select the vSwitch you created earlier

c) Expand IPv4 settings

d) Select «Static»

e) Enter IP address & mask for host, suggest you create a completely separate IP network just for iscsi storage traffic.

f) Select ‘Create»

Here is what you should see after you add the VMkernel NIC

Here is what you should see after performing the networking portion of the setup.

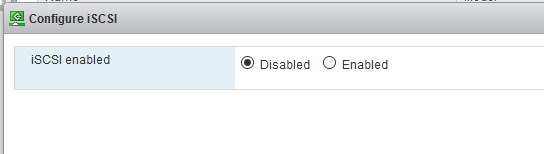

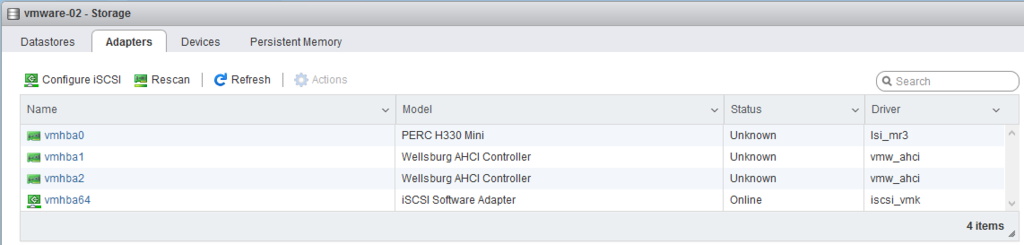

Enable the iSCSI adapter under Storage | Adapters

Click «Configure iSCSI»

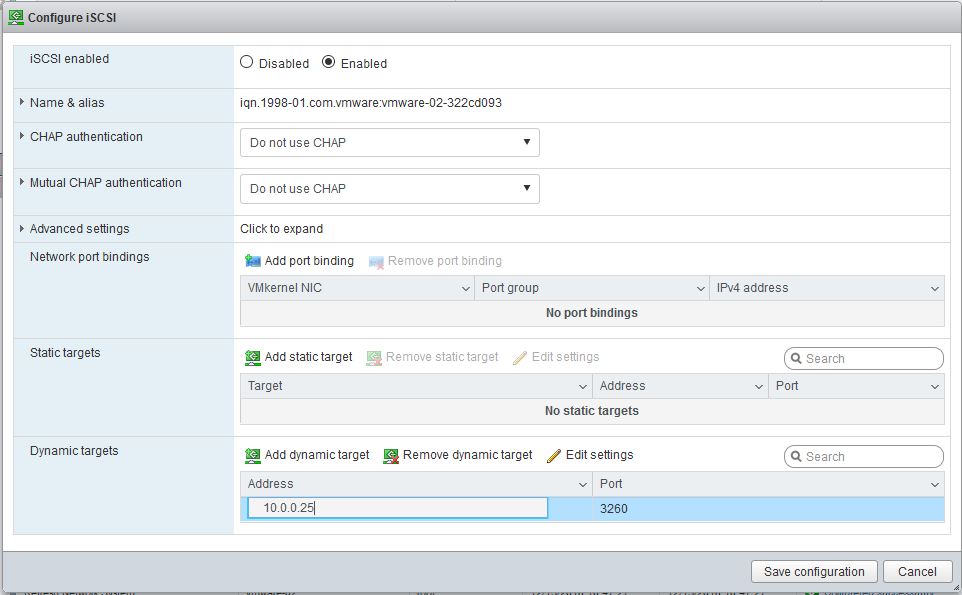

If the iSCSI adapter isn’t enabled already, select «Enabled»

Step 9: Configure iSCSI Adapter

If your NAS iSCSI target has already been configured (this is covered later in this how-to) enter the necessary CHAP settings (if you are using CHAP).

Otherwise, under «Dynamic targets» enter the IP address of the NAS device. If your NAS only has one Interface you will need to adjust your IP settings in STEP 4 to reflect this.

Here is what you should see after you have enabled the iSCSI adapter.

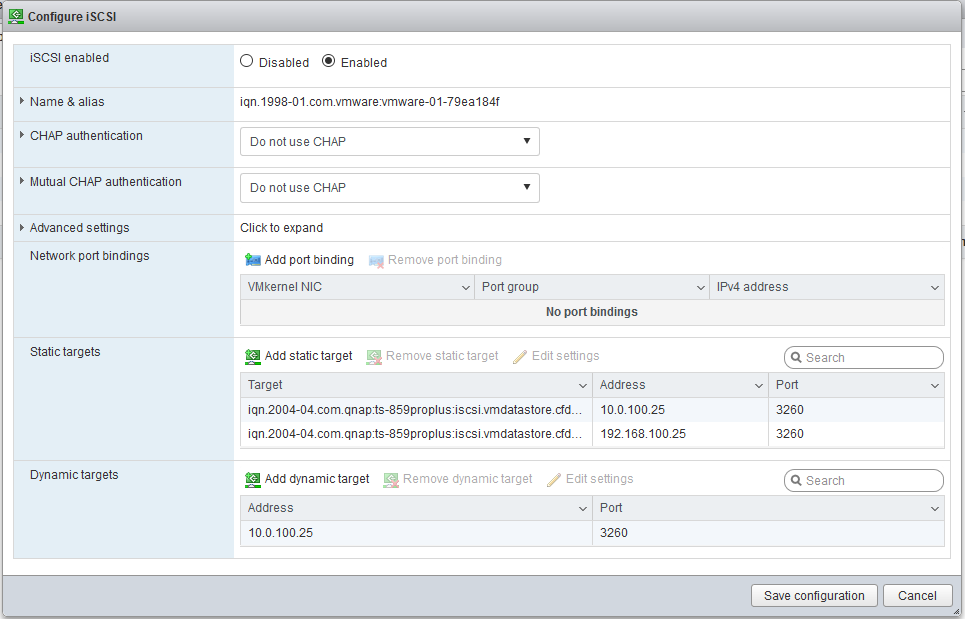

Step 11: Verify iSCSI targets on NAS

Click «Configure iSCSI» to bring up the properties page of the iSCSI adapter, you should see the list of iSCSI targets that the NAS is reporting back. You may see just the one, or several if the NAS has more than one NIC and those are active.

If you are not seeing any entries under the static targets window, it could be that there is an IP restriction or ACL in place on the NAS device blocking that service.

A troubleshooting step would be to enable SSH on the EXSi host and see if you can ping the NAS from the ESXi host. If you can, then attempt to telnet to the IP:PORT of the NAS if that fails either you have an IP filter or ACL in place on the NAS.

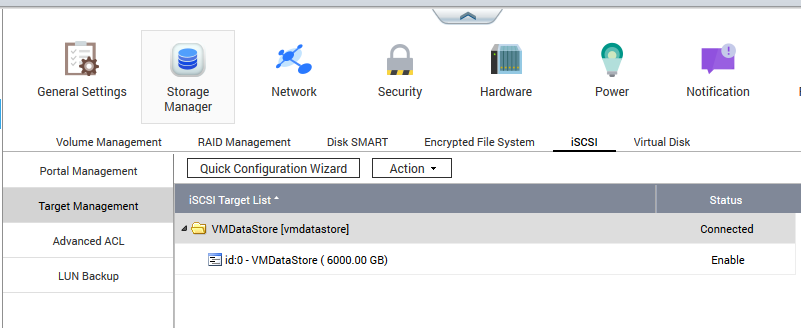

Step 12: Create iSCSI target / LUN on NAS

In my setup I have Qnap TS800 series storage arrays.

a) login to your QNAP and navigate to «Storage Manager»

b) Create your iSCSI target & LUN

This image shows a previously created 6TB LUN

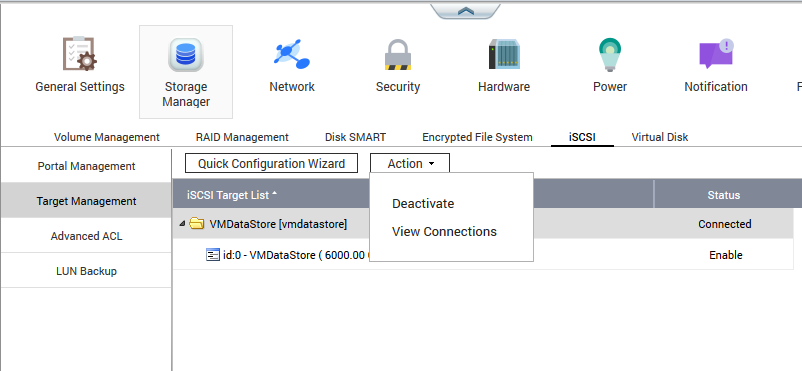

Step 13: Verify iSCSI initator connection

If your ESXi host is properly setup you may find it has already connected to your iSCSI target. This page shows a connection to the target, select «action» then «View Connections» to see if your host is in fact connected.

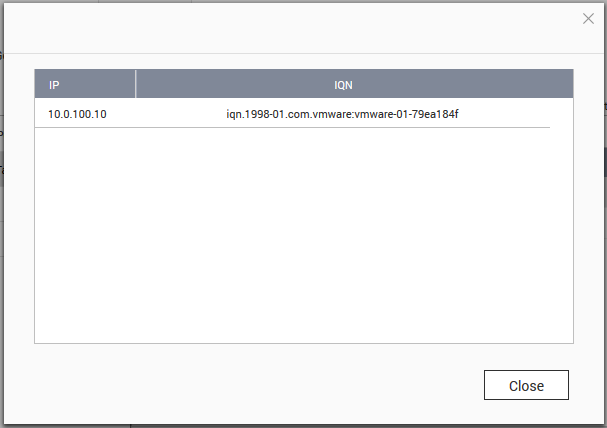

Step 14: iSCSI initator connection properties

This shows the connection from the EXSi Host

(you may notice a difference in the host IP shown here, the IP shown should match your VMkernel NIC IP created earlier, I’m using screen caps from two EXSi hosts to create this how-to)

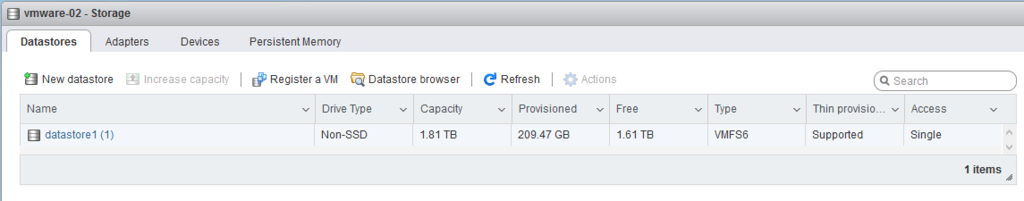

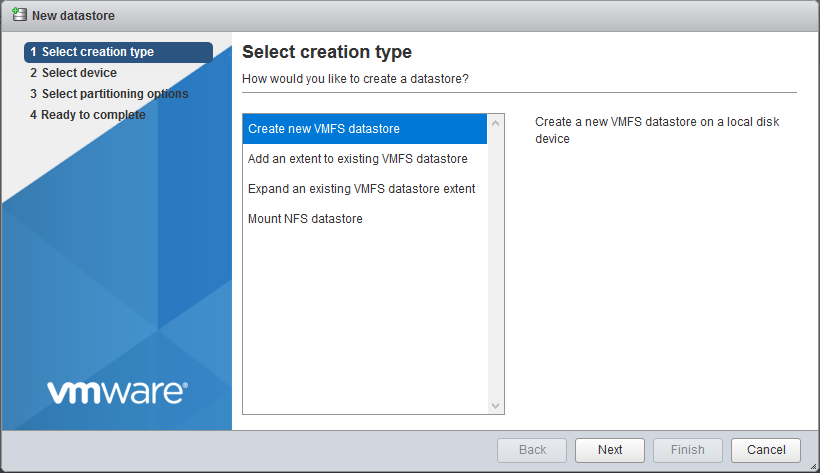

Via the Host control panel select «Datastores» then «New Datastore»

Select «Create new VMFS datastore

Step 17: Select iSCSI target device

Name your new datastore something descriptive and easy to recognize.

You should see the target/LUN you created earlier on your NAS.

Step 18: Select partitioning options

Here you decide how much space you are going to use for your new datastore. You can use 100% of the LUN you created, or a smaller amount.

Keep in mind that if you opt to use a smaller amount of the target your only option from within ESXi is to expand an existing VMFS partition to utilize the remaining space should you decide you need a larger datastore.

(NOTE: this was my direct experience, it may have been due to other factors specific to my host)

I create LUNs on my NAS devices the size I want for the VM Host machines and always allocate 100% of that LUN to the host. This allows me to have different authentication methods for each LUN depending on circumstances.

Step 19: Verify partition properties

The last step before you finalize your new storage devices is to check everything is how you want it. If it looks good, select «Finish»

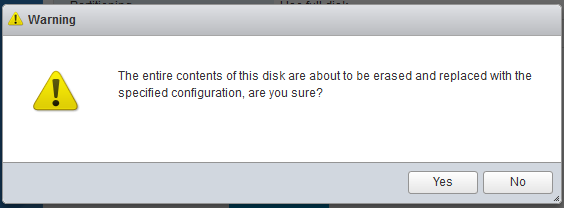

Step 20: Big scary warning!

Just letting you know that the contents of this ‘disk’ are about to be erased and replaced with the present configuration.

![Fc подключение к схд сервера под vmware esxi [colobridge wiki]](http://smartshop124.ru/wp-content/uploads/2/0/2/2027dba1489fd358e70a120ca031235d.jpeg)

![Fc подключение к схд сервера под vmware esxi [colobridge wiki]](http://smartshop124.ru/wp-content/uploads/5/7/b/57b5a4389b420300dc84b83f9cd1a353.jpeg)

![Оптимизация операционной системы vmware esxi 6 для работы с схд [colobridge wiki]](http://smartshop124.ru/wp-content/uploads/3/2/4/324c3d456f80a9612d49b519fc97b170.jpeg)

![Оптимизация операционной системы vmware esxi 6 для работы с схд [colobridge wiki]](http://smartshop124.ru/wp-content/uploads/a/1/5/a15b9c2bdf627dcc6b9eed766d70908e.jpeg)