Настройка iSCSI target в Windows Server

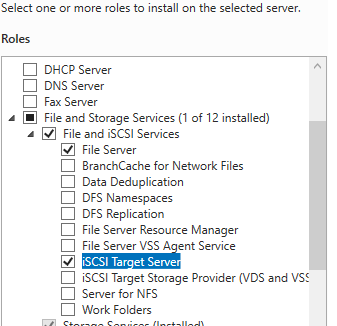

Сначала нужно включить iSCSI target (активировать роль iSCSI Target Server), зайдя в File and Storage Services -> File and iSCSI Services.

Install-WindowsFeature -Name FS-iSCSITarget-Server

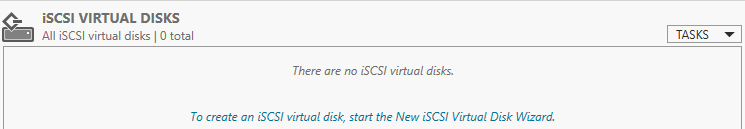

Теперь на iSCSI сервере нужно создать виртуальный диск. Для этого необходимо зайти в Server Manager -> File and Storage Services -> iSCSI, нажать To create an iSCSI virtual disk, start the New iSCSI Virtual Disk Wizard.

В мастере создания виртуального iSCSI диска нужно выбрать физический раздел, на котором его нужно разместить. Далее нужно присвоить имя iSCSI диска, указать размер диска и его тип (Fixed Size, Dynamically expanding или Differencing), имя iSCSI таргета.

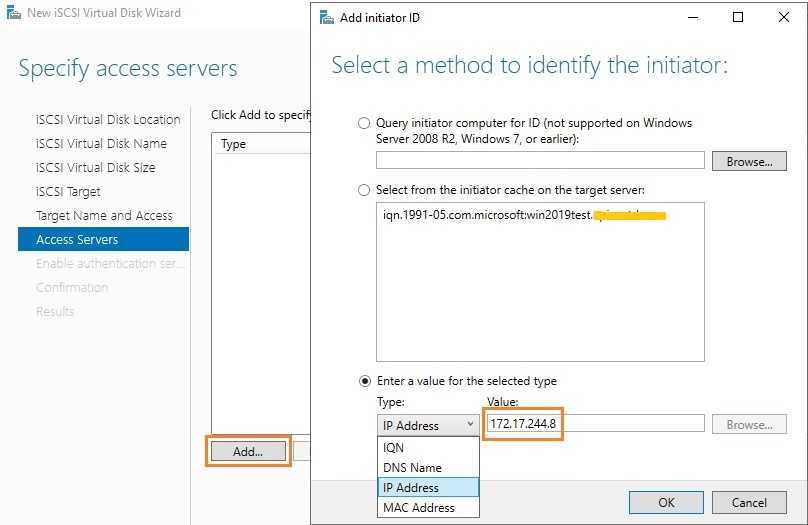

На шаге Access Servers нужно указать серверы (iSCSI инициаторы), которые смогут подключаться к данному iSCSI таргет, выбрав один из вариантов подключения:

- IQN (придется сначала включить iSCSI initiator на сервере и скопировать IQN);

- DNS Name

- IP Address;

- MAC Address.

Пусть используется вариант с IP-адресом.

Следующий шаг в этом мастере – это настройка протокола аутентификации CHAP. Его следует использовать, если необходимо проверять подлинность подключения от инициатора. Далее он включается, вписывается имя пользователя и 12-значный пароль (или длиннее), затем Next -> Next -> Finish. Проверьте, что виртуальный диск iscsiDisk2.vhdx создался в каталоге D:\iSCSIVirtualDisks.

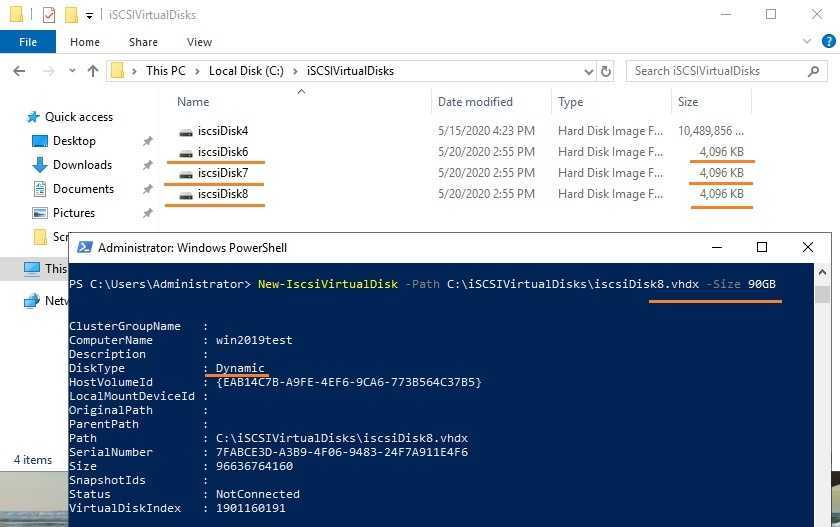

Можно создать iSCSI диск с помощью PowerShell. Создадим виртуальный диск размером 200 Гб:

New-IscsiVirtualDisk -Path С:\iSCSIVirtualDisks\iscsiDisk2.vhdx -Size 200GB.

По умолчанию создается динамический диск размером 4,096 Кб, независимо от того, сколько было указано параметром Size. Динамический диск будет расширяться по мере необходимости.

Если нужно использовать диск фиксированного размера (такие диске резервируют место на физическом носителе при создании), то его создать той же командой с дополнительным параметром UseFixed:

New-IscsiVirtualDisk -Path С:\iSCSIVirtualDisks\iscsiDisk2.vhdx -Size 200GB –UseFixed

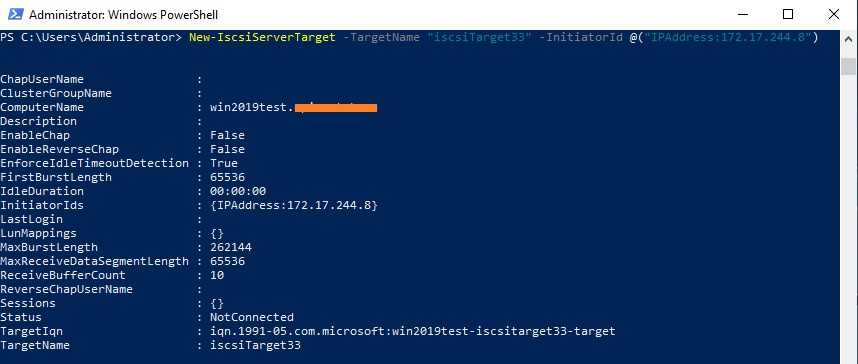

Далее таргету присваивается имя, здесь же можно разрешить к нему доступ с IP-адреса сервера-инициатора:

New-IscsiServerTarget -TargetName “iscsiTarget33” -InitiatorId @(“IPAddress:172.17.244.8”)

При желании вместо IP-адреса можно использовать IQN имя (iSCSI Qualified Name – уникальный идентификатор iSCSI устройства в сети):

New-IscsiServerTarget -TargetName iscsiTarget33 -InitiatorIds “IQN: 1991-05.com.microsoft:win2019test.ddd.com”

Затем желательно проверить результат:

Get-IscsiServerTarget | fl TargetName, LunMappings

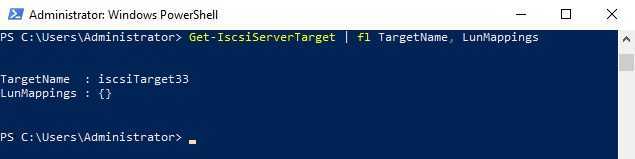

Получить полное имя таргета можно с помощью командлета Get-IscsiTarget , а затем подключить таргет:

Connect-IscsiTarget -NodeAddress iqn.1991-05.com.microsoft:win2019test-iscsitarget33-target

Действия на стороне хоста

Первоначально необходимо один раз установить на сервере компонент Multipath IO, который обеспечивает работу многопутевого ввода/вывода. Данное действие производится через стандартный диалог Add Roles and Features

При использовании протокола iSCSI необходимо выполнить:

- В свойствах Software iSCSI Initiator необходимо указать адреса таргетов, т.е. СХД на вкладке Discovery должны быть введены все используемые IP адреса контроллеров СХД

- После обнаружение таргетов к ним необходимо подключиться при помощи кнопки Connect. Отметим важные детали:

- Необходимо добавить подключаемые таргеты в список Избранных, чтобы в случае разрыва соединения происходило автоматическое переподключение

- Необходимо включить поддержку MPIO

- Хотя автоматическое определение маршрутизации в большинстве случаев работает корректно, мы все же рекомендуем не пренебрегать явным указанием с какого сетевого интерфейса сервера необходимо подключаться к конкретному таргету (Advanced Settings)

- Если через один и тот же сетевой интерфейс сервера производится работа с нескольким портами СХД, то подключение через Connect нужно проделать для каждого пути

При использовании протокола Fibre Channel все гораздо проще: достаточно выполнить Rescan для обнаружения нового тома. В нашем примере это том с LUN ID = 1, доступный по 4 путям. Как и в случае с iSCSI следует убедиться, что для диска установлена политика Round Robin, при которой все доступные пути до СХД будут использоваться равномерно.

Важное замечание касательно конфигурирования MPIO. По умолчанию Windows видит дисковые устройства по отдельности, т.е

каждый путь к устройству – это отдельный диск.

Чтобы ОС «склеила» все одинаковые диски в единое устройство, необходимо в стандартной оснастке MPIO добавить новое устройство как многопутевое. Для iSCSI устройств устанавливается отдельное разрешение. По окончании настройки потребуется перезагрузить сервер. Данную настройку необходимо произвести однократно для каждой СХД. После чего все вновь презентованные диски будут опознаваться ОС как многопутевые.

В случае использования кластера из нескольких хостов Windows Server, действия, описанные выше, необходимо повторить на каждом из хостов. После чего диски, появившиеся в системе, можно добавлять в дисковые ресурсы кластера.

Адаптация файловой системы после миграции

# pvresize /dev/md1

# pvs

PV VG Fmt Attr PSize PFree

/dev/md1 vg0 lvm2 a-- 1.82t 1.36t

# vgs

VG #PV #LV #SN Attr VSize VFree

vg0 1 3 0 wz--n- 1.82t 1.36t

# lvextend /dev/vg0/var /dev/md1

Extending logical volume var to 1.76 TiB

Logical volume var successfully resized

# lvs

LV VG Attr LSize Pool Origin Data% Move Log Copy% Convert

root vg0 -wi-ao-- 47.68g

swap_1 vg0 -wi-ao-- 11.44g

var vg0 -wi-ao-- 1.76t

# xfs_growfs /var

meta-data=/dev/mapper/vg0-var isize=256 agcount=4, agsize=26578176 blks

= sectsz=512 attr=2

data = bsize=4096 blocks=106312704, imaxpct=25

= sunit=0 swidth=0 blks

naming =version 2 bsize=4096 ascii-ci=0

log =internal bsize=4096 blocks=51910, version=2

= sectsz=512 sunit=0 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

data blocks changed from 106312704 to 472291328

# df -h

Filesystem Size Used Avail Use% Mounted on

rootfs 47G 660M 44G 2% /

udev 10M 0 10M 0% /dev

tmpfs 1.6G 280K 1.6G 1% /run

/dev/mapper/vg0-root 47G 660M 44G 2% /

tmpfs 5.0M 0 5.0M 0% /run/lock

tmpfs 3.2G 0 3.2G 0% /run/shm

/dev/md0 962M 36M 877M 4% /boot

/dev/mapper/vg0-var 1.8T 199M 1.8T 1% /var

Настраиваемые параметры сопоставления целей и экстентов iSCSI в FreeNAS

LUN ID

Тип drop-down menu. Выберите значение для использования или введите значение от 1 до 1023

Обратите внимание, что некоторые инициаторы ожидают значения ниже 256

Примечание

Каждая запись LUN имеет кнопки редактирования и удаления для изменения настроек или полного удаления LUN. Всплывающее окно подтверждения появляется при нажатии кнопки «Удалить». Если инициатор имеет активное соединение с LUN, он отображается красным текстом. Рекомендуется очищать соединения инициатора с LUN перед их удалением.

После того, как iSCSI настроен, не забудьте запустить его в Services ‣ Control Services. Нажмите красную кнопку OFF рядом с iSCSI. Через секунду или около того он изменится на синий, указывая, что служба запущена.

Подготовка оборудования[]

Отказоустойчивый сетевой массив будет состоять физически из двух серверов.

Необходимо:

- Два сервера с идентичными настройками и желательно идентичной конфигурацией оборудования

- На каждом сервере должны быть дополнительно идентичные по размеру тома, например отдельные жесткие диски одной моделью (/dev/sdb). Именно они будут объединены в зеркальный сетевой RAID1 массив.

- В каждом сервере должна быть дополнительная сетевая карта pci-express, а гнезда их соединены крос-пачкордом. Через него будет выполнятся синхронизация массива, чтобы не перегружать локальную сеть.

- Встроенные сетевые карты каждого сервера подключаются в общую локальную сеть.

Подключение диска iSCSI

2. В разделе «Свойства» инициатора iSCSI перейдите на вкладку «Обнаружение» и нажмите кнопку «Обнаружить портал».

3. В открывшемся окне заполните поле «IP адрес» сервера iSCSI.

4. Откройте раздел дополнительных параметров подключения к серверу (нажмите кнопку «Дополнительно»). Выберите значения полей «Локальный адаптер» и «IP-адрес инициатора», как на рисунке ниже (где IP-адрес инициатора — это IP вашего локального сетевого адаптера, через который разрешено подключение к серверу iSCSI).

5. Сохраните настройки, убедитесь в получении изображения, подобного приведенному ниже:

6. В разделе «Свойства» инициатора iSCSI перейдите на вкладку «Конечные объекты», выберите появившийся объект с неактивным состоянием и нажмите кнопку «Подключить».

7. В открывшемся окне «Подключение к конечному объекту», нажмите кнопку «Дополнительно…»

8. Заполните поля раздела, как на рисунке ниже. Параметры «Имя» и «Секрет» — это «Логин» и «Пароль» из письма, отправленного вам при активации услуги.

9. Сохраните настройки. Убедитесь, что значение поля «Состояние» обнаруженного конечного объекта – «Подключено», как на рисунке ниже. Выйдите из раздела «Свойства» Инициатора iSCSI, сохранив настройки.

iSCSI vs NAS

Эта часть призвана помочь системным администраторам выбрать между двумя технологиями хранения: NAS и iSCSI. и NAS, и iSCSI были разработаны, чтобы помочь удовлетворить экспоненциально растущую потребность в емкости хранения с помощью внешних масштабируемых устройств хранения, которые при необходимости могут быть объединены в сеть. Основное различие между iSCSI и NAS заключается в том, что iSCSI — это протокол передачи данных, а NAS — это распространенный способ подключения хранилища к общей пользовательской сети.

| Особенности | iSCSI | NAS over SMB |

|---|---|---|

| Уровень доступа к данным | Уровень блоков(команды SCSI, блоки данных). | Уровень объекта (файлы и папки). |

| Прямой доступ для клиентов | Необходимо настроить программное обеспечение iSCSI и сопоставить его как устройство. | Просто введите путь к общей папке, как вы это делаете для веб-сайта. |

| Доступно при использовании встроенных инструментов ОС | Обычно существует инициатор ISCSI, установленный для клиентского доступа, но вам необходимо установить цель iSCSI на сервере хранения, чтобы создать том данных. | Да, вы можете использовать практически любой файловый браузер, включая встроенный Windows/Linux/Mac. |

| Общая производительность | Зависит от инфраструктуры LAN. Можно реализовать SAN на базе 10 GbE или даже выше. | Зависит от используемой версии SMB. Для базовой версии 1 сложно полностью использовать канал 1GpE, но SMBv3 позволяет использовать многоканальный режим, который может многократно увеличить общую производительность. |

| Может использоваться как бэкэнд серверных приложений | Да, благодаря доступу на уровне блоков с использованием общих команд SCSI. | Только для определенных серверных приложений (например, VMware vCenter HA), использующих SMB v2/3. |

| Сложность реализации | Реализация на уровне производства требует установки специальной сетевой карты, настройки сетевых устройств и установки специального серверного программного обеспечения. | Достаточно тщательной настройки встроенных функций сервера для легкого доступа клиентов. |

| Готовы к работе с кластерами HA | Да, поддерживается практически любой технологией кластеризации, так как она основана на протоколе SCSI. | Только для определенных технологий кластеров серверов, которые поддерживают хранилище SMB/NFS в качестве общего тома. |

iSCSI vs Fibre Channel

Fibre Channel (FC) и iSCSI — две ключевые технологии, связанные с SAN, и эти две технологии решают одну и ту же техническую проблему сетевого блочного хранилища, хотя их позиционируют как жестких конкурентов. Люди часто спрашивают Fibre Channel SAN или iSCSI SAN: что лучше для SAN? Это сравнение Fibre Channel и iSCSI поможет вам принять решение:

| Особенности | FC | iSCSI |

|---|---|---|

| Позволяет использовать в существующей сети | Нет | Да |

| Доступ на уровне блоков | Да | Да |

| Надежное управление потоком данных (проверка CRC, предотвращение повторных попыток передачи) | Да | Нет |

| Встроенная сервисная инфраструктура | Да | Нет |

| Сетевая изоляция по дизайну | Да | Нет |

| Необходимо покупать специальное оборудование (адаптеры, коммутаторы и т. д.) | Да | Да/Нет (хорошая производительность невозможна без специальных адаптеров) |

| Доступные скорости передачи | 2/4/8/16/32 Гбит/с, поддержка агрегации каналов | 1/10/40/100 Гбит/с, поддержка агрегации каналов |

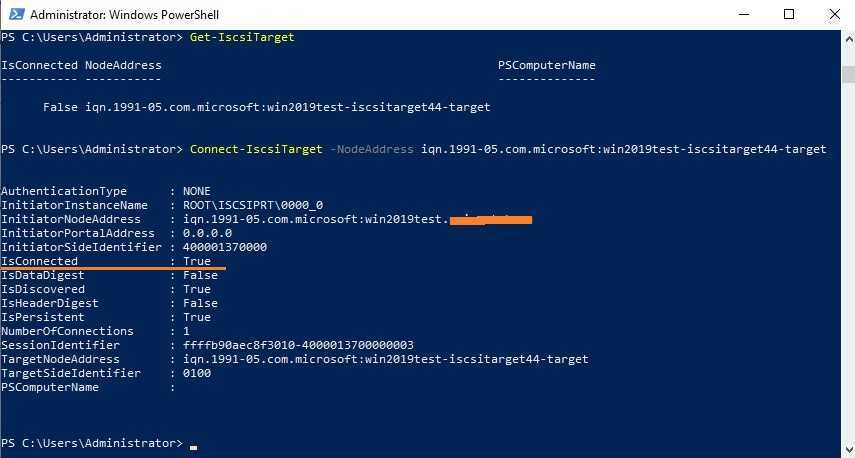

Настраиваемые параметры при добавлении авторизованного доступа

Group ID

Тип integer. Позволяет настраивать разные группы с разными профилями проверки подлинности. Пример: все пользователи с идентификатором группы 1 наследуют профиль аутентификации, связанный с группой 1.

User

Тип string. Введите имя учетной записи пользователя для создания для CHAP-аутентификации с пользователем в удаленной системе. Многие инициаторы по умолчанию используют имя инициатора в качестве пользователя.

Peer User

Тип string. Только ввод при настройке взаимного CHAP. В большинстве случаев это должно быть то же значение, что и Пользователь.

Тип string. Введите взаимный секретный пароль, который должен отличаться от секретного. Требуется, если установлен пользователь Peer.

CHAP не работает с инициаторами GlobalSAN на macOS.

По мере добавления разрешенных прав они будут перечислены в разделе View Authorized Accesses (Просмотр авторизированных доступов). В примере, показанном на рисунке 10.5.6, создаются три пользователя (test1, test2 и test3) и две группы (1 и 2), причем группа 1 состоит из одного пользователя CHAP и группы 2, состоящего из одного пользователя mutual CHAP и одного пользователя CHAP. Нажмите авторизованную запись доступа, чтобы отобразить ее кнопки «Редактировать» и «Удалить».

Просмотр авторизированных доступов iSCSI в FreeNAS

Просмотр авторизированных доступов iSCSI в FreeNAS

Растущие LUNы

Метод, используемый для увеличения размера существующего iSCSI LUN, зависит от того, поддерживается ли LUN размером файла или zvol. Оба метода описаны в этом разделе.

Расширение LUN одним из приведенных ниже методов дает ему больше нераспределенного пространства, но не автоматически изменяет размер файловых систем или других данных на LUN.

Это то же самое, что двоичное копирование меньшего диска на более крупный. На новом диске доступно больше места, но разделы и файловые системы должны быть расширены, чтобы использовать это новое пространство. Изменение размера образа виртуального диска обычно выполняется с помощью программного обеспечения для управления виртуальными машинами. Прикладное программное обеспечение для изменения размера файловой системы зависит от типа файловой системы и клиента, но часто запускается из виртуальной машины.

Например, рассмотрите виртуальную машину Windows с последним разделом на диске с файловой системой NTFS. LUN расширен и таблица разделов отредактирована, чтобы добавить новое пространство в последний раздел. Дисковый менеджер Windows все равно должен использоваться для изменения размера файловой системы NTFS на этом последнем разделе, чтобы использовать новое пространство.

Подключение к iSCSI

Чтобы получить доступ к цели iSCSI, клиенты должны использовать программное обеспечение инициатора iSCSI.

Клиент Инициатора iSCSI предварительно установлен с Windows 7. Подробное руководство для этого клиента можно найти здесь. (http://techgenix.com/Connecting-Windows-7-iSCSI-SAN/)

Клиент для Windows 2000, XP и 2003 можно найти здесь. (http://www.microsoft.com/en-us/download/details.aspx?id=18986)

В этом руководстве показано, как создать цель iSCSI для системы Windows 7. (https://www.pluralsight.com/blog/software-development/freenas-8-iscsi-target-windows-7)

Mac OS X не содержит инициатора. globalSAN — коммерческий, простой в использовании инициатор Mac. (http://www.studionetworksolutions.com/globalsan-iscsi-initiator/)

BSD-системы предоставляют инициаторы командной строки: iscontrol (8) поставляется с версиями FreeBSD 9.x и ниже, iscsictl (8) поставляется с версиями FreeBSD 10.0 и выше, iscsi-инициатор (8) поставляется с NetBSD, а iscsid (8) поставляется с OpenBSD.

Некоторые дистрибутивы Linux предоставляют утилиту командной строки iscsiadm из Open-iSCSI. (http://www.open-iscsi.com/) Используйте веб-поиск, чтобы узнать, существует ли пакет для распространения, если команда не существует в системе Linux.

Если добавлен LUN, а iscsiadm уже подключен, он не увидит новый LUN до повторного сканирования с помощью «iscsiadm -m node -R». В качестве альтернативы, используйте «iscsiadm -m discovery -t st -p portal_IP», чтобы найти новый LUN и «iscsiadm -m node -T LUN_Name -l» для входа в LUN.

Инструкции по подключению с сервера VMware ESXi можно найти в разделе Как настроить FreeNAS 8 для iSCSI и подключиться к ESX (i). (https://www.vladan.fr/how-to-configure-freenas-8-for-iscsi-and-connect-to-esxi/)

Обратите внимание, что требования по загрузке vSphere 4.x из iSCSI различаются между ESX и ESXi. ESX требует аппаратного адаптера iSCSI, в то время как ESXi требует специальной поддержки прошивки iSCSI

Магия находится на стороне хоста загрузки, что означает, что нет никакой разницы в конфигурации FreeNAS. Подробнее см. Руководство по конфигурации SAN iSCSI. (https://www.vmware.com/pdf/vsphere4/r41/vsp_41_iscsi_san_cfg.pdf)

Брандмауэр VMware разрешает только подключения iSCSI по порту 3260. Если выбран другой порт, исходящие соединения с этим портом должны быть добавлены вручную в брандмауэр до того, как эти соединения будут работать.

Если цель можно увидеть, но не подключиться, проверьте Discovery Auth (параметры обнаружения) в Target Global Configuration (глобальной целевой конфигурации).

Если LUN не обнаружен ESXi, убедитесь, что в режиме promiscuous установлен Accept в vSwitch.

ограничения виртуального диска iSCSI

|

Элемент |

Ограничение поддержки |

Применяются? |

Комментировать |

|---|---|---|---|

|

От инициатора iSCSI, который преобразует виртуальный диск из базового диска в динамический |

Да |

Нет |

|

|

Формат виртуального жесткого диска. |

vhdx (только Windows Server 2012 R2 и более поздние версии) .vhd |

||

|

Минимальный размер формата виртуального жесткого диска |

VHDX: 3 МБ . VHD: 8 МБ |

Да |

Применяется ко всем поддерживаемым типам виртуальных жестких дисков: родительский, разностный и фиксированный. |

|

Максимальный размер родительского VHD |

VHDX: 64 ТБ . VHD: 2 ТБ |

Да |

|

|

Фиксированный максимальный размер VHD |

VHDX: 64 ТБ . VHD: 16 ТБ |

Да |

|

|

Максимальный размер разностного виртуального жесткого диска |

VHDX: 64 ТБ . VHD: 2 ТБ |

Да |

|

|

Фиксированный формат VHD |

Поддерживается |

Нет |

|

|

Разностный формат VHD |

Поддерживается |

Нет |

Моментальные снимки не могут быть созданы с разностными виртуальными дисками iSCSI на основе VHD. |

|

Количество разностных виртуальных жестких дисков на родительский виртуальный жесткий диск |

256 |

Нет (да на Windows Server 2012) |

Два уровня глубины (файлы внуками. VHDX) — максимум для VHDX-файлов; один уровень глубины (дочерние VHD-файлы) является максимальным для VHD-файлов. |

|

Динамический формат VHD |

VHDX: Да . VHD: Да (нет в Windows Server 2012) |

Да |

Несопоставление не поддерживается’t. |

|

exFAT/FAT32/FAT (объем размещения виртуального жесткого диска) |

Не поддерживается |

Да |

|

|

CSV v2 |

Не поддерживается |

Да |

|

|

ReFS |

Поддерживается |

Н/Д |

|

|

NTFS |

Поддерживается |

Н/Д |

|

|

CFS не Майкрософт |

Не поддерживается |

Да |

|

|

Тонкая подготовка |

Нет |

Н/Д |

Динамические виртуальные жесткие диски поддерживаются, но сопоставление не поддерживается’t. |

|

Сжатие логического устройства |

да (только Windows Server 2012 R2 и более поздние версии) |

Н/Д |

Чтобы сжать LUN, используйте resize-исксивиртуалдиск . |

|

Клонирование логических устройств |

Не поддерживается |

Н/Д |

Вы можете быстро клонировать данные диска с помощью разностных виртуальных жестких дисков. |

Требования к оборудованию Hardware requirements

Сервер цели iSCSI не требует особого оборудования для функциональной проверки. iSCSI Target Server does not require special hardware for functional verification. В центрах обработки данных с крупномасштабными развертываниями проект необходимо проверять на соответствие с определенным оборудованием. In data centers with large-scale deployments, the design should be validated against specific hardware. Например, внутреннее тестирование Майкрософт показало, что для развертывания 256 компьютеров требуется хранилище на 24 дисках со скоростью 15 000 об/мин в конфигурации RAID 10. For reference, Microsoft internal testing indicated that a 256 computer deployment required 24x15k-RPM disks in a RAID 10 configuration for storage. Пропускная способность сети 10 Гигабитей является оптимальной. A network bandwidth of 10 Gigabit is optimal. Общая оценка — 60 серверов загрузки iSCSI на 1 гигабитный сетевой адаптер. A general estimate is 60 iSCSI boot servers per 1 Gigabit network adapter.

Для этого сценария не требуется специализированный сетевой адаптер, и можно использовать программный загрузчик (например, Ипксе с открытым исходным кодом загрузки). A specialized network adapter is not required for this scenario, and a software boot loader can be used (such as iPXE open source boot firmware).

Шаг 1. Развертывание Windows Server

Шаг 1,1. Установка операционной системы

первым шагом является установка Windows server на каждом сервере, который будет находиться в кластере. дисковые пространства для Direct требуется Windows Server datacenter Edition. Можно использовать вариант установки Server Core или сервер с возможностями рабочего стола.

при установке Windows server с помощью мастера установки можно выбрать между Windows сервером (который ссылается на ядро сервера) и Windows server (сервер с возможностями рабочего стола), который является аналогом полной установки, доступной в Windows Server 2012 R2. Если вы не выбираете, вы получите вариант установки Server Core. Дополнительные сведения см. в разделе Install Server Core.

шаг 1,2. Подключение на серверах

В этом руководство основное внимание уделяется варианту установки Server Core и удаленному развертыванию и управлению из отдельной системы управления, которая должна иметь:

- версия Windows Server или Windows 10 по крайней мере новые, как серверы, которыми он управляет, и с последними обновлениями.

- Сетевое подключение к управляемым им серверам

- Присоединение к тому же домену или полностью доверенному домену

- На нем должны быть установлены средства удаленного администрирования сервера (RSAT) и модули PowerShell для Hyper-V и отказоустойчивой кластеризации. средства RSAT и модули PowerShell доступны на Windows сервере и могут быть установлены без установки других компонентов. вы также можете установить средства удаленного администрирования сервера на пк, на котором выполняется управление Windows 10.

В системе управления установите отказоустойчивый кластер и средства управления Hyper-V. Это можно сделать в диспетчере сервера с помощью мастера добавления ролей и компонентов. На странице Компоненты щелкните Средства удаленного администрирования сервера и выберите средства, которые требуется установить.

Войдите в сеанс PowerShell и используйте имя сервера или IP-адрес узла, к которому хотите подключиться. После выполнения этой команды появится запрос на ввод пароля. Введите пароль администратора, указанный при настройке Windows.

Ниже приведен пример того, как сделать то же самое, что более полезно в сценариях, если это необходимо сделать более одного раза:

Совет

Если развертывание выполняется удаленно из системы управления, может возникнуть ошибка, например WinRM не может обработать запрос. чтобы устранить эту проблему, используйте Windows PowerShell, чтобы добавить каждый сервер в список надежных узлов на компьютере управления:

Примечание. список надежных узлов поддерживает подстановочные знаки, например .

Чтобы просмотреть список надежных узлов, введите .

Чтобы очистить список, введите .

Шаг 1,3. присоединение к домену и добавление учетных записей домена

Пока вы настроили отдельные серверы с учетной записью локального администратора, .

для управления дисковые пространства Direct необходимо присоединить серверы к домену и использовать учетную запись домена домен Active Directory Services, которая входит в группу администраторов на каждом сервере.

В системе управления откройте консоль PowerShell с правами администратора. Используйте для подключения к каждому серверу и выполните следующий командлет, заменив свое имя компьютера, доменное имя и учетные данные домена:

Если ваша учетная запись администратора хранилища не является членом группы «Администраторы домена», добавьте учетную запись администратора хранилища в локальную группу администраторов на каждом узле или еще лучше, добавьте группу, используемую для администраторов хранилища. для этого можно использовать следующую команду (или написать функцию Windows PowerShell. дополнительные сведения см. в статье использование PowerShell для добавления пользователей домена в локальную группу ):

Шаг 1,4. Установка ролей и компонентов

Следующим шагом является установка ролей сервера на каждом сервере. это можно сделать с помощью Windows центра администрирования, диспетчер сервера) или PowerShell. Ниже перечислены устанавливаемые роли.

- Отказоустойчивая кластеризация

- Hyper-V

- Файловый сервер (если требуется разместить любые общие файловые ресурсы, например для согласованного развертывания);

- Мост для центра обработки данных (если вы используете RoCEv2 вместо сетевых адаптеров iWARP)

- PowerShell для кластеризации RSAT

- PowerShell для Hyper-V

Чтобы установить с помощью PowerShell, используйте командлет Install-WindowsFeature . Его можно использовать на одном сервере следующим образом:

Чтобы выполнить команду на всех серверах в кластере как одно и то же время, используйте небольшой сценарий, изменив список переменных в начале скрипта в соответствии с вашей средой.

Сервер alice 10.0.32.201[]

apt-get update apt-get install drbd8-utils -y modprobe drbd

После установки отредактируем файл конфигурации на сервере alice, закомментировав или удалив все имеющиеся в файле строки и внеся свои

сохраняем копию оригинального конфигурационного файла

cp /etc/drbd.conf /etc/drbd.conf.orig

очищаем конфигурационный файл от содержимого

echo ""> /etc/drbd.conf

nano /etc/drbd.conf

global { usage-count yes; }

common { syncer { rate 1G; } }

resource r0 { protocol C;

startup { become-primary-on both; }

net { allow-two-primaries; }

on alice { device /dev/drbd0;

disk /dev/sdb;

address 10.0.32.201:7789;

meta-disk internal; }

on bob { device /dev/drbd0;

disk /dev/sdb;

address 10.0.32.202:7789;

meta-disk internal; }

}

Создаем массив

drbdadm create-md r0

Запускаем службу

/etc/init.d/drbd start

![Iscsi подключение к схд сервера под windows [colobridge wiki]](http://smartshop124.ru/wp-content/uploads/7/5/d/75d7b410b545cb776d8b919b67fd032e.jpeg)

![Iscsi подключение к схд сервера под windows [colobridge wiki]](http://smartshop124.ru/wp-content/uploads/4/0/0/400ca25c19bd6f92d6d396b5257ade2b.jpeg)