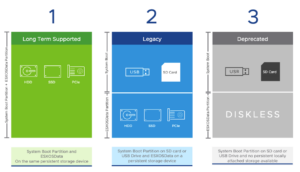

Соображения по загрузке ESXi

На сегодняшний день наилучшей практикой является наличие, а в будущем и обязательное наличие локально подключенного постоянного устройства хранения данных. Для получения дополнительной информации ознакомьтесь с приведенными ниже сведениями.

| Configuration | Status | Notes | Device Considerations |

| High Quality Boot Device | Supported, Preferred Long Term Support | Consolidation of System boot, bootbank, and ESX-OSData Partition on the same device | Device Endurance: 100TBW Locally attached devices such as: *NVMe (128 GB minimum) *SSD(128 GB minimum) *M.2 Industrial Grade (128 GB minimum) *HDD (32 GB Minimum) *Managed FCoE/iSCSI LUN (32 GB Minimum) |

| Low Quality Boot Device + High Quality Device | Supported, Legacy Configuration | Bootbank and ESX-OSData partition remain separate. SD card or USB device should only be considered to storage system boot partition | Low-Quality Device: *SD card or USB drive *Minimum 8 GB Device *Endurance: Minimum 1 TBW High-Quality Device: *Device Endurance: 100TBW *Locally attached devices such as: -NVMe (128 GB minimum) -SSD(128 GB minimum) -M.2 Industrial Grade (128 GB minimum) -HDD (32 GB Minimum) -Managed FCoE/iSCSI LUN (32 GB Minimum) |

| Low Quality Boot Device (Only SD card or USB device as the boot media), No High Quality Device | * It is being deprecated in vSphere 7 Update 3

* Still runs but with warnings. Please refer VMware KB Article 85615, linked at the end of this post |

All the partitions, including the ESX-OSData partition, are installed on the same low-quality boot media. This is a degraded mode configuration. |

Проблемы при установке ESXi

Больше всего проблем возникает у тех, кто пытается произвести установку на несовместимое оборудование. Как я уже писал раньше, дистрибутив гипервизора имеет очень небольшой размер и драйверов в нем помещается немного. В основном VMwareподдерживает брендовых производителей, но иногда и на серверы известных марок, скачанный с официального сайта образ не устанавливается. Узнать точно совместим ли ваш сервер с гипервизором ESXiопределенной версии можно на специальной странице http://vmware.com/go/hcl Для тех кто планирует создание инфраструктуры с нуля, особенно для тех кто собирается экономить и покупать серверное оборудование по отдельным компонентам, эта страничка должна быть в закладках. Здесь можно найти информацию не только по совместимости с серверами, но и по совместимости с моделями определенных сетевых карт, PCI контроллеров, по поддерживаемым способам подключения между сервером и системой хранения и многое другое.

Для собственных серверов производители выпускают специальные сборки VMwareESXi, их чаще всего, можно найти на официальных сайтах вендоров. В этих сборках расширенный, обновленный до последних версий набор драйверов для устройств, устанавливаемых в серверное оборудование. Конечно, если есть такая сборка для вашего сервера, то лучше использовать ее.

Для встраивания своих драйверов в образ ESXiраньше использовалась программка VMware Image Builder, но я давно про нее ничего не слышал. То что вы встроили драйвер образ и он установился-запустился еще не означает его корректную работу. Поэтому все эксперименты на свой страх и риск.

Чаще всего на несовместимом оборудовании ESXiне устанавливается из-за отсутствия драйверов на сетевую карту, тогда есть вариант купить отдельно сетевую карту из листа совместимости, например, Intel PRO/1000, установить ее в сервер и, скорее всего, после этого установка завершится удачно.

Бывает, что установщик ESXi не находит дисков для установки. Возможен вариант, когда не видны диски, находящиеся не в рейде, тогда нужно собрать RAID, даже если диск в сервере один из него можно собрать RAID-0. А бывает наоборот, видны только диски, находящиеся не в рейде. Тогда есть вариант установить на один из дисков или для надежности на оба ESXi, а потом собрать RAID-1. Несколько раз на серверах Intelданный способ спасал.

И главное, получив ошибку при установке не унывайте раньше времени, воспользуйтесь поиском в Google, вы 100% не первый, кто наступает на эти грабли.

Для тех, кто собирается использовать оборудование, которого нет в листе совместимости и платные лицензии VMware. При обращении в службу технической поддержки вам откажут в решении проблемы, если узнают про несовместимость, а они узнают после того, как вы пришлете им логи.

Описание VMware ESXi

Гипервизор VMware ESXi – самый популярный, функциональный и уникальный в своем сегменте программный продукт для серверной виртуализации. Популярность и, как следствие, массовое использование в корпоративном секторе позволили разработчикам к 7-ой версии исправить ошибки, которыми болеют другие гипервизоры-конкуренты. Выбирая, ESXi, даже в бесплатной версии, вы гарантированно получаете продукт высшего качества, который будет работать стабильнее других, по которому всегда можно найти исчерпывающую официальную информацию, документацию, а теперь и видео. Помимо официального сайта есть форумы и блоги, с описаниями установки, способами миграции с физических серверов в виртуальные, вариантами проектов и прочим полезным материалом.

Основная функциональная возможность, которую реализует гипервизор ESXi – это создание виртуальных машин на физическом сервере. В качестве гостевых операционных систем поддерживаются все основные версии, используемые в корпоративном секторе.

Производительность в цифрах

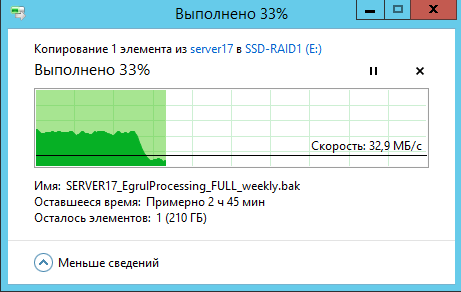

И так давайте теперь разберемся, что это сулит в цифрах, у меня есть сервер IBM 3650 и в нем для установки VMware ESXi 5.5 стоят две ssd, samsung evo 840, сразу скажу, что он уже отслужили свое и плюс в 840-х были проблемы с производительностью. При обычном линейном копировании на зеркальный raid из данных ssd, у меня через 5-8 минут падала скорость с 800 мегабайт в секунду, до 10-30 мегабайт в секунду, была сильная просадка.

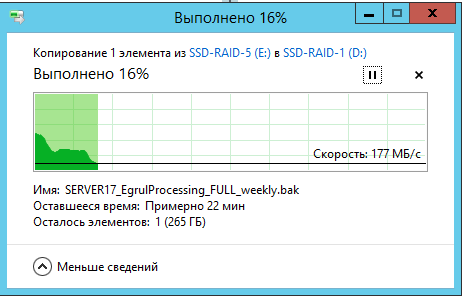

После того как я увеличил over provisioning, до 30 процентов, то скорость стала в 6 раз больше, и ниже 175 не падала

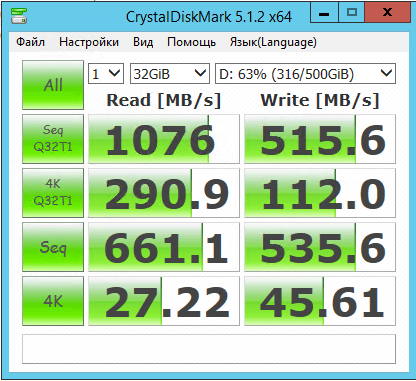

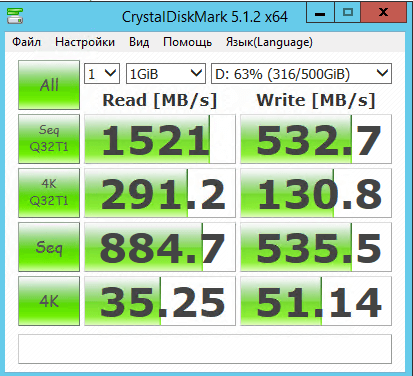

Так же можно сделать тестирование iops и скорости с помощью CrystalDiskMark, где при тесте 32 гигабайтным файлом, я получил 75 000 iops на чтение

вот как выглядят скорости при записи 1 ГБ файла.

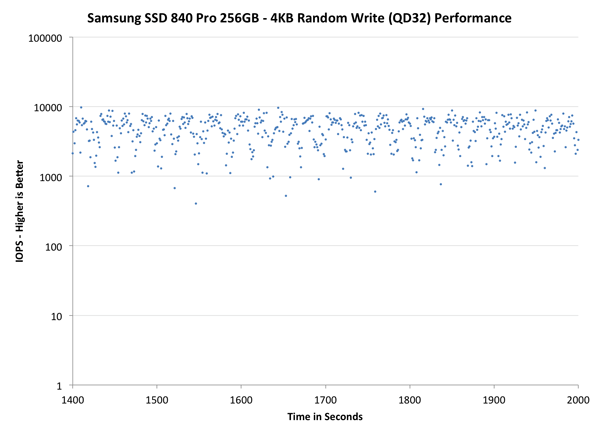

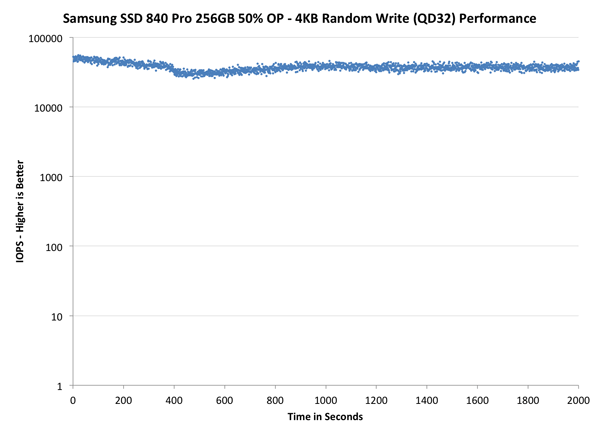

Еще проведем тесты случайной записи блоков по 4К, проверим стабильность. На первой картинке мы не используем over provisioning, и как видите стабильность записи сильно скачет.

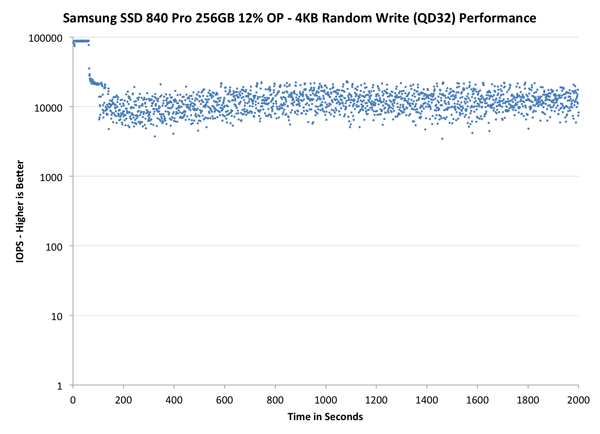

вот тут уже резервирование 12 процентов, видно улучшение

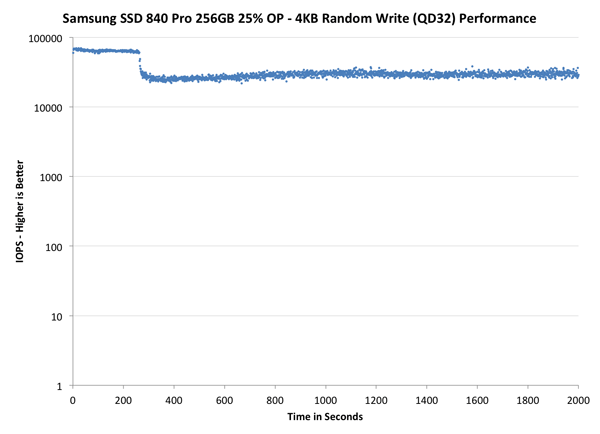

при 25 процентах over provisioning, стабильность еще лучше

при 50 еще больше, но это слишком жирно, отдавать половину места.

резюмируя, можно точно сказать, что технологии резервной области ssd, безусловно помогают увеличить производительность ssd и продлить ее жизнь

От общего к частному

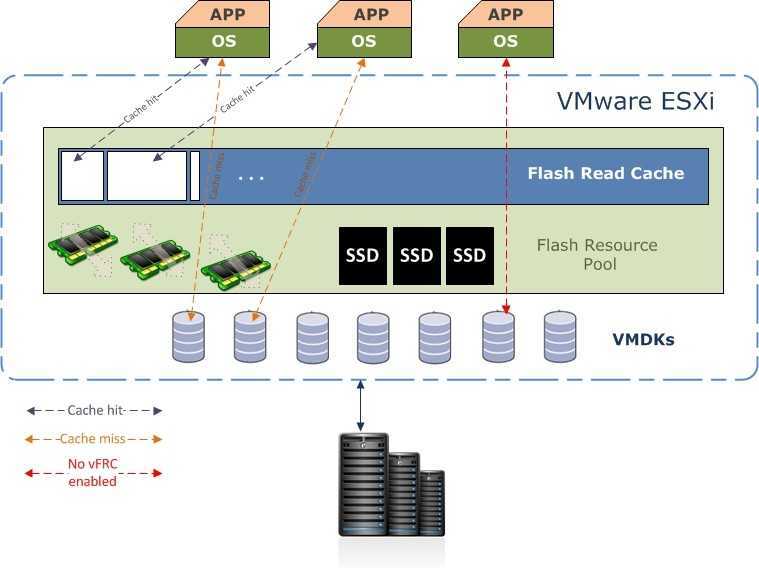

Использование флеш-технологий в корпоративных системах хранения данных на сегодняшний день является достаточно частым явлением, а реализация механизмов кеширования, в свою очередь, возможна на различных уровнях. Попробуем разобраться в вариантах реализации, рассмотрев основные особенности и принципы работы.

Большинство облачных хостинг-провайдеров вместо увеличения количества жестких дисков или твердотельных накопителей отдают предпочтение оптимизации производительности уже имеющихся СХД. При этом почти каждый ставит целью повысить пропускную способность подсистем ввода-вывода, уменьшить время ожидания отклика приложений, добиться возможности использовать меньшее число жестких дисков большего объема и снизить затраты в целом.

Использование технологии кеширования позволяет уменьшить зависимость производительности СХД от количества дисков в базовом дисковом массиве, значительно сокращая расходы и достигая вышеозвученные цели, одновременно уменьшая при этом административную нагрузку для настройки производительности.

Высокая доступность (HA) и управление ресурсами

| VMware vSphere 6.0 Enterprise Plus | Microsoft Hyper-V 2012 R2 Datacenter | |

| Узлов на кластер | 64 | 64 |

| ВМ на кластер | 8000 | 8000 |

| HA (рестарт ВМ при отказе) | VMware HA | Да (кластеризация и Heartbeat) |

| Отказоустойчивость (Fault Tolerance) | Да (100% доступность для бизнес-критичных приложений в ВМ), даже при аппаратном отказе | Нет |

| Репликация | Нативная (vSpare Replication) | Hyper-V Replica |

| Автоматическое управление ресурсами | Планировщик Distributed Resource Scheduler (DRS) для балансирования нагрузки | Dynamic Optimization |

| Пулы ресурсов | Да | Да (Host Group) |

| Совместимость миграции | Да (улучшенная совместимость vMotion); EVC в настройках DRS | Да (для процессоров) |

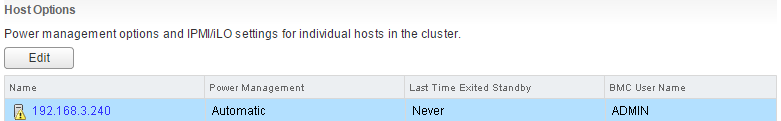

Host Options.

Во вкладке Host Options задаются настройки для управления электропитанием хоста для Distributed Power Management (DPM). DPM — это функция vSphere DRS, задача которой снизить энергопотребление на основе анализа потребляемых ресурсов. DPM мониторит потребляемое количество ресурсов процессора и памяти, сравнивая с общим количеством ресурсов в кластере. Если будут найдено достаточно ресурсов для перемещения ВМ, то они будут перенесены, а хост переводится в режим ожидания. И наоборот, как только в кластере становится недостаточно ресурсов, хост выводится из режима ожидания.

DPM использует для управления три протокола: Intelligent Platform Management Interface (IPMI), Hewlett-Packard Integrated Lights-Out (iLO), или Wake-On-LAN (WOL). Если хост не поддерживает ни один из этих протоколов, то он не может быть переведен с помощью DPM, а если хост поддерживает несколько протоколов — они используются в следующем порядке: IPMI, ILO, WOL.

IPMI является аппаратной спецификацией, а iLO — встроенной технологией по управлению сервером. Обе технологии обеспечивают интерфейс для удаленного мониторинга и управления компьютером. IPMI и iLO требуют наличия Baseboard Management Controller (BMC), который обеспечивает шлюз для доступа к аппаратному управлению, позволяя управлять питанием удаленно через LAN-порт.

Если вы планируете использовать iLO, или IPMI для управления питанием хоста, вам необходимо настроить BMC. Шаги по настройке iLO различны в зависимости от выбранной модели, тогда как IMPI требует дополнительных настроек в BIOS (убедитесь, что BMC LAN включен, сконфигурирован и доступен для управления). VMware DPM поддерживает только IMPI c MD5- и plaintext-based аутентификацией. vCenter Server использует MD5, если BMC дает ответ, что MD5 поддерживается и доступна для роли оператора (Operator role). В противном случае, используется plaintext-based аутентификация, если, опять же, включена и доступна. Если MD5 и plaintext-based аутентификации отключены, то IPMI не может использоваться и vCenter Server попытается использовать Wake-on-LAN.

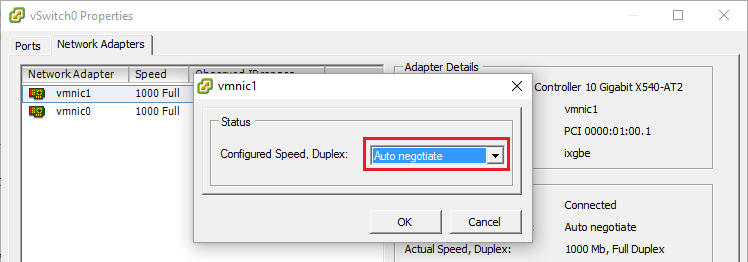

Для работы Wake-On-Lan необходимо выделить vMotion в отдельную IP-сеть и использовать гипервизоры ESX(i) 3.5, или выше. Каждый интерфейс сети vMotion должен поддерживать Wake-On-Lan. Проверить, поддерживают ли сетевые интерфейсы хоста Wake-on-LAN можно перейдя в vSphere Client к настройкам хоста:

Configuration -> Network Adapters

Порт коммутатора (switch) должен быть выставлен в автоматическое согласование скорости (Auto Negatiate), а не принудительное (например, 1Гб/с):

Некоторые сетевые интерфейсы поддерживают Wake-On-Lan только, если они могут переключаться на 100Мб/с (или менее), когда хост выключен.

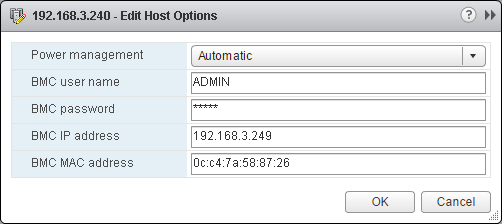

Теперь для того, чтобы настроить BMC для каждого из хостов открываем в веб-клиенте vSphere:

Hosts and Clusters -> {Host} -> Manage -> Power Management

Вводим настройки BMC. Оставляем дефолтную схему менеджмента питания, или выбираем для подключаемого хоста один из трех вариантов: Disabled, Manual, или Automatic. Вводим логин и пароль для роли оператора BMC (Operator role), IP- и MAC-адрес интерфейса.

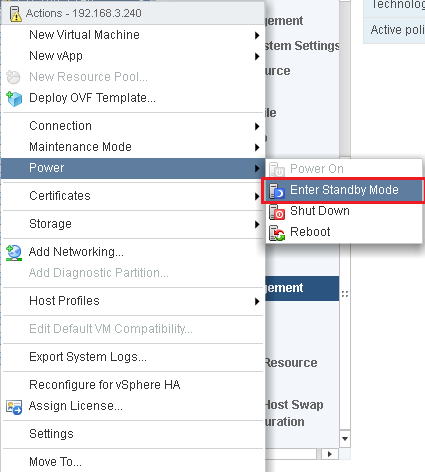

Теперь можно протестировать управление питанием хоста. В веб-клиенте vSphere, или vSphere Client открываем контекстное меню для выбранного хоста и переходим:

Power -> Enter Standby Mode

По окончании миграции ВМ хост будет выключен (точней, перейдет в “режим ожидания”, но при этом будет доступен для BMC). Аналогично можно проверить его включение, раскрыв контекстное меню хоста:

Power -> Power On

Питанием хостов можно так же управлять с помощью VMware vSphere PowerCLI. Для перевода в Standby Mode:

Get-VMHost -Name <Hostname> | Suspend-VMHost -Confirm:$false

Для Power On:

Get-VMHost -Name <Hostname> | Start-VMHost -Confirm:$false

После того, как BMC/WOL протестированы, можно приступить к настройке DPM для vSphere DRS (см. выше описание параметров vSphere DRS). Как только DPM будет активирован, вы можете просмотреть статус для каждого хоста в поле “Last Time Exited Standby”:

Это поле отображает время, когда vCenter Server пытался перевести хосты в режим “ожидания”, а так же статус успешного выполнения — Succeeded, Failed, или Never, если не было ни одной попытки.

Важные ссылки

- ESXi System Storage Changes

- ESXi System Storage While Upgrading

- ESXi System Storage FAQs

- VMFS-L locker partition corruption

- Bootbank cannot be found at path ‘/bootbank’ errors being seen after upgrading to ESXi 7.0 U2

- Creating a persistent scratch location for ESXi 7.x/6.x/5.x/4.x

- Configure ESXi Dump Collector with ESXCLI

- VMware KB Article 85615

P.S. Перевод выполнен комбинацией машинного обучения и человеческого интеллекта в пропорции 99/1. Если есть пожелание поправить чего, то пишите в комментарии.

P.P.S. Качество картинок везде исправлено до приемлемого (в отличии от оригинальной статьи). Таблица сделана текстом, опечатки оригинальной исправлены.

Почему так дорого?

На сайте VMware уже давно можно найти стоимость продуктов и меня часто спрашивают, почему там такие высокие цены. Все дело в том, что там опубликованы рекомендуемые цены, которые и сама компания и ее партнеры должны транслировать своим заказчикам. Естественно, закупочная цена для партнера существенно ниже и озвучивать ее никто не имеет права. Поэтому на сайте ITsave будут публиковаться цены, доступные в OEM канале. Это те лицензии, которые обычно продаются вместе с оборудованием и тоже доступны в открытом доступе.

Лицензии VMware OEM отличаются от тех, которые продаются в коммерческом канале:

Масштабируемость ВМ

| VMware vSphere 6.0 Enterprise Plus | Microsoft Hyper-V 2012 R2 Datacenter | |

| Макс. vCPU на ВМ | 128 | 64 |

| Макс. ОЗУ на ВМ | 4 TБ | 1 TБ |

| Последовательные порты | 32 порта | Только подключенные к Named Pipes |

| Поддержка USB | Да (USB 1.x-3.0), до 20 устройств USB на ВМ | Нет (за исключением Enhanced Session Mode) |

| Поддержка «горячего» подключения | Да (ЦП, память, диск, сетевая карта, PCIe SSD) | Только диск и память, «горячее» добавление памяти в конфигурации Dynamic |

| Виртуальных сетевых карт (NIC) на ВМ | 10 (любая комбинация поддерживаемых NIC) | 8 типа «сетевой адаптер» и 4 — «унаследованный адаптер» |

| Виртуальных дисков IDE на ВМ | 4 | 4 |

| Емкость виртуального жесткого диска | 62 Тбайта | 64 Тбайта (формата VHDX в Windows Server 2012) |

| Поддержка гостевых ОС | Полный список операционных систем, включая FreeBSD 10.0 и Asianux 4 SP3 | Меньше гостевых ОС по сравнению с vSphere 6 |

Наборы лицензий VMware vSphere для старта

Если это ваша первая покупка лицензий VMware для серверной виртуализации, то можно не разбираться сколько стоят отдельные лицензии, т.к. все равно они получатся дороже, чем стартовые наборы.

Любой из наборов рассчитан на 1-3 сервера, по два процессора в каждом. Сейчас уже есть процессоры содержащие по 18 ядер, поэтому изначально рассчитанные на малый бизнес, эти наборы могут потянуть очень большую инфраструктуру. Выделенные синим цветом Essentials Kit наборы обладают минимальным функционалом и такой же стоимостью, но из опыта я знаю, что базовые возможности самые востребованные. Иногда компании покупают самые дорогие Enterprise Plus лицензии, но пользуются только базовыми возможностями.

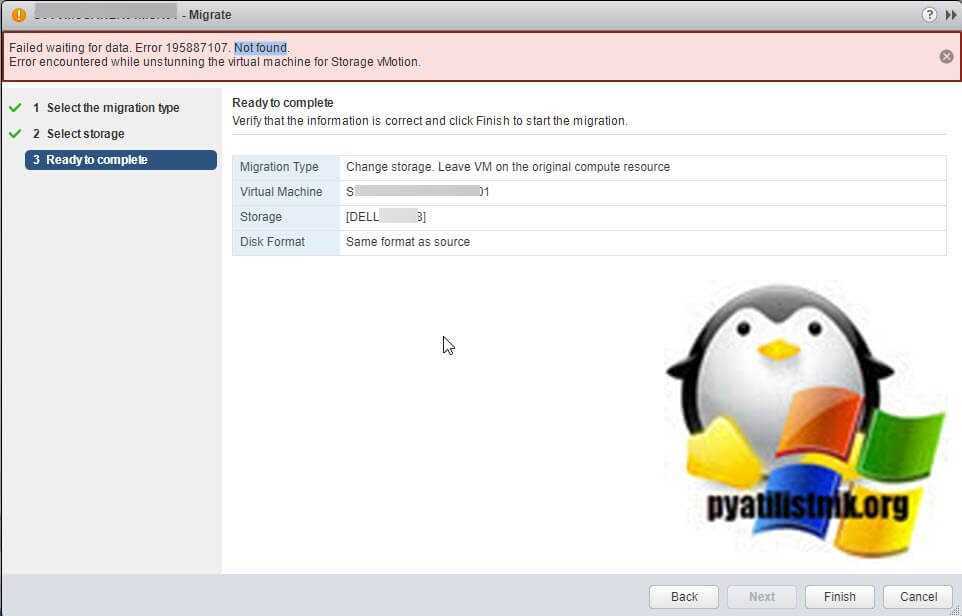

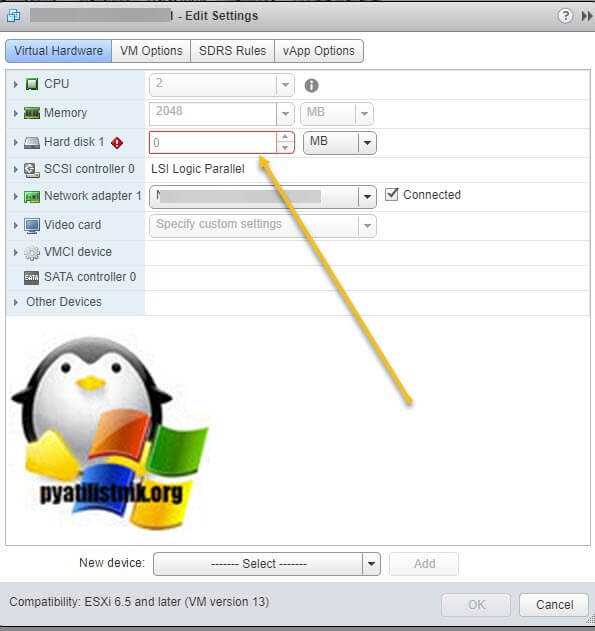

Описание проблемы

Как я и писал выше мне нужно было сделать storage migration, в результате мне мой vCenter Server 6.5 выдал сообщение:

Failed waiting for data. Error 195887107. Error encountered while unstunning the virtual machine for Storage vMotion

Если зайти в свойства данной виртуальной машины, то вы увидите, что у вашего виртуального диска размер 0 МБ.

Если зайти в свойства данной виртуальной машины, то вы увидите, что у вашего виртуального диска размер 0 МБ.

Я начал разбираться в данном вопросе в плане поиска причины и нашел несколько вариантов:

- У вас криво ранее смигрировались файлы виртуальной машины

- Причиной могла быть система резервного копирования Veeam Backup & Replication, которая не смогла удалить снапшот или криво его сделала. Простой пример у вас делалось задание резервного копирования, и в этот момент вы мигрировали ее, в результате Veeam может натворить дел

- Третья проблема, это ранее созданные ручные снапшоты, которые могли быть неправильно удалены или слиты, ниже я рассмотрю все варианты.

Потенциальные проблемы с ESXi 7 и SD-картами и USB-накопителями

Потенциальное повреждение locker-раздела VMFS-L

Устройства с низким ресурсом, такие как SD-карты или USB-накопители, быстро изнашиваются из-за частых операций чтения. Наиболее распространенной причиной частых операций чтения являются файлы VMTools, к которым обращаются виртуальные машины. Одним из способов борьбы с этим является выгрузка операций ввода-вывода при чтении VMTools на RAM Disk, что значительно сокращает количество операций ввода-вывода, передаваемых на SD-карты или USB-накопители.

Текущим обходным решением является перемещение VMTools на RAMDisk путем включения опции ToolsRAMDisk Option вручную. Проблема решена в vSphere 7 Update 2c. Дополнительные сведения см. в статье KB Article 83376.

Отсутствует ‘/bootbank’

SD-карты или USB-устройства обычно имеют небольшую глубину очереди, что приводит к невыполненным запросам ввода-вывода в стеке хранилища и, в конечном счете, к тайм-ауту. Проблема решена в vSphere 7 Update 2c. Более подробную информацию см. в статье KB Article 83963.

Как работают с SSD-кешем СХД на примере флеш-технологий NetApp

Напомним, что компания NetApp была первой в области разработки инновационных технологий кеширования (чтение/запись) и по сей день подтверждает свое лидерство в отрасли СХД корпоративного класса с поддержкой флеш-технологий, реализуя при этом многоуровневый подход.

Кеширование на уровне контроллера

NetApp Flash Cache (ранее PAM II) — это технология Flash на уровне контроллера СХД, которая позволяет сохранять «горячие», часто запрашиваемые данные. Основное преимущество этого решения заключается в увеличении производительности для рабочих нагрузок с большим количеством операций произвольного чтения без добавления высокопроизводительных дисковых устройств. За счет высокопроизводительного кеша для операций чтения время ожидания по сравнению с дисковыми накопителями снижается в десять и более раз, а также улучшается пропускная способность ввода-вывода. Способность кешировать огромные объемы активных данных обеспечивает эффективность работы Flash Cache с целым спектром рабочих нагрузок.

Уровень контроллера Flash Cache

| Основные характеристики | Рабочие нагрузки | Результат |

|

Рабочие процессы с высоким количеством выборочных считываний:

|

Повышенная производительность с меньшим количеством дисков |

Кеширование на уровне дисковой подсистемы (массива)

NetApp Flash Pool технология Flash, использующая гибридную модель: сочетание дисков SSD и HDD в одном дисковом агрегате (наборе дисков). Отличительной особенностью данного решения является кеширование часто запрашиваемых данных на SSD-носитель, а также сохранение данных повторяющейся записи.

Уровень дисковой подсистемы Flash Pool

| Основные характеристики | Рабочие нагрузки | Результат |

|

Рабочие процессы с выборочными операциями чтения и перезаписи:

|

|

Кеширование под управлением ОС СХД на уровне сервера

Технология NetApp Flash Accel задействует устройство Flash на стороне сервера (Flash-карта PCI-e или диск SSD) в качестве локального кеша, который разгружает сеть, выполняя часть операций ввода-вывода, и обеспечивает тем самым оптимальную эффективность операций ввода-вывода для самых загруженных приложений, освобождая при этом ресурсы ЦП и памяти на сервере.

Уровень сервера Flash Accel

| Основные характеристики | Рабочие нагрузки | Результат |

|

|

|

Рассмотрев различные уровни флеш-технологий, можно сделать следующие выводы: Flash Cache ускоряет процессы получения данных, Flash Pool ускоряет операции случайного чтения и записи на уровне системы хранения данных, а Flash Accel кеширует данные непосредственно на сервере для повышения производительности самых ресурсоемких и требовательных приложений.

Рисунок 1. Архитектура работы vFRC

Для чего нужна резервная область over provisioning

У всех твердотельных накопителей резервная область служит для трех целей.

- Хранение мусора > ссд накопители, всегда имеют запас блоков памяти, которые операционная система не видит и не имеет туда доступа, в результате чего сборка хлама производится не так часто.

- Увеличение времени износа ссд > ну тут все логично если у вас есть у контроллера запасные блоки, то это увеличивает время жизни, а так же позволяет проводить выравнивание более равномерно, задачей контроллера является равномерное распределение данных по всем блокам SSD

- Замена отработавших блоков памяти > тут тоже логично, если блок отработал свое время и есть возможность его заменить на резервный, то это положительно скажется на увеличение производительности ssd

Напомню, что ос видит только размеченную область флэш-памяти, а вот контроллер использует все полностью, логично что чем больше у него памяти в наличии, тем меньше появляется нужда в сборе мусора, что в итоге влияет на улучшение производительности ssd,

Увеличиваем резервную область

Все теперь мы с вами знаем, что увеличить производительность ssd можно за счет увеличения резервной области ssd или параметра over provisioning, из этого вытекает логичный вопрос, а можно ли увеличить самостоятельно данный параметр, ответ конечно же да, многие вендоры предлагают вам специальные родные утилиты для получения smart дисков, да и функционал увеличения over provisioning ssd, хотя можно и без них, я вам все покажу.

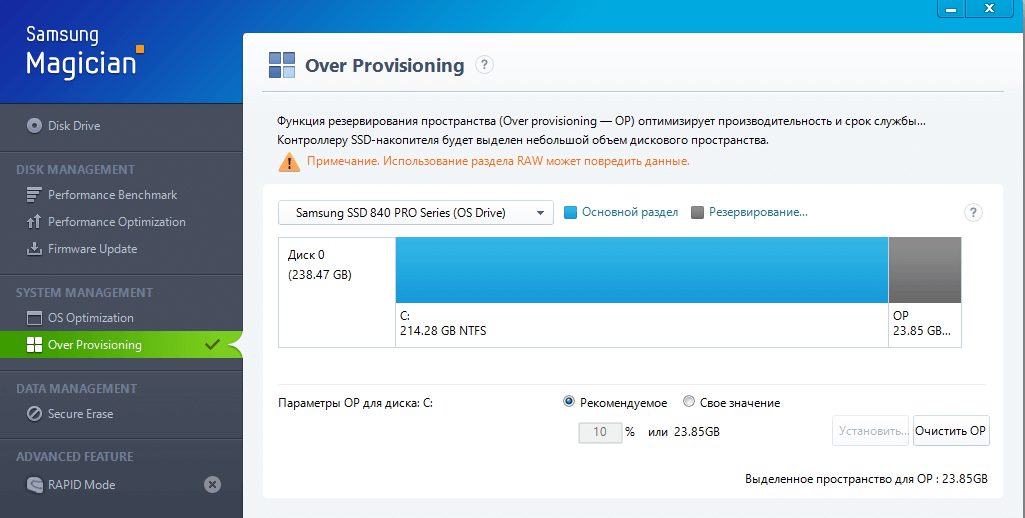

Утилиты производителей твердотельных дисков > приведу простой пример, если у вас ссд от samsung, у данного производителя есть программка Samsung Magician в которой вы можете в пункте System management > over provisioning задать нужный процент, в данном примере это 10 процентов, ниже мы рассмотрим как этот процент влияет на производительность ssd

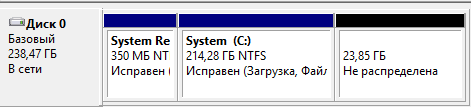

Не размеченное пространство > да именно его прячут и увеличивают специальные утилиты, так что если вы в ручную это сделаете, то это будет то же самое. Если мы говорим про windows, то когда вы инициализируете диск и в дальнейшем его форматируете, в Управлении дисками, то выбирайте не весь размер, а чтобы у вас было минимум 7-10 процентов, посмотрите по таблице выше, если это для серверов оставляем 30 процентов.

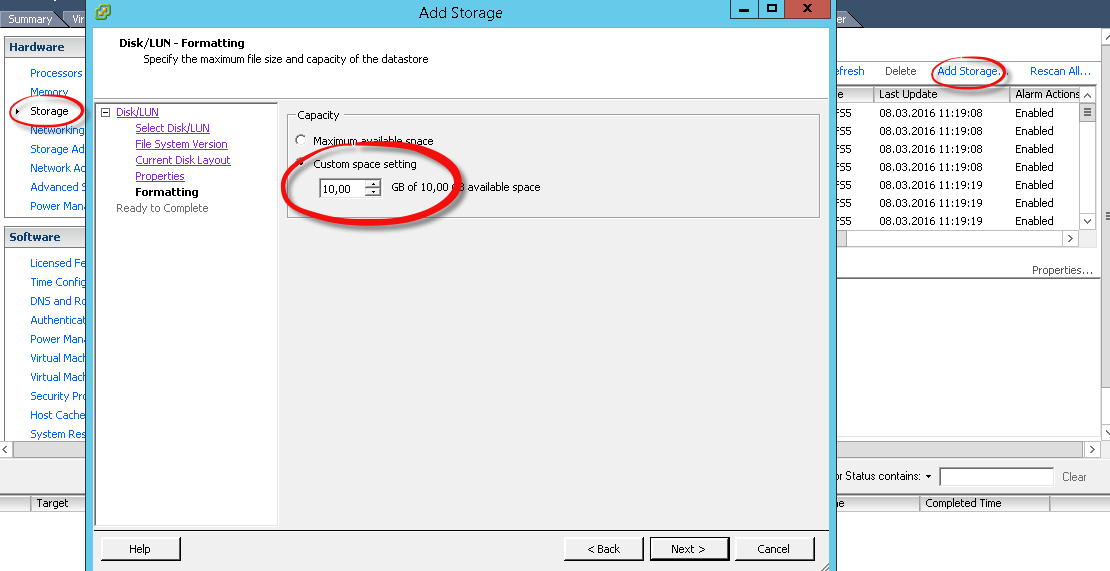

Если вы уже разметили диск и хотите ее высвободить, то можно сжать место на диске, если мы говорим про Vmware ESXI 5.5, то там так же можно при форматировании datastore выбрать нужное количество пространства, которое требуется использовать, и вы также оставляете не размеченным 30 процентов от общего объема. Напомню это делается Configuration > Storage > Add storage > Formating и выбираете там Custom space settings

Как видите второй способ более универсальный и не привязывает вас к тому или иному вендору.

На RAID контроллере > если у вас сервер и ваша дисковая подсистема построена на raid технологии, то можно сразу там отрезать он lun нужное количество объема, это будет более правильно, чем на уровне операционной системы.

Что еще влияет на производительность ssd

Тут приведу еще несколько примеров, что вам позволит увеличить производительность ssd на гипервизоре Vmware ESXi 5.5

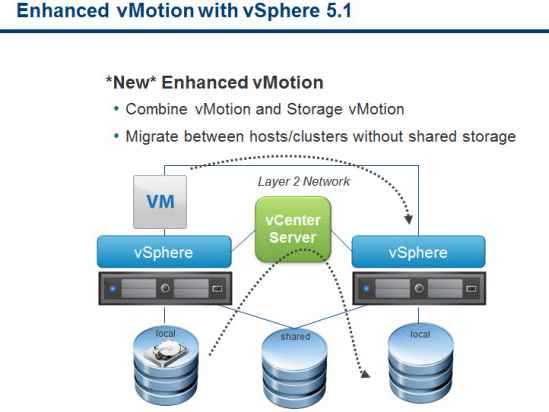

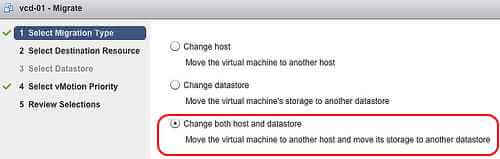

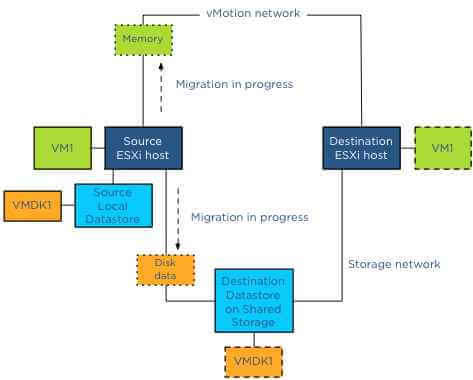

Как работает «Shared-Nothing» vMotion (Enhanced vMotion) в VMware vSphere 5.1.

Как знают многие пользователи, среди новых возможностей VMware vSphere 5.1 есть так называемая Enhanced vMotion или «Shared-Nothing» vMotion — функция, позволяющая переместить работающую виртуальную машину на локальном хранилище ESXi на другой хост и хранилище с помощью комбинации техник vMoton и Storage vMotion в одной операции. Это означает, что для такого типа горячей миграции не требуется общее хранилище (Shared Storage), а значит и затрат на его приобретение. Напомним также, что функция Enhanced vMotion включена во все коммерческие издания VMware vSphere, кроме vSphere Essentials.

Давайте посмотрим поближе, как это все работает:

Как включить VMotion В vmware Sphere 5.x и мигрировать vm-07

Сначала приведем требования и особенности работы vMotion при отсутствии общего хранилища:

- Хосты ESXi должны находиться под управлением одного сервера vCenter.

- Хосты должны находиться в одном контейнере Datacenter.

- Хосты должны быть в одной Layer 2 подсети (и, если используется распределенный коммутатор, на одном VDS).Enhanced vMotion — это исключительно ручной процесс, то есть функции DRS и Storage DRS не будут использовать миграцию машин без общего хранилища. Это же касается и режима обслуживания хоста (Maintenance Mode).

- Для одного хоста ESXi может быть проведено не более 2-х Enhanced vMotion единовременно. Таким образом, на хост ESXi может одновременно приходиться максимум 2 штуки Enhanced vMotion и 6 обычных vMotion (всего 8 миграций на хост) + 2 операции Storage vMotion, либо 2 Enhanced vMotion (так как это также задействует Storage vMotion).

- Enhanced vMotion может проводить горячую миграцию одновременно по нескольким сетевым адаптерам хоста ESXi, если они имеются и настроены корректно.

Миграция Enhanced vMotion может быть проведена только через тонкий клиент vSphere Web Client (в обычном клиенте эта функция недоступна — см. комментарии):

Как включить VMotion В vmware Sphere 5.x и мигрировать vm-08

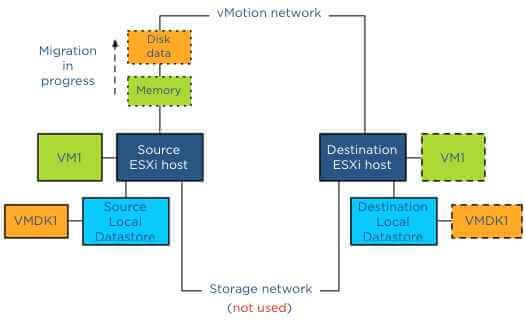

Миграция Enhanced vMotion идет по обычной сети vMotion (а не по Storage Network), по ней передаются и диск ВМ, и ее память с регистрами процессора для обеспечения непрерывной работоспособности виртуальной машины во время миграции:

Как включить VMotion В vmware Sphere 5.x и мигрировать vm-09

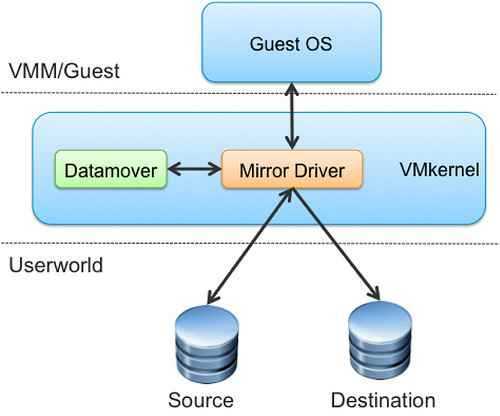

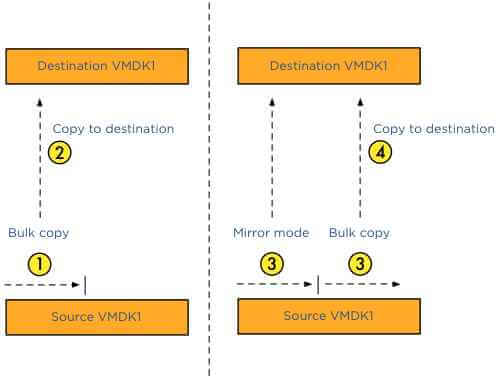

Теперь как это все работает последовательно. Сначала механизм Enhanced vMotion вызывает подсистему Storage vMotion, которая производит копирование данных по сети vMotion. Здесь важны 2 ключевых компонента — bulk copy и mirror mode driver.

Как включить VMotion В vmware Sphere 5.x и мигрировать vm-10

Сначала механизм bulk copy начинает копирование блоков данных с максимально возможной скоростью. Во время этого часть блоков на исходном хранилище хоста может измениться — тут и вступает в дело mirror mode driver, который начинает поддерживать данные блоки на исходном и целевом хранилище в синхронном состоянии.

Mirror mode driver во время своей работы игнорирует те блоки исходного хранилища, которые меняются, но еще не были скопированы на целевое хранилище. Чтобы поддерживать максимальную скорость копирования, Mirror mode driver использует специальный буфер, чтобы не использовать отложенную запись блоков.

Как включить VMotion В vmware Sphere 5.x и мигрировать vm-11

Когда диски на исходном и целевом хранилище и их изменяющиеся блоки приходят в синхронное состояние, начинается передача данных оперативной памяти и регистров процессора (операция vMotion). Это делается после Storage vMotion, так как страницы памяти меняются с более высокой интенсивностью. После проведения vMotion идет операция мгновенного переключения на целевой хост и хранилище (Switch over). Это делается традиционным способом — когда различия в памяти и регистрах процессора весьма малы, виртуальная машина на мгновение подмораживается, различия до передаются на целевой хост (плюс переброс сетевых соединений), машина размораживается на целевом хосте и продолжает исполнять операции и использовать хранилище с виртуальным диском уже целевого хоста.

Ну а если вы перемещаете виртуальную машину не между локальными дисками хост-серверов, а между общими хранилищами, к которым имеют доступ оба хоста, то миграция дисков ВМ идет уже по Storage Network, как и в случае с обычным Storage vMotion, чтобы ускорить процесс и не создавать нагрузку на процессоры хостов и сеть vMotion. В этом случае (если возможно) будет использоваться и механизм VAAI для передачи нагрузки по копированию блоков на сторону дискового массива.

Как включить VMotion В vmware Sphere 5.x и мигрировать vm-12

Заключение

VMware отказывается от поддержки SD-карт и USB-накопителей в качестве загрузочных накопителей. Конфигурация загрузки ESXi с использованием только SD-карты или USB-накопителя, без какого-либо постоянного устройства, устарела в vSphere 7 Update 3. В будущих выпусках vSphere эта конфигурация будет неподдерживаемой. Клиентам рекомендуется полностью отказаться от SD-карт или USB-накопителей. Если в настоящее время это невозможно, убедитесь в наличии SD-карт или USB-накопителей объемом не менее 8 ГБ и дополнительного локально подключенного устройства повышенной емкости объемом не менее 32 ГБ для раздела ESX-OSData Partition. Как объяснялось ранее, клиентам следует предпринять все действия, уменьшающие количество запросов ввода-вывода, отправляемых на SD-карту или USB-устройство, например, настроить раздел /scratch на постоянном устройстве, настроить дамп ядра сети и включить опцию toolsRamDisk. Кроме того, клиентам следует перейти на версию vSphere 7 Update 2c или более позднюю, которая содержит исправления проблем с USB и стеком хранения данных.

![Оптимизация операционной системы vmware esxi 6 для работы с схд [colobridge wiki]](http://smartshop124.ru/wp-content/uploads/2/a/e/2aec95f5a4e64b6aca90f75fc0b43bc7.jpeg)

![Оптимизация операционной системы vmware esxi 6 для работы с схд [colobridge wiki]](http://smartshop124.ru/wp-content/uploads/2/d/f/2df40929d4127938a9aa70ffce7f66ec.jpeg)