Проблема: не монтируются автоматически VMFS хранилища

Довольно часто, пользователи жалуются, что при подключении к ESXi 6.5 USB флешки, на которой уже имеется хранилище VMFS, оно автоматически не монтируется. Устройства отображается в /dev/disks, но само хранилище остается в офлайн режиме. Проблема видна в логе vmkernel.log.

2017-12-27T10:25:05.885Z cpu0:65593)VMWARE SCSI Id: Id for vmhba34:C0:T0:L00x50 0x00 0x00 0x00 0x00 0x00 0x00 0x01 0x41 0x53 0x32 0x31 0x31 0x352017-12-27T10:25:05.885Z cpu0:65593)ScsiDeviceIO: 9120: Get VPD 80 Inquiry for device «naa.5000000000000002» from Plugin «NMP» failed. Not supported2017-12-27T10:25:05.885Z cpu0:65593)ScsiDeviceIO: 9167: Get VPD 86 Inquiry for device «naa.5000000000000002» from Plugin «NMP» failed. Not supported2017-12-27T10:25:05.887Z cpu0:65593)ScsiDeviceIO: 7851: Could not detect setting of QErr for device naa.5000000000000002. Error Not supported.2017-12-27T10:25:05.891Z cpu0:65593)ScsiDeviceIO: 8365: Could not detect setting of sitpua for device naa.5000000000000002. Error Not supported.2017-12-27T10:25:05.898Z cpu1:65562)ScsiDeviceIO: 2948: Cmd(0x439500b60000) 0x1a, CmdSN 0x238 from world 0 to dev «naa.5000000000000002» failed H:0x0 D:0x2 P:0x0 Valid sense data: 0x5 0x24 0x0.2017-12-27T10:25:05.905Z cpu0:65593)LVM: 11136: Device naa.5000000000000002:1 detected to be a snapshot:2017-12-27T10:25:05.905Z cpu0:65593)LVM: 11143: queried disk ID: <type 2, len 14, lun 0, devType 0, scsi 0, h(id) 4847995147196820166>2017-12-27T10:25:05.905Z cpu0:65593)LVM: 11150: on-disk disk ID: <type 0, len 11, lun 0, devType 0, scsi 0, h(id) 8386732072863042940>2017-12-27T10:25:05.914Z cpu0:65593)ScsiEvents: 300: EventSubsystem: Device Events, Event Mask: 40, Parameter: 0x43029e372700, Registered!2017-12-27T10:25:05.914Z cpu0:65593)ScsiEvents: 300: EventSubsystem: Device Events, Event Mask: 200, Parameter: 0x43029e372700, Registered!2017-12-27T10:25:05.914Z cpu0:65593)ScsiDevice: 4265: Successfully registered device «naa.5000000000000002» from plugin «NMP» of type 0

Как видно из лога, устройство почему-то определилось как снапшот. Такая проблема почему-то появляется только в ESXi 6.5 и исправляется довольно просто. Выведем список снапшотов:

593b1a71-ade01512-51f6-f49d35640016Volume Name: usbflashVMFS UUID: 593b1a71-ade01512-51f6-f49d35640016Can mount: trueReason for un-mountability:Can resignature: trueReason for non-resignaturability:Unresolved Extent Count: 1

С помощью VMFS UUID смонтируем хранилище:

Хранилище должно появится в /vmfs/volumes и отобразится в vSphere клиенте.

What Is USB Passthrough?

VMware USB device passthrough is a feature that allows you to connect a physical USB device attached to a USB port of a physical ESXi server to a virtual machine as if the USB device was connected to a virtual machine directly. VMware passthrough is a feature available starting with ESXi 4.1.

Reasons vary for using passthrough for a USB device from the ESXi server to a guest operating system (OS) of a virtual machine. For example, you have an old scanner or printer that doesn’t have drivers for the latest Windows OS versions. You can install the old Windows version supported by the USB device and connect this device to a virtual machine. Another use case of this feature is when you need to copy files from/to a USB hard disk drive to/from a virtual machine directly with high speed. It may happen that users need to use software that is protected by hardware USB license keys on virtual machines.

Проброс USB устройств через Enhanced Session Mode в Hyper-V

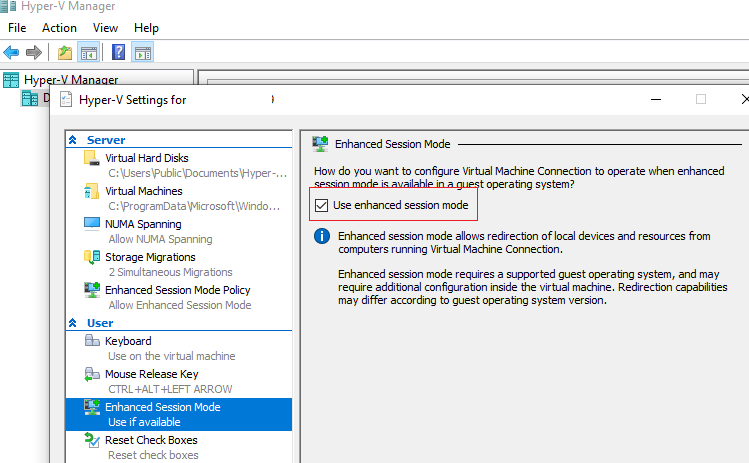

Сначала нужно включить Enhanced Session Mode в настройках сервера Hyper-V. Это можно сделать с помощью PowerShell:

Перезапустите службу Hyper-V Virtual Machine Management: Get-Service vmms | Restart-Service

В разделе Integration Services настроек ВМ нужно включить опцию Guest Services.

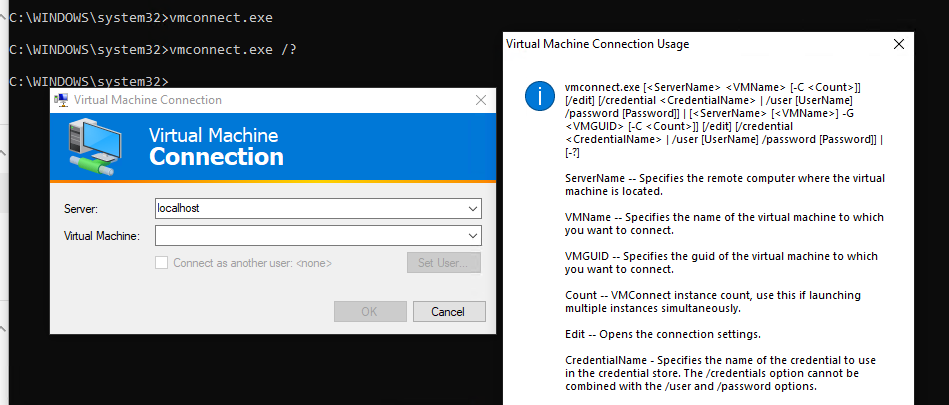

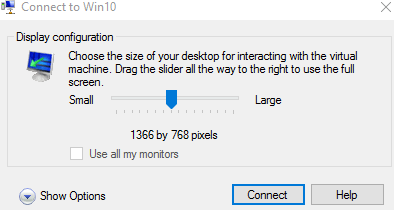

Для проброса USB устройства через Enhanced Session Mode нужно запустить консоль Hyper-V, выбрать ВМ и нажать Connect. Либо вы можете запустить утилиту vmconnect.exe (Virtual Machine Connection), указать Hyper-V сервер и имя ВМ (утилита поддерживает некоторые параметры командной строки, поэтому вы можете отдавать пользователям настроенный bat файл).

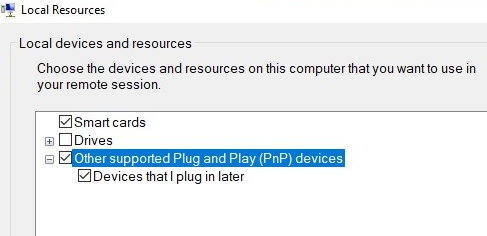

Выберите USB устройства на вашем компьютере, которое нужно пробросить в ВМ. Если устройства, которое вам нужно, сейчас не подключено, выберите опции Other supported Plug and Play (PnP) devices и Devices that I plug in later.

Теперь все подключённые к вашему компьютеру USB устройства будут автоматически доступны в консольной сессии виртуальной машины Hyper-V.

Основные возможности и ограничения Enhanced Session Mode

Методы проброса USB устройства через сеть (USB over IP или в RDP сессии) позволяют сохранить доступ к USB ключу при миграции виртуальной машины на другой хост (Hyper-V Live Migration /vMotion).

Подключение USB-устройств информации

Подключать USB-носитель необходимо при работающей машине. Если это флешка или USB-HDD, внизу окна VMware Workstation, на панели состояния жмём значок носителя данных и жмём «Connect (Disconnect from Host)».

Подключение USB-носителя подтверждаем в окошке, где VMware нас информирует о том, что флешка или USB-HDD будут безопасно отключены от хост-системы (т.е. установленной на компьютере Windows) и подключены к виртуальной машине. Жмём «Ок».

Другие типы USB-устройств – SD-карты в картридере, соединённые с компьютером смартфоны, планшеты и т.п. — подключаются по точно такому же принципу, только с использованием иного значка на панели состояния.

И после подключения USB-устройства можем искать его в проводнике установленной на виртуальную машину Windows.

Для отключения USB-устройства от виртуальной машины проделываем точно такое же действие – кликаем значок на панели состояния и жмём «Connect (Disconnect from Host)».

Машины VMware предусматривают альтернативный способ подключения/отключения USB-устройств – через меню «Виртуальная машина – Съёмные устройства». Здесь будет виден перечень USB-устройств, которые могут быть подключены к машине, по их названиям.

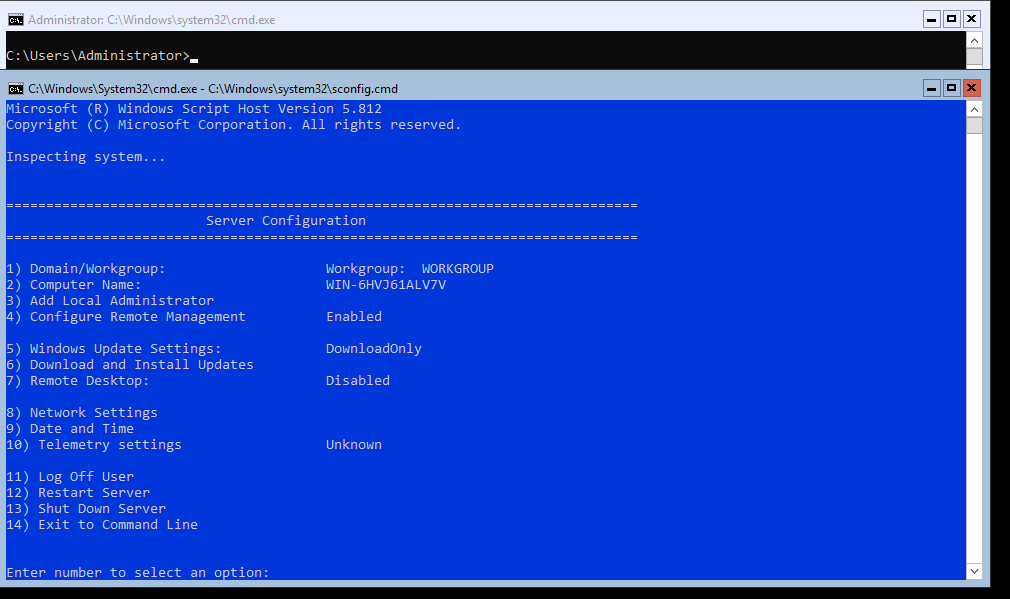

Утилита Sconfig: базованя настройка Hyper-V Server 2019/2016

После установки система требует сменить пароль администратора. Меняете пароль и попадаете в консоль гипервизора.

Обратите внимание, что у Hyper-V Server нет привычного графического интерфейса Windows. Большинство настроек сервера придется выполнять через командную строку

На рабочем столе два окна – стандартная командная строка и окно скрипта sconfig.cmd. С помощью данного скрипта можно выполнить первоначальную настройку сервера Hyper-V. В строку “Enter number to select an option:” введите номер пункта меню, с которым будете работать.

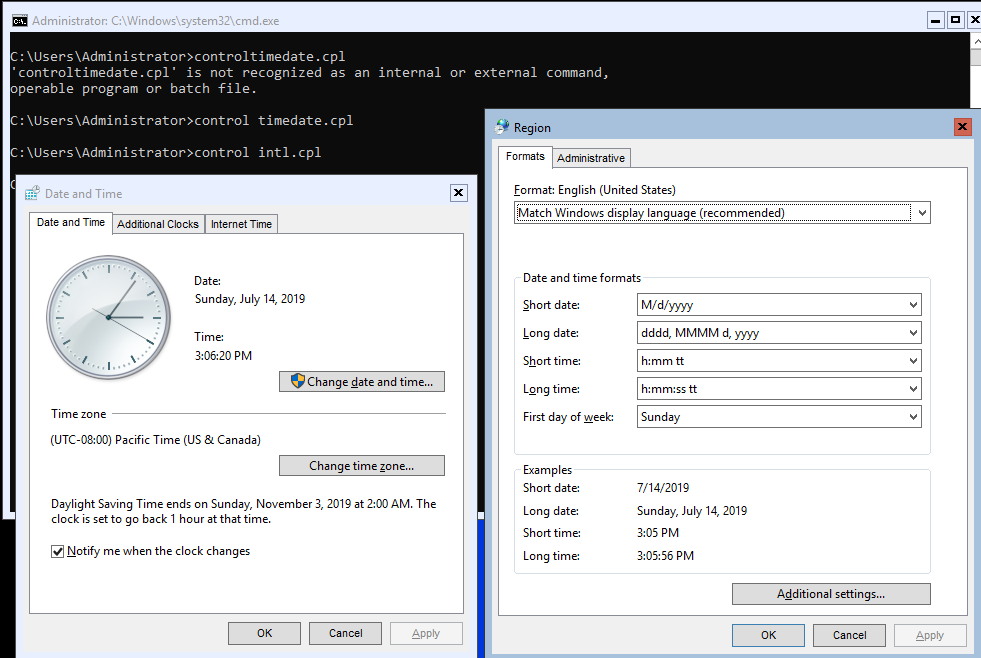

Дату, время и часовой пояс можно также настроить с помощью команды:

При этом открываются стандартные консоли.

Доступ к VMFS разделу из Ubuntu

В этой секции мы покажем, как смонтировать раздел с файловой системой VMFS на компьютере с установленной ОС Ubuntu (Live CD с Ubuntu в этом сценарии нам не подойдет, скачать серверные ubuntu с 10 по 14 версии и выше).

В первую очередь необходимо подключить физический диск с VMFS к компьютеру с Ubuntu.

Чтобы получить доступ к данным на VMFS томе, нам понадобиться установить специальный пакет vmfs-tools. Данный пакет позволяет получить доступ к файловой системе раздела VMFS с не ESX/ESXi хостов. Доступ возможен в режиме только на чтение (read-only).

Установим пакет следующей командой

apt-get install vmfs-tools

Примечание. В репозитариях Ubuntu пока доступна только версия vmfs-tools 0.2.1, основной ее недостаток – она умеет работать только с файловой системой VMFS v4. Если вам нужно смонтировать датастор с VMFS 5, придется самостоятельно скачать и установить версию vmfs-tools не ниже 0.2.5, например, здесь: http://ge.archive.ubuntu.com/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_i386.deb – пакет для 32 битной системы http://de.archive.ubuntu.com/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_amd64.deb – пакет для 64 битной системы

Качаем соответствующую версию пакета так:#wget http://de.archive.ubuntu.com/ubuntu/pool/universe/v/vmfs-tools/vmfs-tools_0.2.5-1_amd64.deb

И устанавливаем его:#dpkg -i vmfs-tools_0.2.5-1_amd64.deb

Если нужно будет удовлетворить зависимости, воспользуемся командой:#apt-get install vmfs-tools

После установки пакета, создадим каталог для точки монтирования:#mkdir /mnt/vmfs

Следующий шаг – нужно разобраться с разделами на дисках. Гипервизор ESXi при установке помимо, собственно, раздела для файлов виртуальных машин (VMFS) создает множество служебных разделов. Если версия ESXi 4 или ниже, или VMFS хранилище было обновлено с версии VMFS 4 до VMFS 5, а его размер не превышает 2 Тб, выведем список дисков и разделов так:#fdisk -l

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Как мы видим, раздел с файловой системой VMFS – /dev/sd3 (метка VMware VMFS) Важно. Т.к

в ESXi 5 используется VMFS v5 с таблицей разделов GPT (таблица GUID Partition Table используется вместо MBR, что позволяет создавать хранилища большего размера и пробрасывать RDM диски в режиме физической совместимости размером более 2 TB). Поэтому для просмотра таблицы разделов придется вместо fdisk использовать команду parted. Итак, выведем информацию о разделах так:#parted -l

Осталось смонтировать партицию с хранилищем VMFS:#vmfs-fuse /dev/sdb3 /mnt/vmfs

Выведем содержимое смонтированного раздела:#ls -all /mnt/vmfs

Итак, теперь мы видим все файлы виртуальных машин на VMFS хранилище, которое доступно нам для чтения, а это значит, что мы можем скопировать каталоги и/или отдельные файлы нужных виртуальных машин на отдельный диск и запустить их на другом гипервизоре ESXi. Доступ к VMFS разделу из Windows

Для доступа к данным на VMFS разделе из Windows, нам понадобится специальный открытый драйвер Open Source VMFS Driver, написанный на Java. Драйвер требует версию Java не ниже 6 и также позволяет монтировть VMFS-тома только для чтения Итак, качаем Open Source VMFS Driver по этой ссылке https://code.google.com/p/vmfs/ и распаковываем его в произвольный каталог (допустим C:\vmfs) Проверить работу java-приложения fvmfs.jar можно так:cd \vmfsjava -jar fvmfs.jar Определяем номер диска с хранилищем VMFS, подключенный к нашему Windows-компьютеру. Номер диска можно узнать с помощью консоли управление дисками или diskpart. (В нашем примере подключенный диск имеет индекс 1 – Disk1. Для драйвера утилиты fvmfs, этот диск будет именоваться так: \\.\PhysicalDrive1)

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Попытаемся получить информацию о диске: java -jar fvmfs.jar \\.\PhysicalDrive1 info

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Предоставим общий доступ к данному диску с помощью webdav: java -jar fvmfs.jar \\.\PhysicalDrive1 webdav

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Подключим расшаренный диск: net use * http://localhost:50080/vmfs

В системе должен появиться новый диск, с содержимым датастора VMFS, доступный для чтения.

Как получить доступ к данным на VMFS разделе из-под Windows / Linux

Вот так вот просто получить доступ к данным на VMFS разделе из-под Windows / Linux. До новых встреч. С вами был Иван Семин, автор и создатель IT портала Pyatilistnik.org

Проброс USB-устройств

Если имеется USB ключ защиты, или внешний накопитель, то удобней передавать в гостевую систему непосредственно само устройство, вне зависимости от того, к какому USB-порту это устройство подключено физически. Ведь при обслуживании, мы можем в следующий раз подключить в другой разъем.

# lsusb Bus 002 Device 002: ID 8087:8000 Intel Corp. Bus 002 Device 001: ID 1d6b:0002 Linux Foundation 2.0 root hub Bus 001 Device 002: ID 8087:8008 Intel Corp. Bus 001 Device 001: ID 1d6b:0002 Linux Foundation 2.0 root hub Bus 004 Device 001: ID 1d6b:0003 Linux Foundation 3.0 root hub Bus 003 Device 004: ID 051d:0002 American Power Conversion Uninterruptible Power Supply Bus 003 Device 003: ID 051d:0002 American Power Conversion Uninterruptible Power Supply Bus 003 Device 002: ID 046d:c00c Logitech, Inc. Optical Wheel Mouse Bus 003 Device 001: ID 1d6b:0002 Linux Foundation 2.0 root hub

Находим нужное нам устройство и берем его ID, который и будем использовать.

У меня стояла задача пробросить UPS-ы.

(Ситуация, на самом деле не типовая, скорее из серии как быть не должно: На сервер и сетевое оборудование поставлены 2 самый простых безперебойника для рабочих станций. UPS-ы оказались нежными и начинали голосить по поводу и без. Чтоб быстро подрезать им голос и пока не разбираться с управлением ИБП из Debian и было решено подцепить два безперебойника к Windows-гостям.)

На этом этапе я обнаружил, что оба нужных мне устройства имеют одинаковые ID… Но пробуем.

Пробрасываемые устройства прописываются в конфигурационном файле соответствующей виртуальной машины.

# nano /etc/pve/qemu-server/101.conf usb0: host=051d:0002

Перезагрузил. Устройство подцепилось, вроде бы все хорошо. Но тут вспоминаем, что второе устройство с таким же идентификатором. Как их различать? И действительно, опыт показал, что если в две виртуальные машины прописать один идентификатор, то они при включении будут отбирать друг у друга одно и то же устройство. Не смотря на то, что в host-системе есть несколько USB-устройств с таким идентификатором.

Вот тут то мы и вспоминаем, что есть другой способ проброса.

VMware PCI Passthrough (VMDirectPath): кидок USB контролера в ВМ

Інший, менш зручний метод надання доступу з ВМ до фізичного USB пристрою — кидок цілком USB контролера з ESXi хоста. Цей режим називається VMDirectPath. Для його використання чіпсет сервера повинен підтримувати Intel Directed I / O або AMD I / O Virtualization Technology (AMD IOMMU), і цей режим включений в налаштуваннях BIOS / UEFI.

Якщо на сервері встановлений тільки один USB контролер, при прокинув його в ВМ, ви не зможете використовувати локально підключені USB пристрої хоста (клавіатуру, миша). В цьому випадку краще додати в сервер додатковий PCI USB контролер.

Якщо на хості є кілька USB контролерів, ви можете ідентифікувати підключене USB пристрій і номер контролера через ESXi shell. Вивести список USB пристроїв:

У висновку команду потрібно знайти рядок USB накопичувача, наприклад:

Bus 002 Device 003: ID 0280: a00c Toshiba America Info. Systems, Inc.

Потім за номером контролера (Bus02 в цьому випадку) визначаємо root hub та його iSerial:

Bus 002 Device 001: ID 1d6b: 0002 Linux Foundation 3.0 root hub iSerial 1 0000: 00: 1D.0

2019-12-03T12: 06: 12.546Z cpu0: 33271) usb 4-2: new SuperSpeed USB device number 5 using xhci_hcd 2019-12-03T12: 06: 12.570Z cpu0: 33271) usb 4-2: New USB device found , idVendor = 0480, idProduct = b207 2019-12-03T12: 06: 12.570Z cpu0: 33271) usb 4-2: New USB device strings: Mfr = 1, Product = 2, SerialNumber = 3 2019-12-03T12: 06 : 12.570Z cpu0: 33271) usb 4-2: Product: External USB 3.0 2019-12-03T12: 06: 12.570Z cpu0: 33271) usb 4-2: Manufacturer: TOSHIBA 2019-12-03T12: 06: 12.570Z cpu0 : 33271) usb 4-2: SerialNumber: 20180528012427F 2019-12-03T12: 06: 12.571Z cpu0: 33271) usb 4-2: Vendor: 0x0480, Product: 0xb207, Revision: 0x0315 2019-12-03T12: 06: 12.571 Z cpu0: 33271) usb 4-2: Interface Subclass: 0x06, Protocol: 0x50 2019-12-03T12: 06: 12.571Z cpu0: 33271) WARNING: LinScsiLLD: scsi_add_host: 573: vmkAdapter (usb-storage) sgMaxEntries rounded to 255 . Reported size was 65535 2019-12-03T12: 06: 12.571Z cpu0: 33271) usb-storage 4-2: 1.0: interface is claimed by usb-storage 2019-12-03T12: 06: 12.571Z cpu0: 33271) usb 4-2: device is not availa ble for passthrough 2019-12-03T12: 06: 12.571Z cpu0: 33271) usb 4-2: usbfs: registered usb0405 2019-12-03T12: 06: 15.454Z cpu0: 33207) usb-storage 4-2: 1.0: suspended

Якщо USB диск не визначається ESXi хостом, перевірте що служба запущена:

Відповідно, ми отримали номер USB контролера, який потрібно прокинути в ВМ.

- Щоб прокинути фізичний USB контролер, виберіть ESXi хоста, на якому запущена ваша ВМ і перейдіть в розділ Manage -> Settings -> PCI Devices -> Edit;

- У списку PCI пристроїв знайдіть і виберіть потрібний USB контролер по його ID (в моєму прикладі 00: 1D.0, контролер називається C610 / X99 series chipset USB Enhanced Host Controller # 1 Intel Corporation);

- Статус USB контролера повинен змінитися з Unavailable (This device is not currently available for VMs to use) на Available (This device available for VMs to use). натисніть Ок.

- Для збереження змін потрібно перезавантажити хост ESXi.

- Після завантаження хоста, вимкніть ВМ і додайте нове PCI пристрій (New Device -> PCI Device -> Add). У випадаючому списку виберіть ваш USB контролер (наприклад 0000: 00: 1D | Intel Corporation USB Chipset …). Якщо при додаванні PCI пристрої в налаштуваннях ВМ з’явилося попередження: «Warning: The VM will not power on until its memory reservation equals its memory size», Потрібно зарезервувати пам’ять для ВМ.

- Увімкніть ВМ і переконайтеся, що в гостьовій ОС з’явився USB диск. У моєму випадку в гостьовій Windows Server 2012 R2 з’явився підключений USB диск «Toshiba External USB 3.0 USB Device».

У режимі VMDirectPath ви можете прокинути в ВМ до двох PCI пристроїв.

Hyper-V також підтримує режим проброса фізичних USB пристроїв в ВМ.

Conclusion

This blog post has covered ESXi USB passthrough, which is a useful feature supported by VMware vSphere. You can connect diverse devices attached to USB ports of physical ESXi servers to virtual machines directly and use them in guest operating systems of VMs just like you use these USB devices on regular physical computers. You can even migrate virtual machines using external USB devices connected to the parent ESXi host with vMotion to another host. Despite some limitations, the VMware USB passthrough feature adds more capabilities and flexibility in different situations.

VMware VM backup is important for those who use VMware vSphere. Download the Free Edition of NAKIVO Backup & Replication and try this universal data protection solution to protect your VMware vSphere VMs and other data in your environment.

Сценарии применения проброса устройств в Vmware Workstation

Перед тем. как я вам покажу сам не хитрый процесс, я бы хотел привести несколько сценариев, которые применимы к данной задаче.

Вы создали загрузочную флешку с Windows 10 или ESXI, не важно и хотели бы проверить, ее корректную работу

У вас есть USB-принтер, который в данный момент у вас работает на операционной системе Windows 7. Вам предлагают обновиться до Windows 10, но вы не знаете будет ли ваш старый принтер на нем корректно работать, в данном случае его проброс на виртуальную машину с десяткой сможет ответить на данный вопрос.

Проверка USB-токенов в таких продуктах, как КриптоПРО

Например я так тестировал проблемы с JaCarta ключиком.

Применений очень много и, что самое замечательное, если вы сломаете операционную систему внутри виртуальной машины, то это ни как не повлияет на вашу основную ОС.

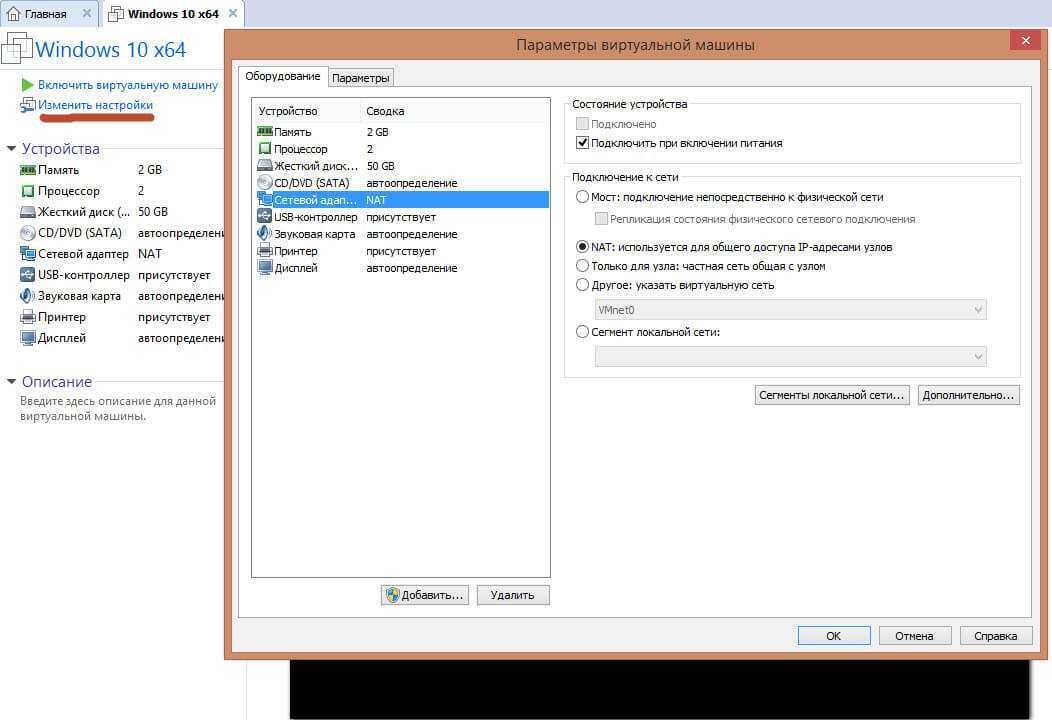

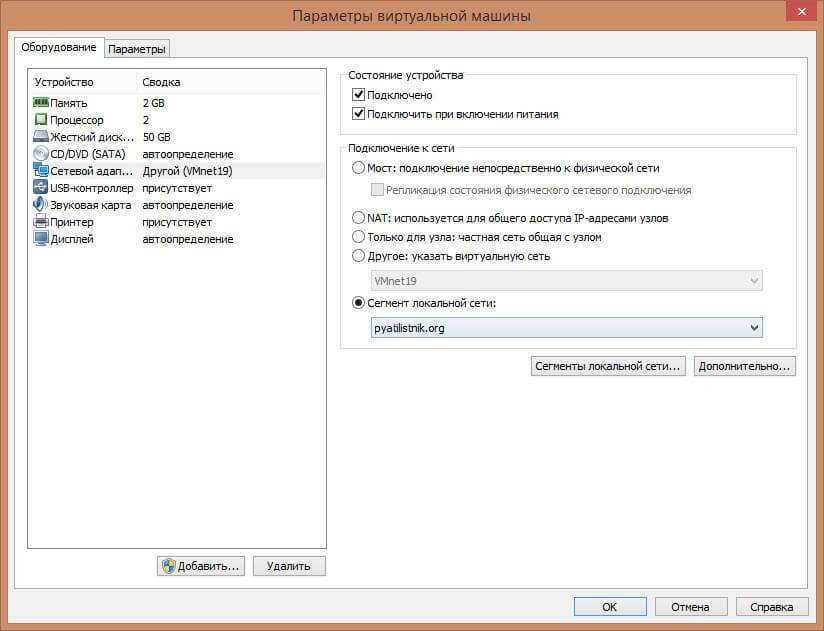

Как настроить сеть

Для этого заходим в параметры виртуальной машины и выбираете новый или существующий сетевой адаптер. По умолчанию стоит NAT, в данной настройке встроенный сервер DHCP, выдает вам внутренний ip адрес. Так же при установке VMware, у вас на физическом хосте создается два сетевых виртуальных интерфейса, через которые и проксируется трафик.

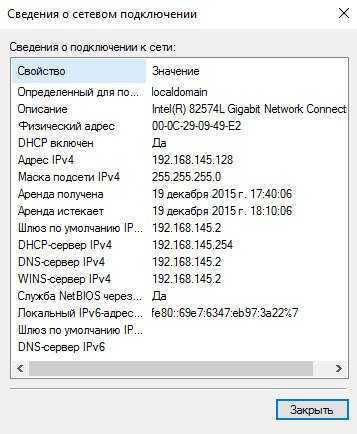

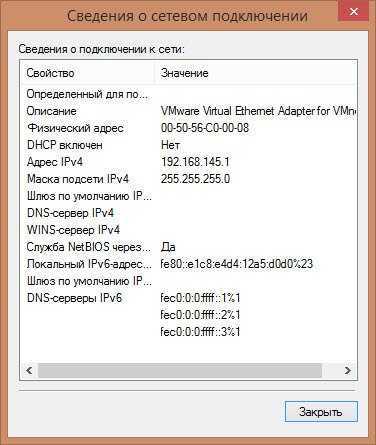

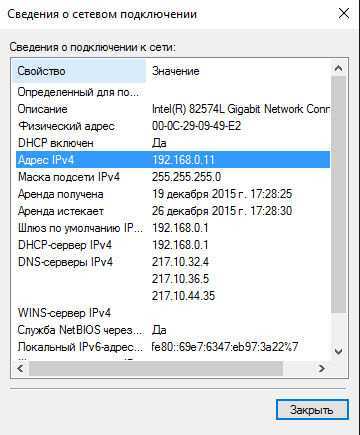

Вот настройки network интерфейса vm машинке:

- ip адрес 192.168.145.128

- основной шлюз 192.168.145.2

- DHCP сервер 192.168.145.254

Смотрим настройки тех сетевых адаптеров что у вас добавились на физическом компьютере:

ip адрес 192.168.145.1, как видите они из одного сегмента 145. Что позволяет вам получать интернет в виртуалке.

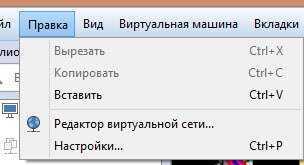

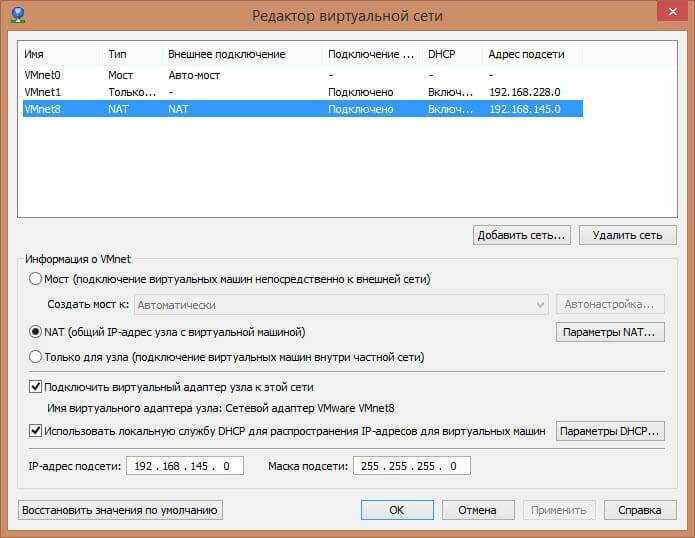

Настройки NAT можно посмотреть Правка > Редактор виртуальной сети

В данном редакторе можно задать и посмотреть параметры NAT

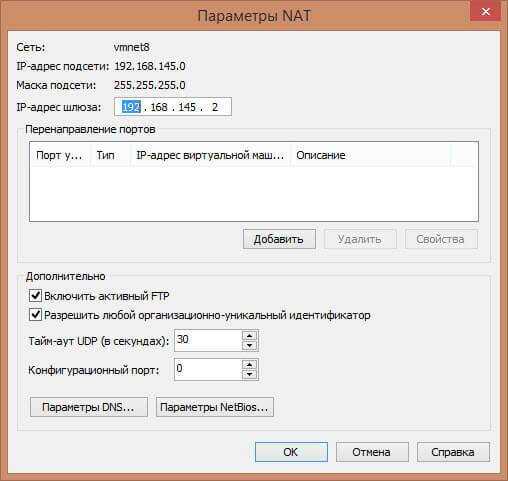

Щелкаем Параметры NAT, тут видно шлюз 192.168.145.2, при желании его можно заменить на нужный вам

Обратите внимание можно даже пробрасывать порты в нужную машинку

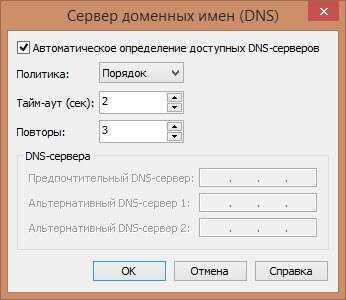

посмотреть параметры DNS. По умолчанию задаются автоматически, но можно задать и вручную.

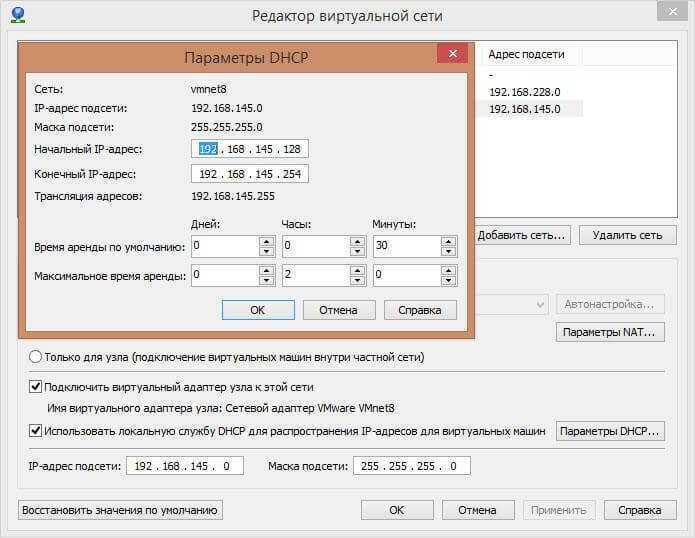

Параметры DHCP, в них указывается выдаваемый пул ip адресов, время аренды.

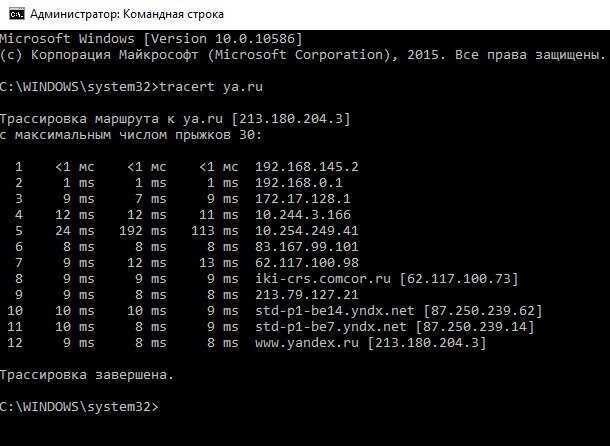

Давайте сделаем трассировку из нашей vm и посмотрим прохождение трафика. Как видите первым хопом идет шлюз, а дальше уже шлюз физического интерфейса, куда трафик попадает через тот виртуальный интерфейс с ip 192.168.145.1.

Режим моста

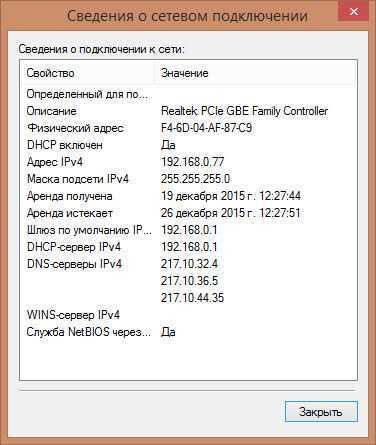

Вот параметры моего сетевого адаптера на физическом компьютере, как видите ip адрес 192.168.0.77 и шлюз 192.168.0.1

А вот настройки сети на виртуальной машине Wmware workstation 192.168.0.11 и с таким же основным шлюзом. Из чего можно сделать вывод, что настройка сети, произведена в одном сегменте и если бы у меня еще был ноутбук подключенный через WiFi, то я бы с него имел доступ на прямую к виртуальной машине, так как они были бы в одной локальной сети. Единственной, что все бы шло через физический адаптер компьютера где настроена виртуализация.

Только для узла

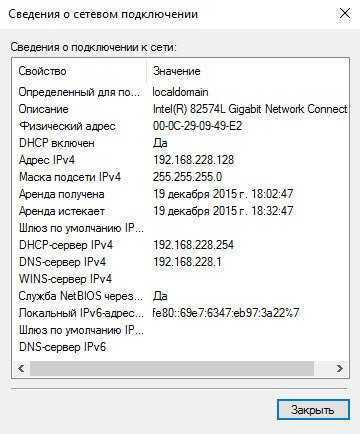

Продолжаем сетевые настройки VMWare Workstation и устанавливаем значение Только для узла. И так теперь ваша virtual machine получает ip адрес из локальной сети в которой только она и ваш физический компьютер.

На фихическом хосте.

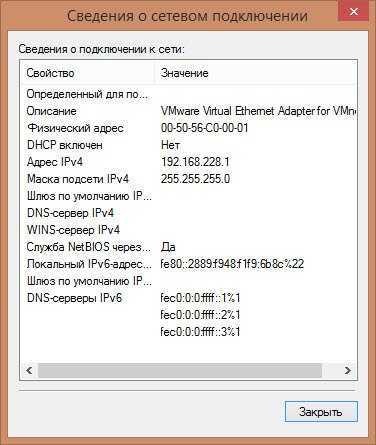

Другое: указать виртуальную сеть

В данном случае у вас тут может быть как и мост так и NAT, а может и изолированная сеть, все зависит от того как вы настроите в редакторе виртуальных сетей.

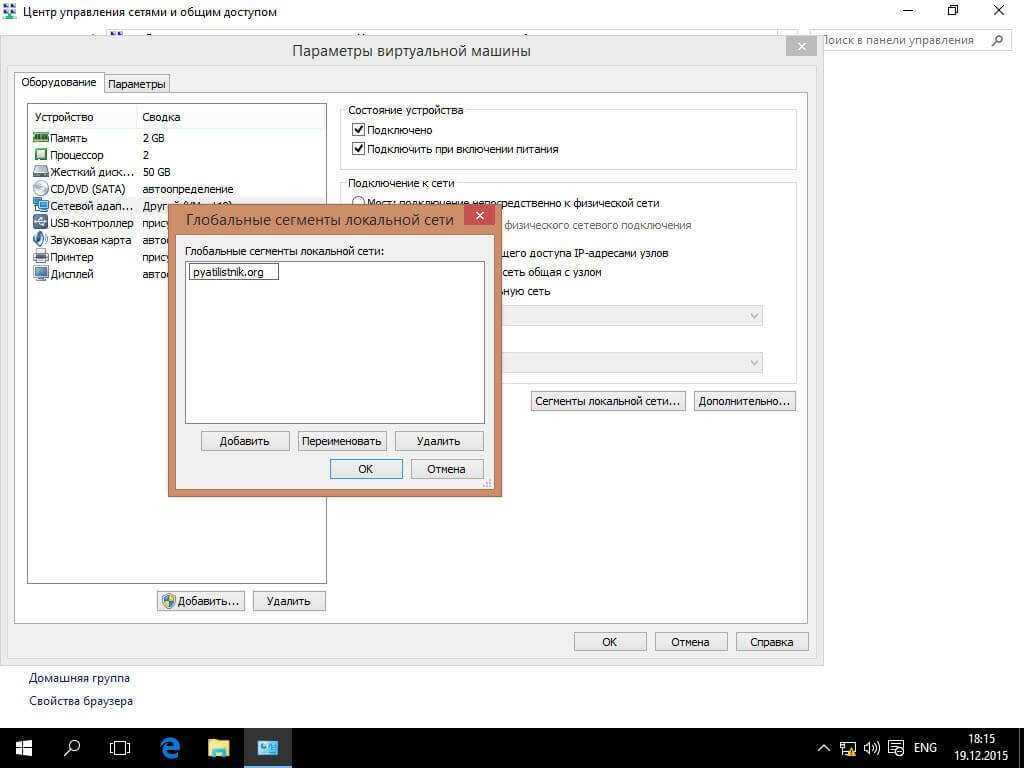

Сегмент локальной сети

Изолированная сеть, трафик между виртуальными машинами бегает внутри виртуального коммутатора и никуда более. Создается очень просто в настройках виртуалки. Жмем Сегменты локальной сети > Добавить. Задаем имя у меня пусть это будет как название сайта pyatilistnik.org.

Теперь выбираем созданный сегмент, подойдет для доменов active directory например.

Физическая и логическая коммутация

Совокупность оборудования и линий связи между СХД и серверами образуют так называемую SAN сеть. Отказоустойчивое подключение участников SAN сети подразумевает постоянное наличие хотя бы одного пути между инициатором (хост) и таргетом (СХД). Т.к. СХД сейчас практически поголовно имеют минимум два контроллера, каждый сервер должен иметь связь с каждым из них. В простейшем варианте серверы подключаются к СХД напрямую. Такой режим работы называют Direct Attach. СХД Qsan поддерживают такой режим работы. В этом случае каждый сервер должен иметь двухпортовую HBA для соединения с каждым контроллером СХД. Т.е. между сервером и СХД будет 2 пути. При наличии максимального количества опциональных портов в таком режиме к СХД можно подключить до 10 серверов через iSCSI или до 8 серверов через Fibre Channel.

В большинстве случаев серверы соединяются с СХД через коммутаторы. Для большей надежности их должно быть два (в общем случае их, конечно же, может быть больше, но это они все равно делятся на две группы – фабрики). Этим выполняется защита от выхода из строя самого коммутатора, линка и порта контроллера СХД/HBA. В этом случае каждый сервер и каждый контроллер СХД подключается к каждому коммутатору. Т.е. между каждым сервером и СХД будет 4 пути (в случае двух коммутаторов).

Важные замечания по поводу параметров SAN сети:

Фабрики между собой не соединяются для изоляции в случае возникновения ошибок в сети;

Если протокол iSCSI делит использование коммутаторов с другими сервисами, то весь трафик iSCSI должен быть помещен в изолированный VLAN;

Для протокола Fibre Channel необходимо настроить в коммутаторах зонирование по принципу «один инициатор – один или несколько таргетов» для исключения взаимовлияния серверов друг на друга;

Для iSCSI соединений со скоростью 10G и выше рекомендуется включить поддержку кадров большого размера (MTU=9000) с целью увеличения производительности

Важно помнить, что необходимо изменить MTU у всех участников сети: порты контроллера СХД, физические коммутаторы, виртуальные коммутаторы vSwitch, порты vKernel.. Для Qsan параметр MTU меняется на каждом порту каждого контроллера в меню iSCSI Ports

Для Qsan параметр MTU меняется на каждом порту каждого контроллера в меню iSCSI Ports

Для ESXi параметр MTU меняется у vSwitch: хост → Configure → Virtual Switches → Edit для конкретного коммутатора

Для vKernel параметр MTU меняется хост → Configure → Virtual Switches → Edit Settings для конкретного порта

Для получения инструкций по изменению MTU у физических коммутаторов рекомендуем обратиться к документации конкретного производителя.

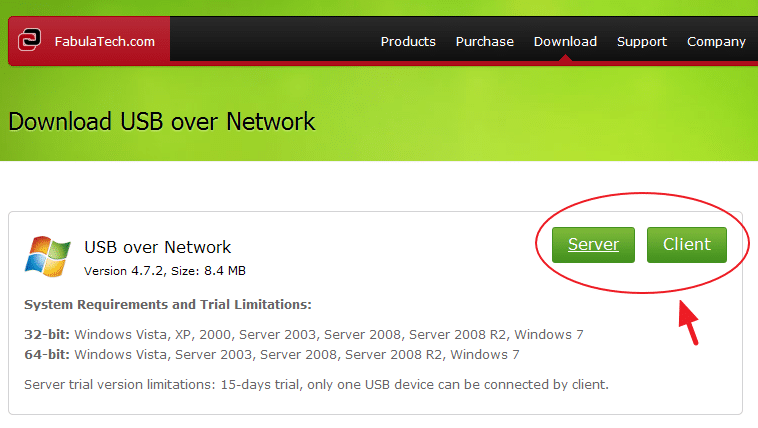

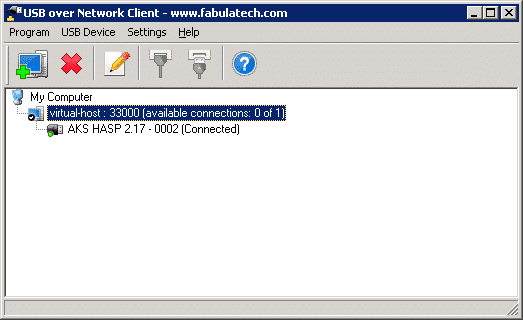

USB over Network

USB over Network от Fabulatech — отличная утилита, которая нам поможет решить проблему с пробросом портов USB через локальную сеть, даже как поможет, точнее она всё сделает, а вот мы уже ей слегка поможем =) Минусом является то, что она платная, но функционирует просто на отлично, потому можно потратиться =)

Установка и настройка USB over Network

Утилита состоит из двух частей: серверная и клиентская. Что логично, серверную мы ставим на системе, USB-порты которой мы хотим предоставить в доступ, а клиентская на системах, в которых мы хотим эти порты использовать. Замечу, что можно предоставлять в доступ не только порты, но и устройства, но данный момент нам не нужен, так как для нашей задачи необходимо именно использование порта! Настройка USB over Network несложная, давайте разберем все по порядку:

1. Для начала нам необходим скачать серверную и клиентскую части утилиты, вот страничка для скачивания

Страница скачивания USB over Network

2. Я перестраховался, потому поставил драйв для HASP и на сервер, и на клиент, хотя должно работать и в случае установки только на клиент! Втыкаем HASP-ключик в USB-нашей системы.

3. Устанавливаем скачанные серверную и клиентскую части на соответствующие системы.

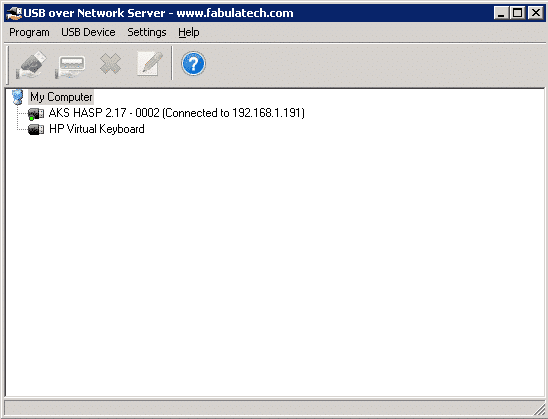

Серверная часть USB over Network

5. Запускаем серверную часть программы. Видим наши USB-устройства. Находим наш ключик, выделяем и жмем вторую сверху кнопку «Share USB-Port»!

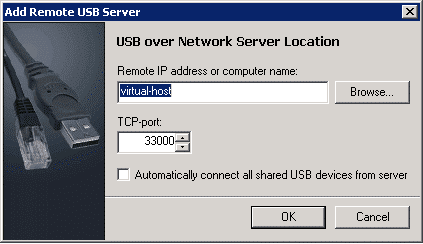

6. Запускаем в клиентской системе клиентскую часть утилиты. Жмем «Add USB Server», вводим в это окне данные нашего сервера USB. Можно поставить галочку внизу, чтобы автоматически подключать все устройства. В окне программы видим наши расшаренные устройства.

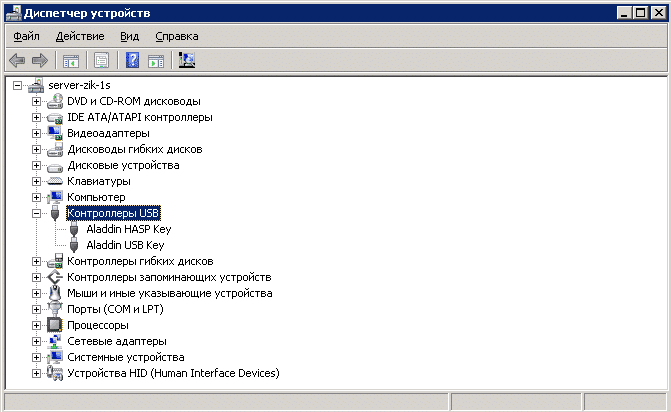

7. В диспетчере устройств должны появится наши ключики.

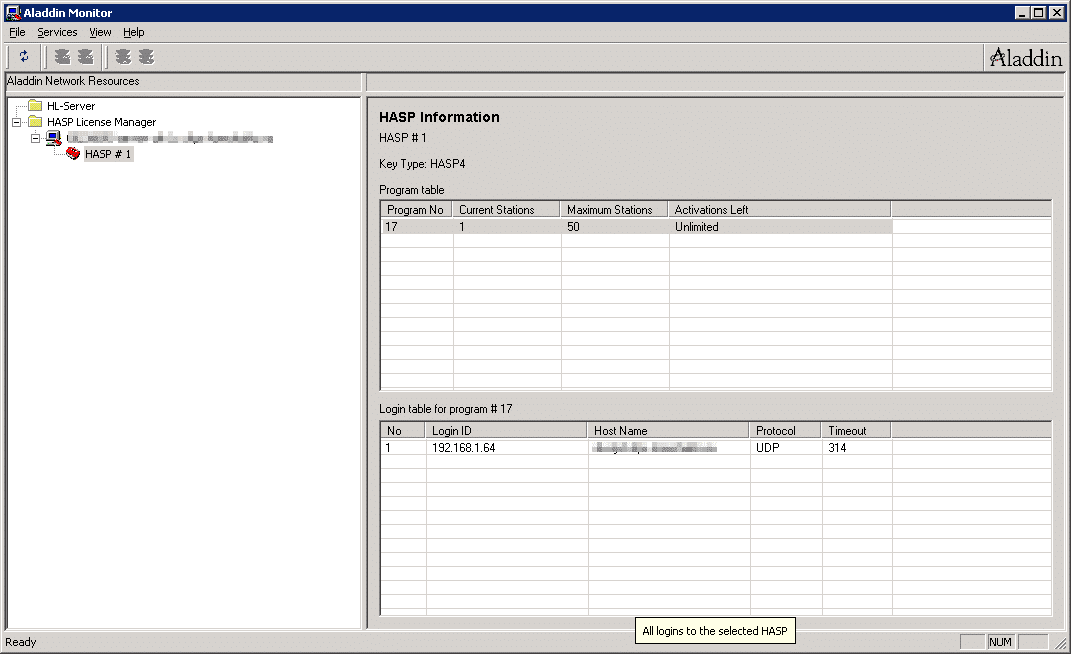

8. Запускаем менеджер лицензий Aladdin и видим наши лицензии!

Н адеюсь мой опыт кому-нибудь пригодится, ну а если возникли вопросы, плюс я мог что-то упустить, то комментируем-с.

Ограничения общих дисков VMware ESXI

Без некоторых нюансов все же не обошлось, хочу выделить некоторые ограничения при использовании общих дисков:

Самое главное, что у вас пропадет возможность производить миграцию виртуальной машины, обычный vMotion и Storage vMotion (Подробнее https://kb.vmware.com/s/article/1003797)

Например, при попытке сделать Storage vMotion вы получите ошибку:

Virtual machine is configured to use a device that prevents the operation: Device ‘SCSI controller 1’ is a SCSI controller engaged in bus-sharing

Если нужно будет мигрировать, то придется выключать виртуалку.

Вы не сможете на живую произвести расширение дисков, при попытке вы получите вот такую ошибку:

The disk extend operation failed: The virtual disk requires a feature not supported by this program. Hot-extend is currently supported only for VMFS flat virtual disks without snapshots opened in persistent mode.

Если вы вдруг разметите оба диска в NTFS на двух хостах и попытаетесь на них писать, создав на одном одну папку, а на втором вторую, то хосты эти папки не увидят, каждый свою, учтите, это вам не общий диск с синхронизацией файлов, Multi-Writer VMDK именно нужен для кластеризации.

Действия на стороне СХД

Необходимые настройки на СХД можно разделить на два этапа:

- Настройка интерфейсов

- Настройка пространства хранения

Настраивать интерфейсы требуется в основном в случае использования протокола iSCSI: необходимо задать IP адреса портов на вкладке iSCSI Ports. IP адреса портов должны быть из разных подсетей, чтобы однозначно маршрутизировался трафик на стороне хоста.

В случае использования интерфейса Fibre Channel ничего настраивать, как правило, не нужно.

Далее необходимо создать пространство хранения. Сначала создается пул – группа физических накопителей, работающих совместно. Пулов в пределах СХД может быть несколько. Накопители внутри пула объединяются в соответствии с выбранным при его создании уровнем RAID, обеспечивая заданную надежность. Пулы создаются на вкладке Pools → Create Pool, где запускается пошаговый мастер.