Импорт Hyper V

Что бы выполнить в Hyper V импорт виртуальной машины нажмите следующую кнопку:

После стартового окна нам нужно будет выбрать папку, куда мы экспортировали ВМ:

Проверяем, что имя ВМ совпадает с той, которую мы хотим импортировать:

На следующем окне у нас появляется три возможных пункта клонирования виртуальной машины Hyper V. Так как ВМ тоже имеет уникальные идентификаторы этот пункт очень важен:

- Регистрировать виртуальную машину по мету (Register the virtual machine in-place) — если файлы ВМ уже находятся там, где они должны и вы не планируете переносить их в новое место. Это может быть ВМ с подключенной флешки или iSCSI диска. В этом случае уникальный идентификатор не генерируется.

- Восстановить виртуальную машину (Restore the virtual machine) — в отличие от предыдущего пункта все файлы переносятся в новое место, которые вы укажете в следующем окне. Уникальный идентификатор так же остается прежним.

- Копировать виртуальную машину (Copy the virtual machine) — копирует ВМ с новым сгенерированным идентификатором. В следующем окне нужно будет указать куда копировать эти файлы. Этот случай используется когда мы используем шаблон ВМ.

Если в этот момент уже работает ВМ с этим идентификатором, то мы получим ошибку:

The operation failed because a virtual machine with the same identifier already exists. Select a new identifier and try the operation again.

Ошибка загрузки конфигурации виртуальной машины hyper v

Я выполню копирование машины, но остальные варианты аналогичны:

В случае с копированием мы можем выбрать новое расположение файлов чекпоинтов, конфигураций и кэша либо использовать установленное по умолчанию:

В этом окне выбирается расположение диска:

В этой ВМ адаптер подключен к другому коммутатору и его не существует на этом хосте гипервизора. Проверка коммутаторов идет по именам и если раньше коммутатор, на этом же хосте, назывался ‘Ext 1’, а затем был удален или переименован на ‘Ext 01’ вы тоже получите ошибку. Можно выбрать новый коммутатор или пропустить этот шаг:

На последнем шаге мы проверяем введенные данные и нажимаем кнопку подтверждения:

После этого ВМ импортируется и вам может понадобится подключиться к коммутатору и переименовать ее.

В обоих случаях вам нужно зайти в настройки ВМ:

Для переименовывания машины нужно зайти на вкладку «Имя»:

Если сетевых адаптеров у ВМ нет, то нужно зайти во вкладку добавления устройств и добавить сетевой адаптер:

А затем подключить к коммутатору:

После этого в Hyper V виртуальная машина будет подключена и ее можно запускать.

Windows Server 2019 Новые Функции Виртуальной Сети

Microsoft добилась огромных успехов с каждым выпуском Windows Server, введя новые функции для расширения и повышения мощности платформ Windows Server и Hyper-V.

Давайте рассмотрим две новые функции и усовершенствования в Windows Server 2019 в области сетей, которые, несомненно, будут функциями, которыми захотят воспользоваться ИТ-администраторы.

Зашифрованные виртуальные сети-шифрование виртуальной сети позволяет шифровать трафик виртуальной сети между виртуальными машинами, которые взаимодействуют друг с другом в подсетях, помеченных как включенное шифрование. Он также использует datagram Transport Layer Security (DTLS) в виртуальной подсети для шифрования пакетов. DTLS защищает от подслушивания, фальсификации и подделки любым лицом, имеющим доступ к физической сети. Это обычно известно как шифрование данных в полете и является механизмом безопасности, который повышает безопасность данных.

Повышение производительности сети для виртуальных рабочих нагрузок-новые улучшения в Windows Server 2019 помогают снизить загрузку ЦП хоста и увеличить пропускную способность. Кроме того, технология Коалесцирования сегмента приема (RSC) в vSwitch позволяет коалесцировать несколько сегментов TCP в меньшее количество, но больших сегментов. Обработка этих меньших, больших сегментов более эффективна, чем обработка многочисленных, маленьких сегментов.

В целом, Коалесценция сегмента Receive была доступна в Windows Server 2012, но предоставляла только аппаратные разгрузочные версии технологии. Однако эта технология была несовместима с виртуальными рабочими нагрузками. Как только сетевой адаптер подключается к vSwitch, этот тип RSC отключается.

Рабочие нагрузки, чей путь передачи данных пересекает виртуальный коммутатор, извлекают выгоду из этой функции.

Например:

- Хост виртуальные сетевые карты в том числе:Программно-Определяемая СетьХост Hyper-VСкладские Помещения Прямые

- Гостевые Виртуальные Сетевые Карты Hyper-V

- Программно-определяемые сетевые шлюзы GRE

- Контейнер

Сочетания клавиш

По умолчанию ввод с клавиатуры и щелчки мыши отправляются на виртуальную машину. Поэтому может потребоваться нажать клавиши CTRL + ALT + СТРЕЛКА ВЛЕВО, прежде чем использовать следующие сочетания клавиш.

| Сочетание клавиш | Описание |

|---|---|

| CTRL + ALT + стрелка влево | Отпускание кнопки мыши |

| CTRL + ALT + END | Эквивалент CTRL + ALT + DELETE на виртуальной машине |

| CTRL + ALT + BREAK | Переключение из полноэкранного режима обратно в оконный режим |

| CTRL+O | Открытие параметров для виртуальной машины |

| CTRL + S | Запускает виртуальную машину. |

| CTRL+N | Создание контрольной точки |

| CTRL+E | Возврат к контрольной точке |

| CTRL + C | Сделайте снимок экрана |

Создание виртуальной машины.

Жмём правой кнопкой по нашему компьютеру -> «Создать» -> «Виртуальная машина». (Рис.13)

Рис.13 — Создание виртуальной машины Hyper-V.

Откроется «Мастер создания виртуальной машины».(Рис.14)

- Нажмите кнопку «Готово», чтобы создать виртуальную машину с настройками по умолчанию.

- Нажмите кнопку «Далее», чтобы создать виртуальную машину с особыми параметрами конфигурации.

Жмём «Далее» чтобы выбрать нужные нам параметры.

Рис.14 — Мастер создания виртуальной машины.

Указываем Имя виртуальной машины и её расположение.(Рис.15)

Я решил протестировать при помощи Ubuntu Server 18.04.

По этому у меня так:

- Имя: ubuntuserver 18.04.

- Расположение: E:\hyper-v ubuntu server 18.04\.

Рис.15 — Указываем Имя виртуальной машины и её расположение.

Выбираем поколение виртуальной машины.(Рис.16)

В большинстве случаев стоит выбрать второе поколение, но если вы устанавливаете что-то 32-bitное то стоит выбрать — Поколение -1.

Лично у меня Ubuntu Server 18.04 64-bit с поддержкой UEFI, следовательно я выбираю — Поколение 2.

Рис.16 — Выбираем поколение виртуальной машины.

Выделяем количество оперативной памяти.(Рис.17)

Моей операционной системе хватит 1Gb ОЗУ => Я оставляю по умолчанию вписанные 1024 Mb. Идём «Далее».

Рис.17 — Выделяем количество оперативной памяти.

Выбираем к какому коммутатору будет подключен наш сетевой интерфейс.(Рис.18)

Выбираем наш «Hypernet» , идём «Далее».

Рис.18 — Настройка сети.

Создаём виртуальный жёсткий диск.(Рис.19)

Указываем Имя, Расположение и максимальный Размер файла виртуального HDD.

У меня так:

- Имя: ubuntu server 18.04.vhdx.

- Расположение: E:\hyper-v ubuntu server 1804\.

- Размер: 10 ГБ.

Рис.19 — Создаём виртуальный жёсткий диск.

Выбираем ISO-образ с которого будем устанавливать операционную систему.(Рис.20)

Выбираем пункт «Установить операционную систему из файла загрузочного образа» -> Нажимаем «Обзор» -> Выбираем iso-образ. -> Жмём «Далее».

Рис.20 — Выбор образа ОС.

Завершение работы мастера создания виртуальной машины.(Рис.21)

Жмём «Готово».

Рис.21 — Завершение работы мастера создания виртуальной машины.

Теперь в Диспетчере Hyper-V мы видим, только что созданную, виртуальную машину — ubuntu server 1804. (Рис.22)

Нажимаем на нее правой кнопкой мыши — > «Подключить».

Рис.22 — Диспетчер Hyper-V, Новая виртуальная машина.

Появится окно «Подключение к виртуальной машине.»(Рис.23)

Если вы хотите установить систему Windows то при нажатии на кнопку «Пуск» у вас должна запуститься установка, без каких любо ошибок.

Но для того чтобы запустился Ubuntu Server 18.04 Пришлось в «Файл» — > «Параметры» -> «Безопасность» отключить «Безопасную загрузку».(Рис.24)

Рис.23 — Подключение к виртуальной машине.Рис.24 — Отключаем Безопасную загрузку.

Включаем виртуальную машину.(Рис.25)

Рис.25 — Включаем виртуальную машину.

Всё отлично виртуальная машина запустилась. Нас встречает установщик Ubuntu Server 18.04.(Рис.26)

Рис.26 — Запущенная виртуальная машина. Установщик Ubuntu Server 18.04.

Требования к системе

помимо требований к системе для Windows Server и требований к системе для Hyper-V, дляназначения дискретного устройства требуется оборудование класса сервера, способное предоставлять управление операционной системой для настройки структуры PCIe (встроенного управления PCI Express). Кроме того, в случае сложности с корнем PCIe необходимо поддерживать «службы контроля доступа» (ACS), что позволяет Hyper-V принудительно выполнять весь трафик PCIe через ММУ ввода-вывода.

Эти возможности обычно не предоставляются непосредственно в BIOS сервера и часто скрываются за другими параметрами. Например, для поддержки SR-IOV требуются те же возможности, что и в BIOS. возможно, потребуется установить флажок «включить SR-IOV». Если вы не можете определить правильный параметр в BIOS, обратитесь к поставщику системы.

Чтобы обеспечить оборудование, которое может использовать оборудование для дискретного назначения устройств, наши инженеры составили , который можно запустить на узле с поддержкой Hyper-V, чтобы проверить, правильно ли настроен сервер и какие устройства поддерживают отдельное назначение устройств.

Initial Configuration Procedure

If you don’t want the back story, you can just scroll down to the Solution section.

The first thing I did was to configure the relevant ports on my physical switch as a LAG (link aggregation group) in LACP mode (link aggregation protocol, 802.3ax) mode. On the newly created LAG, I allowed the VLANs that my adapters will be members of as tagged traffic and set the default VLAN as untagged traffic. If your switch is a smart layer-2 device, consult with your manufacturer on how to perform these steps. If your switch isn’t a smart device or if it doesn’t have all these features, you can use “Switch Independent” for the “TeamingMode” and/or skip the steps about VLANs. If you use “Switch Independent” mode, you will not have access to the full array of aggregation capabilities. If you don’t use VLANs, your various traffic types will be easier to compromise and your switch ports will have to deal with some broadcast traffic intended for other networks.

After configuring the switches, I fired up PowerShell on the host and created the team with a virtual switch, using extremely original and creative names:

New-NetLbfoTeam -Name "Converged Fabric" -TeamMembers "Onboard", "PCI Top Left", "PCI Top Right", "PCI Bottom Right", "PCI Bottom Left" -TeamingMode LACP -LoadBalancingAlgorithm TransportPorts New-VMSwitch -Name "Converged Switch" -AllowManagementOS 0 -MinimumBandwidthMode Weight -NetAdapterName "Converged Fabric"

Next, I created virtual adapters on the switch for each of my Hyper-V roles, also with decidedly original and creative names:

Add-VMNetworkAdapter –ManagementOS –Name "Management" –SwitchName "Converged Switch" Add-VMNetworkAdapter -ManagementOS -Name "Cluster-CSV" -SwitchName "Converged Switch" Add-VMNetworkAdapter -ManagementOS -Name "LiveMigration" -SwitchName "Converged Switch" Add-VMNetworkAdapter -ManagementOS -Name "Storage" -SwitchName "Converged Switch"

I have smart layer-2 switches so I placed all but the management adapter into a separate VLAN. I left the management adapter alone, which means that its traffic will be untagged and, because of the above switch configuration, will travel on the default VLAN:

Set-VMNetworkAdapterVlan –ManagementOS –VMNetWorkAdapterName "Cluster-CSV" -Access –VlanId 15 Set-VMNetworkAdapterVlan –ManagementOS –VMNetWorkAdapterName "LiveMigration" -Access –VlanId 10 Set-VMNetworkAdapterVlan –ManagementOS –VMNetWorkAdapterName "Storage" -Access –VlanId 50

As previously mentioned, I’m going to use QoS to set reasonable minimums for my traffic. I certainly don’t mind if you duplicate these settings into your own environment, but be aware that these are the numbers I have determined are correct for my situation. You might need a different balance. You might want to set QoS on protocols instead of adapters. You might want to set maximums. You might have fancy hardware and want to use datacenter bridging instead. Whatever you do, you should keep the sum of your minimums at or below 100. The remaining space in mine will be left for virtual machines:

Set-VMNetworkAdapter –ManagementOS –Name "Management" –MinimumBandwidthWeight 5 Set-VMNetworkAdapter -ManagementOS -Name "Cluster-CSV" -MinimumBandwidthWeight 10 Set-VMNetworkAdapter -ManagementOS -Name "LiveMigration" -MinimumBandwidthWeight 40 Set-VMNetworkAdapter -ManagementOS -Name "Storage" -MinimumBandwidthWeight 40

My next step was to set IP addresses. I used NETSH when I did this initially, but since Microsoft seems to want to get rid of NETSH, I’ll present them here in their PowerShell equivalents:

New-NetIPAddress -InterfaceAlias "vEthernet (Management)" -IPAddress 192.168.25.11 -DefaultGateway 192.168.25.1 -PrefixLength 24 New-NetIPAddress -InterfaceAlias "vEthernet (Cluster-CSV)" -IPAddress 192.168.15.11 -PrefixLength 24 New-NetIPAddress -InterfaceAlias "vEthernet (LiveMigration)" -IPAddress 192.168.10.11 -PrefixLength 24 New-NetIPAddress -InterfaceAlias "vEthernet (Storage)" -IPAddress 192.168.50.11 -PrefixLength 24 Set-DnsClientServerAddress -InterfaceAlias "vEthernet (Management)" -ServerAddresses 192.168.25.5, 192.168.25.6

To wrap up, I used NETSH to set jumbo frames on all but the management adapter. I’ll show one for the sake of illustration, but keep in mind that while this command will be accepted, it doesn’t work:

NETSH INTERFACE IP SET SUBINTERFACE "vEthernet (Storage)" MTU=9000 STORE=PERSISTENT

Эффективность полосы пропускания

Jumbo-кадры могут повысить эффективность обработки Ethernet и сети на узлах за счет уменьшения накладных расходов протокола , как показано в следующем примере с TCP через IPv4 . Обработки накладных хозяев потенциально может снизить отношением размеров полезной нагрузки (примерно в шесть раз улучшение в этом примере)

Насколько это важно, зависит от того, как пакеты обрабатываются на хосте. Хосты, использующие механизм разгрузки TCP , получат меньше преимуществ, чем хосты, обрабатывающие кадры с помощью своего ЦП

Эффективность полосы пропускания на уровне кадра

| Тип кадра | MTU | Накладные расходы уровня 1 | Накладные расходы уровня 2 | Накладные расходы уровня 3 | Накладные расходы уровня 4 | Размер полезной нагрузки | Всего передано | Эффективность | ||

|---|---|---|---|---|---|---|---|---|---|---|

| Стандарт | 1500 | преамбула

8 байт |

IPG

12 байт |

заголовок кадра

14 байт |

FCS

4 байта |

Заголовок IPv4

20 байт |

Заголовок TCP

20 байт |

1460 байт | 1538 байт | 94,93% |

| Джамбо | 9000 | преамбула

8 байт |

IPG

12 байт |

заголовок кадра

14 байт |

FCS

4 байта |

Заголовок IPv4

20 байт |

Заголовок TCP

20 байт |

8960 байт | 9038 байт | 99,14% |

| Другие размеры кадров для справки | ||||||||||

| IEEE 802.11 | 7935 | Преамбула и заголовок PLCP

24 байта |

IPG

варьируется |

заголовок кадра и безопасность ovhd

52 байта |

FCS

4 байта |

Заголовок IPv4

20 байт |

Заголовок TCP

20 байт |

7895 байт | 8015 байт + размер IPG | <98,5% |

| IEEE 802.11 с подключением к Ethernet | 1500 | Преамбула и заголовок PLCP

24 байта |

IPG

варьируется |

заголовок кадра и безопасность ovhd

52 байта |

FCS

4 байта |

Заголовок IPv4

20 байт |

Заголовок TCP

20 байт |

1460 байт | 1580 байт + размер IPG | <92,4% |

Относительная масштабируемость пропускной способности сетевых данных в зависимости от скорости передачи пакетов сложным образом связана с размером полезной нагрузки на пакет. Как правило, по мере увеличения скорости передачи данных в линии размер полезной нагрузки пакета должен увеличиваться прямо пропорционально для поддержания эквивалентных параметров синхронизации. Однако это подразумевает масштабирование множества промежуточных логических схем на сетевом пути для обеспечения максимального требуемого размера кадра.

Рекомендации По Настройке Сети Hyper-V

Теперь, когда мы рассмотрели основы Hyper-V networking, виртуальные коммутаторы, требования к сети кластера Hyper-V, а также новые функции, найденные в виртуальной сети Windows Server 2019.

Давайте рассмотрим ключевые рекомендации по созданию сетей Hyper-V, которые следует учитывать при проектировании и создании инфраструктуры Hyper-V.

По возможности установите или обновите до последней версии Windows Server. С каждым выпуском Windows Server появляются новые и расширенные возможности, связанные с Hyper-V

Используйте современные физические сетевые карты, поддерживаемые корпорацией Майкрософт и имеющие возможность использовать удаленный прямой доступ к памяти (RDMA)

Убедитесь, что вы используете новейшие драйверы сетевых карт и прошивку

Используйте очередь виртуальных машин или сетевые карты с поддержкой VMQ – это обеспечивает преимущества аппаратной виртуализации, которые позволяют более эффективно подключаться к сети для TCP / IP / iSCSI и FCoE

Использование высокоскоростных сетей между узлами Hyper-V в кластере Hyper – V-используйте не менее 10 сетей GbE между узлами Hyper-V для обеспечения соответствия требованиям к пропускной способности и производительности между узлами кластера

Включить jumbo frames-Jumbo frames обеспечивает более эффективную сетевую связь в высокопроизводительных приложениях, поскольку позволяет увеличить количество кадров передачи и снизить загрузку процессора на хостах. Гигантские кадры обычно имеют размер 9000 байт или больше, в отличие от стандартного размера 1500-байтового кадра Ethernet

Не используйте разгрузку TCP Chimney или разгрузку IPsec с Windows Server 2016. Эти технологии устарели в Windows Server 2016 и могут повлиять на производительность сервера и сети

Чтобы отключить разгрузку TCP Chimney, из командной строки с повышенными правами выполните следующие команды:Netsh int tcp show global – показывает текущие настройки TCPnetsh int tcp set global chimney=disabled-отключает разгрузку TCP Chimney, если она включена

Убедитесь, что вы используете избыточные пути между узлами кластера Hyper-V, чтобы убедиться, что при сбое в одном пути существует другой путь, который можно использовать для связи

Планируйте свои сети Hyper – V-особенно с кластерами Hyper-V, планирование сетей очень важно. Убедитесь, что вы подготовили отдельные диапазоны IP-адресов/подсети, VLAN и т

д., для ваших специфичных для кластера сетей (живая миграция, кластер, хранилище, сети виртуальных машин)

Не используйте ReFS с общими томами кластера (CSV) – в настоящее время при использовании с CSV ReFS заставляет кластер работать в режиме перенаправления файловой системы, который отправляет все операции ввода-вывода по сети кластера на узел координатора Тома. Это может значительно повлиять на производительность

Понимание кластерной сети и ее использования – вы должны включить несколько сетей для кластерной связи, так как это обеспечивает встроенную устойчивость к кластерной связи, помогая обеспечить HA этой важной сетевой связи в кластере Hyper-V

Разрешите доступ к операционной системе управления только в тех сетях, которые необходимы. Поймите, как это создает специализированные сетевые соединения на узле Hyper-V

Используемая конвергентная сеть-конвергентная сеть позволяет гораздо эффективнее использовать физические адаптеры на хосте Hyper-V, а также доступную полосу пропускания.

Used Switch Embedded Teaming – With Switch Embedded Teaming позволяет создавать команду с помощью виртуального коммутатора вместо использования физической команды

При использовании Windows Server 2019 используйте Коалесценцию сегмента приема (RSC) для повышения производительности виртуальных рабочих нагрузок

С Windows Server 2019 используйте зашифрованные сети – это позволяет шифровать все сетевые коммуникации в виртуальных сетях для шифрования в полете

Подготовка к работе с Hyper-V

Львиная доля шумихи вокруг Windows 11 досталась её ужесточённым системным требованиям к компьютерному железу. Эти требования отметают большую часть пользовательских устройств и, по сути, делают Windows 11 массово доступной только для ПК и ноутбуков, выпущенных не ранее 2017 года. Для 11-й версии системы от Microsoft нужен совместимый процессор, объём «оперативы» не менее 4 Гб, BIOS UEFI с активной безопасной загрузкой. И самое противоречивое требование – наличие модуля безопасности TPM 2.0. Стоит ли Windows 11 того, чтобы делать апгрейд до всего этого, если ваш компьютер не соответствует новой системе – ответ на этот вопрос и даст работа с новой системой в среде Hyper-V.

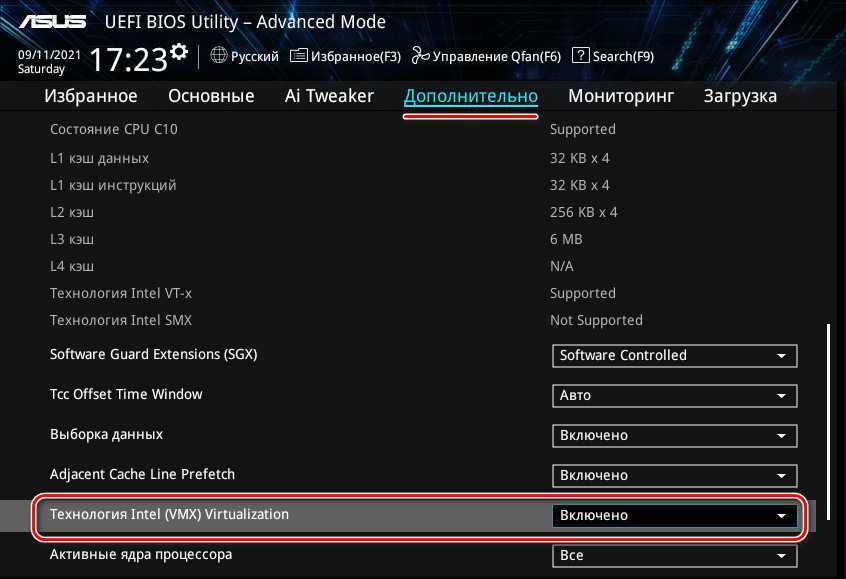

Для поставленной задачи нам нужен компьютер минимум с двумя ядрами процессора и «оперативкой» 8 Гб. В исключительных случаях можно 6 Гб, Hyper-V всё равно использует память динамически, просто тогда перед запуском виртуальной машины необходимо оставить в хост-системе минимум нагрузок. Дальше нам нужна включённая в BIOS технология виртуализации, если процессор поддерживает таковую, а большинство десктопных поддерживает. Чтобы включить, ищем виртуализацию в расширенных настройках BIOS. На платформах Intel ищем по названию Intel (VMX) Virtualization, возможно, VT-x или Intel Virtualization Technology. На платформах AMD ищем по названиям AMD Virtualization, возможно, SVM, либо же AMD-V.

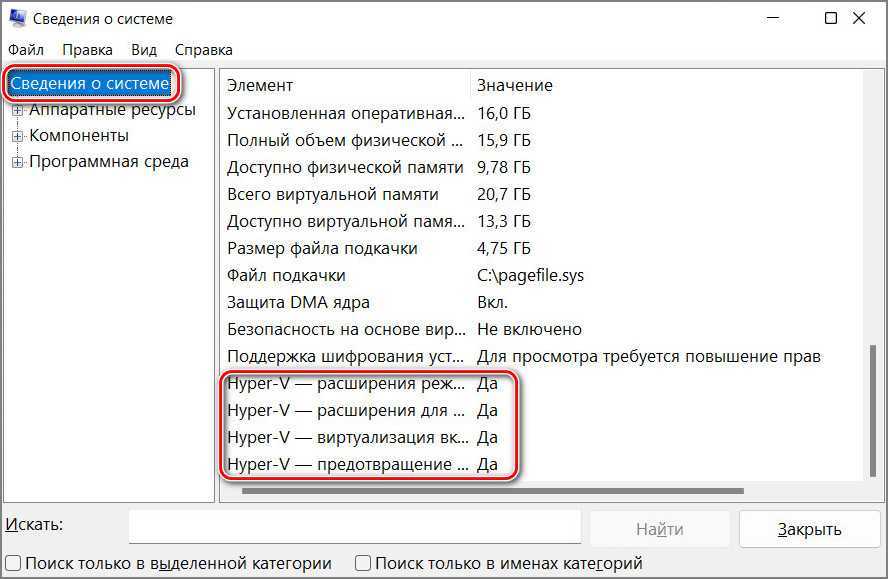

Далее смотрим, есть ли в Windows поддержка Hyper-V.

В системный поиск вводим:

msinfo32

В сведениях о системе смотрим, стоит ли значение «Да» для элемента Hyper-V.

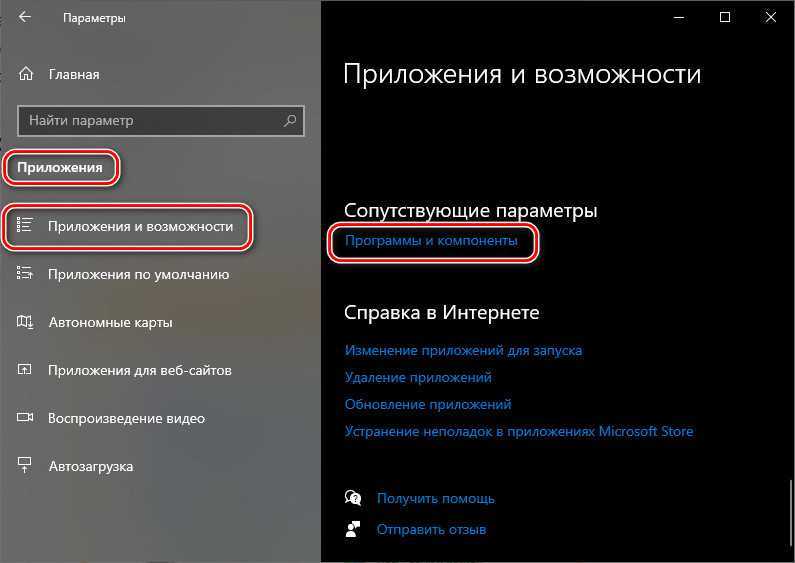

Hyper-V – опциональный системный компонент, для работы с ним его прежде необходимо активировать. Рассмотрим на примере активации в Windows 10.

В системных параметрах заходим в раздел приложений, открываем подраздел приложений и возможностей. В числе сопутствующих параметров кликаем отсылку «Программы и компоненты».

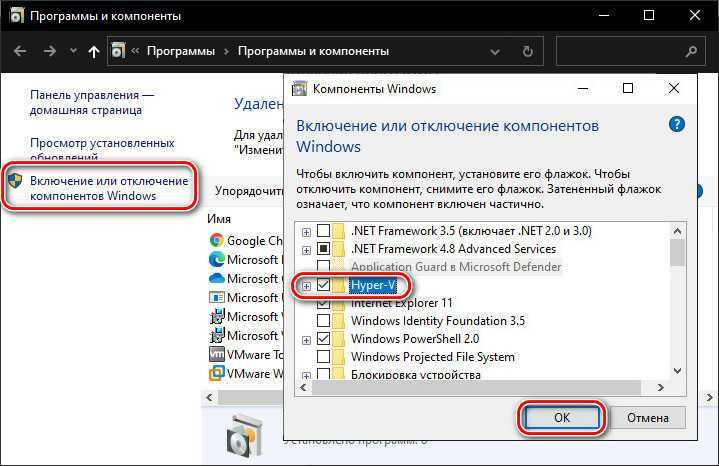

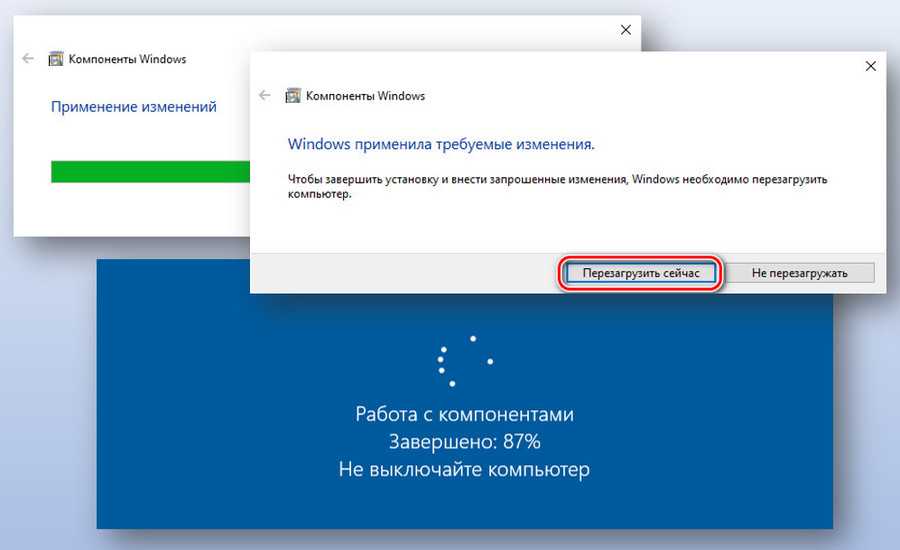

Откроется классический формат настроек программ, здесь нам нужно включение системных компонентов. В окошке компонентов ставим галочку Hyper-V, жмём «Ок».

Ожидаем применения изменений, перезагружаемся, ожидаем внедрения обновлений.

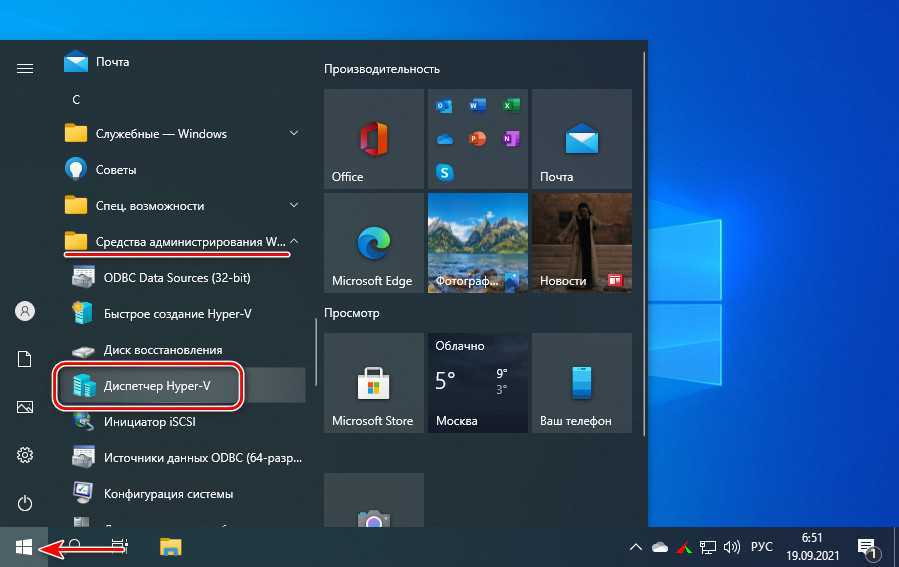

После запуска компьютера ищем Hyper-V через системный поиск или открываем в меню «Пуск», штатный гипервизор будет в числе средств администрирования.

Максимум для виртуальных машин

Эти максимальные значения применяются к каждой виртуальной машине. Не все компоненты доступны в обеих поколениях виртуальных машин. Сравнение поколений см . в статье как создать виртуальную машину поколения 1 или 2 в Hyper-V?

| Компонент | Максимум | Примечания |

|---|---|---|

| Контрольные точки | 50 | Реальное количество может быть ниже в зависимости от доступного объема хранения. Каждая контрольная точка хранится в виде AVHD-файла, использующего физическое хранилище. |

| Память | 12 ТБ для поколения 2;1 ТБ для поколения 1 | Сверьтесь с требованиями для конкретной операционной системы, чтобы определить минимальный и рекомендуемый объемы. |

| Последовательные порты (COM) | 2 | Отсутствует. |

| Объем физических дисков, напрямую подключенных к виртуальной машине | Различается | Максимальный размер зависит от операционной системы на виртуальной машине. |

| Виртуальные адаптеры Fibre Channel | 4 | Мы рекомендуем подключать каждый виртуальный адаптер Fibre Channel к отдельной виртуальной сети SAN. |

| Виртуальные гибкие диски | 1 виртуальный гибкий диск. | Отсутствует. |

| Емкость виртуального жесткого диска | 64 ТБ для формата VHDX;2040 ГБ для формата VHD | Каждый виртуальный жесткий диск хранится на физическом носителе в виде файла .VHDX или .VHD в зависимости от используемого формата виртуального жесткого диска. |

| Виртуальные IDE-диски | 4 | Загрузочный диск (иногда называемый загрузочным диском) должен быть подключен к одному из устройств IDE. Диск запуска может быть виртуальным жестким диском или физическим диском, напрямую подключенным к виртуальной машине. |

| Виртуальные процессоры | 240 для поколения 2;64 для поколения 1;320 доступна для ОС узла (корневой раздел) | Число виртуальных процессоров, поддерживаемых операционной системой на виртуальной машине, может быть ниже. Дополнительные сведения см. в сведениях, опубликованных для конкретной операционной системы. |

| Виртуальные SCSI-контроллеры | 4 | Для использования виртуальных устройств SCSI требуются службы Integration Services, доступные для поддерживаемых гостевых операционных систем. дополнительные сведения о поддерживаемых операционных системах см. в разделе поддерживаемые виртуальные машины Linux и FreeBSD и поддерживаемые Windows гостевые операционные системы. |

| Виртуальные SCSI-диски | 256 | Каждый SCSI-контроллер поддерживает до 64 дисков; это означает, что в каждой виртуальной машине может быть настроено до 256 виртуальных SCSI-дисков (4 контроллера x 64 диска). |

| Виртуальные сетевые адаптеры | Windows Сервер 2019 и более поздние версии поддерживают всего 68:

Windows Server 2016 поддерживает 12:

|

Сетевой адаптер, относящийся к Hyper-V, обеспечивает лучшую производительность и требует наличия драйвера, входящего в службы Integration Services. дополнительные сведения см. в статье планирование сетей Hyper-V в Windows Server. |

![Добавление компонентов [установка] hyper-v в windows 10 | создание виртуальной машины | itdeer.ru](http://smartshop124.ru/wp-content/uploads/0/a/1/0a180d23bf8843ea11d32ca03aa7b5be.jpeg)

![Добавление компонентов [установка] hyper-v в windows 10 | создание виртуальной машины](http://smartshop124.ru/wp-content/uploads/d/c/2/dc2067d2033b647bf8ea74007e4ea605.jpeg)

![Добавление компонентов [установка] hyper-v в windows 10 | создание виртуальной машины | itdeer.ru](http://smartshop124.ru/wp-content/uploads/0/2/6/02665eb26976d93878d66cc6db629f6d.jpeg)