Central Management

While many people start with a single node, Proxmox Virtual Environment can scale out to a large set of clustered nodes. The cluster stack is fully integrated and ships with the default installation. To manage all tasks of your virtual data center, you can use the central, web-based management interface.

Web-based management interface

Proxmox VE is easy to use. You can do all management tasks with the integrated graphical user interface (GUI), there is no need to install a separate management tool. The central web interface is based on the ExtJS JavaScript framework and can be accessed from any modern browser. In addition to management tasks, it also provides an overview of the task history and system logs of each node. This includes running backup tasks, live migration, software-defined storage, or HA triggered activities. The multi-master tool allows you to manage your whole cluster from any node of your cluster; you don’t need a dedicated manager node.

Unique multi-master design

To simplify the management of a cluster, you can carry out maintenance tasks cluster wide, from any node. The integrated web-based management interface gives you a clean overview of all your KVM guests and Linux containers across your cluster. You can easily manage your VMs and containers, storage or cluster from the GUI. There is no need to install a separate, complex, and pricey management server.

Proxmox Cluster File System (pmxcfs)

Proxmox VE uses the unique Proxmox Cluster File System (pmxcfs), a database-driven file system developed by Proxmox.

The pmxcfs enables you to synchronize configuration files across your cluster. By using Corosync, these files are replicated in real time to all cluster nodes. The file system stores all data inside a persistent database on disk, nonetheless, a copy of the data resides in RAM. The maximum storage size is currently 30MB — more than enough to store the configuration of several thousands of VMs.

Proxmox VE is the only virtualization platform using this unique cluster file system pmxcfs.

Live/Online Migration

With the integrated live/online migration feature, you can move running virtual machines from one Proxmox VE cluster node to another, without any downtime or noticeable effect from the end-user side.

Administrators can initiate this process from either the web interface or the command line. This enables you to minimize downtime, in case you need to take the host system offline for maintenance.

Command Line Interface (CLI)

For advanced users who are used to the comfort of the Unix shell or Windows Powershell, Proxmox VE provides a command line interface to manage all the components of your virtual environment. This command line interface has intelligent tab completion and full documentation in the form of UNIX man pages.

REST API

Proxmox VE uses a RESTful API. We chose JSON as the primary data format, and the whole API is formally defined using JSON Schema. This enables fast and easy integration for third party management tools, such as custom hosting environments.

Role-based Administration

You can define granular access to all objects (like VMs, storage, nodes, etc.) by using the role-based permission management system. This allows you to define privileges and helps you to control access to objects. This concept is also known as access control lists: Each permission specifies a subject (a user group, or API token) and a role (set of privileges) on a specific path.

СОЗДАНИЕ ВИРТУАЛЬНЫХ МАШИН

Обратите внимание, что веб интерфейс Proxmox VE позволяет создавать виртуальные машины двух типов:

- VM это полностью виртуализированная машина, созданная из ISO образа, который необходимо загрузить в хранилище Proxmox VE;

- CT – паравиртуализированная машина на ядре Linux, шаблоны которой необходимо сначала загрузить и установить в хранилище Proxmox VE.

Загрузите CT, предложенные на сайте Proxmox VE. Выберите небольшой дистрибутив, например CentOS 7, и поместите его в хранилище home:

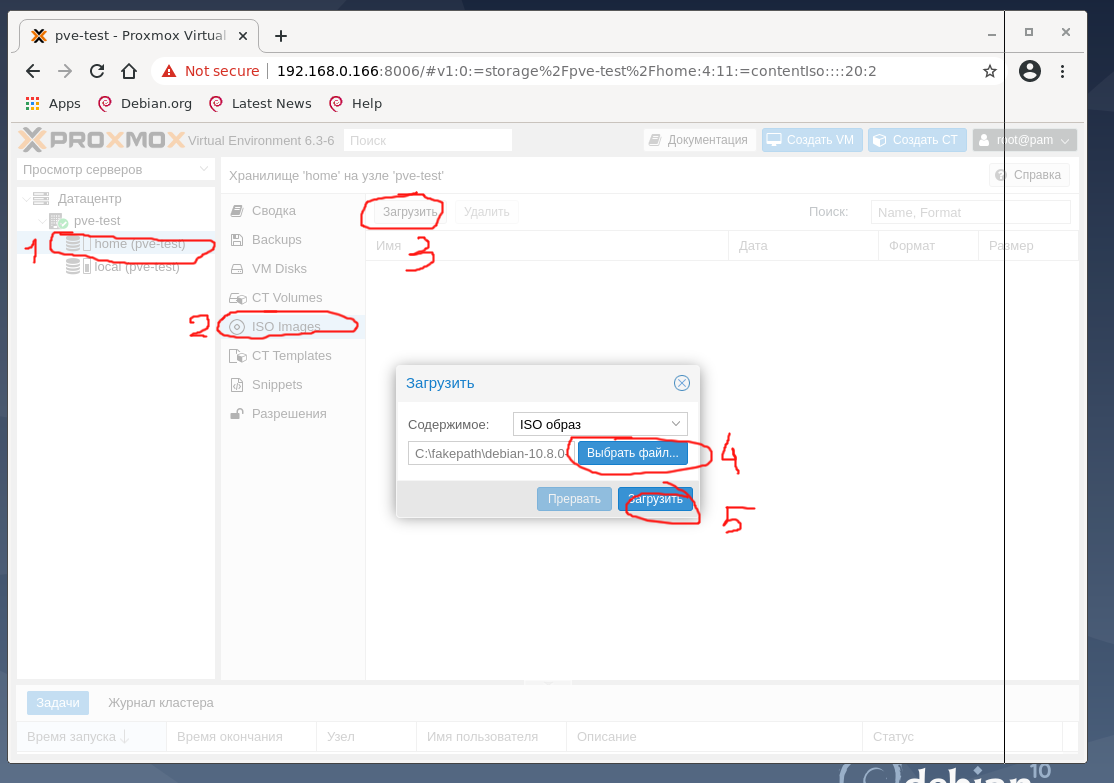

Параллельно можно поставить загрузку дистрибутива debian10 netinstall ISO со своего рабочего компьютера в хранилище home. Для этого выберите в WEB-интерфейсе хранилище home, тип хранения выберите ISO Images и нажмите кнопку Загрузить, в появившемся окне выберите файл образа ISO со своего компьютера и нажмите ОК.

Так же информацию можно загрузить с usb-хранилища, с CD-Диска (на тестовой машине он подключён), передать по сети с помощью FTP, Samba, http. Для этого можно использовать из консоли соответствующие утилиты wget, curl, ftp или файловый менеджер Midnight Commander:

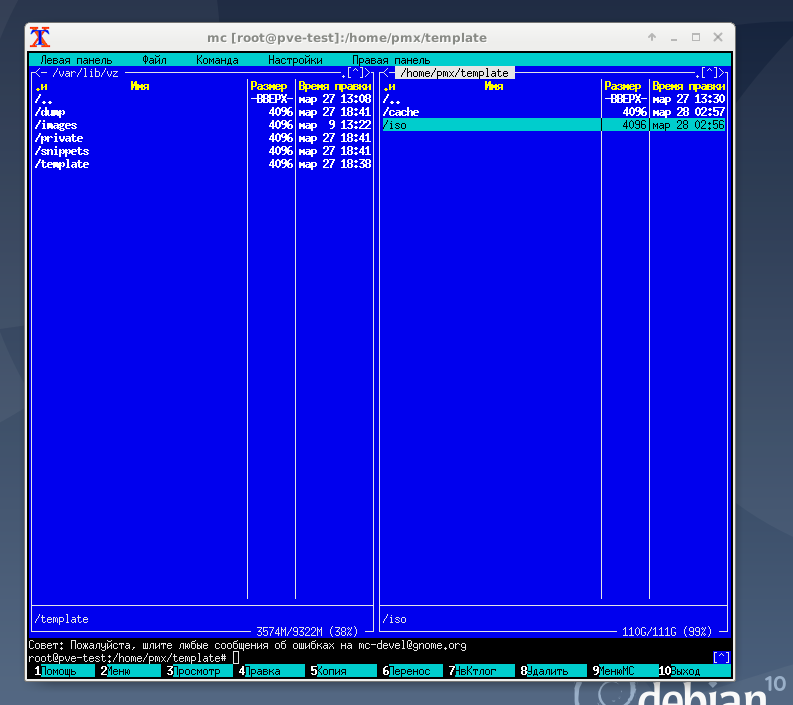

Шаблоны и загрузки расположены по путям хранилищ local: /var/lib/vz или home: /home/pmx. Вы можете напрямую копировать в соответствующий раздел файлы. Логическая структура размещения информации на скриншоте:

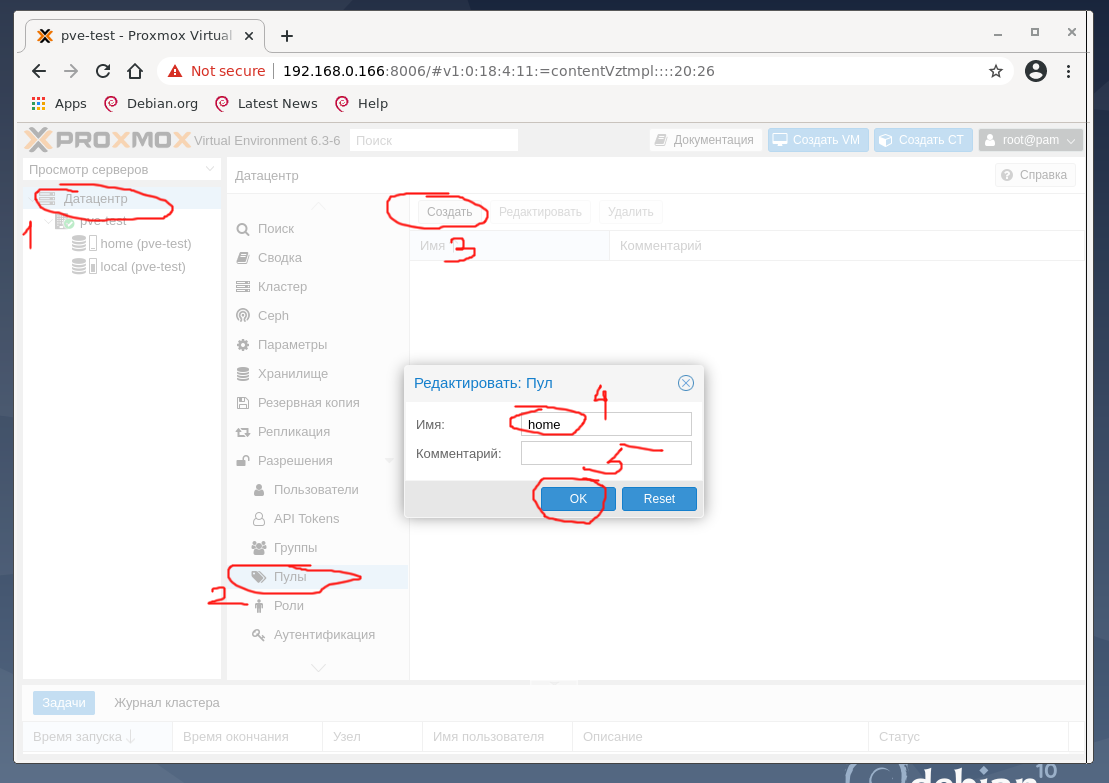

Для создания виртуальных машин необходимо создать Пул ресурсов. Для этого кликните в дереве на вкладку Датацентр, справа выберите пункт Пулы, нажмите Создать, на тестовой машине задано имя пула home, по окончании нажмите ОК:

СОЗДАНИЕ ВИРТУАЛЬНОГО КОНТЕЙНЕРА CT

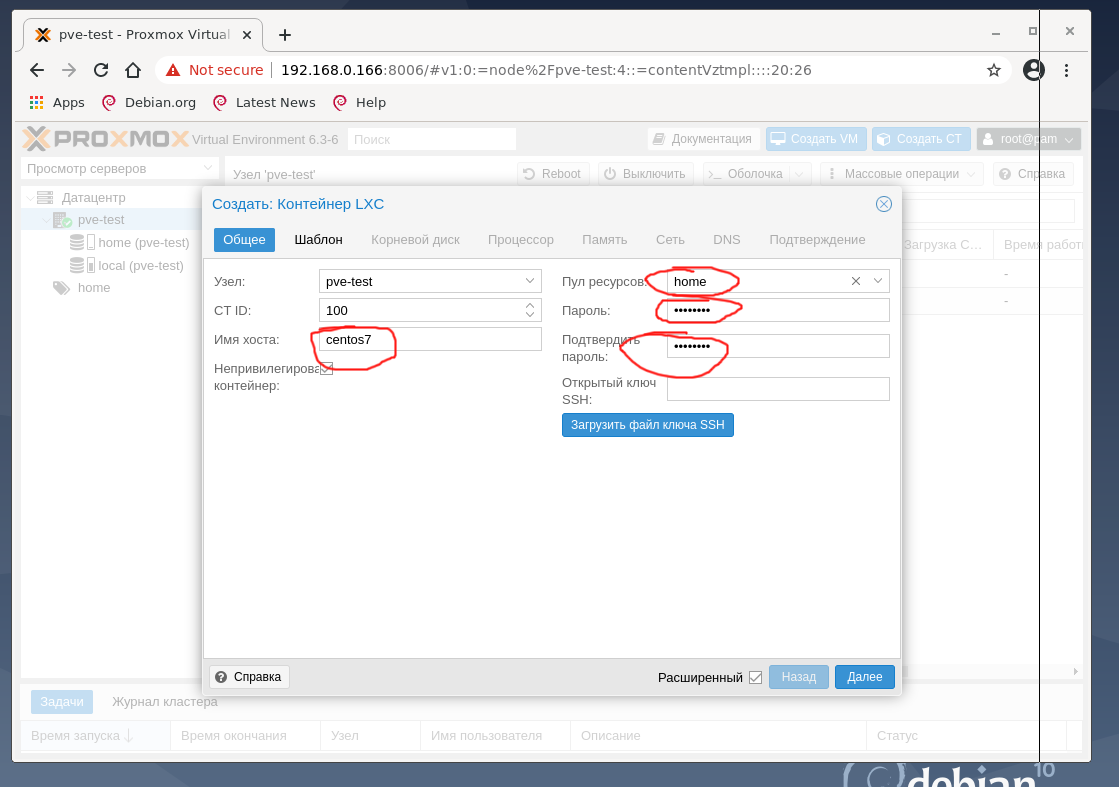

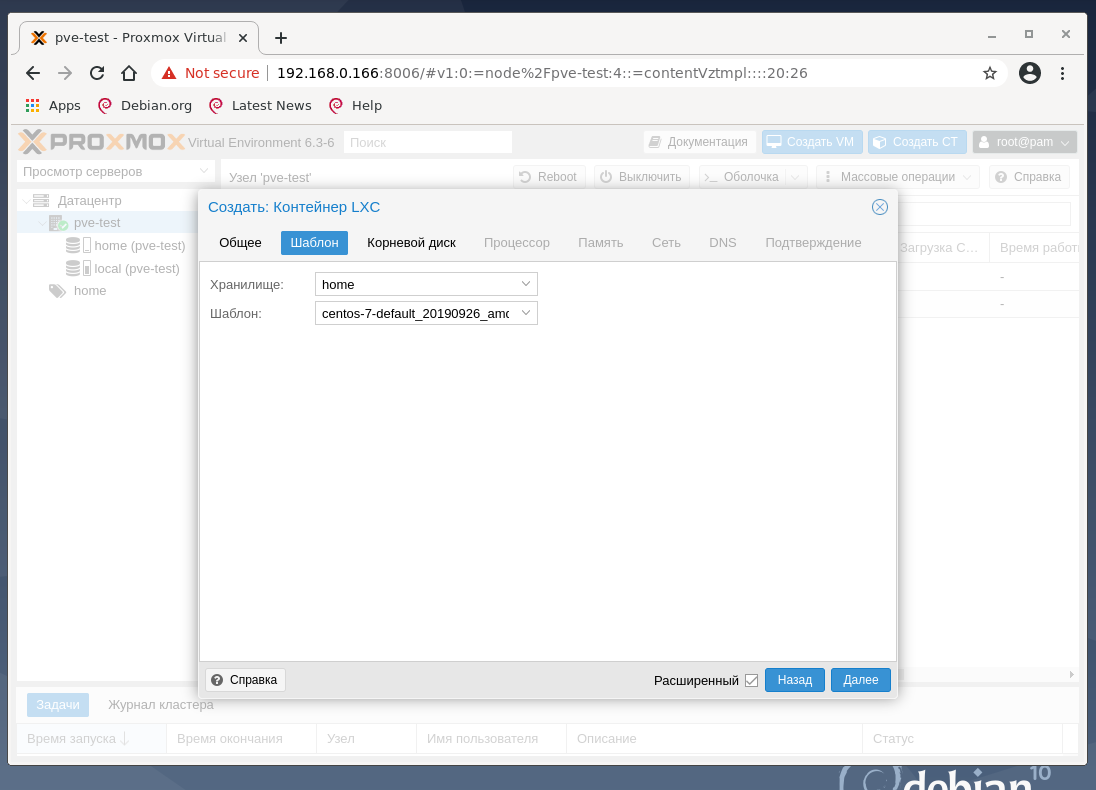

Сначала создайте CT виртуальную машину из скачанного шаблона CentOS 7. Для этого нажмите кнопку Создать CT, заполните поля и нажмите ОК.

На следующей вкладке выберите хранилище home и ранее закачанный шаблон CentOS 7.

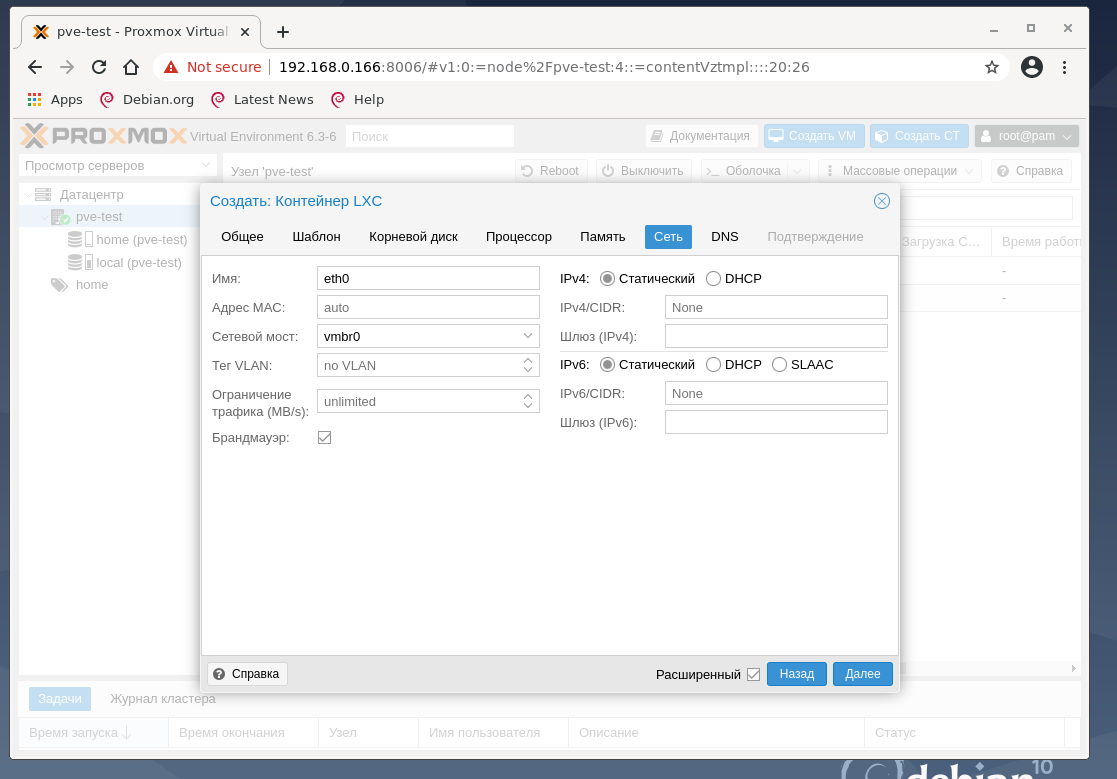

Настройки корневого диска, процессора и памяти на тестовой машине оставим как предложено гипервизором. Обратите внимание на раздел сеть:

Итак, созданный нами ранее сетевой мост vmbr0 используется в виртуальных машинах Proxmox VE для создания виртуальных сетевых интерфейсов для них. Через vmbr0 интерфейс будет подключён к роутеру сети, к которому подключена сетевая карта, на которой работает vmbr0.

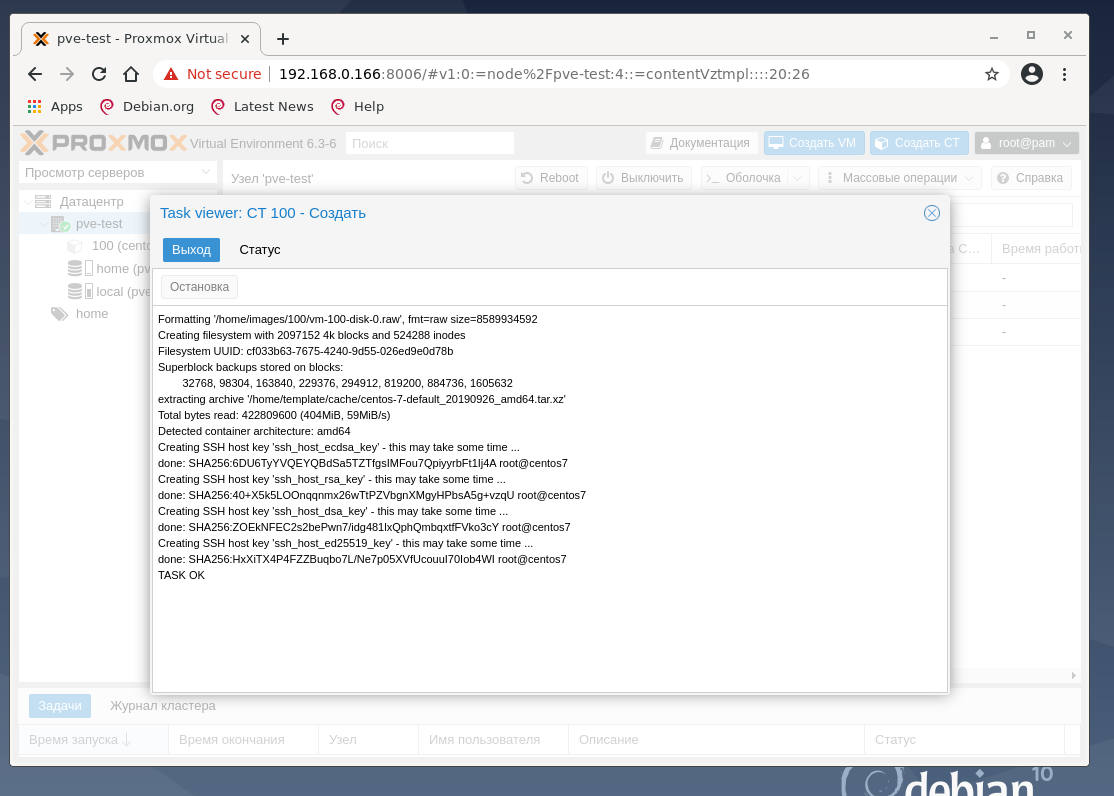

В результате наших действий начинает разворачиваться контейнер, содержащий CentOS 7 и настраиваться виртуальная машина.

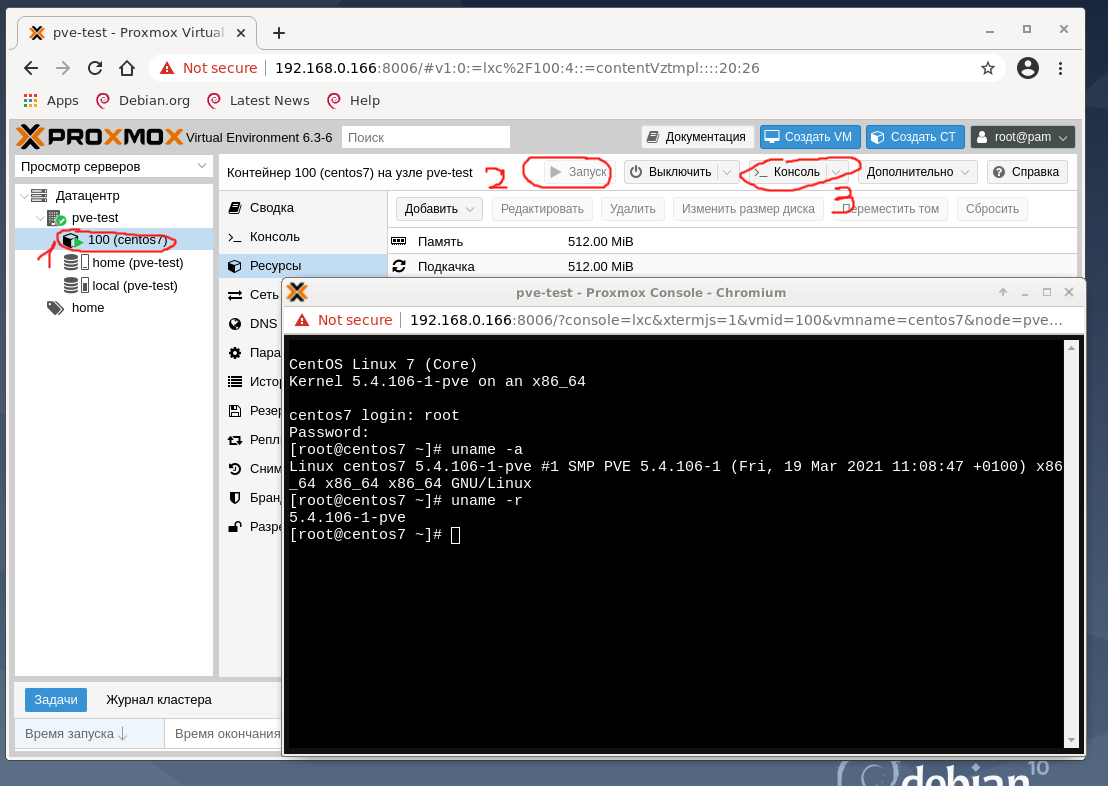

Вернитесь в pve-test, найдите вновь созданный контейнер c ID 100 и названием centos7 и нажмите Запуск, а затем Консоль. Откроется окно браузера, в котором видно запущенный CentOS:

Укажите имя пользователя root и пароль, который ввели при создании контейнера CT и, если все сделано верно, можно управлять виртуальной машиной. Узнайте её IP-адрес, так как роутер, подключённый к тестовому хосту, должен был его выдать:

В результате получилось запустить полноценную виртуальную машину с Linux.

СОЗДАНИЕ ВИРТУАЛЬНОГО КОНТЕЙНЕРА VM

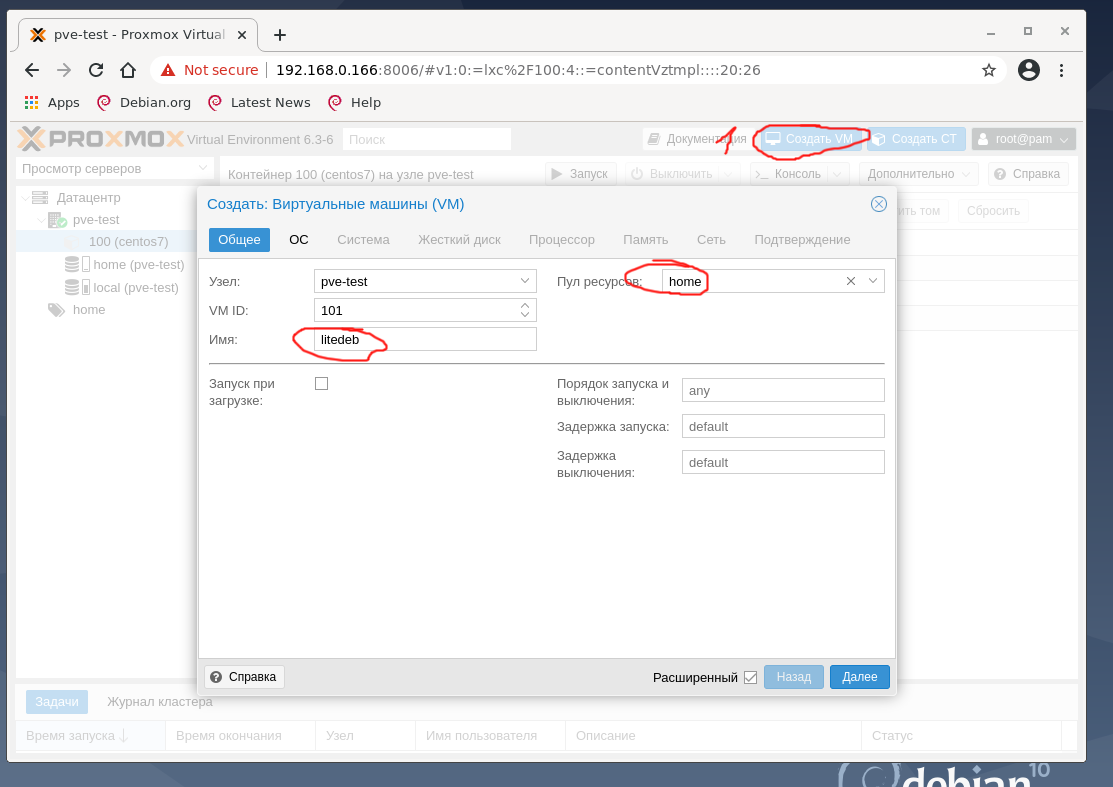

Для создания виртуальной машины VM с любой ОС нажмите кнопку Создать VM, укажите имя создаваемой VM, выберите пул ресурсов, нажмите Далее:

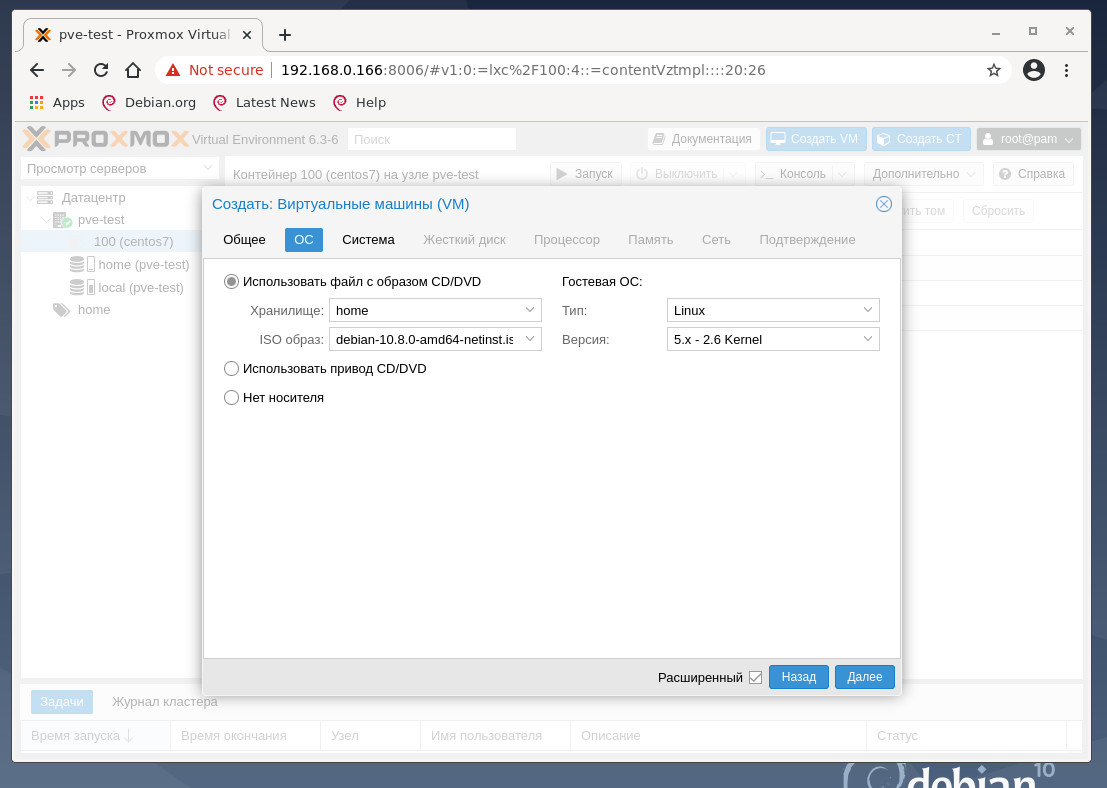

На втором окне предлагается выбрать загрузочный образ виртуального CD-диска, указать тип гостевой ОС:

Если все сделано правильно, то загруженный ISO образ должен быть доступен по клику по обведённому красным полю. Этот параметр может быть настроен позже из интерфейса управления виртуальной машиной VM.

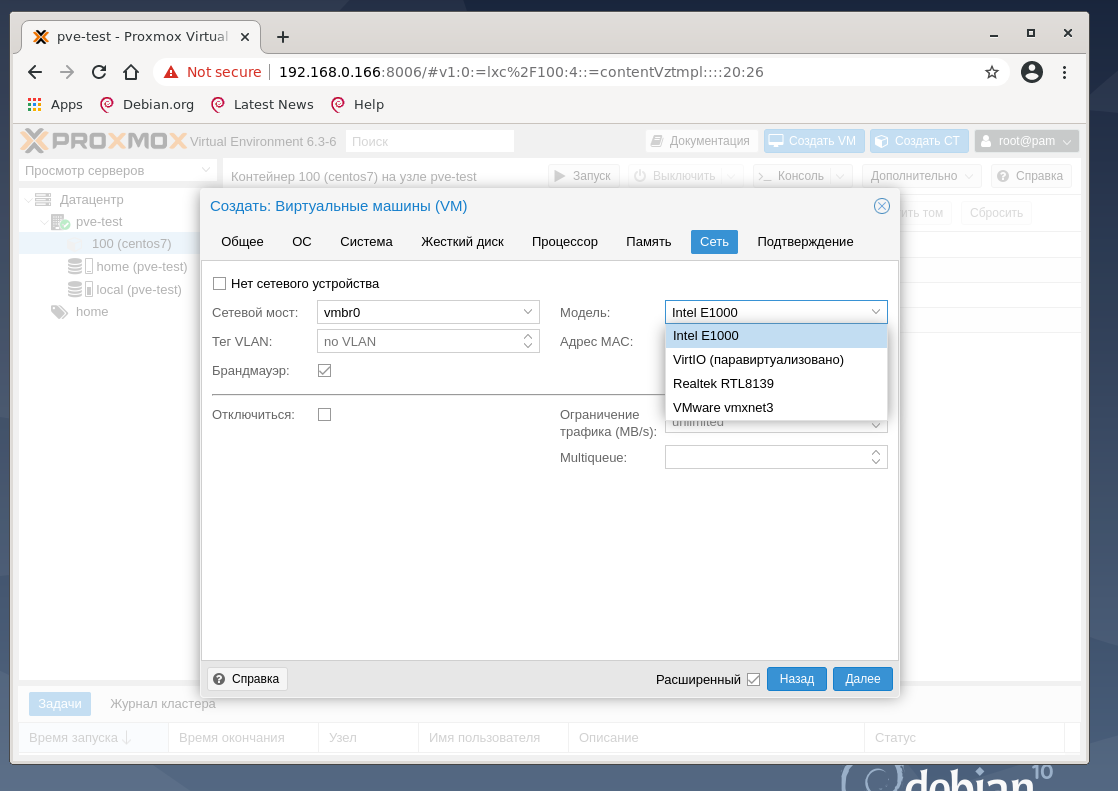

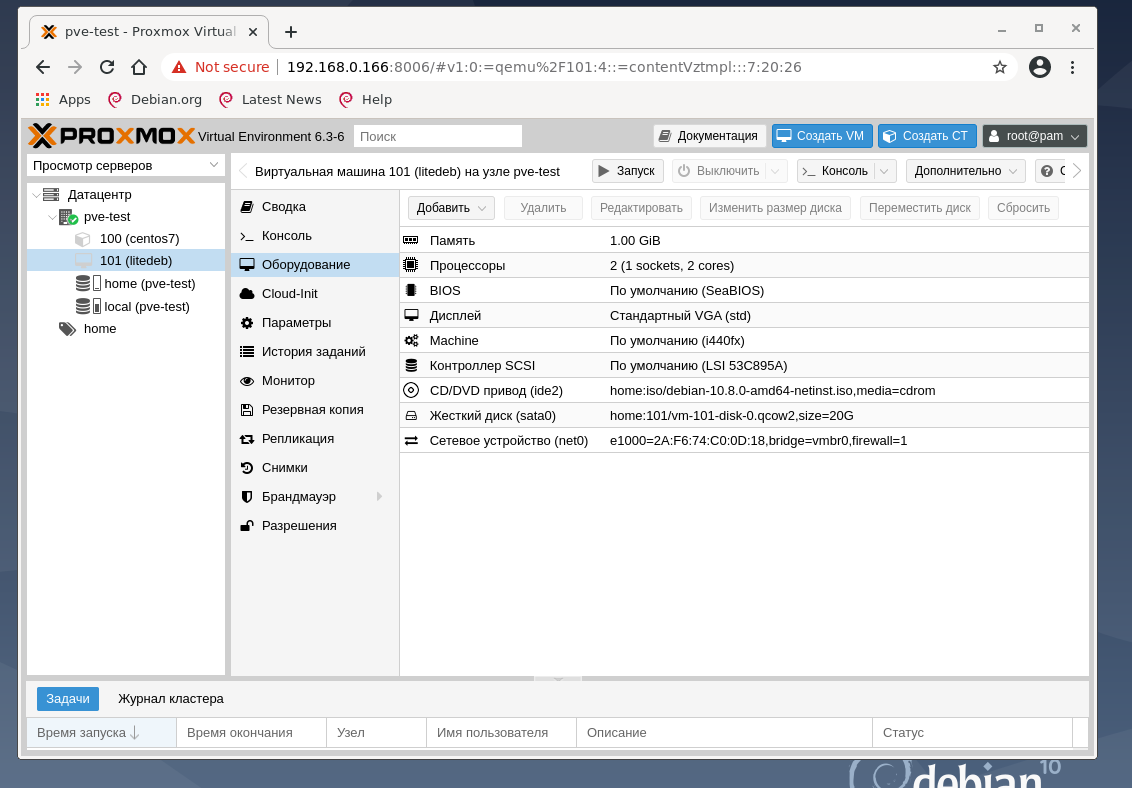

Во вкладках Система, Жёсткий диск, Процессор, Память, Сеть оставлены все значения так, как предложил гипервизор. В последней вкладке Подтверждение кликем Готово и перейдите в настройки виртуальной машины ID 101 с именем litedeb, во вкладку Оборудование:

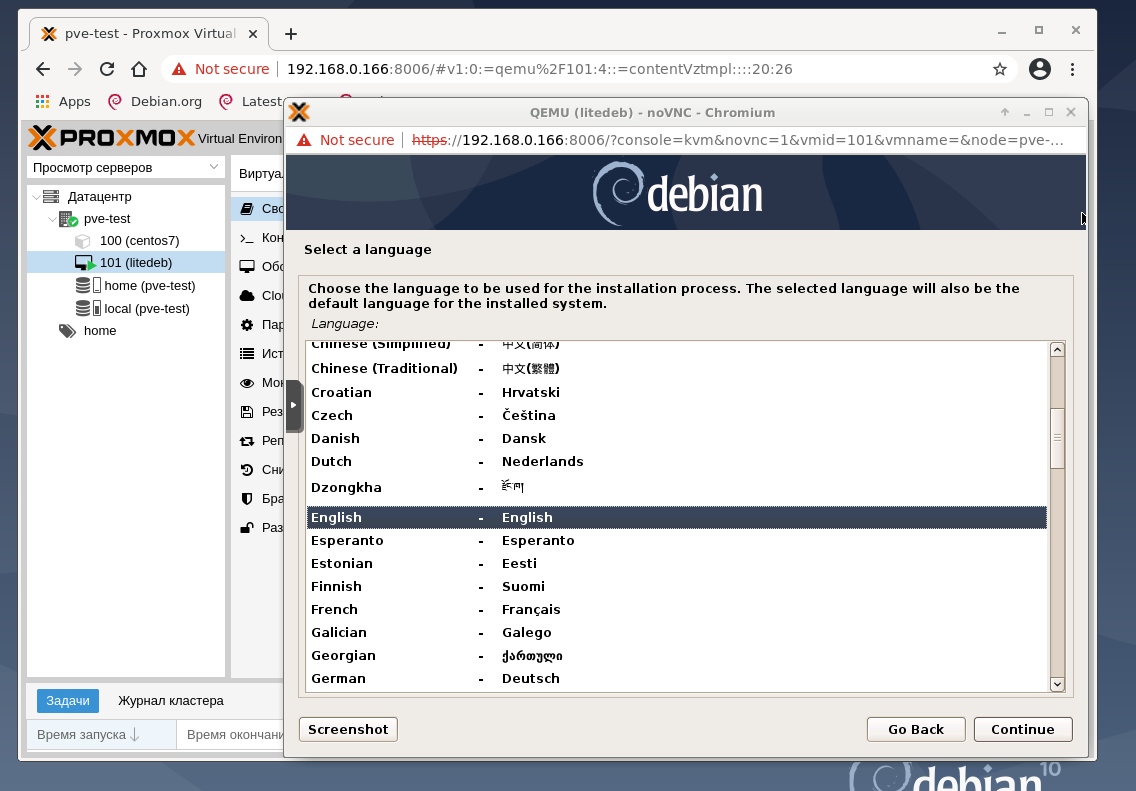

Если все нас устраивает и ничего менять не надо, нажмите кнопку Запуск и откройте Консоль. На тестовом хосте выяснилось, что лучше эксперимент проводить на дистрибутиве Debian 10 netinstall, и поменять тип жёсткого диска со SCSI на SATA, а также увеличить размер оперативной памяти виртуальной машины. И результат работы после нажатия кнопки Запуск и подключению к Консоли:

Режимы архивирования

- Режим Snapshot (Снимок). Этот режим можно еще назвать как Live backup, поскольку для его использования не требуется останавливать работу виртуальной машины. Использование этого механизма не прерывает работу VM, но имеет два очень серьезных недостатка — могут возникать проблемы из-за блокировок файлов операционной системой и самая низкая скорость создания. Резервные копии, созданные этим методом, надо всегда проверять в тестовой среде. В противном случае есть риск, что при необходимости экстренного восстановления, они могут дать сбой.

- Режим Suspend (Приостановка). Виртуальная машина временно «замораживает» свое состояние, до окончания процесса резервного копирования. Содержимое оперативной памяти не стирается, что позволяет продолжить работу ровно с той точки, на которой работа была приостановлена. Разумеется, это вызывает простой сервера на время копирования информации, зато нет необходимости выключения/включения виртуальной машины, что достаточно критично для некоторых сервисов. Особенно, если запуск части сервисов не является автоматическим. Тем не менее такие резервные копии также следует разворачивать в тестовой среде для проверки.

- Режим Stop (Остановка). Самый надежный способ резервного копирования, но требующий полного выключения виртуальной машины. Отправляется команда на штатное выключение, после остановки выполняется резервное копирование и затем отдается команда на включение виртуальной машины. Количество ошибок при таком подходе минимально и чаще всего сводится к нулю. Резервные копии, созданные таким способом, практически всегда разворачиваются корректно.

Переход на Proxmox VE 4.х + Ceph

Было решено перейти на связку Proxmox VE 4.х + Ceph, что позволило бы создать масштабируемое и отказоустойчивое собственное «облако».

В отличие от таких распределённых файловых систем, как GFS, OCFS2 и GPFS, в Ceph обработка данных и метаданных разделена на различные группы узлов в кластере, примерно как это сделано в Lustre, с тем различием, что обработка производится на уровне пользователя, не требуя никакой особой поддержки от ядра операционных систем узлов. Ceph может работать поверх блочных устройств, внутри одного файла или используя существующую файловую систему узла (например, XFS).

В Proxmox VE 4.0 OpenVZ был заменен на LXC. При конвертации образов машин из OpenVZ в LXC наблюдали некоторые проблемы, например:

- Контейнер LXC работает в 2 — 3 раза медленнее OpenVZ;

- Контейнеры с Debian 6 и CentOS 5 не поддерживаются;

- В CentOS 6 не работала сеть из-за переименования сетевых интерфейсов с venet0 на eth0;

- Нельзя зайти в контейнер redhat based по ssh из за отсутствия tty;

В версии 4.3 все исправили.

На конец 2016 года идет создание тестового стенда для внедрения собственного «облака».

Install a standard Debian Jessie (amd64)

You can also create empty partitions during installation and then create ZFS pool on them.

The suggested partition layout with LVM is like that:

Device Boot Start End Blocks Id System /dev/sda1 1 122 975872 83 Linux /dev/sda2 122 5222 40965120 8e Linux LVM

LVM:

root@pvedebian:~# lvs

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert data pve -wi-ao---- 68.25g root pve -wi-ao---- 29.75g swap pve -wi-ao---- 7.00g

Add an /etc/hosts entry for your IP address

Please make sure that your hostname is resolvable via /etc/hosts, i.e you need an entry in /etc/hosts which assigns an IPv4 address to that hostname.

Note: Make sure that no IPv6 address for your hostname is specified in `/etc/hosts`

For instance if your IP address is 192.168.15.77, and your hostname prox4m1, then your /etc/hosts file shoud look like:

127.0.0.1 localhost.localdomain localhost 192.168.15.77 prox4m1.proxmox.com prox4m1 pvelocalhost # The following lines are desirable for IPv6 capable hosts ::1 localhost ip6-localhost ip6-loopback ff02::1 ip6-allnodes ff02::2 ip6-allrouters

You can test if your setup is ok using the hostname command:

hostname --ip-address 192.168.16.77 # should return here your IP adress

Настройка DRBD

Ну хорошо, с идеей разобрались теперь перейдем к реализации.

По умолчанию в комплекте с ядром Linux поставляется модуль восьмой версии drbd, к сожалению он нам не подходит и нам необходимо установить модуль девятой версии.

Подключим репозиторий LINBIT и установим все необходимое:

- — заголовки ядра необходимые для сборки модуля

- — модуль ядра в формате DKMS

- — основные утилиты для управления DRBD

- — интерактивный инструмент, как top только для DRBD

После установки модуля проверим, все ли в порядке с ним:

Если вы увидите в выводе команды восьмую версию значит что-то пошло не так и загружен in-tree модуль ядра. Проверьте что-бы разобраться в чем причина.

Каждая нода у нас будет иметь одно и тоже drbd-устройство запущенное поверх обычных разделов. Для начала нам нужно подготовить этот раздел под drbd на каждой ноде.

В качестве такого раздела может выступать любое блочное устройство, это может быть lvm, zvol, раздел диска или весь диск целиком. В этой статье я буду использовать отдельный nvme диск с разделом под drbd:

Стоит заметить, что имена устройств имеют свойство иногда меняться, так что лучше сразу взять за привычку использовать постоянный симлинк на устройство.

Найти такой симлинк для можно таким образом:

Опишем наш ресурс на всех трех нодах:

Желательно для синхронизации drbd использовать отдельную сеть.

Теперь создадим метаданные для drbd и запустим его:

Повторим эти действия на всех трех нодах и проверим состояние:

Сейчас наш диск Inconsistent на всех трех нодах, это потому, что drbd не знает какой диск должен быть взят в качестве оригинала. Мы должны пометить один из них как Primary, что бы его состояние синхронизировалось на остальные ноды:

Сразу после этого начнется синхронизация:

Нам не обязательно дожидаться ее окончания и мы можем параллельно выполнять дальнейшие шаги. Их можно выполнять на любой ноде, вне зависимости от ее текущего состояния локального диска в DRBD. Все запросы будут автоматически перенаправлены на устройство с UpToDate состоянием.

Стоит не забыть активировать автозапуск drbd-сервиса на нодах:

Requirements

In nested virtualization, also the guest hypervisor should have access to hardware-assisted virtualization extensions, and that implies that the host hypervisor should expose those extension to its virtual machines. In principle it works without those extensions too but with poor performance and it is not an option for productive environment (but maybe sufficient for some test cases). Exposing those extensions requires in case of intel CPUs kernel 3 or higher, i.e. it is available in Proxmox VE > 4.x, but not as default in older versions.

You will need to allocate plenty of CPU, RAM and disk space for those guest hypervisors.

Установка

Есть два варианта установки Proxmox VE — использовать готовый образ или установка на Debian. Мы рассмотрим оба.

Установка готового образа ISO

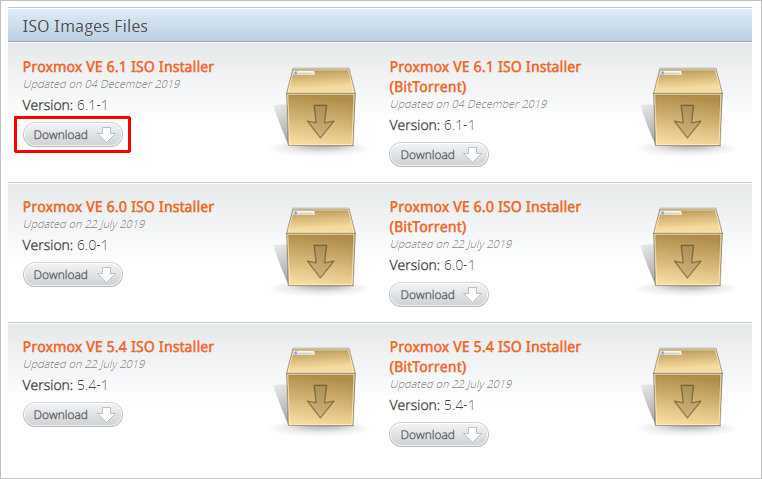

1. Переходим на страницу загрузки Proxmox официального сайта. Загружаем дистрибутив, например, Proxmox VE 6.1:

2. Если установка выполняется на виртуальную машину, монтируем образ. Если нет — создаем установочную флешку, например, с помощью WinSetupFromUsb или загрузочный диск с помощью InfraRecorder.

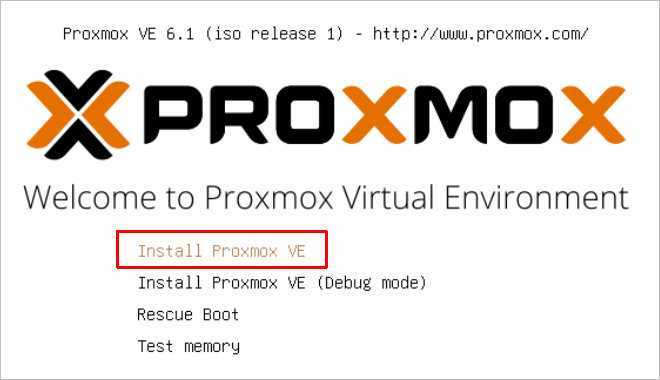

3. Загружаем сервер с установочного ISO — мы увидим окно приветствия Proxmox — выбираем пункт меню Install Proxmox VE:

4. Принимаем лицензионное соглашения, кликнув по I agree.

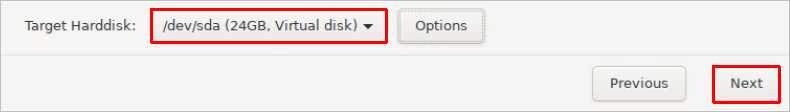

5. Выбираем диск, на который будет установлена система:

* при необходимости, кликаем по Options и задаем настройки файловой системы и размера раздела.

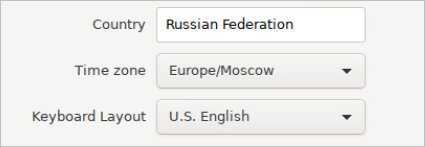

6. Пишем страну, временную зону, язык раскладки клавиатуры по умолчанию:

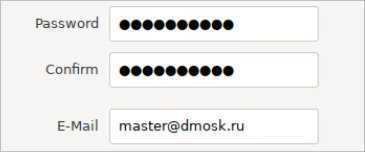

7. Вводим дважды пароль, который будет использоваться для пользователя root:

8. Прописываем сетевые настройки:

* где:

- Management Interface: сетевой интерфейс для управления сервером виртуальных машин.

- Hostname (FQDN): имя хоста для сервера.

- IP Address: IP-адрес нашего сервера.

- Netmask: маска подсети для сервера.

- Gateway: шлюз по умолчанию.

- DNS Server: сервер DNS.

9. В окне «Summary» проверяем введенные данные и кликаем по Install. Начнется процесс установки, который займет не более 10 минут.

10. После установки мы должны увидеть «Installation Successful» — перезагружаем сервер, кликнув по кнопке Reboot.

После переходим к проверке установки.

Установка на Debian

Если мы решили установить Proxmox на уже установленный Debian, выполняем следующую инструкцию.

При установке среды виртуализации меняется ядро Linux. Это может привести к потери работоспособности уже установленных сервисов. Таким образом, установку Proxmox следует выполнять на чистый сервер, а не тот, который уже используется для каких-либо задач.

1. Имя сервера должно разрешаться по его IP-адресу. Для этого либо добавляем А-запись в DNS, либо настраиваем на сервере файл hosts:

nano /etc/hosts

… и добавляем:

192.168.1.55 proxmox.dmosk.local proxmox

* где 192.168.1.55 — IP-адрес нашего сервера; proxmox — имя сервера; dmosk.local — наш домен, если используется.

2. Добавляем репозитории, которые будем устанавливать для установки Proxmox PE и дополнительных компонентов:

nano /etc/apt/sources.list

deb http://mirror.yandex.ru/debian/ buster main non-free contrib

deb-src http://mirror.yandex.ru/debian/ buster main non-free contrib

deb http://download.proxmox.com/debian/pve buster pve-no-subscription

Чтобы мы могли работать с репозиторием proxmox добавляем в систему цифровую подпись:

wget http://download.proxmox.com/debian/proxmox-ve-release-6.x.gpg -O /etc/apt/trusted.gpg.d/proxmox-ve-release-6.x.gpg

Обновляем список пакетов:

apt-get update

3. Устанавливаем Proxmox PE и компоненты:

apt-get install proxmox-ve open-iscsi

* где proxmox-ve — собственно, сам гипервизор; open-iscsi — iSCSI-клиент для подключения iSCSI-target-ов.

4. Перезагружаем сервер:

systemctl reboot

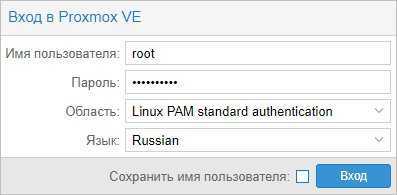

Проверка установки

В браузере открываем панель управления системой виртуализации по адресу https://<IP-адрес сервера>:8006. В открывшемся окне выбираем язык, вводим логин и пароль от пользователя root:

Должно открыться окно управления.

Optional Steps

Optional: Remove the Debian kernel

apt-get remove linux-image-amd64 linux-image-3.16.0-4-amd64 linux-base

Check grub2 config by running:

update-grub

Optional: Developer Workstations with Proxmox VE and X11

Proxmox VE is primarily used as virtualization platform with NO additional software installed. In some case it makes sense to have a full desktop running on Proxmox VE, for example for developers using Proxmox VE as their primary workstation/desktop.

For example, just install XFCE4 desktop and Firefox/Iceweasel browser:

apt-get install xfce4 iceweasel lightdm

If you prefer LXDE desktop instead just do:

apt-get install lxde iceweasel

Make sure network-manager is not used, else pve-cluster will not start in some cases

Причины отказа от перехода в «облака»

1. Высокие ежемесячные затраты на размещение серверов в «облаках».

Оценка стоимости перехода в «облака» проводилась в конце 2014 года.

В «облака» планировалось перенести основные сервера компании:

- сервер Exchange,

- сервер 1С,

- сервер Oracle.

Изучив предложения известных компаний, предоставляющих услуги по размещению серверов в «облаках», мы выяснили, что средняя ежемесячная плата за размещение 3 серверов составляет порядка 120-160 тыс. рублей. Подобные затраты мы посчитали нецелесообразными.

Также для комфортной работы наших сотрудников (как головного офиса, так и филиалов) с размещенными в «облаках» серверами компания была бы вынуждена значительно увеличить пропускную способность канала Интернет, что является дорогим «удовольствием» для компании, расположенной в бизнес-центре с провайдером-монополистом.

2. Запрет на размещение серверов не на территории компании.

Таким образом, вариант перехода в «облака» оказался в нашем случае невозможным. Возникла необходимость поиска иного пути решения проблемы. Проведя анализ имеющихся систем виртуализации, мы пришли к выводу, что наиболее подходящим решением будет использование Proxmox Virtual Environment.

Flexible Storage Options

The Proxmox VE storage model is very flexible. VM images can either be stored on one or several local storage devices or on shared storage like NFS and SAN. There are no limits. You can configure as many storages as you like, and can use all storage technologies available for Debian GNU/Linux. The benefit of storing VMs on shared storage is the ability to live-migrate running machines without any downtime.

Read more on the Proxmox VE Storage Model

In the Proxmox VE web interface, you can add the following storage types:

Network storage types supported

- LVM Group (network backing with iSCSI targets)

- iSCSI target

- NFS Share

- SMB/CIFS

- Ceph RBD

- Direct to iSCSI LUN

- GlusterFS

- CephFS

Разметка жесткого диска

Тема разметки диска раньше была достаточно спорной и вызывала много дискуссий и споров. Делали отдельно разделы под корень /, домашнюю директорию /home, под логи /var/logs и т.д. Мне кажется, что сейчас все это стало неактуально. Сервера общего назначения переехали в виртуальные среды, а там можно и дополнительный диск выделить под образовавшиеся нужды, либо увеличить текущий. Нет необходимости заранее продумывать на много шагов вперед, можно без проблем потом добавить дисковое пространство.

Если же вы настраиваете железный сервер, то скорее всего четко знаете для чего он нужен и разбиваете уже в зависимости от его прямого назначения. Я сам лично, если нет каких-то особых требований к серверу, создаю только один общий раздел / на lvm.

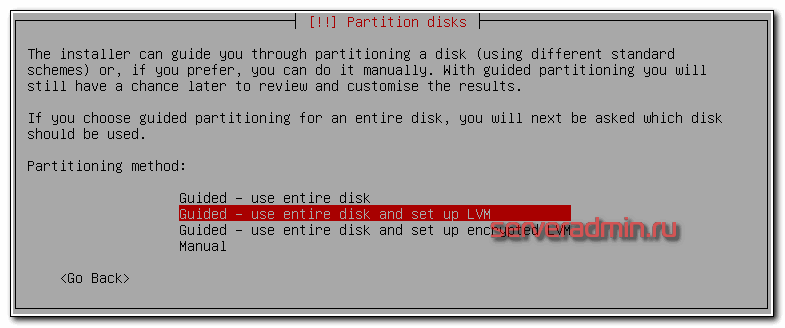

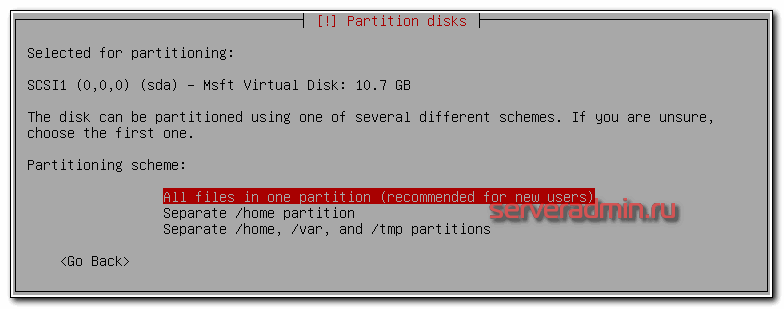

Далее нужно выбрать жесткий диск, на который будет установлена система. Если у вас он только один, как у меня, то выбирать не из чего. Дальше выбираем схему разбивки диска. Как я уже сказал ранее, все будет храниться в одном корневом разделе, так что выбираем All files in one partition.

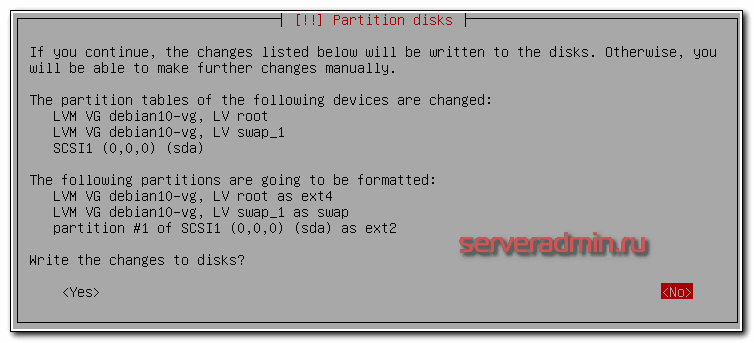

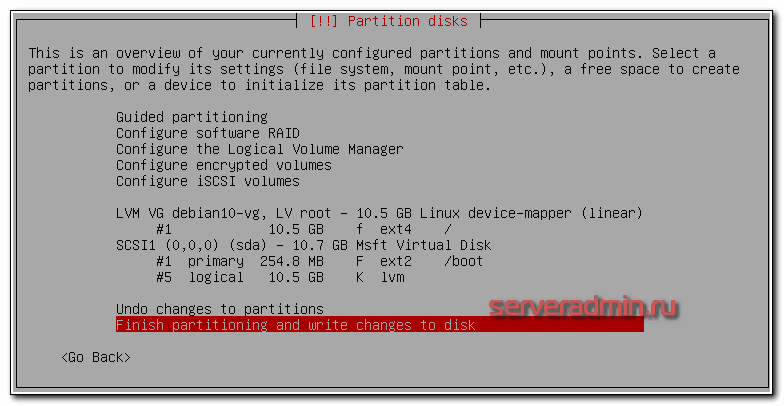

Затем вас спросят, записать ли изменения — соглашайтесь. Далее надо указать размер группы томов LVM. По-умолчанию указан весь размер диска, можно с этим согласиться. Далее увидите окончательный вариант разбивки диска.

В принципе, можно с ним согласиться. Но лично мне не нравится swap на отдельном lvm томе. Я люблю хранить swap в файле прямо на файловой системе

Теоретически, это чуть медленнее, чем отдельный раздел, но практически это не важно. В современных серверах swap редко используется, нужен больше для стабильности работы системы, нежели для скорости

Со swap в отдельном разделе не получится гибко работать, как с обычным файлом. Я на серверах ставлю минимальный размер свопа в 1 Гб, увеличиваю по мере необходимости. Когда своп это обычный файл, с этим нет проблем.

Так что изменения не записываем, выбираем No. Вы попадаете в раздел управления разметкой диска. Необходимо удалить LV раздел под swap, затем удалить LV раздел root и создать его заново максимального размера. Потом на нем же еще раз создать корневую систему в точке монтирования /. Должно получиться вот так.

В принципе, раздел /boot тоже можно было бы разместить в корне, но в целом можно оставить и так. Я сталкивался с неожиданными проблемами, когда /boot раздел был на lvm. Так что не буду вам рекомендовать его куда-то переносить.

Когда будете соглашаться с новой разметкой, получите предупреждение, что забыли про swap

Не обращайте на него внимание. Дальше пойдет непосредственно установка Debian 10 в виде копирования системных файлов на диск

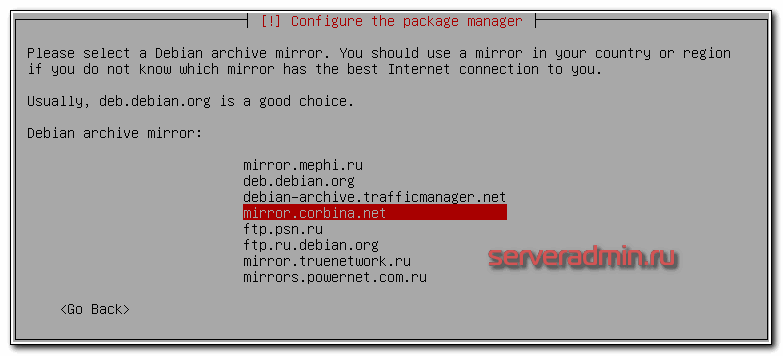

На следующем этапе установки системы, вам будет задан вопрос по поводу дополнительного диска с пакетами. Вам будет предложено проверить другой диск для установки дополнительных пакетов. Отказываемся и идем дальше. Теперь нужно выбрать зеркало, с которым будет работать пакетный менеджер apt. Выбираем свою страну и подходящее зеркало. Я выбираю Russian Federation и зеркало mirror.corbina.net. Раньше всегда выбирал зеркало Яндекса, но в Debian 10 его почему-то нет для выбора.

Далее нас просят указать прокси. Скорее всего вы им не пользуетесь, поэтому строку можно оставить пустой. Если это не так, то укажите адрес proxy сервера. На следующем этапе установки debian 10 вопрос о том, хотим ли мы делиться анонимной статистической информацией об использовании различного ПО на сервере. Я обычно не делюсь.

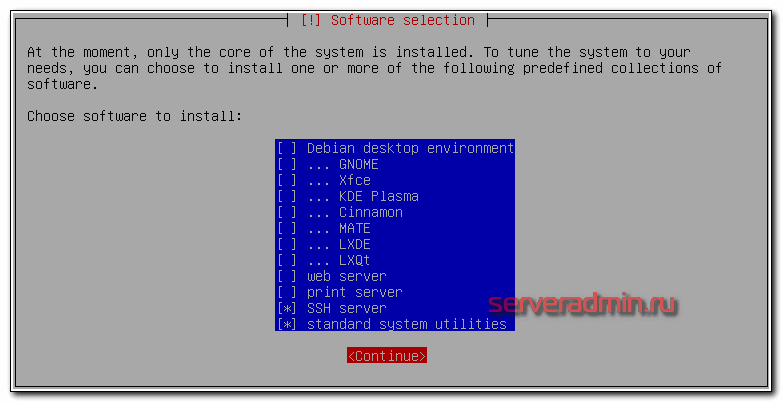

Дальше выбираем набор дополнительного ПО, которое будет установлено на сервер debian 10 вместе с основной системой. Я никогда не ставлю ничего, кроме ssh сервера и системных утилит.

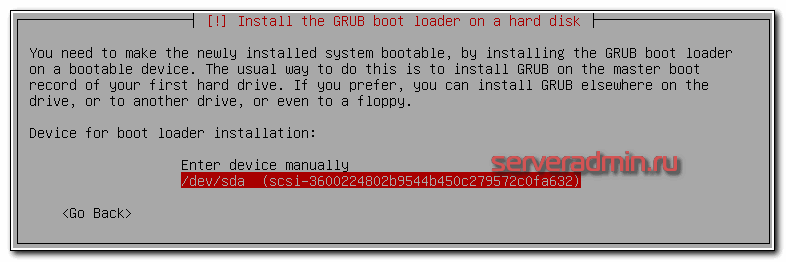

Все остальное можно установить потом. На последнем этапе установки нас спрашивают про загрузчик grub — установить ли нам его. В подавляющем большинстве случаев это нужно сделать. Если вы не знаете, нужно или нет, значит 100% нужно. Без загрузчика можно обойтись в очень специфических ситуациях, которые мы рассматривать не будем в этой инструкции по установке debian. Так что устанавливаем grub на единственных жесткий диск.

Перезагружаем сервер. Установка завершена, он полностью готов к работе. Не забывайте, что по-умолчанию, на сервер нужно подключаться под учетной записью обычного пользователя, не root. После установки системы, предлагаю выполнить предварительную настройку сервера.

Функции

Proxmox VE — это мощная платформа виртуализации серверов с открытым исходным кодом для управления двумя технологиями виртуализации — KVM ( виртуальная машина на основе ядра ) для виртуальных машин и LXC для контейнеров — с помощью единого веб-интерфейса. Он также объединяет готовые инструменты для настройки высокой доступности между серверами, программно-определяемого хранилища, сети и аварийного восстановления.

KVM и виртуализация контейнеров

Виртуализация серверов с поддержкой виртуальной машины на основе ядра (KVM) и виртуализации на основе контейнеров с помощью контейнеров Linux (LXC).

Модель хранения

Proxmox VE поддерживает локальное хранилище с LVM-группой, каталогом и ZFS , а также типы сетевого хранилища с iSCSI , Fibre Channel , NFS , GlusterFS , CEPH .

Кластер высокой доступности

Proxmox VE можно кластеризовать на нескольких серверных узлах.

Начиная с версии 2.0, Proxmox VE предлагает вариант высокой доступности для кластеров на основе коммуникационного стека Corosync . Отдельные виртуальные серверы можно настроить для обеспечения высокой доступности с помощью встроенного ha-manager. Если узел Proxmox становится недоступным или выходит из строя, виртуальные серверы могут быть автоматически перемещены на другой узел и перезапущены. Файловая система Proxmox Cluster (pmxcfs) на основе базы данных и FUSE позволяет выполнять настройку каждого узла кластера через стек связи Corosync.

Живая миграция

По крайней мере, с 2012 года в кластере высокой доступности живые виртуальные машины можно перемещать с одного физического хоста на другой без простоев. Начиная с Proxmox VE 1.0, выпущенного 29.10.2008, поддерживается живая миграция KVM и OpenVZ .

Виртуальные устройства

Proxmox VE имеет предварительно упакованные серверные программные устройства, которые можно загрузить через графический интерфейс. Можно загружать и развертывать устройства из библиотеки виртуальных устройств TurnKey Linux .

Резервное копирование данных

PVE имеет встроенное автономное решение для резервного копирования vzdump, которое обеспечивает сжатие данных и работу в режиме онлайн (режим моментальных снимков). С 2020 года существует также расширенное клиент-серверное программное обеспечение под названием Proxmox Backup Server (PBS), которое предлагает дедупликацию , сжатие, шифрование с проверкой подлинности и инкрементное резервное копирование .

Драйвера и Службы

Чтобы установить все недостающие драйвера для корректной работы Windows на Proxmox, запустите virtio-win-gt-x64.msi в корне диска virtio. Можете убрать установку тех драйверов и служб, что вы точно не будете использовать. Например, Qxl и Spice. После этого не только ip адреса, но и использования оперативной памяти должны корректно отображаться в веб интерфейсе.

Рекомендуется посмотреть менеджер устройств, чтобы убедиться в том, что там нет неопределённого оборудования. Если все драйверы установились корректно, то всё оборудование будет с драйверами и определено. Если это не так, то попробуйте установить драйвер устройства вручную. Для этого укажите в качестве источника драйвера виртуальный диск с virtio.iso и обязательно укажите использовать для поиска драйвера подпапки. Если драйвер будет найдет, то выберите его и установите, подтвердив, что доверяете установке драйверов от указанного поставщика.