Упрощаем с docker

Поддержка показанной выше инфраструктуры требует определенных затрат, как денежных, так и людских. В случае, если Ваша команда трудится над небольшим стартапом, или Вы являетесь единственным разработчиком, то можно воспользоваться контейнерами docker для реализации своей инфраструктуры сборки.

Рассмотрим тривиальный Qt проект, который собирается с помощью qmake — SimpleQtProject. В папке docker указанного проекта находится ряд файлов:

- centos7.docker — описывает контейнер для сборки проекта под CentOS 7;

- ubuntu-bionic.docker — контейнер для сборки под Ubuntu 18.04;

- ubuntu-xenial.docker — описывает контейнер для сборки под Ubuntu 16.04.

Данные файлы реализуют идею клонирования исходного кода внутрь контейнера.

Запускается вся сборка с помощью Makefile. Он очень короткий и содержит достаточно комментариев. Его основа — это создание образа и запуск контейнера:

В этом этапе сборки создается образ контейнера с именем, состоящим из префикса simple-qt- и названия системы (для centos 7 это будет simple-qt-centos7). В качестве Dockerfile используется соответствующий файл с разрешением .docker. Далее запускается контейнер на основе созданного образа, и к нему монтируется папка для копирования артефактов сборки.

После запуска команды в директории docker, в папке docker/releases будут находится результаты сборки под несколько платформ.

Таким образом наша инфраструктура для сборки SimpleQtProject будет выглядеть следующим образом:

Достоинства данной конфигурации:

- Локальность. Разработчик собирает проект для нескольких платформ на своей локальной машине, это исключает необходимость содержать парк серверов, настраивать копирование артефактов между серверами по сети, отправку и обработку сетевых команд.

- Изоляция окружения. Контейнер обеспечивает полностью изолированную среду для сборки конкретного приложения. Есть возможность обеспечить сборку проектов с несовместимыми окружениями на одной машине (например таких, которые требуют различных версий одной и той же библиотеки).

- Версионирование. Поместив Dockerfile в git-репозиторий, можно отслеживать изменения в среде сборки с выходом новых релизов, откатываться к предыдущим версиям среды сборки и пр.

- Мобильность. При необходимости данная инфраструктура без особых проблем разворачивается на другом компьютере. Технология создания позволяет вносить изменения в сам образ очень легко — достаточно обновить Dockerfile и запустить сборку образа.

- Самодокументируемость. По сути, Dockerfile содержит шаги для развертывания окружения сборки. Поэтому, при необходимости развернуть такое окружение, но уже в обычной системе, можно воспользоваться командами из него же.

- Легковесность. Контейнер запускается в момент начала сборки и останавливается по ее завершению автоматически. Он не тратит процессорное время и оперативную память впустую.

Однако есть и существенный минус — сборка проекта потребует и сборки образа контейнера. При первом запуске это может занять продолжительное время. Но при повторных, особенно если Dockerfile не менялся, образ собирается с использованием кеша в разы быстрее.

Так же необходимо не забывать очищать остановленные контейнеры.

Что такое Docker

Docker представляет собой систему управления контейнерами. Она позволяет «упаковать» приложение или веб-сайт со всем его окружением и зависимостями в контейнер, которым в дальнейшем можно легко и просто управлять: переносить на другой сервер, масштабировать, обновлять.

Docker был написан на языке программирования Go и выпущен в 2013 году. Изначально он работал только с Linux-системами, однако на данный момент его можно использовать также в Windows и macOS. Несмотря на то, что проект является относительно новым, Докер широко используется многими специалистами и продолжает завоевывать популярность.

Важной частью экосистемы Docker является Docker Hub – открытый репозиторий образов контейнеров. В нем можно найти десятки готовых приложений от официальных разработчиков

Среди них – nginx, MySQL, Apache, Gitlab, Redmine, Elasticsearch, Jenkins и другие.

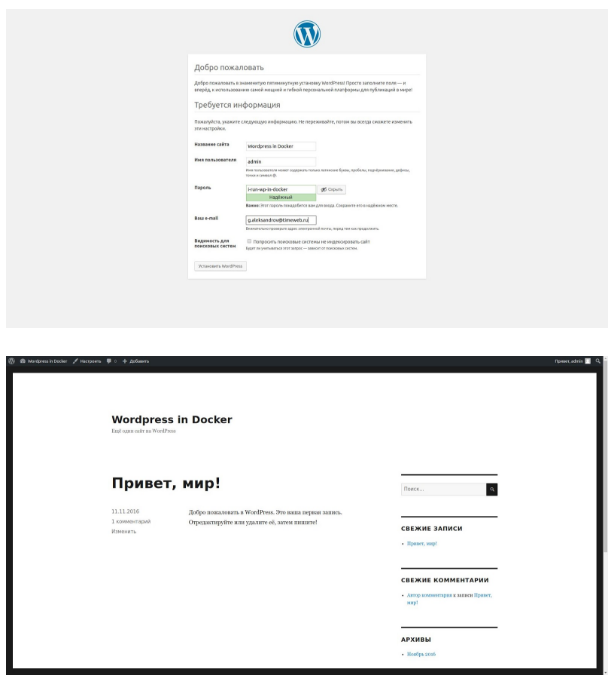

Например, для запуска WordPress с помощью Docker достаточно выполнить следующие команды:

docker run --name wp-mysql -e MYSQL_ROOT_PASSWORD=wpmsqlpsswd -d mysql:5.7 <вывод пропущен> docker run --name my-wordpress --link wp-mysql:mysql -d -p 80:80 wordpress

После этого откройте в браузере страницу http://12.34.56.78 (здесь укажите реальный IP-адрес вашего VDS) и приступите к настройке CMS!

Теперь расскажем о том, что представляет собой Docker. Три основных термина в экосистеме Docker:

Теперь расскажем о том, что представляет собой Docker. Три основных термина в экосистеме Docker:

- Образ (image) – шаблон, который используется для создания контейнеров. Представляет собой слепок файловой системы, в котором расположен код приложения и его окружение.

- Реестр (registry) – репозиторий образов. Docker Hub, о котором шла речь выше, – это публичный репозиторий, где хранится огромное количество образов.

- Контейнер (container) – запущенное приложение, т.е. совокупность процессов и образа.

Создание микросервисов

Чтобы иметь возможность проверить состояние каждого из сервисов, в их зависимости был добавлен Spring Actuator. Он создаст эндпойнт /actuator/health и будет возвращать 200 статус, если сервис готов принимать траффик, или 504 в случае проблем. В данном случае это довольно фиктивная проверка, так как сервисы очень просты, и при каком-то форсмажоре они скорее станут полностью недоступны, чем сохранят частичную работоспособность. Но в реальных системах Actuator может помочь диагностировать проблему до того, как об нее начнут биться пользователи. Например, при возникновении проблем с доступом к БД, мы сможем автоматически на это среагировать, прекратив обрабатывать запросы сломанным экземпляром сервиса.

Сервис бекенда будет просто считать и отдавать количество принятых запросов.

Код контроллера:

Тест на контроллер:

Сервис Gateway

Шлюз будет переадресовывать запрос сервису бекенда, дополняя его следующей информацией:

id шлюза

Он нужен, чтобы можно было по ответу сервера отличить один экземпляр шлюза от другого

Некий «секрет», который будет играть роль очень важного пароля (№ ключа шифрования важной куки). Конфигурация в application.properties:

Конфигурация в application.properties:

Адаптер для связи с бекендом:

Контроллер:

Начало

Все началось дождливым сентябрьским вечером, когда я чистил арендованную за $5 машинку на Digital Ocean, которая намертво повисла из-за того что Докер заполонил своими образами и контейнерами все 24 гигабайта доступного дискового пространства. Ирония была в том, что все эти образы и контейнеры были транзиентными и нужны были лишь для того чтобы тестировать работоспособность моего приложения каждый раз когда выходила новая версия какой-либо библиотеки или фреймворка. Я пробовал писать шелл-сркипты и настраивать расписание крон для очистки мусора, но это не спасло: каждый раз все неминуемо заканчивалось тем, что дисковое пространство моего сервера оказывалось съеденным а сервер зависшим (в лучшем случае). В какой-то момент я наткнулся на статью про то как запускать Jenkins в контейнере и как он может создавать и удалять сборочные конвееры через проброшенный в него сокет докер демона. Идея мне приглянулась, но я решил пойти дальше и попробовать поэкспериментировать с непосредственным запуском Докера внутри Докера. Мне тогда казалось вполне логичным решением выкачивать докер образы и создавать контейнеры всех приложений которые мне нужны для тестирования внутри другого контейнера (давайте назовем его staging контейнер). Идея заключалась в том, чтобы запускать staging контейнер с флагом -rm, что автоматически удаляет весь контейнер со всем его содержимым при его остановке. Я покопался с докер образом от самого Докера (https://hub.docker.com/_/docker), но оно оказалось слишком громоздким и мне так и не удалось заставить его работать так как мне нужно и мне хотелось пройти весь путь самому.

Немного о docker

Для наглядности дальнейшего изложения необходимо привести описание некоторых компонент docker.

Image

это шаблон только для чтения с инструкциями по созданию контейнера. Для того, чтобы собрать image необходимо создать Dockerfile, в котором описываются все шаги сборки. Каждый такой шаг создает отдельный слой внутри image. Каждый последующий слой накладывается поверх всех предыдущих и содержит лишь изменения, которые необходимо внести в предшествующий слой.

Например, для Dockerfile:

docker-образ будет иметь следующую структуру:

Слои внутри image кешируются и могут быть переиспользованы, если никаких изменений не обнаружено. Если слой , то все последующие создаются с нуля. Для внесения изменений в образ контейнера (и соответственно в окружение запускаемого процесса) достаточно поправить Dockerfile и запустить сборку образа.

Контейнер

— это запускаемый экземпляр image. Его можно создать, запустить, остановить, удалить и пр. По умолчанию, контейнеры изолированы друг от друга и хост-системы. При старте контейнер запускает команду, которая может быть указана в или , и останавливается при ее завершении. Допустимой является ситуация, когда присутствуют и CMD и ENTRYPOINT, как они взаимодействуют .

При создании каждого контейнера добавляется новый слой поверх всех существующих. Он доступен для записи в текущем контейнере, и уничтожается вместе с контейнером. Все операции записи, создания новых файлов при работе контейнера применяются к этому слою, image всегда остается неизменным. Таким образом структура слоев созданного контейнера будет иметь вид:

При использовании команды каждый раз будет контейнер, со своим слоем для записи. В задачах сборки это означает, что при каждом запуске будет создавать новое чистое окружение, которое никак не связано с предыдущими выполнениями. Список созданных контейнеров можно посмотреть, выполнив команду: .

Что мне всегда НЕ нравилось в docker:

для того чтобы мое приложение работало, нужен сам docker на сервере. А зачем мне это, если мои приложения работают на jre или на nodejs и окружение для них уже есть на сервере?

если я хочу запустить свой (приватный) локально собранный образ на удаленном сервере, то мне нужен свой docker репозиторий, нужно чтобы где-то работал registry и еще нужно настроить https, потому что docker cli работает только по https. Ох блин… есть варианты, конечно, сохранить образ локально через и через scp просто скинуть образ… Но это столько телодвижений. И к тому же выглядит «костыльным» решением, пока не появится свой репозиторий

. Он нужен только для запуска контейнеров. И все. Больше ничего он не может. имеет кучу версий своих файлов, свой синтаксис. Каким декларативным он бы ни был, я не хочу читать их документацию. Мне она больше нигде не понадобится.

при работе в команде, в большинстве своем люди пишут Dockerfile очень криво, не понимают как это кешируется, добавляют в образ все что надо и не надо, наследуются от образов которых нету в dockerhub или приватном репозитории, создают какие-то файлы с базами данных и ничего не персистируют

При этом разработчики гордо заявляют, что docker крут, у них все работает локально и HR важно пишет в вакансии: «Мы используем docker и нам нужен кандидат с таким опытом работы»

постоянно преследуют мысли о поднятии в docker всего и вся: postgresql, kafka, redis. Жаль, что не всё работает в контейнерах, не все легко сконфигурировать и запустить

Поддерживаются это сторонними разработчиками, а не самими вендорами. И кстати сразу возникает вопрос, вендора не парятся насчет поддержания своих продуктов в docker, почему же это, может они что-то знают?

всегда возникает вопрос про персистенцию данных контейнера. и тут думаешь, мне просто примонтировать хостовую директорию или создать docker volume или сделать data container который теперь ? Если я монтирую директорию, то мне нужно убедиться что uid и gid пользователя в контейнере соответствует id пользователя, запустившего контейнер, иначе файлы, созданные контейнером будут созданы с правами владельца root. Если использую , то данные просто буду созданы в каком нибудь и будет такая же история с uid и gid как в первом случае. Если запускаешь сторонний компонент, то нужно вчитываться в документацию и искать ответ на вопрос: «а в какие директории контейнера компонент пишет файлы?»

Мне всегда не нравилось, что приходится слишком долго возиться с docker-ом на начальном этапе: я придумывал как запускать контейнеры, из каких образов запускаться, делал Makefile, которые содержали алиасы к длинным docker командам. Терпеть не мог docker-compose, потому что не хотел учить еще один инструмент экосистемы docker. И меня напрягала, особенно, если там еще встречались конструкции, а не уже собранные образы. Все, что я реально хотел — это просто делать продукт эффективно и быстро. Но я никак не мог разложить по полочкам использование docker.

Подлинность образов Docker

Описание

В Интернет можно найти немало Docker-образов, которые делают всевозможные полезные и классные вещи, но если вы загружаете образы без использования каких-либо механизмов доверия и проверки подлинности, вы по сути запускаете на своих системах произвольное ПО.

- Откуда был загружен этот образ?

- Доверяете ли вы его создателям? Какие политики безопасности они используют?

- Есть ли у вас объективное криптографическое доказательство того, что образ был действительно создан этими людьми.

- Вы уверены, что никто не изменил образ после того, как он был загружен?

Docker запустит все, что попросите, поэтому инкапсуляция здесь не поможет. Даже если вы пользуетесь исключительно образами собственного производства, имеет смысл проверять, не изменяет ли их кто-нибудь после создания. Решение в итоге сводится к классической цепочке доверия на основе PKI.

Лучшие практики

-

Обычный здравый смысл: не запускайте непроверенное ПО и/или ПО, полученное из недоверенных источников.

-

С помощью серверов реестров Docker, которые можно найти в этом списке Docker Security Tools, разверните доверенный сервер (trust server).

- Для любого образа, который загружается или запускается в системе, обеспечьте обязательную проверку цифровой подписи.

Примеры

Развертывание полноценного доверенного сервера выходит за рамки этой статьи, но вы уже сейчас можете начать с подписывания своих образов.

Если у вас еще нет учетной записи на Docker Hub, заведите ее.

Создайте директорию с простым Dockerfile следующего содержания:

Соберите образ:

Войдите в свою учетную запись на Docker Hub и загрузите образ:

Включите в Docker принудительную проверку доверия:

Теперь попробуйте получить только что загруженный вами образ:

Вы должны получить следующую ошибку:

При включенном DOCKER_CONTENT_TRUST соберите контейнер еще раз. Теперь он по умолчанию будет подписан.

Теперь вы сможете скачивать и загружать подписанные контейнеры без каких-либо предупреждений, связанных с безопасностью. При первой загрузке доверенного образа Docker создаст для вас . Вам также понадобится ключ репозитория. В обоих случаях будет предложено задать пароль.

Ваши закрытые ключи будут сохранены в директории ~/.docker/trust, ограничьте к ним доступ и создайте резервную копию.

DOCKER_CONTENT_TRUST — это переменная окружения, которая исчезнет после закрытия терминальной сессии. Однако проверка доверия должна быть внедрена на каждом этапе процесса — от сборки образов и их размещения в реестрах до закачки и выполнения на серверах.

Зачем программисту холодильник

Кто сказал: «Не люблю пить теплое»? Убираем емкость подальше и смотрим на принципиальную схему девайса:

Холодильник — это блок питания, компрессор, хладагент, конденсатор и камера, в одну из стенок которой спрятаны капиллярные трубки. Все это хозяйство утрамбовано в большой, в меру красивый шкаф с дверцей наружу, за которой и прячется то, что требуется пить охлажденным.

А теперь представим, что в доме программиста появилось существо противоположного пола, считающее, что в холодильнике можно хранить мясо. Что характерно — замороженное. Но при этом, как несложно догадаться, замерзнут до непотребного состояния и напитки, что нас в некотором смысле не совсем устраивает.

У нас два пути: купить второй холодильник или разделить тот, что у нас есть, на две камеры с датчиками температуры на входе, чтобы управлять клапаном подачи хладагента внутрь. Ура, мы только что изобрели двухкамерный холодильник. А заодно — разобрались с тем, для чего программистам понадобились виртуальные машины и докер.

Проекты, которые мы делаем, не сильно отличаются от продуктов в холодильнике — каждому нужны свои условия. Для одного — PHP 7.4, база MySQL 7.6, Sphinx и мейлер на Golang. Для другого — нода 12 версии, Angular 7 и база MySQL 8.0. Проектов может быть не один десяток. Установить это все на одну машину — все равно, что запихнуть все продукты в одну камеру холодильника.

Нужно как-то изолировать один проект (продукт) от другого. На помощь приходит или виртуальная машина (еще один холодильник), или докер (вторая камера со своими настройками). Давайте немного изменим схему нашего устройства:

Включаем воображение и смекалку, поехали!

Итак, у нас есть квартира (компьютер) со своей инфраструктурой, от которой нам требуется электричество (жесткий диск, сетевая плата, процессор, etc). Для установки второго холодильника (виртуальной машины) нам нужен разветвитель розеток (hypervisor). Довольно просто, но мы видим, что для изоляции мяса от напитков нам потребовалось два комплекта оборудования (Guest OS), хотя по факту условия хранения определяет только датчик, управляющий клапаном к капиллярной системе (bins/lib).

В случае, когда мы физически разделяем холодильную и морозильную камеры (container engine), нам не нужна вторая розетка (hypervisor) и место для второго холодильника (полноценная Guest OS). Мы получили два независимых контейнера — каждый со своими условиями (bins/lib), которые подходят нужному продукту (app).

Почему я так много говорю о томах?

Мы можем создать простой веб-сервер nginx для размещения статического веб-сайта за пару простых шагов.

Создайте новый каталог, назовите его как хотите, я назову свой myapp для удобства. Все, что вам нужно, – создать простой файл index.html в каталоге myapp и вставить его.

У нас есть общая веб-страница с текстом заголовка. Осталось запустить контейнер nginx.

Мы захватываем образ nginx из Docker Hub для мгновенной настройки nginx. Конфигурация томов похожа на то, что мы сделали выше. Мы указали на каталог по умолчанию, где nginx размещает HTML-файлы. Новым является параметр , который мы установили для и . Мы сопоставили порт контейнера 80 с портом 8080 на главной машине. Не забудьте запустить команду в каталоге myapp.

Проверьте, работает ли контейнер, с помощью и запускается окно браузера. Перейдите на .

У нас есть веб-сервер nginx, запускающийся всего за пару команд. Редактируйте в index.html как вам нужно. Перезагрузите страницу, и увидите, что содержимое изменилось.

Примечание. Вы можете остановить запущенный контейнер с помощью команды stop.

How to run SQL server in a Docker container

How to run SQL server in a Docker container

Подключение к работающему контейнеру Docker полезно, когда вы хотите увидеть, что происходит внутри контейнера. Если контейнер Docker не работает должным образом, вы можете присоединиться к контейнеру или получить оболочку для контейнера и запустить такие команды, как или . Вы также можете войти в контейнер, установить новые пакеты и создать из него новый образ Docker.

В этом руководстве мы объясним, как подключиться к основному процессу выполнения контейнера и как получить оболочку для работающего контейнера.

Присоединить к контейнеру

Хотя в контейнере можно запускать несколько процессов, большинство контейнеров Docker запускают только один процесс. Команда, которая выполняется при запуске контейнера, указывается с помощью и / или .

Команда позволяет вам подключить ваш терминал к работающему контейнеру. Это полезно, когда вы хотите видеть, что написано в стандартном выводе в режиме реального времени, или контролировать процесс в интерактивном режиме.

Чтобы лучше понять, как работает команда давайте запустим новый отдельный контейнер Nginx, используя официальный образ Nginx.

Опция указывает Docker связать порт 8080 контейнера с портом 80 на хост-компьютере.

Перечислите контейнеры, чтобы убедиться, что контейнер my_nginx работает:

Присоедините к контейнеру, используя идентификатор или имя контейнера:

Команда по умолчанию для образа nginx, которая выполняется при запуске контейнера, установлена в . Когда вы запускаете команду ваш терминал подключается к процессу .

Откройте в своем браузере, и вы сможете наблюдать результаты процесса nginx в режиме реального времени.

Чтобы получить доступ к журналам контейнеров, вы должны использовать команду .

Чтобы отсоединиться от контейнера, не останавливая его, используйте комбинацию . Нажатие останавливает контейнер.

Если запущенные процессы, к которым вы подключаетесь, принимают ввод, вы можете отправить ему инструкции.

Получить снаряд в контейнер

Команда позволяет запускать команды внутри работающего контейнера.

Чтобы увидеть, как работает команда и как ее можно использовать для входа в оболочку контейнера, сначала запустите новый контейнер. Мы будем использовать официальный образ MySQL:

Это создаст контейнер с именем «my_mysql».

Чтобы выполнить команду внутри контейнера, выполните следующую команду:

Параметр обозначает интерактивный, а указывает Docker выделить псевдо-устройство TTY. Команда выведет список всех файлов и каталогов в каталоге контейнера :

Чтобы получить оболочку в контейнер, т. Е. Войти внутрь контейнера, запустите новый сеанс оболочки, выполнив двоичный файл оболочки. Вы можете использовать , или любую другую оболочку, которая включена в изображение.

Команда ниже создаст новый сеанс Bash внутри контейнера:

Ваша командная строка изменится, показывая, что вы сейчас работаете над оболочкой контейнера.

Отсюда вы можете запускать команды так же, как и на любом другом сервере Linux. Например, чтобы получить список текущих переменных среды, введите :

Вывод будет выглядеть примерно так:

Вывод

Команды и позволяют вам подключаться к работающему контейнеру. Чтобы получить интерактивную оболочку для контейнера, используйте команду для запуска нового сеанса оболочки. Команда присоединяет ваш терминал к работающему контейнеру.

докер

Что такое скрытая сеть Wi-Fi или скрытый SSID? Как найти и подключиться к скрытым сетям Wi-Fi в Windows 10? Как сделать вашу беспроводную сеть скрытой? Это сообщение отвечает на все такие вопросы.

Узнайте, как подключиться к бесплатной услуге VPN на вашем Mac, и наслаждайтесь контентом со всего мира, даже если он ограничен в вашей стране.

Узнайте, как подключиться к FTP-серверу в Mac прямо из Finder через Macfusion.

Рост в вебе и микросервисах

Докер впервые появился через веб-приложение. В то время, это был простой путь разработчику запаковать и развернуть его. Они попробовали и быстро научились применять. Как только мы начали использовать микросервисную архитектуру, докер распространился и на микросервисы.

Веб-приложения и микросервисы — похожи. Они не имеют состояния, они могут быть запущены, остановлены, убиты, перезапущены, совершенно без раздумий. Вся тяжелая работа делегируется внешним системам (базам данных и бэкендам).

Применение докера началось с небольших новых сервисов. Вначале, всё нормально работало в деве, и в тестинге, и в продакшене. По мере докеризации всё большего количества веб-сервисов и веб-приложений, понемногу начали случаться паники ядра. Чем больше мы росли, тем большее явными и важными становились проблемы со стабильностью.

В течение года появилось несколько патчей и регрессий. С тех пор мы начали играться с поиском проблем Докера и методами их обхода. Это боль, но не похоже чтобы она оттолкнула людей от внедрения Докера. Внутри компании постоянно существует запрос на использование Докера, и на его поддержку.

Заметка: никакие из этих проблем не коснулись наших клиентов и их денег. Мы довольно успешно сдерживаем буйство Докера.

Практика. Шишки

Я задался целью заставить контейнер работать так как мне было нужно и продолжал свои эксперименты, результатом которых стало несметное количество шишек. Итогом моего самоистязания стала следующий алгоритм:

Запускаем Докер контейнер в интерактивном режиме.

Обратите внимание на версию контейнера, шаг вправо или в лево и ваш ДинД превращается в тыкву. На самом деле, все ломается довольно часто с выходом новой версии.

Мы должны сразу попасть в шелл.

Пробуем узнать, какие контейнеры запущены (Ответ: никакие), но давайте выполним команду все-равно:

Вы будете немного удивлены, но оказывается Докер демон даже не запущен:

Давайте запустим его самостоятельно:

Еще одна неприятная неожиданность:

Устанавливаем пакеты iptables и bash (в баше всяко работать приятнее чем в sh):

Запускаем bash

Наконец-то мы снова в привычном шелле

попробуем запустить Докер еще раз:

Мы должны увидеть длинную простыню логов заканчивающуюся:

Нажимаем Enter. Мы снова в баше.

Начиная с этого момента мы можем пробовать запускать другие контейнеры внутри нашего Докер контейнера, но что если мы хотим поднять еще один Докер контейнер внутри нашего Докер контейнера или что-то пойдет не так и контейнер «вылетит»? Начинать все с начала.

Docker-compose?

Docker-compose позволит создавать и запускать контейнер c одной команды. Но еще важнее, что вы можете построить целый кластер контейнеров и настроить их, используя docker-compose.

Перейдите на страницу установки и установите docker-compose на компьютер.

Install Docker Compose

Вернувшись в устройство, запустите . Разберемся с некоторыми композициями.

Вместе с Dockerfile добавьте еще один файл с именем docker-compose.yml и вставьте этот фрагмент.

Будьте осторожны с отступами, иначе *docker-compose.yml** не будет работать должным образом. Осталось только запустить его.

Docker будет собирать образ из Dockerfile в текущем каталоге (), отображать порты, как мы это делали выше, а также «шарить» томы. Посмотрите, что происходит! То же самое, что мы делали с командами сборки и запуска. Теперь вместо них мы выполняем только одну команду .

Вернитесь в браузер, и увидите, что все работает так же, как и раньше. Единственное различие в том, что теперь нет необходимости в утомительном написании команд в терминале. Мы заменили их двумя конфигурационными файлами – и . Оба эти файла могут быть добавлены в ваш репозиторий Git

Почему это важно? Потому что они всегда будут работать в производстве правильно, как и ожидалось. Точно такая же сеть контейнеров будет развернута на производственном сервере!

Чтобы закончить этот раздел, перейдите обратно в консоль и просмотрите список всех контейнеров еще раз

Если вы хотите удалить контейнер, можете запустить команду , о которой я упоминал выше. Для удаления образов используйте команду .

Постарайтесь не оставлять остатки контейнеров и удалять их, если они вам больше не нужны.

Более широкая перспектива?

Убедившись, что Docker не является единственной технологией для создания контейнеров, я должен обязательно упомянуть менее популярные технологии. Docker – это всего лишь самый распространенный вариант контейнеризации. Но, похоже, rkt также отлично работает.

Копая глубже, я должен упомянуть об оркестровке контейнеров. Мы говорили только о верхушке айсберга. Docker-compose – это инструмент для создания сетей контейнеров. Но, когда появляется необходимость управлять большими объемами контейнеров и обеспечивать максимальный аптайм, в игру вступает оркестровка.

Управление большим кластером на основе контейнеров – вовсе не тривиальная задача. По мере роста количества контейнеров нужен способ автоматизации различных задач DevOps, которые мы обычно делаем. Оркестрация – это то, что помогает в создании хостов, создании или удалении контейнеров, когда нужно масштабировать или воссоздавать упавшие контейнеры, сетевые контейнеры и многое другое. И здесь на помощь приходят следующие инструменты: Kubernetes от Google и собственная разработка Docker – Swarm Mode.

Уязвимости в образах контейнеров

Описание

Контейнеры — это изолированные черные ящики. Если они выполняют свои функции, легко забыть, какие программы каких версий запущены внутри. Контейнер может отлично справляться со своими обязанностями с операционной точки зрения, при этом используя уязвимое программное обеспечение. Эти уязвимости могут быть давно исправлены в апстриме, но не в вашем локальном образе. Если не предпринимать соответствующие меры, проблемы подобного рода могут долгое время оставаться незамеченными.

Лучшие практики

Представление контейнеров в виде неизменяемых атомарных частей системы обоснованно с архитектурной точки зрения, однако для обеспечения безопасности их содержимое нужно регулярно проверять:

- Чтобы получить свежие исправления уязвимостей, регулярно обновляйте и пересобирайте свои образы. Разумеется, не забывайте тестировать их перед тем, как отправлять в production.

- Патчить работающие контейнеры считается дурным тоном. Лучше при каждом обновлении пересобирать образ. В Docker реализована декларативная, эффективная и легкая для понимания система сборки, так что эта процедура на самом деле проще, чем кажется на первый взгляд.

- Используйте программное обеспечение, которое регулярно получает обновления безопасности. Все, что вы устанавливаете вручную, минуя репозитории вашего дистрибутива, необходимо в дальнейшем обновлять самостоятельно.

- Постепенные роллинг-обновления без прерывания работы сервиса считаются фундаментальным свойством модели построения систем с помощью Docker и микросервисов.

- Пользовательские данные отделены от образов контейнеров, что делает процесс обновления безопаснее.

- Не усложняйте. Простые системы реже требуют обновлений. Чем меньше компонентов в системе, тем меньше поверхность атаки и проще обновления. Разбивайте контейнеры, если они становятся слишком сложными.

- Используйте сканеры уязвимостей. Их сейчас предостаточно — и бесплатных, и коммерческих. Старайтесь быть в курсе событий, связанных с безопасностью используемого вами программного обеспечения, подпишитесь на почтовые рассылки, сервисы оповещений и т. д.

Примеры

Многие реестры образов Docker предлагают услугу сканирования образов. Выберем, например, CoreOS Quay, в котором используется сканер безопасности образов Docker с открытым исходным кодом под названием Clair. Quay — это коммерческая платформа, но некоторые услуги предоставляются бесплатно. Пробную учетную запись можно создать, следуя этим инструкциям.

После регистрации аккаунта откройте Account Settings и установите новый пароль (он понадобится для создания репозиториев).

Нажмите + в правом верхнем углу и создайте новый публичный репозиторий:

Здесь мы создадим пустой репозиторий, но, как видно на скриншоте, существуют и другие варианты.

Теперь из консоли залогинимся в Quay и загрузим туда локальный образ:

Если образ уже загружен, можно щелкнуть по его ID и посмотреть результаты сканирования безопасности, отсортированные в порядке убывания опасности уязвимости, которые снабжены ссылками на CVE и версии пакетов, содержащие исправления.

Как установить Docker на VDS Timeweb

Так как мы постоянно работаем над тем, чтобы сделать работу на нашем хостинге удобной и комфортной для наших клиентов, внедрение Docker было лишь вопросом времени.

Для того чтобы начать использовать Docker, сначала вам необходимо установить его – это можно сделать двумя путями.

- Вы можете установить Docker в панели управления VDS при создании нового сервера: на 2-м шаге «Программное обеспечение», при выборе Ubuntu 16.04 в качестве операционной системы, вы сможете установить DockerUI.

- Также вы можете провести установку через консоль любого дистрибутива Linux, следуя инструкции на официальном сайте.

Соответственно, работа с Docker может производиться либо в консоли, либо в соответствующем интерфейсе.

Как и во многих других случаях, работа с Docker напрямую через консоль отличается большей стабильностью и широкими возможностями. Все необходимые команды вы найдете на этой странице официального сайта.

Однако начинающим пользователям, которые хотят познакомиться с Docker, будет удобнее работать в DockerUI:

Если вам интересно более детально разобраться в том, что такое Docker, рекомендуем к чтению следующую англоязычную статью: What is Docker?

Docker в CI

Все компании, в которых я работал, похожи друг на друга. Они, как правило, продуктовые. То есть у них есть какое-то одно приложение, один стек технологий (ну может пара — тройка языков программирования).

Эти компании используют docker на своих серверах где запускается CI процесс. Вопрос — зачем нужно собирать проекты в docker контейнере на своих серверах? Почему просто не подготовить окружение для сборки, например написать Ansible плейбук, который будет ставить нужные версии nodejs, php, jdk, копировать ssh ключи и пр. на сервер, в котором будет происходить сборка?

Сейчас я понимаю, что это стрельба себе по ногам, потому что docker не приносит никакого профита со своей изоляцией. Проблемы с CI в docker с которыми я столкнулся:

- снова нужнен docker образ для сборки. нужно искать образ или писать свой dockerfile.

- 90%, что нужно пробросить какие-нибудь ssh ключи, секретные данные, которые не хочется писать в docker образ.

- контейнер создается и умирает, теряются все кеши вместе с ним. следующая сборка будет заново скачивать все зависимости проекта, а это долго и неэффективно, а время — деньги.

Разработчики не собирают проекты в docker контейнерах ( я — когда то был таким фанатом, жалко себя в прошлом xD ). В java есть возможность иметь несколько версий и менять одной командой на ту, которая нужна сейчас. В nodejs тоже самое, есть nvm.